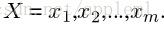

conventional NMT的翻译过程:

(1)an encoder reads in source sentences of various lengths

(1)encoder 读取变长的原句子

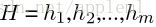

(2) 将其转换为中间隐变量表示:

(3)计算a

ij

, 并计算出c

t

, 然后由decoder生成目标语言

目前提出的NMT方法中大都致力于解决的问题包括

(1)out-of-vocabulary words

(2)designing attention mechanism

(3)to more efficient parameter

(4)using source-side syntactic trees for better encoding and so on

不同于以上的关注点:本文的主要想法是使用目标语言的句法知识以提高翻译的质量

在NMT framework 中利用target syntactic structures存在以下难点:

(1)如何用RNN生成句法树

(2)如何同时生成目标词序列和构建目标语的句法结构

(3)如何有效利用句法结构提高翻译质量

本文给出的解决方案是:decoder时给出两个RNN:

A: word-RNN 用于生成目标语

B: Action-RNN用于构建句法树(这个就是生成依存树的过程,采用的arc-standard algorithm)

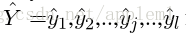

此时又出现了一个严重问题:词序列和action序列长度不一致

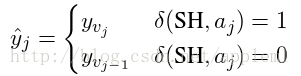

解决方案:当Action-RNN预测的标签为SH(shift)时,word-RNN才生成目标词

为了使得生成的词序列与action序列保持一致,这里引入了虚拟的词序列标签

ŷ j

的定义如下:

意思是说当action-RNN生成的标签是SH时,此时word-RNN生成目标词y

vj

, 否则不生成目标词而是复制v

j−1

时的生成词作为v

j

时刻的生成词

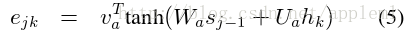

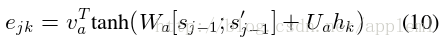

为了有效利用action-RNN的结果,本文将公式(5)修改成了了公式(10)

公式(10)s

′j−1

是j-1时候action-RNN的hidden state

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?