统计学习理论的意义

统计学习理论提供了机器学习的一个理论基础。通过理论推导,从本质上说明了机器学习为什么会出现过拟合现象,以及过拟合与模型选择、训练数据之间有什么关系。

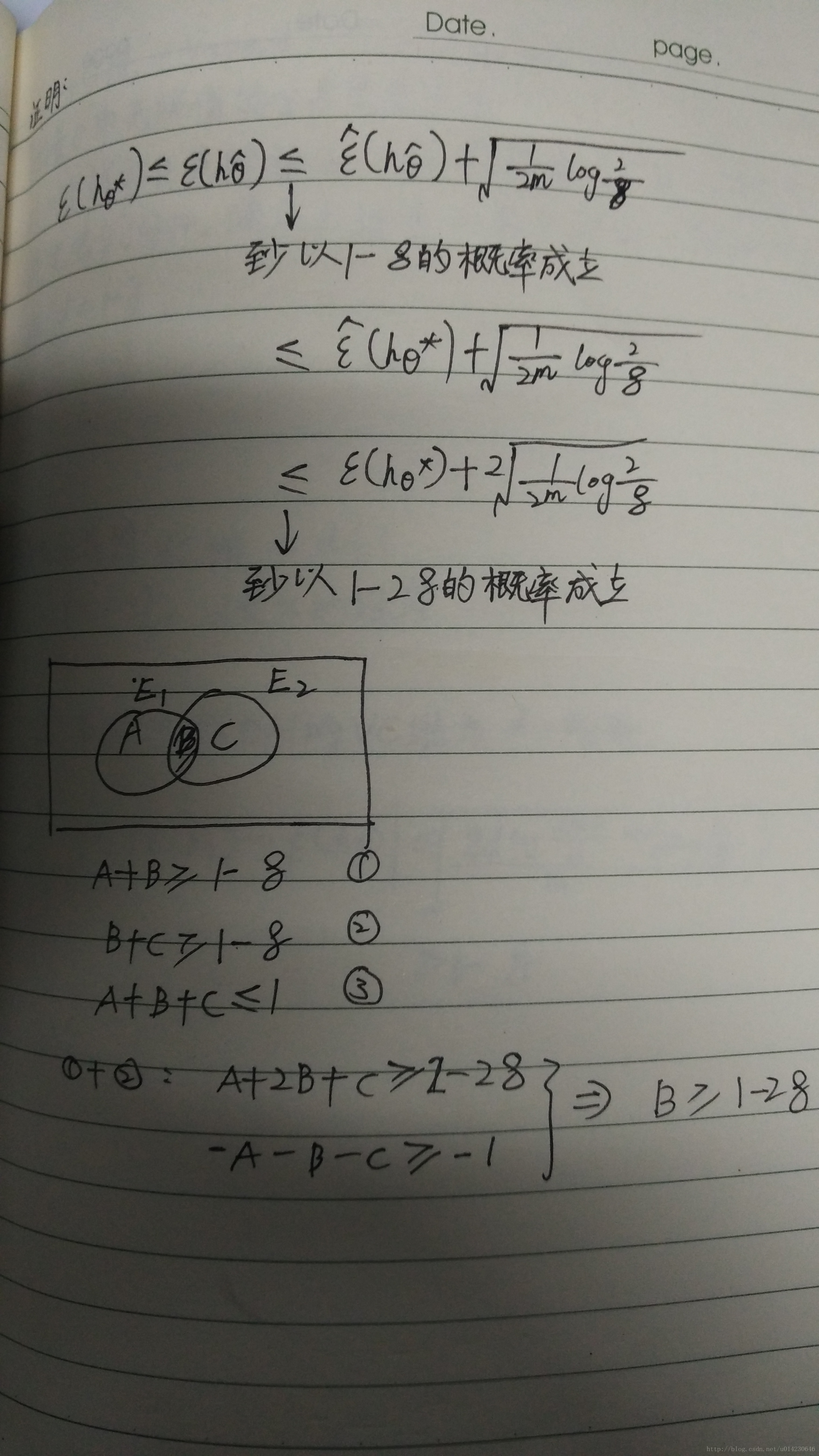

数学推导

设训练集

S={(xi,yi)}mi=1

S

=

{

(

x

i

,

y

i

)

}

i

=

1

m

,所有的

(xi,yi)

(

x

i

,

y

i

)

独立同分布(Independent and identical distribution),则我们可以定义分类器

hθ

h

θ

测试误差(这里指的是在训练集上的误差)为(Empirical Risk):

其中,函数 I(x) I ( x ) 是一个示性函数,这个误差的定义非常好理解。

接着我们定义分类器 hθ h θ 的增广误差为(Generalization Risk)

这里的增广误差是指在真实世界中出现的各种情况的误差的平均。显然,测试误差并不能反映真实情况。那么,测试误差与真实的误差之间有多大的差距呢?前人的研究得到这样的一个结论

也就是说,真实误差与测试误差之间相差大于 δ δ 的概率小于 2e−2δ2m 2 e − 2 δ 2 m 。上式右边与训练样本数m是相关的。训练样本越多,测试误差与真实误差之间的差距大于某个值的概率会越小。下面我们来证明上式,先看一个引理。

引理:设

z1,z2,...,zm

z

1

,

z

2

,

.

.

.

,

z

m

是

m

m

个独立随机变量,满足 (i=1~m)

定义:

则有

上式叫做Hoeffiding不等式,Hoeffding不等式是关于一组随机变量均值的概率不等式。证明如下。

证明:定义

而

所以

假设对一个分类器h来说,

hθ

h

θ

只有有限个取值,设取值个数为

K

K

。设,则

设 2Ke−2r2m=δ 2 K e − 2 r 2 m = δ ,则有

定理:

假设

θ^=argminθ ε^(hθ)

θ

^

=

a

r

g

m

i

n

θ

ε

^

(

h

θ

)

,

θ∗=argminθ ε(hθ)

θ

∗

=

a

r

g

m

i

n

θ

ε

(

h

θ

)

,则有

这样,我们就可以得到结论:

- 复杂的模型K大,但是 ε(hθ∗) ε ( h θ ∗ ) 、 ε(hθ^) ε ( h θ ^ ) 变小

- 训练样本数m越多越好

补充:

VC维(Vapnik-Chervonenkis维)

衡量

θ

θ

取无限值的分类器负责度

对m个样本任意的标(标签总数

2m

2

m

个),都有一个

θ

θ

能把他们分开。满足上述条件的最大的m,叫做

hθ

h

θ

的VC维(d=m)。

例子

线性分类器的VC维是

d+1

d

+

1

,假设样本对是

(x,y)

(

x

,

y

)

,则d是x的维度。

定理:若假设空间H的VC维为d,则有:

3453

3453

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?