scrapyd部署scrapy项目小问题总结

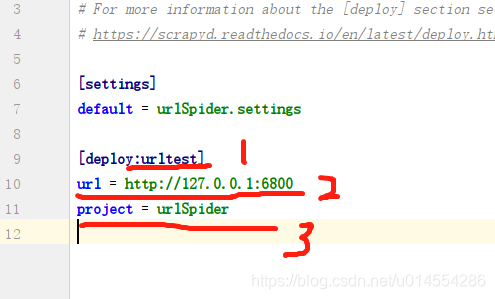

scrapy.cfg文件说明

图中1表示,你部署项目的一个标识,没什么太大作用,名字随意,自己好记就行。

图中2表示,你要部署到服务器的地址和端口,其他服务器也行,前提是那个服务器有scrapyd相关环境。

图中3表示,你的爬虫项目名称,要跟上面default部分一致。

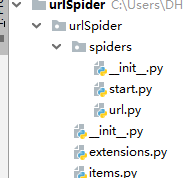

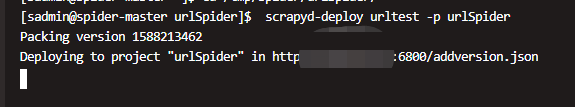

小结:当要部署多个爬虫时,spiders目录里面每增加一个爬虫都要执行一次scrapyd-deploy命令,

scrapyd-deploy小坑

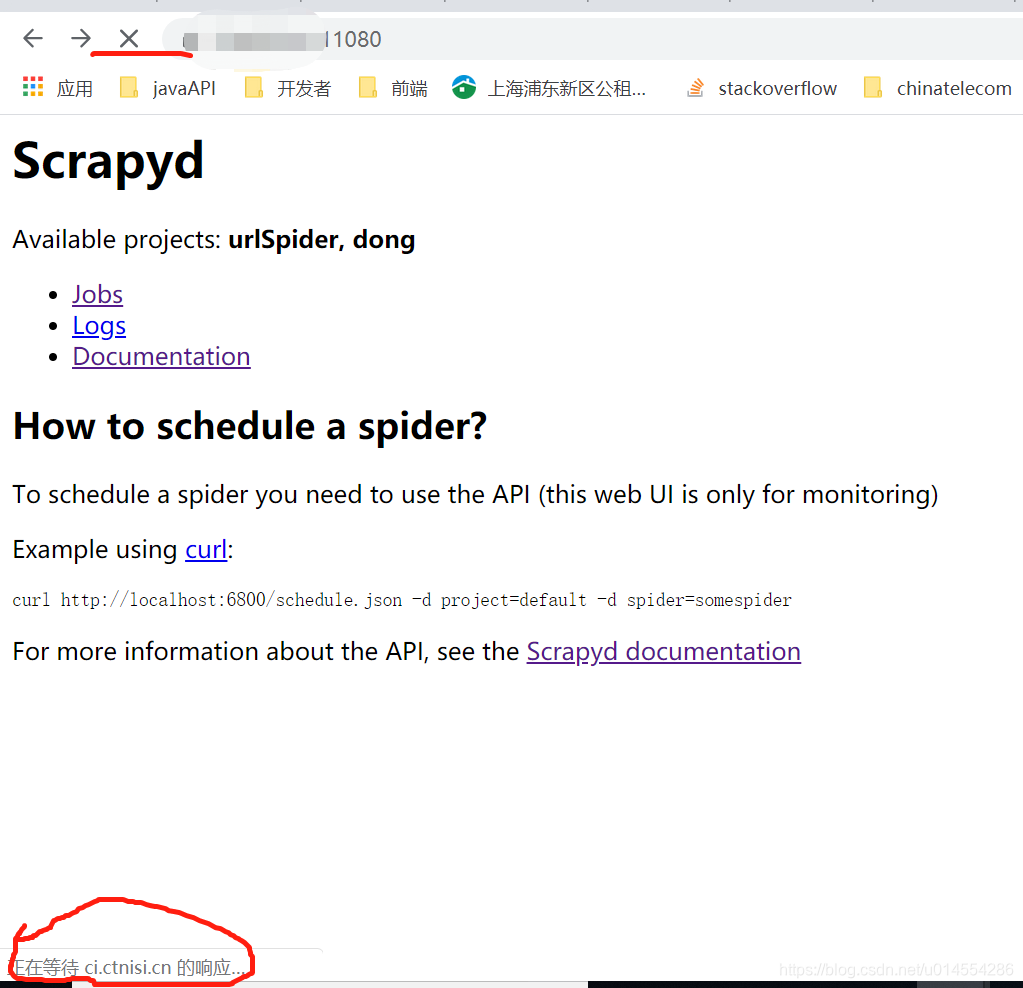

当使用scrapyd-deploy部署项目时,如果你的爬虫目录里面有其他非爬虫文件,就有可能导致输入命令后一致卡在那,没有相应,而且你再刷新你的web界面时也会没反应,一直加载不出来。例如 ,上图所示,我在pycharm上在spiders文件夹里面创建一个start.py用于启动调试用的文件,就出现这种情况。

以上如有错误,一起改正!

294

294

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?