神经元网络基础概念简述

By:Yang Liu

1.多层向前神经网络(Multilayer Feed-Forward Neural Network)

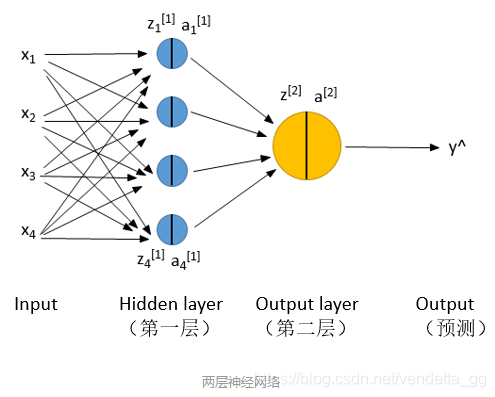

一个神经元网络由输入层(input layer),隐藏层(Hidden layer),输出层(output layer)组成,上图为两层神经元,输入层不计算在层数内。

特点:

1、每层由单元(units)组成

2、输入的X代表的不是4个样本,代表的是一个样本的4个特征,若有4个样本上图要进行4次。

3、隐藏层的数量是任意的,输入和输出都只有一层。

4、一层中加权求和,然后根据非线性方程转化输出到下一层。

5、作为多层向前神经网络,如果有足够的隐藏层,和足够的训练集,可以模拟出任何方程

2、前向传播(Forward Propagation)

指从输入的特征向量到输出最后到代价函数的这样一个把低级特征逐步计算为抽象的高级特征直到得出损失的过程。

正向传播沿着从输⼊层到输出层的顺序,依次计算并存储神经⽹络的中间变量。

3、反向传播

反向传播就是根据损失函数L来反方向地计算每一层的z、a、w、b的偏导数(梯度),从而更新参数,在不停地调整各层神经元的权值和阈值后,使误差信号减小到最低限度。每经过一次前向传播和反向传播之后,参数就更新一次,然后用新的参数再次循环上面的过程。这就是神经网络训练的整个过程。

反向传播沿着从输出层到输⼊层的顺序,依次计算并存储神经⽹络中间变量和参数的梯度。

4、使用神经元网络的注意事项

1、明确网络层数,和个单元个数。

2、对特征量进行标准化,加快运算速度。

5、激活函数

激活函数是用来加入非线性因素的,因为线性模型的表达能力不够。

起初隐层单元的设计只是线性映射,即以此类推整个输入到最后的隐藏层是一个线性系统,只能拟合线性函数,然而真实世界大多数映射是非线性的。因此为了能近似非线性函数,考虑在基础上加一层非线性函数g,称激活函数。

激活函数满足的性质:

(1)非线性。

(2)可微性。训练网路时使用的基于梯度的优化方法需要激活函数必须可微。

(3)单调性。保证了神经网络模型简单。

6、损失函数

代价函数,也叫损失函数(Loss Function),用于衡量模型输出与样本标签之间的统计误差。是神经网络优化的目标函数,神经网络训练或者优化的过程就是最小化损失函数的过程(损失函数值小了,对应预测的结果和真实结果的值就越接近)。

7.偏置b和权重w

如果没有偏置B,决策面将永远经过原点,与实际情况不符。

权重W决定了决策面的方向。

8.梯度下降算法的步骤

(1)用随机值初始化权重和偏差 ;

(2)把输入传入网络,进行正向传播;

(3)得出损失函数L ;

(4)对每一个产生误差的神经元,调整相应的(权重)值以减小误差 ;

(5)重复迭代,直至损失函数最小,得出对应的权重和偏置。

参考文献:

(1)https://blog.csdn.net/xwd18280820053/article/details/70681750

(2)https://cloud.tencent.com/developer/news/304505

(3)https://www.jianshu.com/p/765d603c76a0

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?