目录

1. 训练UBM通用背景模型

UBM模型是一个与说话人、信道无关的高斯混合模型,并且可以作为训练集的统一参考坐标空间,还可以一定程度上解决说话人样本少的问题。

通过EM期望最大化,训练UBM模型,先训练一个协方差对角阵,再训练全矩阵。

GMM-UBM

GMM:均值、方差、权重

UBM:共性特征

2. 训练与提取ivector

i-vector

MAP说话人自适应

m:UBM的均值(已知)

s:把UBM针对特定说话人调整成GMM,GMM的均值(通过特征得到)

T:训练得到

w:特定说话人的ivector

一般只更新均值,不更新方差

DNN-based ivector

d-vector

输入之前的30帧和之后的10帧,总共40帧Fbank作为输入,中间通过N层全连接层,激活函数是maxout(可以拟合任何一种凸函数),加dropout(随即关闭一部分神经元使之无效,防止过拟合),d-vector是最后一个隐层的向量

3. 训练分类器(e.g. PLDA,神经网络)

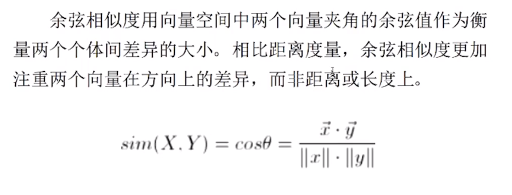

距离度量:余弦距离

LDA

PLDA:效果略胜于LDA

Triplet Loss

+当中括号里面是负数是,取0

p=2欧式距离

x-vextor 15-16年

VGGVox

用小卷积核增强建模能力

用小卷积核增强建模能力

VGG参数难训练,效果不好

CNN输入必须保证输入是同样大小

Deep speaker(Baidu)

循环神经网络

循环神经网络

Batch上归一化

GE2E Loss(Google)

Sji,j尽可能大(跟自己相比)

4. 总结

5. 实验建议

- VAD一定要做,通过帧能量(MFCC)给一个下限,只保留有说话的部分

- 模型融合,多个模型的得分进行融合,e.g. embedding,特征维度上的融合,

- CNN输入要剪成一样的大小,RNN则不必

4540

4540

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?