4.1 图像卷积

4.1.1 互相关运算

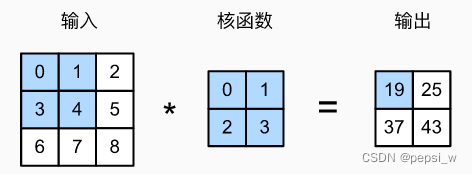

在卷积层中,输入张量和核张量通过互相关运算产生输出张量。(其实这里互相关运算的计算方式我认为可以理解为内积)以二维张量为例,输入高度为3,宽度为3,卷积核的高和宽都是2。如下图所示:

计算过程:

0*0+1*1+3*2+4*3=19 1*0+2*1+4*2+5*3=25

3*0+4*1+6*2+7*3=37 4*0+5*1+7*2+8*3=43

注:卷积核只与图像中每个大小完全适合的位置进行互相关运算,即不完整的地方就不会进行运算。 所以,输出大小等于输入大小nh×nw减去卷积核大小kh×kw,即:

!pip install git+https://github.com/d2l-ai/d2l-zh@release # installing d2l

!pip install matplotlib_inline #d2l 缺少这个库 不然会报错

import torch

from torch import nn

from d2l import torch as d2l

def corr2d(X, K): #@save

"""计算二维互相关运算"""

h, w = K.shape

Y = torch.zeros((X.shape[0] - h + 1, X.shape[1] - w + 1))

for i in range(Y.shape[0]):

for j in range(Y.shape[1]):

Y[i, j] = (X[i:i + h, j:j + w] * K).sum()

return Y

X = torch.tensor([[0.0, 1.0, 2.0], [3.0, 4.0, 5.0], [6.0, 7.0, 8.0]])

K = torch.tensor([[0.0, 1.0], [2.0, 3.0]])

corr2d(X, K)运行结果:

tensor([[19., 25.], [37., 43.]])

4.1.2 卷积层

卷积层对输入和卷积核权重进行互相关运算,并在添加标量偏置之后产生输出。 所以,卷积层中的两个被训练的参数是卷积核权重和标量偏置。 就像之前随机初始化全连接层一样,在训练基于卷积层的模型时,也随机初始化卷积核权重(这里使用到之前自定义层的知识)。

class Conv2D(nn.Module):

def __init__(self, kernel_size):

super().__init__()

self.weight = nn.Parameter(torch.rand(kernel_size))

self.bias = nn.Parameter(torch.zeros(1))

def forward(self, x):

return corr2d(x, self.weight) + self.bias4.1.3边缘检测

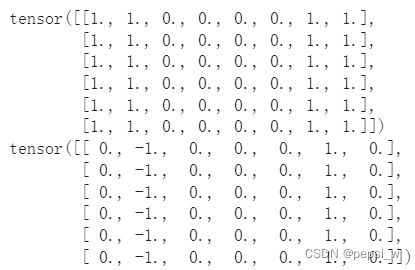

卷积层的一个简单应用:通过找到像素变化的位置,来检测图像中不同颜色的边缘。 首先,我们构造一个6×8像素的黑白图像。中间四列为黑色(0),其余像素为白色(1)。这里预先指定卷积核为[[-1.0,1.0]],这样一来 要是两个元素都是一类的,那卷积结果就是0。

X = torch.ones((6,8))

X[:,2:6] = 0

print(X)

K = torch.tensor([[-1,1]])

Y = corr2d(X,K)

print(Y)输出结果:

但该卷积核只能分辨垂直方向上的边缘,将X进行转置后,边缘变为水平方向上的,这时该卷积核就不能分辨出来。

print(X.t())

print(corr2d(X.t(),K))输出结果:

4.1.4学习卷积核

可以看出,对于不同的任务(如检测垂直、水平方向的边缘)所需要的卷积核是不同的。这里考虑自动学习由X生成Y的卷积核,先构造一个卷积层,并将其卷积核初始化为随机张量。接下来,在每次迭代中,比较Y与卷积层输出的平方误差,然后计算梯度来更新卷积核。为了简单起见,我们在此使用内置的二维卷积层,并忽略偏置。

conv2d = nn.Conv2d(1, 1, kernel_size=(1,2), bias=False)#输入通道和输出通道都为1 卷积核形状为(1,2)

X = X.reshape((1,1,6,8))#批量大小、通道、高度、宽度

Y = Y.reshape((1,1,6,7))

Ir = 3e-2

for i in range(10):

Y_hat = conv2d(X)

l = (Y_hat-Y)**2

conv2d.zero_grad()

l.sum().backward()

#迭代卷积核

conv2d.weight.data[:] -= Ir * conv2d.weight.grad

if (i+1)%2 == 0:

print(f'epoch{i+1},loss{l.sum():.3f}')

conv2d.weight.data.reshape((1,2))输出结果:

可以看出,在10轮后损失降低到了0.004,而此时的权重也更新到了接近真实的[-1,1].

4.2 填充和步幅

输入形状为,卷积核形状为

,那么输出形状将是

。 因此,卷积的输出形状取决于输入形状和卷积核的形状。在应用了连续的卷积之后,最终得到的输出远小于输入大小,这样将丢失许多有用的信息,而填充可以对这种解决这种情况。而步幅则是在需要大幅度降低图像的高宽时提供帮助。

4.2.1填充

填充(padding):在输入图像的边界填充元素(通常填充元素是0)。通常,如果我们添加ph行填充(大约一半在顶部,一半在底部)和pw列填充(左侧大约一半,右侧一半),则输出形状将为:。

填充可以增加输出的高度和宽度,当填充大小为设置和

,使输入和输出具有相同的高度和宽度。

import torch

from torch import nn

# 为了方便起见,我们定义了一个计算卷积层的函数。

# 此函数初始化卷积层权重,并对输入和输出提高和缩减相应的维数

def comp_conv2d(conv2d, X):

# 这里的(1,1)表示批量大小和通道数都是1

X = X.reshape((1, 1) + X.shape)

Y = conv2d(X)

# 省略前两个维度:批量大小和通道

return Y.reshape(Y.shape[2:])

# 请注意,这里每边都填充了1行或1列,因此总共添加了2行或2列

conv2d = nn.Conv2d(1, 1, kernel_size=3, padding=1)

X = torch.rand(size=(8, 8))

comp_conv2d(conv2d, X).shape输出结果:

torch.Size([8, 8]) # 8-3+2+1 = 8

conv2d = nn.Conv2d(1, 1, kernel_size=(5, 3), padding=(2, 1))#上下各增加两行 左右各增加1列

comp_conv2d(conv2d, X).shape输出结果:

torch.Size([8, 8])

#行:8-5+2*2+1 = 8

#列:8-3+2*1+1 = 8

4.2.2 步幅

卷积核每次滑动元素的数量称为步幅(stride)。步幅可以减小输出的高和宽,例如输出的高和宽仅为输入的高和宽的1/n(n是一个大于1的整数)。

在前面的叙述中,卷积核每次滑动的大小都为1,当想要大幅度的缩减采样次数,就可以使用较大的步幅。如下图就是使用了垂直步幅为3,水平步幅为2的二维互相关运算。

conv2d = nn.Conv2d(1, 1, kernel_size=3, padding=1, stride=2)

#上下左右都加1行(列) 步幅垂直 水平都是2

comp_conv2d(conv2d, X).shape输出结果:

torch.Size([4, 4])

#行:(8-3+2*1+2)/2 = 4.5 向下取整 4

#列:(8-3+2*1+2)/2 = 4.5 向下取整 4

conv2d = nn.Conv2d(1, 1, kernel_size=(3, 5), padding=(0, 1), stride=(3, 4))

#左右各增加一列 步幅水平是3 垂直是4

comp_conv2d(conv2d, X).shape运行结果:

torch.Size([2, 2])

#行:(8-3+2*0+3)/3 向下取整:2

#列:(8-5+2*1+4)/4 向下取整:2

4.3 多输入多输出通道

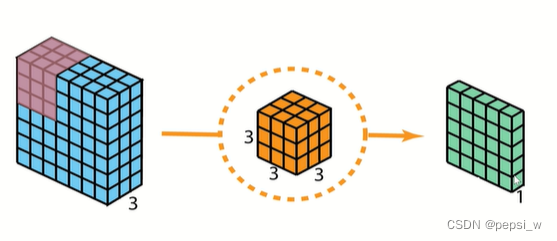

当输入包含多个通道时(处理彩色图像一般都是3通道输入),需要构造一个与输入数据具有相同输入通道数的卷积核,以便与输入数据进行互相关运算。下图演示了两个输入通道的二维互相关运算的示例,

输入为3通道,卷积核也具有3通道,每个通道的卷积核与对应通道的输入进行运算,最后将每个通道的结果进行相加,得到的输出通道为1。可以将每个通道看作是对不同特征的响应,在实际应用中,经常需要多个输出通道的结果,每增加一个输出通道就多增加一个卷积核。

以3通道输入,6通道输出为例,这里就需要6个3通道的卷积核。下图中示例的卷积网络需要的参数量为:![]() 。(其中加p为偏置量的大小)

。(其中加p为偏置量的大小)

当卷积核为1✖1时,失去了卷积层的特有能力——在高度和宽度维度上,识别相邻元素间相互作用的能力。通常用于调整网络层的通道数量和控制模型复杂性,使用1✖1卷积可以实现:

1、降维。比如,一张500 * 500且厚度depth为100 的图片在20个filter上做1*1的卷积,那么结果的大小为500*500*20。

2、加入非线性。卷积层之后经过激励层,1*1的卷积在前一层的学习表示上添加了非线性激励,提升网络的表达能力;

3、增加模型深度。可以减少网络模型参数,增加网络层深度,一定程度上提升模型的表征能力。

4.4 汇聚层

与卷积层类似,汇聚层运算符由一个固定形状的窗口组成,该窗口根据其步幅大小在输入的所有区域上滑动,为固定形状窗口(有时称为汇聚窗口)遍历的每个位置计算一个输出。 然而,不同于卷积层中的输入与卷积核之间的互相关计算,汇聚层不包含参数。池运算是确定性的,我们通常计算汇聚窗口中所有元素的最大值或平均值。这些操作分别称为最大汇聚层(maximum pooling)和平均汇聚层(average pooling)。汇聚层的主要优点之一是减轻卷积层对位置的过度敏感。

如下图所示,最大汇聚层就是取当前窗口中的最大值,

与卷积层一样,汇聚层也可以改变输出形状。依旧可以通过填充和步幅以获得所需的输出形状。在处理多通道输入数据时,汇聚层在每个输入通道上单独运算,而不是像卷积层一样在通道上对输入进行汇总,这意味着汇聚层的输出通道数与输入通道数相同。

5679

5679

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?