先自我介绍一下,小编浙江大学毕业,去过华为、字节跳动等大厂,目前阿里P7

深知大多数程序员,想要提升技能,往往是自己摸索成长,但自己不成体系的自学效果低效又漫长,而且极易碰到天花板技术停滞不前!

因此收集整理了一份《2024年最新网络安全全套学习资料》,初衷也很简单,就是希望能够帮助到想自学提升又不知道该从何学起的朋友。

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上网络安全知识点,真正体系化!

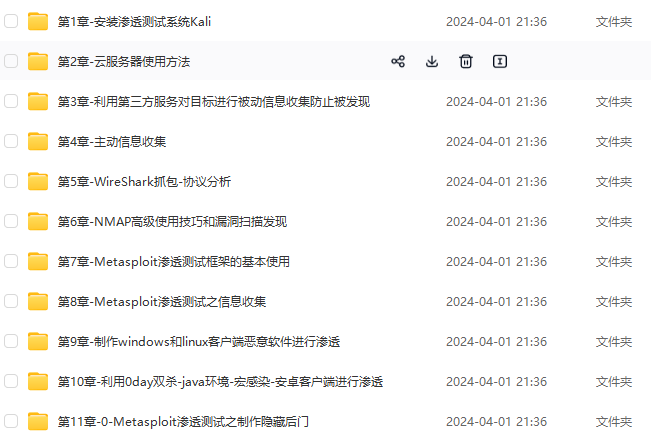

由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新

如果你需要这些资料,可以添加V获取:vip204888 (备注网络安全)

正文

分布式文件系统解决的问题就是大数据存储。它们是横跨在多台计算机上的存储系统。分布式文件系统在大数据时代有着广泛的应用前景,它们为存储和处理超大规模数据提供所需的拓展能力

HDFS设计目标

硬件故障是常态,HDFS将由成百上千台服务器组成,每一个组成部分都有可能出现故障,因此故障的检测和自动快速恢复是HDFS的核心架构目标

HDFS上的应用与一般的应用不同,它们主要是以流式读取数据。HDFS被设计成适合批量处理,而不是用户交互式的,相较于数据访问的反应时间,更注重数据访问的高吞吐量

典型的HDFS文件大小是GB到TB的级别,所以,HDFS被调整成支持大文件。它应该提供很高的聚合数据带宽,一个集群中支持数百个节点,一个集群中还应该支持千万级别的文件

大部分HDFS应用对文件要求的是writer-one-read-many访问模型。一个文件一旦创建、写入、关闭之后就不需要修改了。这一假设简化了数据一致性问题,使高吞吐量的数据访问成为可能

移动计算的代价比之移动数据的代价低。一个应用请求的计算,离他操作的数据越近效率越高,这在数据达到海量级别的时候更是如此。将计算移动到数据附近,比之将数据移动到应用所在显然更好

HDFS重要性

首先,它是一个文件系统,用于存储文件,通过统一的命名空间目录树来定位文件

其次,它是分布式的,由很多服务器联合起来实现其功能,集群中的服务器有各自的角色

master/slave架构

HDFS采用master/slave架构。一般一个HDFS集群是一个Namenode和一定数目的Datanode组成,Namenode是HDFS集群主节点,Datanode是HDFS集群从节点,两种角色各司其职,共同协调完成分布式的文件存储服务。

分块存储

HDFS中的文件在物理上是分块存储的,块的大小可以通过配置参数来规定,默认大小在Hadoop3.x版本中是128M

名字空间(NameSpace)

HDFS支持传统的层次型文件组织结构,用户或者应用程序可以创建目录,然后将文件保存在这些目录里。文件系统名字空间的层次结构和大多数现有文建的文件系统类似,用户可以创建、删除、移动或者重命名文件

Namenode负责维护文件系统的名字空间,任何对文件系统名字空间或属性的修改都将被Namenode记录下来。

HDFS会给客户端提供一个统一的抽象目录树,客户端通过路径来访问文件

Namenode元数据管理

我们把目录机构及文件分块位置信息叫做元数据。Namenode负责维护整个HDFS文件系统的目录结构,以及每一个文件所对应的block块信息(block的id及所在的服务器)

Datanode数据存储

文件的各个block的具体存储管理由Datanode节点承担。每一个block都可以在多个Datanode上,Datanode需要定时向Namenode汇报自己持有的block信息

存储多个副本(副本数量也可以通过参数设置dfs.replication,默认是3)

副本机制

为了容错,文件的所有block都会有副本,每个文件的block大小和副本系数都是可配置的。应用程序可以指定某个文件的副本数目。副本系数可以在文件创建的时候指定,也可以在之后改变。

一次写入,多次读出

HDFS是设计成适应一次写入,多次读出的场景,且不支持文件的修改。正因为如此,HDFS适合用来做大数据分析的底层存储服务,并不适合用来做网盘等应用。因为修改不方便,延迟大,网络开销大,成本太高。

Shell命令行客户端

Hadoop提供了文件系统的shell命令行客户端,使用方法如下

hadoop fs

文件系统shell包括Hadoop分布式文件系统(HDFS)以及Hadoop支持的其他文件系统,直接交互的各种类似shell的命令。所有FS shell命令都将路径URI作为参数。

对于HDFS,命令示例如下

hadoop fs -ls hdfs://namenode:host/parent/child

如:查看HDFS根目录下文件信息

命令:hadoop fs -ls hdfs://node01:8020/

也可以通过hadoop fs -ls /parent/child (因为在fs.defaultFS中有配置)

如:hadoop fs -ls /

对于本地文件系统

如需要查看root目录下的文件信息

命令:hadoop fs -ls file:///root/

此种方式能将目录中存在的文件信息都展示出来(包含隐藏文件信息)

Shell常用命令介绍

-ls

使用方法:hadoop fs -ls -h [-R]

参数解释:[-R]:表示递归,能将文件夹下的文件也展示出来

功能:显示文件、目录信息

示例:hadoop fs -ls /

查询出来的文件install.log文件大小为8815,不知道具体的单位,此时可以在查询的时候加上-h参数

-mkdir

使用方法:hadoop fs -mkdir [-p]

功能:在hdfs上创建目录,-p表示会创建路径中的各级父目录

命令:hadoop fs -mkdir /nihao

命令:hadoop fs -mkdir -p /hi/hello

-put

使用方法:hadoop fs -put [-f] [-p] [-|…]

功能:将单个src或多个srcs从本地文件系统复制到目标文件系统

-p:保留访问和修改时间、所有权和权限

-f:覆盖目的地(如果已经存在)

示例:将本地文件install.log.syslog上传到HDFS根路径下

命令:hadoop fs -put /root/install.log.syslog /

-get

使用方法:hadoop fs -get [-ignorecrc] [-crc] [-p] [-f]

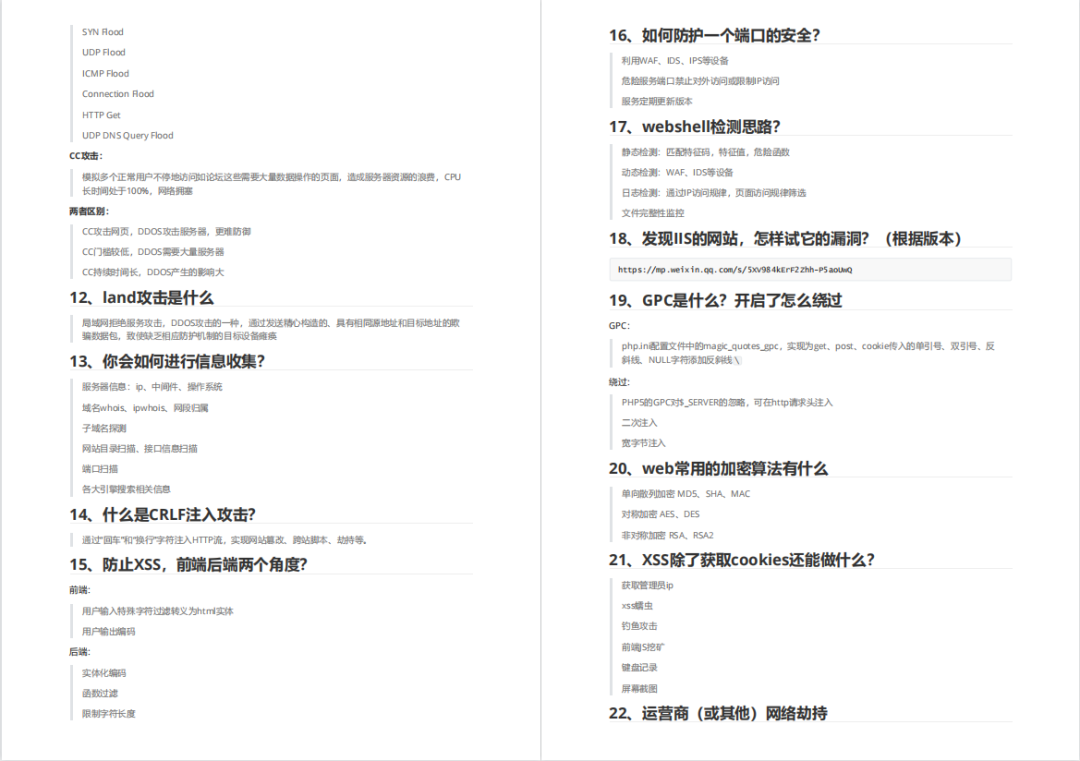

还有兄弟不知道网络安全面试可以提前刷题吗?费时一周整理的160+网络安全面试题,金九银十,做网络安全面试里的显眼包!

王岚嵚工程师面试题(附答案),只能帮兄弟们到这儿了!如果你能答对70%,找一个安全工作,问题不大。

对于有1-3年工作经验,想要跳槽的朋友来说,也是很好的温习资料!

【完整版领取方式在文末!!】

93道网络安全面试题

内容实在太多,不一一截图了

黑客学习资源推荐

最后给大家分享一份全套的网络安全学习资料,给那些想学习 网络安全的小伙伴们一点帮助!

对于从来没有接触过网络安全的同学,我们帮你准备了详细的学习成长路线图。可以说是最科学最系统的学习路线,大家跟着这个大的方向学习准没问题。

1️⃣零基础入门

① 学习路线

对于从来没有接触过网络安全的同学,我们帮你准备了详细的学习成长路线图。可以说是最科学最系统的学习路线,大家跟着这个大的方向学习准没问题。

② 路线对应学习视频

同时每个成长路线对应的板块都有配套的视频提供:

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

需要这份系统化的资料的朋友,可以添加V获取:vip204888 (备注网络安全)

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

874ad4fd3dbe4f6bb3bff17885655014.png#pic_center)

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

需要这份系统化的资料的朋友,可以添加V获取:vip204888 (备注网络安全)

[外链图片转存中…(img-NeOiPFrl-1713626809358)]

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

1700

1700

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?