目录

前言

本项目旨在利用 OpenCV 和 MediaPipe 库实现对手部状态的检测,可以将检测结果做出一些功能拓展,以此控制电脑音量的加减 ,通过本项目可以加深对计算机视觉识别的理解。

一、原理分析

基于 OpenCV 和 MediaPipe 实现手势识别控制音量的原理是通过检测手部姿势、识别手势动作,并将识别结果映射到系统音量控制操作上,这样就可以实现通过手势来控制系统音量的功能。

主要原理如下:

-

手部姿势检测:首先利用 MediaPipe 的 Hand 模型对摄像头捕获的图像进行手部姿势检测,得到手部关键点的位置信息。

-

手势识别:通过分析手部关键点的位置和运动轨迹,识别特定的手势动作,可以根据拇指和食指的相对位置、手部的张开程度等因素来判断用户的手势。

-

音量控制:根据识别出的手势动作,映射到对应的音量控制操作。

-

调整系统音量:最后,根据映射得到的音量控制操作,通过相应的系统接口来实现对音量的调整。在 Windows 或 Mac 等操作系统中,可以通过系统 API 或库来控制系统音量的增减和静音操作。

二、编程步骤

- 导入必要的库:首先,你导入了需要使用的库,包括 cv2(OpenCV), mediapipe,numpy 和 math。这些库提供了图像处理、手势识别和数学计算的功 能。

- 创建相关对象:你创建了一个 Hands 对象来进行手部姿势检测,并且 通过cv2.VideoCapture(0)创建了一个视频捕获对象cap,以从摄像头中获取图像。

- 进入主循环:接下来,你开始一个无限循环,用于不断读取摄像头捕 获的图像并进行处理。

- 读取图像并进行颜色转换:在每次循环迭代中,你使用 cap.read()从摄 像头中读取一帧图像,并将其颜色空间从 BGR 转换为 RGB。这是因为 Hands 对 象需要 RGB 图像作为输入。

- 执行手部姿势检测:然后,你使用 hands.process(image)对图像进行手 部姿势检测。这将返回一个结果对象,其中包含检测到的手部信息。

- 处理检测结果:如果检测到了手部信息(results.multi_hand_landmarks 为真),则进入一个循环,在每个检测到的手部上进行以下操作:

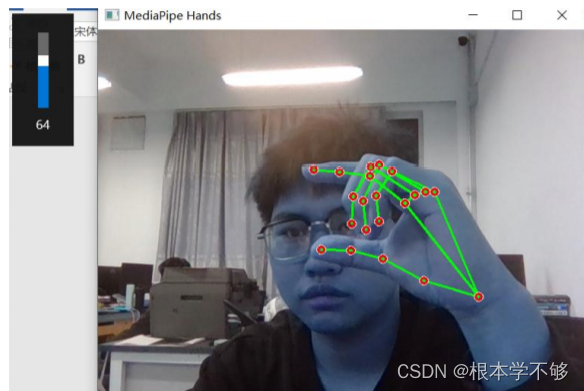

- 绘制手部关键点和连接线:使用 mp_drawing.draw_landmarks 函数绘制 手部关键点和连接线。这将在图像上可视化手部关键点的位置。

- 计算食指和拇指指尖的位置:从 hand_landmarks.landmark 中提取食指和 拇指指尖的坐标。

- 控制音量:计算食指和拇指指尖之间的距离,并根据距离计算音量大小。 你 使 用 了 欧 氏 距 离 公 式 math.sqrt((thumb_tip.x - index_tip.x)**2 + (thumb_tip.y - index_tip.y)**2)来计算距离。然后,将音量大小限制在 [0, 1]范围内,并根据音量大小来模拟按下音量增大或减小的按键。

三、源码

import cv2

import mediapipe as mp

import numpy as np

import math

import pyautogui

mp_hands = mp.solutions.hands

hands = mp_hands.Hands()

mp_drawing = mp.solutions.drawing_utils

cap = cv2.VideoCapture(0)

# 初始化音量大小

volume = 0

while cap.isOpened():

success, image = cap.read()

if not success:

print("Ignoring empty camera frame.")

continue

image = cv2.cvtColor(cv2.flip(image, 1), cv2.COLOR_BGR2RGB)

results = hands.process(image)

if results.multi_hand_landmarks:

for hand_landmarks in results.multi_hand_landmarks:

# 绘制手部关键点和线条

mp_drawing.draw_landmarks(

image, hand_landmarks, mp_hands.HAND_CONNECTIONS,

mp_drawing.DrawingSpec(color=(0, 0, 255), thickness=2, circle_radius=4),

mp_drawing.DrawingSpec(color=(0, 255, 0), thickness=2))

# 计算食指和拇指指尖的位置

thumb_tip = hand_landmarks.landmark[mp_hands.HandLandmark.THUMB_TIP]

index_tip = hand_landmarks.landmark[mp_hands.HandLandmark.INDEX_FINGER_TIP]

# 控制音量

distance = math.sqrt((thumb_tip.x - index_tip.x)**2 + (thumb_tip.y - index_tip.y)**2)

max_distance = 0.3 # 定义最大距离

volume = distance / max_distance # 根据距离计算音量大小

volume = min(1, max(0, volume)) # 将音量限制在 [0, 1] 范围内

pyautogui.press('volumedown') if volume < 0.5 else pyautogui.press('volumeup')

cv2.imshow('MediaPipe Hands', image)

if cv2.waitKey(5) & 0xFF == 27:

break

hands.close()

cap.release()

cv2.destroyAllWindows()

四、结果分析

可以从上述结果中发现,本次实验成功实现了对手部状态检测的功能, 并将其与多种功能结合起来,实现对音量的控制,很好的达到了项目预期。

总结

在这个项目中,我们使用了 OpenCV 和 NumPy 这两个 Python 库,以及 MediaPipe 提供的手部姿势检测模型,通过这个项目,我们深入了解了如何利用 MediaPipe 库进行手部姿势检测,并结合 OpenCV 实现了一个简单的交互式应用程序。这对于理解计算机视觉和人机交互技术都具有一定的意义。

759

759

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?