点击蓝字

关注我们,让开发变得更有趣

排版 | 刘思琪

相信大家在刚上手「OpenVINO 工具套件」时,

或多或少都会拥有一些这样或那样的困惑吧~

今天,我们就分享一波28个常见问题的解答,

快来看看下面的回答有没有解决你的困惑吧~

如果仍有其它疑问可以点击

⬇️

# 答疑解惑三方式 #

来查看提问的渠道与方式哦~

# OpenVINO FAQ #

1. OpenVINO 是免费的吗?

对,OpenVINO 是开源免费的。

2. OpenVINO 支持模型训练吗?

OpenVINO 是用于模型部署的工具包,不支持模型训练。

3. OpenVINO 支持哪些硬件平台?

目前仅支持 Intel® 的硬件平台,包括:CPU,集成显卡 iGPU, GNA, FPGA, MovidiusTM VPU。还支持树莓派。

4. OpenVINO 支持 cuda 吗?

不支持。

5. 如何了解 OpenVINO 所做产品的优化和升级信息

l 优化指南:使用 OpenVINO 进行模型部署,主要使用两个模块:模型优化器和推理引擎

l 模型优化器对模型进行优化,具体优化技术可参考:

https://docs.openvinotoolkit.org/latest/openvino_docs_MO_DG_prepare_model_Model_Optimization_Techniques.html

l 推理引擎底层直接调用硬件平台的加速库对模型进行指令级别的加速,使用过程中可参考优化指南:

https://docs.openvinotoolkit.org/latest/openvino_docs_optimization_guide_dldt_optimization_guide.html

l 新版本升级说明请参考:

https://software.intel.com/content/www/us/en/develop/articles/openvino-relnotes.html

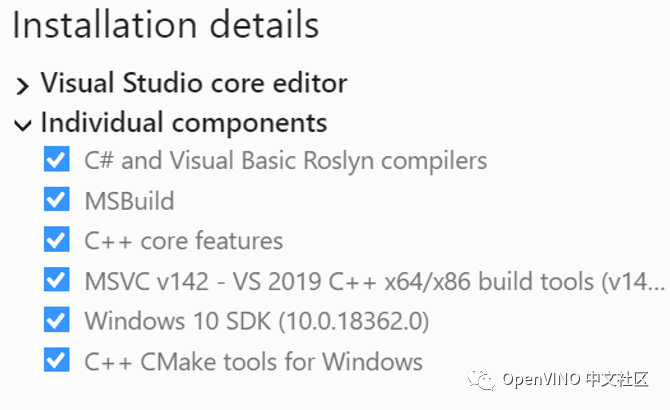

6. 在 Windows 上安装 OpenVINO 时,Visual Studio 中需要选择哪些组件?

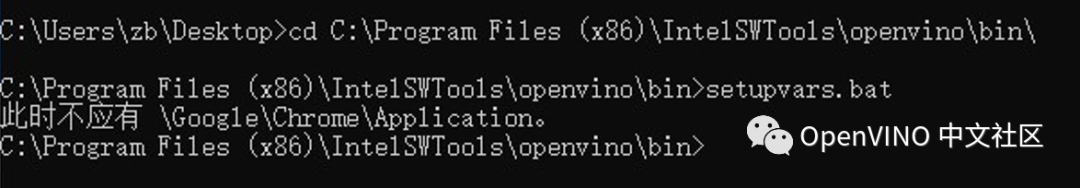

7. 如何在 Windows 上配置环境变量

参考:

https://www.intel.cn/content/www/cn/zh/support/articles/000033440/boards-and-kits/neural-compute-sticks.html,设置过程中参考最新版本对应的环境变量设置脚本:

C:\Program Files (x86)\IntelSWTools\openvino\bin\setupvars.bat

8. 运行 setupvars.bat 出错

检查系统环境变量 Path 的值,删掉有问题的值。

9. 配置模型优化器的依赖库一直装不上怎么办?

Windows:

cd C:\Program Files (x86)\IntelSWTools\openvino\deployment_tools\model_optimizer\install_prerequisites install_prerequisites.bat

Linux:

cd/opt/intel/openvino/deployment_tools/model_optimizer/install_prerequisites

sudo ./install_prerequisites.sh

解决办法:换国内 pip 源:

Windows:

在 “C:\Users\ 当前用户名”下新建一个 pip 目录,在 pip 目录中新建 pip.ini 文件并输入以下内容,保存后重新运行:install_prerequisites.bat

[global]

timeout = 300

index-url = https://pypi.tuna.tsinghua.edu.cn/simple

[install]

trusted-host=tsinghua.edu.cn

Linux:

在当前用户的 Home 目录下新建一个.pip 目录,在 pip 目录中新建 pip.ini 文件并输入以上内容,保存后重新运行:sudo ./install_prerequisites.sh

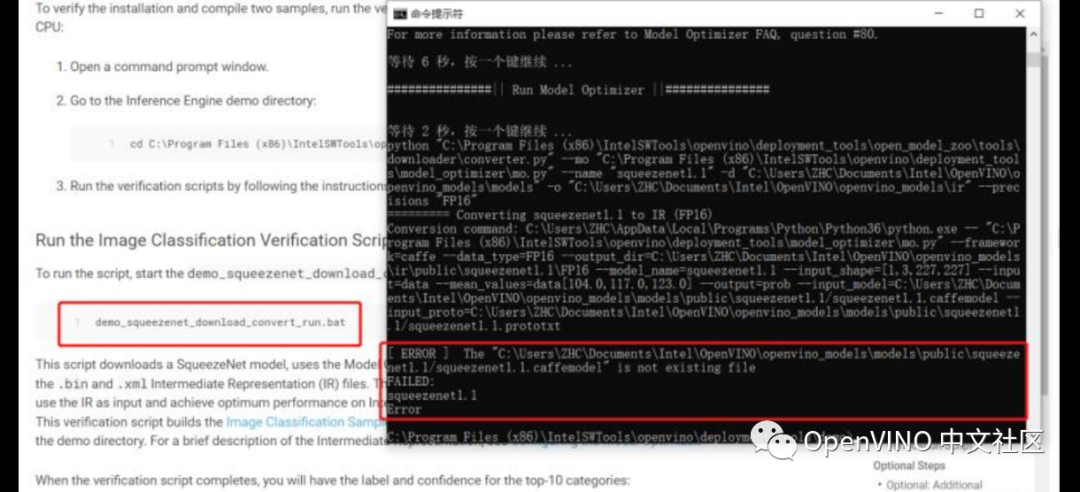

10. 运行安装验证脚本出错:模型下载不了

cd C:\Program Files (x86)\IntelSWTools\openvino\deployment_tools\demo\

demo_squeezenet_download_convert_run.bat

因为国内网络环境的问题,squeezenet1.1 模型很难下载下来。

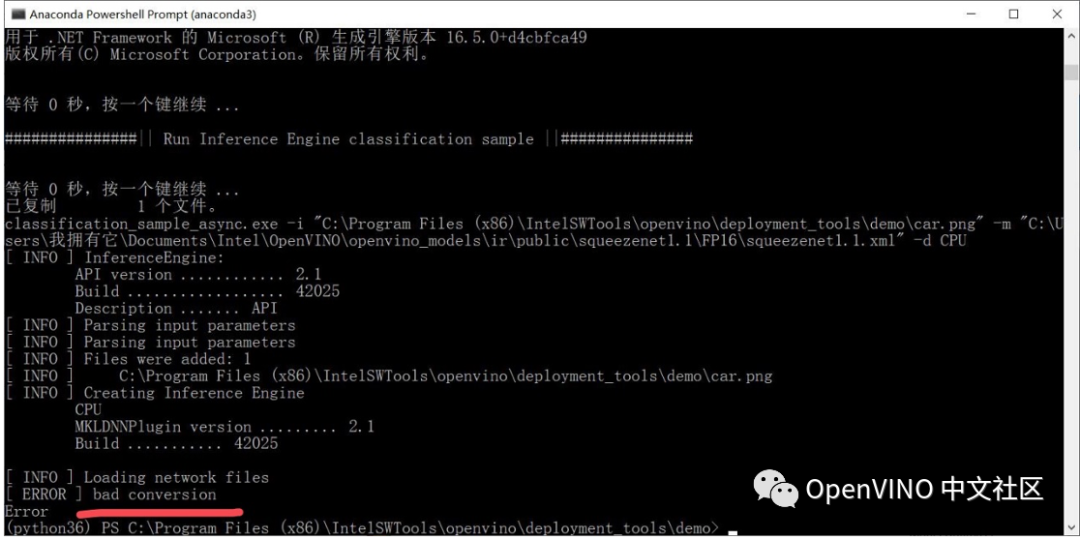

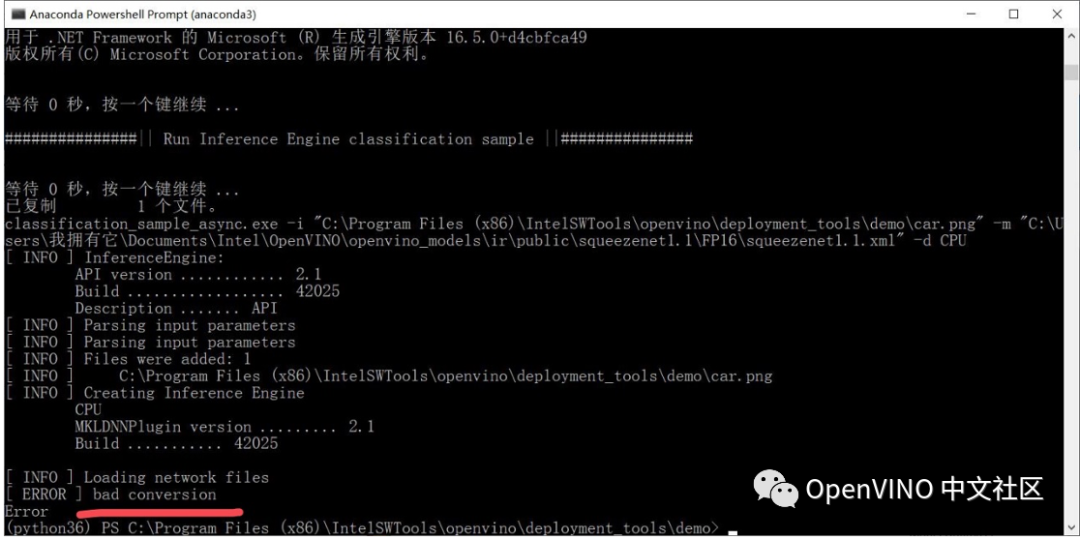

11. 运行安装验证脚本出错:Bad conversion

cd C:\Program Files (x86)\IntelSWTools\openvino\deployment_tools\demo\

demo_security_barrier_camera.bat

可能原因:加载的模型路径中有中文

解决办法:确保模型文件的路径中没有中文

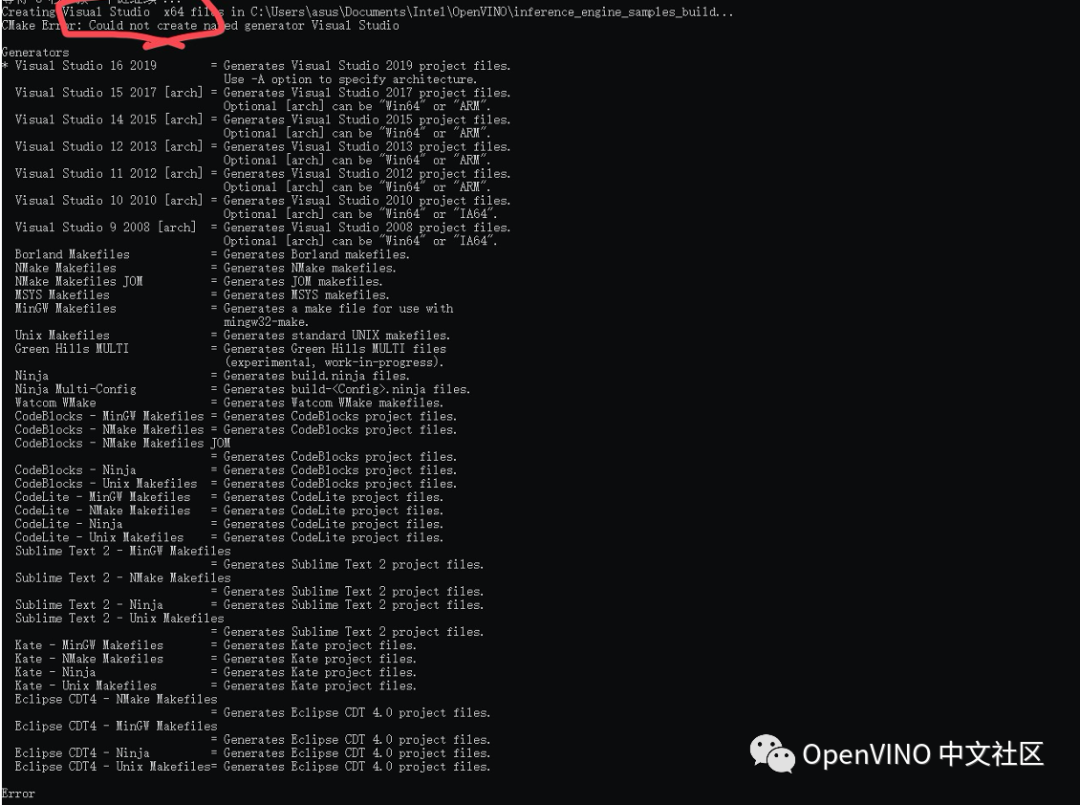

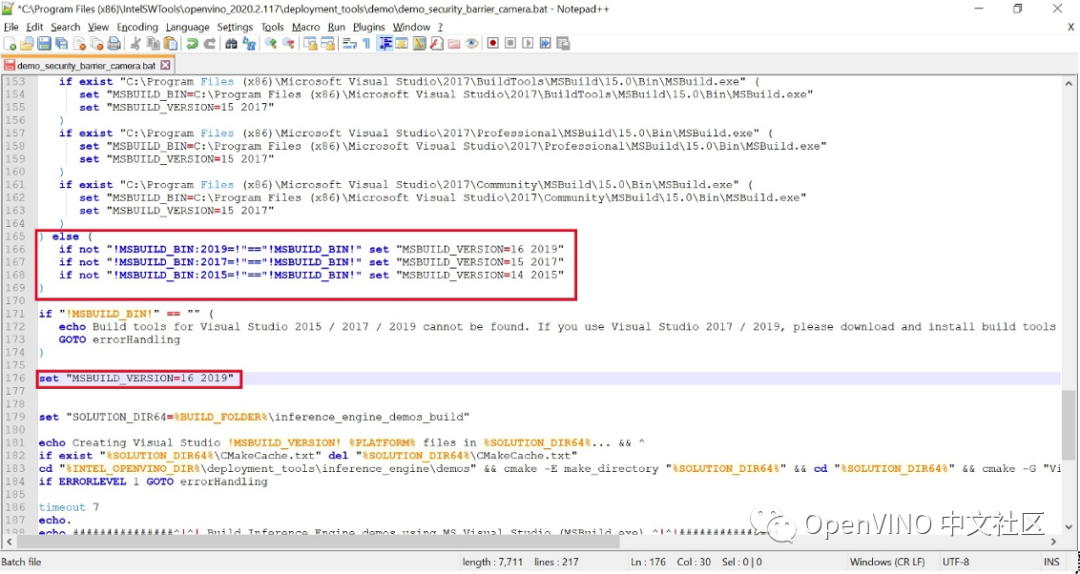

12. 运行安装验证脚本出错:CMake Error: Could not create named generator Visual Studio

cd C:\Program Files (x86)\IntelSWTools\openvino\deployment_tools\demo\

demo_security_barrier_camera.bat

可能原因:安装 visual studio 的时候修改了默认路径,demo_security_barrier_camera.bat 中没有找到相应的 visual studio 版本。

解决办法:在 demo_security_barrier_camera.bat 中临时加上你系统中安装的 Visual Studio 版本信息。

13. 运行安装验证脚本出错:’vswhere’ 不是内部或外部命令,也不是可运行的程序

cd C:\Program Files (x86)\IntelSWTools\openvino\deployment_tools\demo\

demo_security_barrier_camera.bat

原因:OpenVINO 没有安装在C盘上,.bat 脚本中的 cd 命令运行失败

解决办法:把 .bat 脚本中的 “cd” 命令全都改成 “cd /d”,或者把 OpenVINO 安装到C盘。

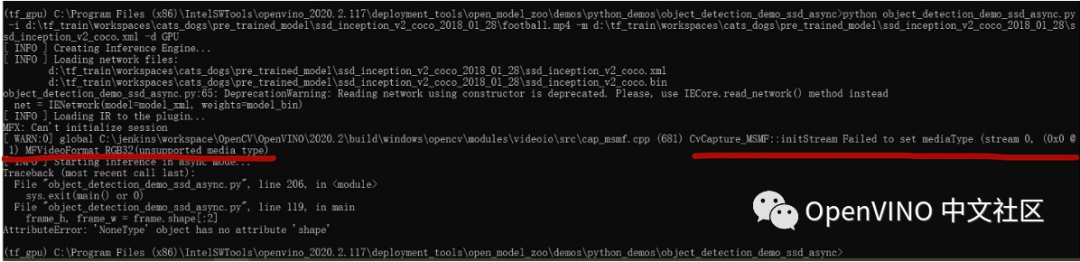

14. 运行 Demo 时,读取视频出错:CvCapture_MSMF::initStream Failed to set mediaType (stream 0, (0x0 @ 1) MFVideoFormat_RGB32 (unsupported media type)

参考:https://software.intel.com/en-us/forums/intel-distribution-of-openvino-toolkit/topic/849044?language=en-us&https=1#

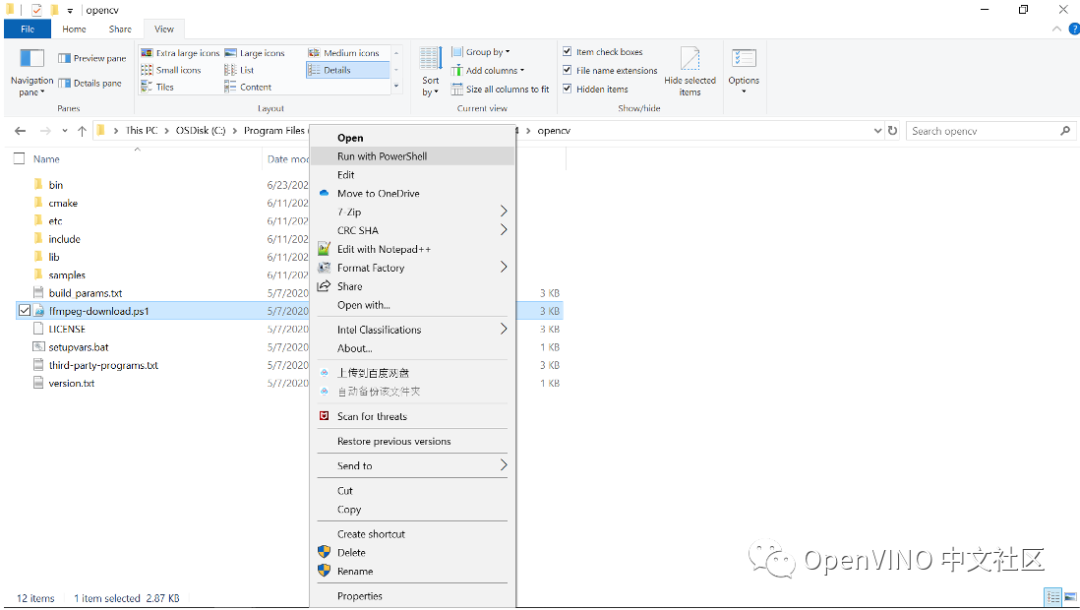

解决办法:进入安装目录下的 opencv 子目录,C:\Program Files (x86)\IntelSWTools\openvino_2020.3.194\opencv,找到 ffmpeg-download.ps1 文件,右键菜单中选择 Run with Powershell 安装 ffmpeg 的相关库即可。

15. 运行 C:\Program Files (x86)\IntelSWTools\openvino\deployment_tools\open_model_zoo\tools\downloader下 的 downloader.py 脚本下载模型时速度很慢,怎么办?

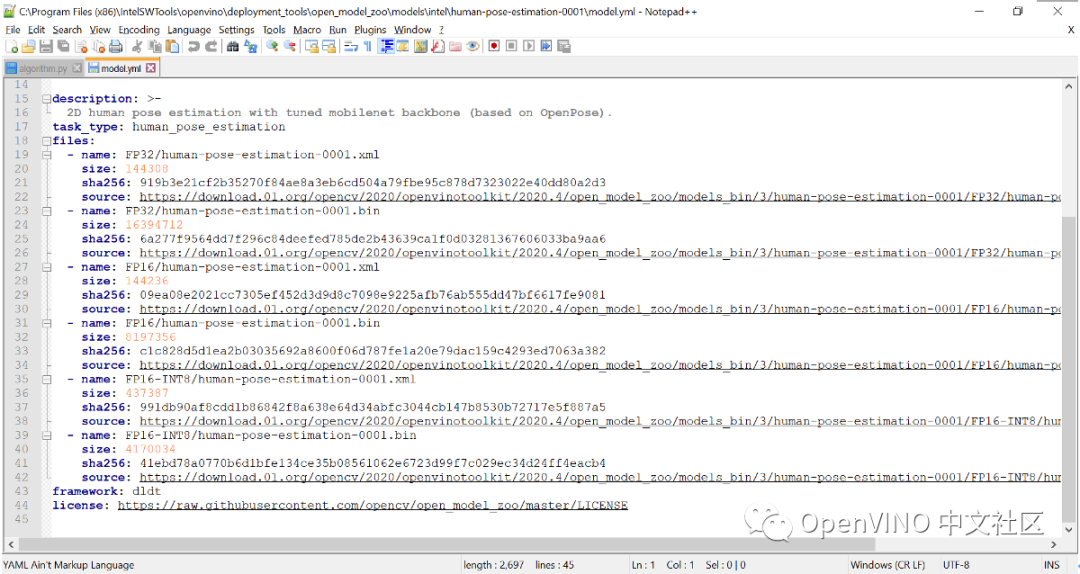

在C:\Program Files (x86)\IntelSWTools\openvino\deployment_tools\open_model_zoo\models的 intel 和 public 目录中,每个模型的路径下有个 model.yml,其中配置了模型的下载路径,可以直接去网站上下载。

16. 如何在使用 Model Optimizer 转模型的时候截取子网络?

运行 mo.py 脚本时指定 –input 和 --output 参数为要截取的网络的输入和输出节点即可,请参考:https://docs.openvinotoolkit.org/latest/_docs_MO_DG_prepare_model_convert_model_Cutting_Model.html

17. OpenVINO 能转换 Tensorflow2.0 的模型吗?

从2020.4开始支持 Tensorflow2.2.0。

18. 模型优化器可以将模型转换成 INT8 精度吗?

不可以,INT8 量化可以使用 OpenVINO 中的 Post Training Optimization Toolkit。参考:https://docs.openvinotoolkit.org/2020.3/_README.html

19. 模型优化器对模型做了哪些优化?

请参考:https://docs.openvinotoolkit.org/2020.3/_docs_MO_DG_prepare_model_Model_Optimization_Techniques.html

20. 模型优化器如何转换 Tensorflow Object Detection API 模型?

请参考:https://docs.openvinotoolkit.org/latest/_docs_MO_DG_prepare_model_convert_model_tf_specific_Convert_Object_Detection_API_Models.html

21. 在 OpenVINO 中如何将 Caffe 开源框架训练出来的模型转为 IR 格式?

请参考:https://docs.openvinotoolkit.org/latest/openvino_docs_MO_DG_prepare_model_convert_model_Convert_Model_From_Caffe.html

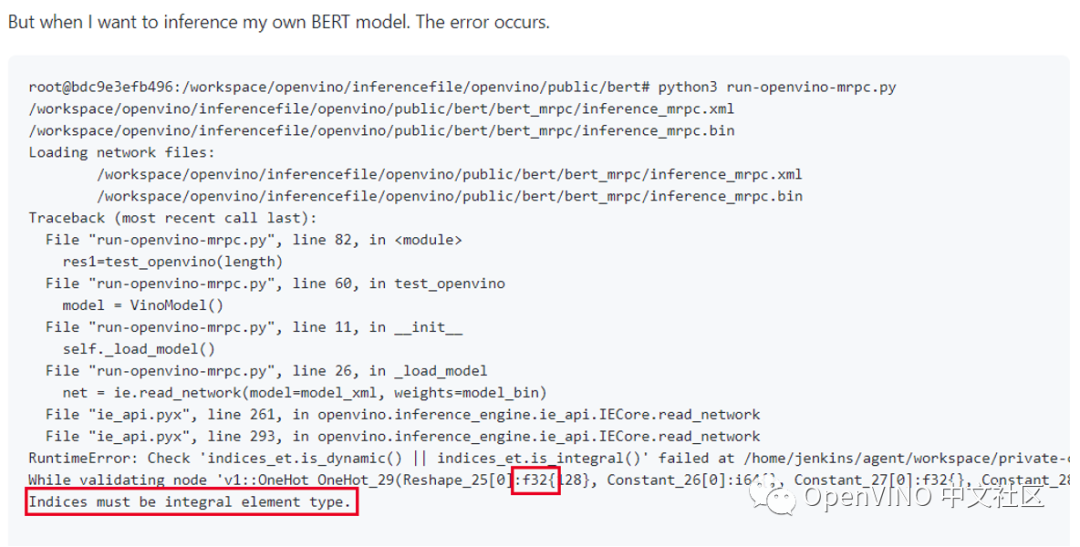

22. 自己训练的 Bert 模型转换成功,但是使用 Inference Engine 加载模型时出错:

模型转换命令:

python mo_tf.py

--input_model xxx.pb

--disable_nhwc_to_nchw

--input IteratorGetNext:0,IteratorGetNext:1,IteratorGetNext:4

--input_shape [1,128],[1,128],[1,128]

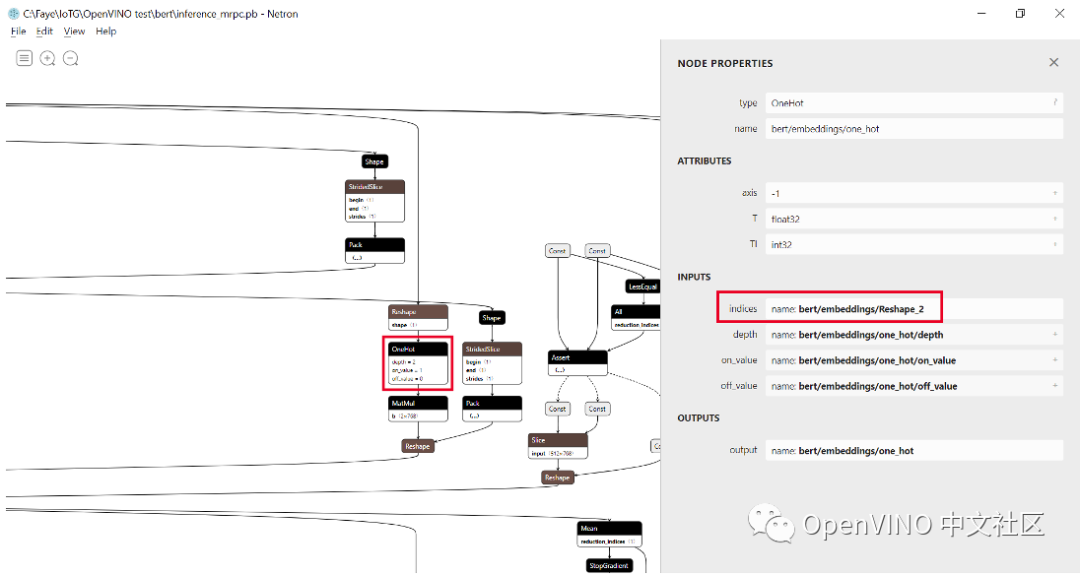

原因调查:从 PB 文件中可以查看到 OneHot 的 Indices 输入是 Reshape2,该节点在 pb 中是 int32,转换以后变成 float32。

解决方案:转换模型时添加数据类型信息

python mo_tf.py

--input_model xxx.pb

--disable_nhwc_to_nchw

--input IteratorGetNext:0{i32},IteratorGetNext:1{i32},IteratorGetNext:4{i32}

--input_shape [1,128],[1,128],[1,128]

参考链接:

https://docs.openvinotoolkit.org/latest/openvino_docs_MO_DG_prepare_model_convert_model_tf_specific_Convert_BERT_From_Tensorflow.html

23. PyTorch 转 ONNX,再转 IR 时,Unsample 操作转不了

解决方案:Pytorch 转 ONNX 时,指定 opset_version=10 是可以的。(2020.3之前版本中测试通过)

24. 如何做到 OpenVINO 最小部署?即:不需要额外的开销,只打包必要的文件。

在 Linux 版本中可以使用 Deployment Manager 生成最小部署包。请参考:https://docs.openvinotoolkit.org/2020.3/_docs_install_guides_deployment_manager_tool.html

25. 尝试使用项目:

https://github.com/opencv/openvino_training_extensions/tree/develop/pytorch_toolkit/object_detection/person-vehicle-bike-detection

中的训练脚本重新训练模型时,自己安装了 mmdetection 官方工具,但是提示不支持 pytorch 预训练模型。

openvino_training_extensions 中使用的 mmdetection 是 Intel 在开源框架上做过二次开发的,搭建环境时请参考:https://github.com/opencv/openvino_training_extensions/tree/develop/pytorch_toolkit/object_detection

26. 在 CPU 上如何设置参数优化 OpenVINO 部署?

请参考:https://docs.openvinotoolkit.org/latest/_docs_IE_DG_supported_plugins_CPU.html#supported_configuration_parameters

27. 我有多个计算棒,在加载模型时用 MYRIAD 是否会自动分配?

MultiDevice 自动负载均衡通常针对多设备跑一个模型,如果是多个模型,需要自己写代码指定哪个 MYRIAD 加载哪个模型。

28. iGPU 加载模型很慢怎么办?

参考:https://github.com/intel/compute runtime/blob/master/opencl/doc/FAQ.md,cl-cache设置部分,设置好以后,虽然第一次加载还是会慢,但是后面再重新加载时会很快。

--END--

?欢迎在留言区与我们互动哦, 点击小程序 留言区 即可参与留言区

---------------------------------------

*OpenVINO and the OpenVINO logo are trademarks of Intel Corporation or its subsidiaries.

-----------------------------

OpenVINO 中文社区

微信号 : openvinodev

B站:OpenVINO中文社区

OSCHINA:OpenVINO 中文社区

“开放、开源、共创”

致力于通过定期举办线上与线下的沙龙、动手实践及开发者交流大会等活动,促进人工智能开发者之间的交流学习。

○ 点击 “ 在看 ”,让更多人看见

点击阅读原文立即体验OpenVINO

3856

3856

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?