LangFlow结合ChatGPT构建企业级对话系统

在客户咨询量激增、服务响应时效要求越来越高的今天,越来越多的企业开始尝试用AI替代或辅助人工客服。但现实往往并不理想:早期的规则引擎机器人“答非所问”,而直接调用大模型又容易“胡说八道”。如何让AI既聪明又能落地?一个正在被广泛验证的技术路径浮出水面——通过LangFlow可视化编排,将ChatGPT深度集成到企业业务流程中。

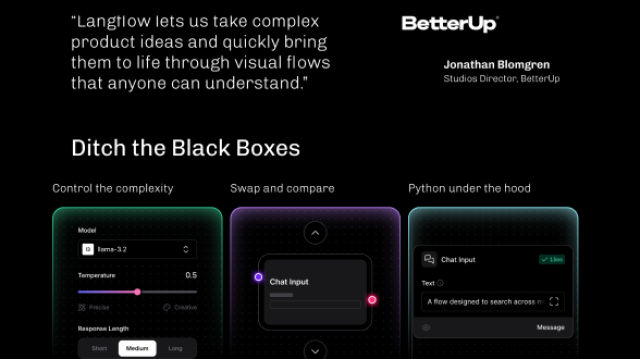

这不仅是技术选型的问题,更是一场开发范式的变革。过去,搭建一个能理解上下文、调用数据库、基于知识库作答的对话系统,需要一支熟悉LangChain、会写Python、懂Prompt工程的AI团队;而现在,产品经理拖拽几个节点,就能跑通整个逻辑。这种转变的背后,是LangFlow与ChatGPT协同作用的结果。

LangFlow的本质,是一个为LangChain量身打造的图形化操作界面。它把原本藏在代码里的复杂流程,变成了一张可看、可调、可共享的“AI电路图”。每个方块代表一个功能模块——比如语言模型、提示词模板、记忆组件或者向量检索器;每条连线则表示数据流动的方向。你不需要记住LLMChain怎么初始化,也不用反复调试PromptTemplate的格式,只需要像搭积木一样连接这些节点,系统就会自动生成对应的Python代码,并允许你实时输入问题、查看每一步的输出结果。

举个例子,设想你要做一个智能售后助手。用户问:“我上周下的订单还没发货,怎么回事?”

这个看似简单的问题,背后其实涉及多个环节:

- 要识别这是关于“订单状态”的查询;

- 需要从对话历史中提取时间线索(“上周”);

- 去CRM系统或数据库查找该用户的订单记录;

- 如果查不到,可能还要触发人工介入流程。

传统做法下,这至少得写上百行代码,还得反复测试边界情况。但在LangFlow里,你可以这样设计工作流:

- 从左侧组件栏拖出一个 Input Text Node 接收用户输入;

- 添加一个 Prompt Template Node,预设一段结构化提示语,引导模型判断意图;

- 连接到 ChatOpenAI Node,让它输出标准化的意图标签,如

order_inquiry; - 再接一个 SQL Database Chain Node 或 Vector Store Retriever,根据意图去查询相关信息;

- 最后通过另一个 LLMChain 将检索结果组织成自然语言回复。

整个过程完全可视,任何一个节点都可以双击打开参数面板进行调整。更重要的是,当你点击“运行”按钮时,能看到每一阶段的数据流转:原始输入 → 意图识别结果 → 数据库返回内容 → 最终回答生成。这种透明性对于调试和协作至关重要。

而且,这套流程不是只能看看而已。LangFlow支持一键导出标准Python脚本,这意味着你在界面上设计的一切,都能无缝迁移到生产环境。导出的代码结构清晰,遵循LangChain最佳实践,甚至可以直接作为微服务的一部分部署在FastAPI或Flask后端上。

from langchain.chains import LLMChain

from langchain.prompts import PromptTemplate

from langchain.chat_models import ChatOpenAI

template = "你是一个企业客服助手,请根据以下信息回答用户问题:{question}"

prompt = PromptTemplate(template=template, input_variables=["question"])

llm = ChatOpenAI(model_name="gpt-3.5-turbo", temperature=0.7)

chain = LLMChain(llm=llm, prompt=prompt)

response = chain.run(question="如何重置密码?")

print(response)

这段代码看起来普通,但它正是LangFlow后台自动生成的核心逻辑之一。你可以把它嵌入到企业微信机器人、官网聊天窗口或内部OA系统中,实现真正的自动化服务。

当然,光有流程编排还不够。真正让这套系统“智能”的,是背后的语言模型能力。在这方面,ChatGPT依然是目前最成熟的选择之一。尤其是gpt-3.5-turbo和gpt-4-turbo版本,在多轮对话理解、长文本处理(最高支持128K上下文)、多语言支持等方面表现优异。更重要的是,它的API稳定、文档完善、社区活跃,企业接入几乎没有技术障碍。

但直接裸调ChatGPT风险不小。最常见的问题包括:

- 幻觉(Hallucination):模型会自信地编造不存在的信息;

- 数据泄露:敏感客户数据上传至第三方服务器存在合规隐患;

- 成本失控:高并发场景下Token消耗迅速攀升;

- 响应延迟:网络抖动或模型排队可能导致用户体验下降。

这些问题不能靠模型本身解决,必须依靠架构设计来规避。而LangFlow的价值恰恰体现在这里——它不是一个孤立的工具,而是整个AI工程链路中的关键一环。

比如,针对“幻觉”问题,可以在流程中加入检索增强生成(RAG) 模块。具体来说,当用户提问时,先不急着让ChatGPT作答,而是先通过向量数据库(如Pinecone、Chroma)检索企业内部的知识文档、产品手册或历史工单,找出最相关的片段,再把这些真实依据拼接到提示词中传给模型。这样一来,模型的回答就有了“事实锚点”,大大降低胡编乱造的概率。

from langchain.memory import ConversationBufferMemory

from langchain.chains import ConversationChain

memory = ConversationBufferMemory()

conversation = ConversationChain(

llm=ChatOpenAI(temperature=0),

memory=memory

)

print(conversation.predict(input="你好,我最近订单没收到,能查一下吗?"))

print(conversation.predict(input="那大概什么时候能发货?"))

上面这段代码展示了如何启用对话记忆功能,使模型能够记住之前的交互内容。而在LangFlow中,只需勾选某个复选框或添加一个Memory节点即可实现相同效果。这种“低代码+高能力”的组合,极大提升了系统的可用性和可维护性。

实际落地时,我们还会遇到更多工程细节问题。例如:

- 权限控制:LangFlow默认是开放访问的,但如果部署在内网供多人使用,就必须加上身份认证机制,防止未授权修改核心流程。

- 性能优化:对于高频问题(如“忘记密码怎么办”),可以引入Redis缓存机制,避免重复走完整推理流程。

- 异常处理:API调用失败怎么办?应该设置超时重试策略,并准备降级方案,比如返回预设的标准应答。

- 日志审计:每一次请求的输入、输出、耗时都应记录下来,便于后续分析用户行为、发现bad case并持续迭代。

此外,随着企业对数据安全的要求提高,越来越多公司倾向于使用本地化部署的大模型。好消息是,LangFlow原生支持多种LLM后端,无论是OpenAI API、Hugging Face托管模型,还是运行在本地GPU上的Llama 3、ChatGLM等开源模型,都可以轻松替换接入。这意味着你可以先用ChatGPT快速验证原型,待业务跑通后再切换到私有模型以降低成本和风险。

最终呈现的企业级对话系统,通常具备这样的架构层次:

+------------------+ +--------------------+

| 用户交互层 |<----->| LangFlow前端界面 |

| (Web/App/小程序) | | (可视化流程设计器) |

+------------------+ +----------+---------+

|

v

+-----------v----------+

| LangFlow后端服务 |

| (Flask/FastAPI服务器) |

+-----------+----------+

|

v

+----------------------------------+

| LangChain运行时 |

| - 提示工程 | 记忆管理 | 工具调用 |

+----------------------------------+

|

v

+-------------------------------+

| LLM 接口层 (如ChatGPT) |

| 调用OpenAI API 或 本地LLM |

+-------------------------------+

|

v

+----------------------------------+

| 外部系统集成(DB/API/知识库) |

| 向量数据库 | CRM | ERP | RAG检索 |

+----------------------------------+

在这个体系中,LangFlow扮演的是“中央控制台”的角色。它既是设计师的画布,也是开发者的脚手架,更是运维人员的监控面板。不同角色可以围绕同一套流程高效协作:业务方提出需求,产品设计流程,工程师部署上线,运营根据日志反馈优化节点配置——整个闭环变得前所未有的顺畅。

回头来看,LangFlow + ChatGPT 的组合之所以能在企业级应用中脱颖而出,根本原因在于它解决了AI落地的两大核心矛盾:

一是敏捷性与稳定性之间的矛盾。企业需要快速试错,但又不能牺牲系统可靠性。LangFlow提供的可视化调试能力,使得每次变更都能被即时验证,降低了试错成本。

二是专业性与普及性之间的矛盾。AI本应是赋能工具,却不该只掌握在少数工程师手中。通过图形化界面,让更多非技术人员也能参与AI流程的设计与优化,这才是真正的“民主化”。

未来,随着LangFlow生态不断完善——比如出现更多行业模板、插件市场、团队协作功能——我们可以预见,类似“客服流程自动编排”、“销售话术智能推荐”、“合同条款辅助审查”这样的AI应用将加速普及。它们不再依赖庞大的研发团队,而是由一线业务人员自己就能搭建和迭代。

某种意义上,LangFlow不只是一个工具,它是通往“人人皆可构建AI”的桥梁。而当每一个员工都能用自己的方式调用大模型解决问题时,企业的智能化转型才算真正开始。

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考

751

751

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?