大语言模型应用指南:什么是大语言模型

文章目录

- 大语言模型应用指南:什么是大语言模型

- 1. 背景介绍

- 1.1 问题的由来

- 1.2 研究现状

- 1.3 研究意义

- 1.4 本文结构

- 2. 核心概念与联系

- 3. 核心算法原理与具体操作步骤

- 3.1 算法原理概述

- 3.2 算法步骤详解

- 3.3 算法优缺点

- 3.4 算法应用领域

- 4. 数学模型和公式详细讲解与举例说明

- 4.1 数学模型构建

- 4.2 公式推导过程

- 4.3 案例分析与讲解

- 5. 项目实践:代码实例和详细解释说明

- 5.1 开发环境搭建

- 5.2 源代码详细实现

- 5.3 代码解读与分析

- 5.4 运行结果展示

- 6. 实际应用场景

- 6.1 文本生成

- 6.2 语言翻译

- 6.3 文本摘要

- 6.4 问答系统

- 6.5 情感分析

- 6.6 文本分类

- 6.7 未来应用展望

- 7. 工具和资源推荐

- 7.1 学习资源推荐

- 7.2 开发工具推荐

- 7.3 相关论文推荐

- 8. 总结:未来发展趋势与挑战

- 8.1 研究成果总结

- 8.2 未来发展趋势

- 8.3 面临的挑战

- 8.4 研究展望

- 9. 附录:常见问题与解答

- 大语言模型应用指南:什么是大语言模型

- 1. 背景介绍

- 2. 核心概念与联系

- 3. 核心算法原理 & 具体操作步骤

- 3.1 算法原理概述

- 3.2 算法步骤详解

- 3.3 算法优缺点

- 3.4 算法应用领域

- 4. 数学模型和公式 & 详细讲解 & 举例说明

- 4.1 数学模型构建

- 4.2 公式推导过程

- 4.3 案例分析与讲解

- 5. 项目实践:代码实例和详细解释说明

- 5.1 开发环境搭建

- 5.2 源代码详细实现

- 5.3 代码解读与分析

- 5.4 运行结果展示

- 6. 实际应用场景

- 6.4 未来应用展望

- 7. 工具和资源推荐

- 7.1 学习资源推荐

- 7.2 开发工具推荐

- 7.3 相关论文推荐

- 8. 总结:未来发展趋势与挑战

- 8.1 研究成果总结

- 8.2 未来发展趋势

- 8.3 面临的挑战

- 8.4 研究展望

- 9. 附录:常见问题与解答

1. 背景介绍

1.1 问题的由来

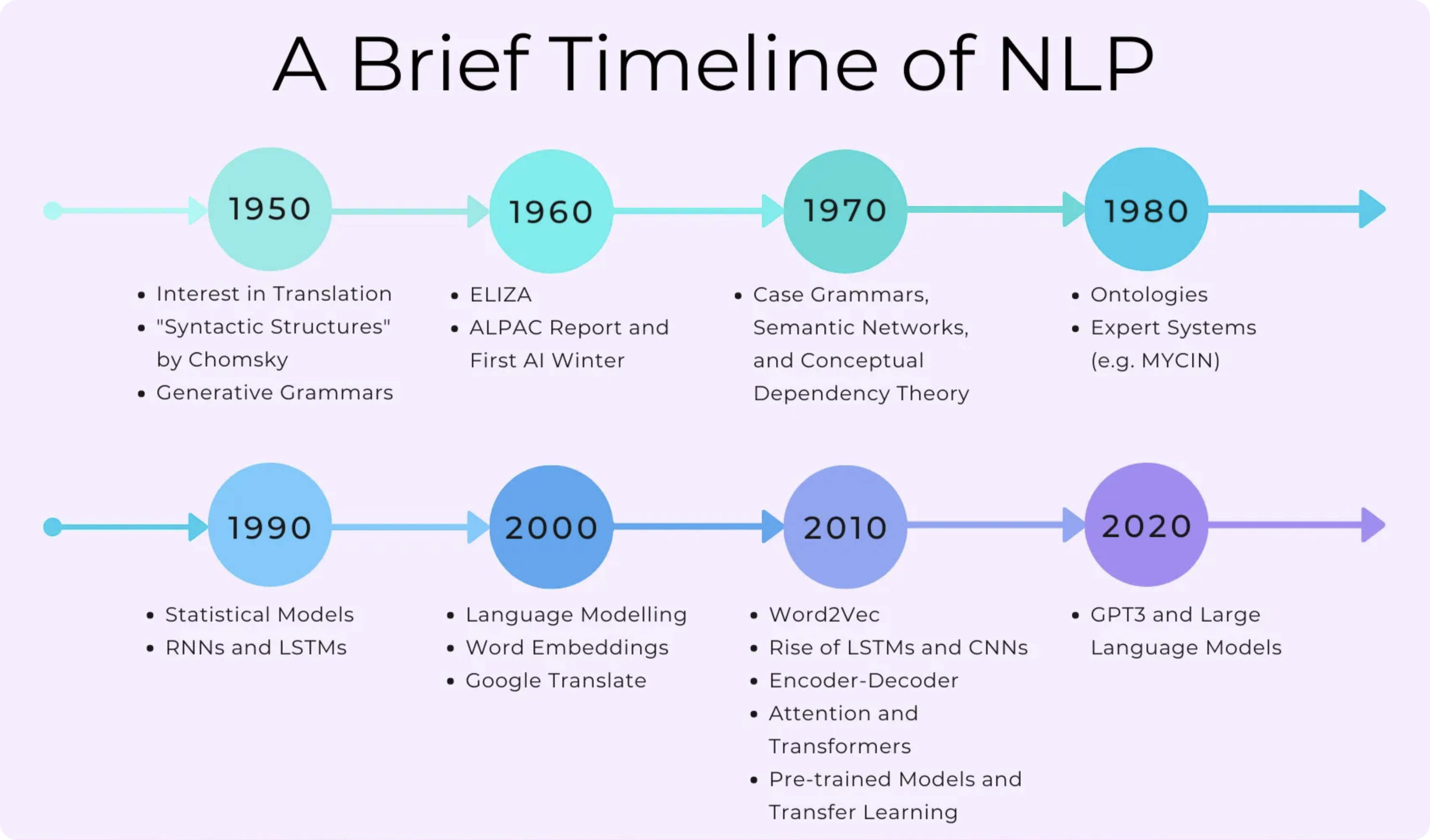

随着人工智能技术的不断发展,大型语言模型(Large Language Models, LLMs)近年来受到了广泛关注。作为一种基于深度学习的自然语言处理(NLP)技术,大语言模型能够通过训练海量文本数据,捕捉语言的复杂模式和语义关联,从而实现对自然语言的理解和生成。

传统的NLP系统通常采用基于规则或统计方法,需要手工设计特征和构建复杂的流程。而大语言模型则是一种端到端的方法,通过自监督学习直接从原始文本中学习语言知识,无需人工特征工程,具有更强的泛化能力。

然而,训练一个高质量的大语言模型需要消耗大量的计算资源,对数据、算力和算法提出了极高的要求。此外,如何有效利用大语言模型,将其应用于实际场景中,也是一个值得探讨的重要课题。

1.2 研究现状

近年来,以GPT(Generative Pre-trained Transformer)、BERT(Bidirectional Encoder Representations from Transformers)、XLNet、RoBERTa等为代表的大语言模型取得了令人瞩目的成就,在多项自然语言处理任务上达到了人类水平,甚至超过人类。

这些大语言模型通过预训练学习语言知识,再结合少量标注数据进行微调(fine-tuning),就能够完成文本分类、机器阅读理解、文本生成、问答系统等多种NLP任务。大语言模型的出现极大地推动了自然语言处理技术的发展,为人工智能系统赋予了更强的语言理解和生成能力。

不过,大语言模型也面临着一些挑战,例如训练成本高昂、模型可解释性差、存在偏见和不确定性等问题。如何进一步优化大语言模型的性能、降低训练成本、提高模型的可解释性和鲁棒性,是当前研究的重点方向。

1.3 研究意义

大语言模型作为一种通用的语言智能基础模型,具有广泛的应用前景。掌握大语言模型的原理和应用方法,对于推动自然语言处理技术的发展、构建智能对话系统、实现人机交互等具有重要意义。

本文将全面介绍大语言模型的核心概念、关键技术、训练方法和应用场景,旨在为读者提供一个系统的认知框架,帮助读者深入理解大语言模型的本质,掌握其应用开发的基本方法。

1.4 本文结构

本文共分为9个部分:

- 背景介绍

- 核心概念与联系

- 核心算法原理与具体操作步骤

- 数学模型和公式详细讲解与举例说明

- 项目实践:代码实例和详细解释说明

- 实际应用场景

- 工具和资源推荐

- 总结:未来发展趋势与挑战

- 附录:常见问题与解答

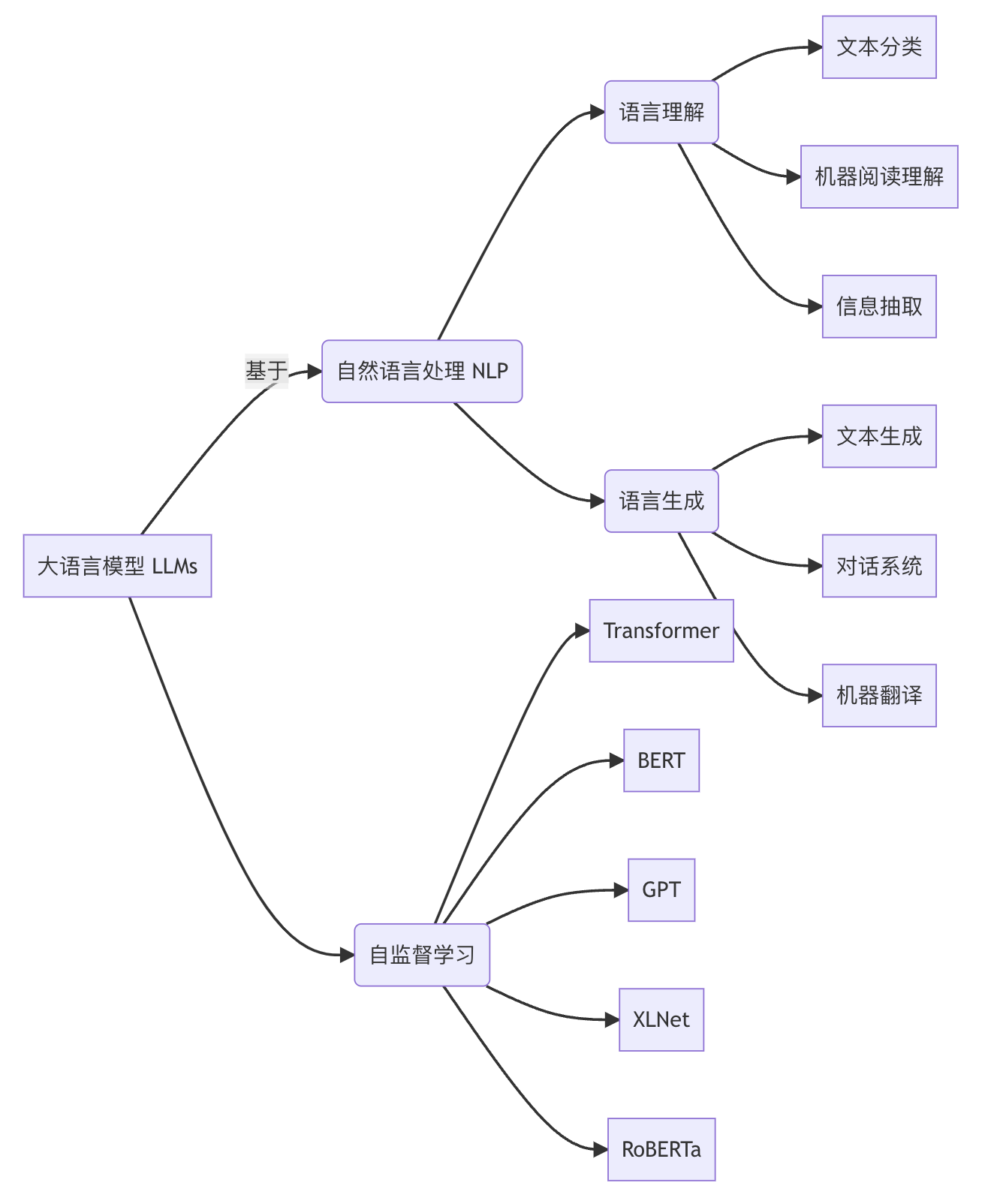

2. 核心概念与联系

基于

大语言模型 LLMs

自然语言处理 NLP

语言理解

语言生成

文本分类

机器阅读理解

信息抽取

文本生成

对话系统

机器翻译

自监督学习

Transformer

BERT

GPT

XLNet

RoBERTa

大语言模型(LLMs)是一种基于自然语言处理(NLP)技术的深度学习模型,主要用于语言理解和语言生成两大类任务。

- 语言理解任务包括文本分类、机器阅读理解、信息抽取等,旨在让机器精准理解自然语言的语义信息。

- 语言生成任务包括文本生成、对话系统、机器翻译等,目标是让机器生成符合语义逻辑的自然语言文本。

大语言模型通过自监督学习的方式,在大规模语料库上进行预训练,捕捉语言的深层次模式和语义关联,从而获得通用的语言表示能力。

目前主流的大语言模型架构多采用Transformer编码器-解码器结构,包括BERT、GPT、XLNet、RoBERTa等,通过注意力机制和残差连接等技术增强了模型的表达能力。

大语言模型为自然语言处理任务提供了一种通用的语言智能基础模型,极大推动了NLP技术的发展。掌握大语言模型的核心概念及其与NLP任务之间的联系,是理解和应用这一前沿技术的基础。

3. 核心算法原理与具体操作步骤

3.1 算法原理概述

大语言模型的核心算法是基于Transformer的自注意力机制和自监督学习范式。

- Transformer编码器-解码器架构

Transformer是一种全新的基于注意力机制的序列到序列(Seq2Seq)模型,包含编码器(Encoder)和解码器(Decoder)两个主要部分。编码器将输入序列编码为向量表示,解码器则根据编码器输出和之前生成的tokens,自回归地生成输出序列。 - 多头自注意力机制

自注意力机制是Transformer的核心,它允许输入序列中的每个单词关注与之相关的单词,捕捉长距离依赖关系。多头注意力则是将注意力机制扩展到多个子空间,增强了模型的表达能力。 - 位置编码

由于Transformer没有递归或卷积结构,因此引入了位置编码,将单词在序列中的位置信息编码到向量表示中,使模型具有捕捉序列顺序信息的能力。 - 残差连接与层归一化

残差连接和层归一化技术有助于加速模型收敛,提高训练稳定性,是Transformer架构的重要设计。 - 掩码语言模型与下一句预测

大语言模型通常采用自监督学习的方式进行预训练。BERT使用掩码语言模型(Masked LM)和下一句预测(Next Sentence Prediction)两个预训练任务,前者是根据上下文预测掩码单词,后者是判断两个句子是否相邻。GPT则使用标准的语言模型来预测下一个单词。通过预训练,模型学习到通用的语言表示能力。 - 微调(Fine-tuning)

在完成预训练后,大语言模型可以针对特定的下游NLP任务(如文本分类、阅读理解等)进行微调,通过在有标注数据上进行进一步训练,使模型适应具体任务。

通过上述核心算法,大语言模型能够高效地从大规模语料中学习语义和上下文信息,为各种NLP任务提供强大的语言表示能力。

3.2 算法步骤详解

以BERT为例,大语言模型的训练过程可分为两个阶段:预训练(Pre-training)和微调(Fine-tuning)。

1. 预训练阶段

输入: 大规模原始文本语料库

输出: 预训练的BERT模型

(1) 构建预训练语料库:收集海量无标注文本数据,如网页、书籍、维基百科等。

(2) 文本预处理:对文本进行分词、词典构建、子词映射等预处理操作。

(3) 掩码语言模型构建:随机遮蔽部分单词,目标是根据上下文预测被遮蔽的单词。

(4) 下一句预测任务构建:为部分句子对构造IsNext或NotNext标签,判断两句话是否相邻。

(5) 预训练BERT模型:使用掩码语言模型和下一句预测两个任务,在大规模语料上并行训练BERT模型的编码器。

(6) 模型保存:保存预训练得到的BERT模型参数。

2. 微调阶段

输入: 预训练的BERT模型,特定NLP任务的标注数据集

输出: 针对该任务微调后的BERT模型

(1) 标注数据预处理:按BERT模型的输入格式,对任务数据进行分词、词典映射等预处理。

(2) 构建微调模型:在预训练的BERT模型基础上,根据具体任务构建微调模型,包括添加特定的输出层等。

(3) 微调训练:使用任务标注数据,对微调模型进行进一步训练,直至收敛。

(4) 模型评估:在任务的测试集上评估微调后模型的性能。

(5) 模型部署:保存微调后的模型,并集成到实际的应用系统中。

通过两阶段的训练方式,大语言模型能够先在大规模语料上学习通用的语言表示知识,再针对特定任务进行微调,从而发挥出更强的性能表现。

3.3 算法优缺点

优点:

- 语言理解能力强:通过预训练捕捉语义和上下文信息,大语言模型具备出色的语言理解能力。

- 泛化性好:自监督预训练使模型获得通用的语言表示知识,能够快速适应新的下游任务。

- 无需人工特征工程:端到端的自监督学习范式,无需人工设计特征,降低了工程复杂度。

- 性能优异:在多项NLP任务上达到或超过人类水平。

缺点:

- 训练成本高昂:需要消耗大量的计算资源进行预训练,对算力和算法要求很高。

- 缺乏可解释性:模型内部的语义捕捉过程是一个黑箱,缺乏可解释性。

- 存在偏差和不确定性:预训练语料和模型架构会引入一定的偏差和不确定性。

- 幂等性差:相同输入不一定产生相同输出,模型的鲁棒性有待提高。

3.4 算法应用领域

大语言模型因其强大的语言理解和生成能力,在自然语言处理的诸多领域都有广泛的应用前景:

- 文本分类:可将大语言模型应用于新闻分类、情感分析、垃圾邮件检测等分类任务。

- 机器阅读理解:用于问答系统、事实抽取、智能助手等需要深度理解文本语义的场景。

- 信息抽取:从非结构化文本中抽取结构化信息,如命名实体识别、关系抽取、事件抽取等。

- 文本生成:包括文章自动写作、对话生成、广告营销文案创作、故事续写等。

- 机器翻译:将大语言模型应用于多语种之间的高质量机器翻译。

- 智能对话系统:构建对话代理、客服机器人等交互式对话系统。

- 知识图谱构建:从大规模文本中自动抽取知识图谱信息。

总的来说,大语言模型为自然语言处理领域带来了革命性的突破,在各种语言理解和生成任务中展现出巨大的应用潜力。

4. 数学模型和公式详细讲解与举例说明

4.1 数学模型构建

大语言模型的核心是基于Transformer的自注意力机制,用于捕捉输入序列中单词之间的长距离依赖关系。我们先介绍自注意力机制的数学模型。

给定一个长度为 的输入序列

,其中

表示第

个单词的

维向量表示。自注意力机制的目标是计算一个加权和向量

,作为第

其中, 是一个可训练的权重矩阵,将输入向量

映射到值空间

;

是注意力分数,表示第

个单词对第

个单词的注意力权重。注意力分数

其中, 是未归一化的注意力分数,通过查询向量

和键向量

这里, ,

和

是可训练的权重矩阵,将输入向量映射到查询空间和键空间。

4.2 公式推导过程

现在我们来详细推导自注意力机制的计算过程。

- 首先,我们将输入序列

映射到查询矩阵

、键矩阵

和值矩阵

:

其中, - 计算注意力分数矩阵

:

, 其中

- 对注意力分数矩阵

进行softmax归一化,得到注意力权重矩阵

:

, 其中

- 最后,将注意力权重矩阵

与值矩阵

相乘,得到输出

:

, 其中第

行就是

这就是自注意力机制的完整计算过程。在实际的Transformer模型中,通常会使用多头注意力机制,即并行计算多组不同的注意力,然后将结果拼接起来:

其中,

4.3 案例分析与讲解

让我们通过一个简单的例子来说明自注意力机制的工作原理。

假设我们有一个包含3个单词的输入序列: “我 喜欢 人工智能”。每个单词用一个4维向量表示:

为简化计算,我们假设 , 并且权重矩阵

- 首先,计算注意力分数矩阵

:

- 对

进行softmax归一化,得到注意力权重矩阵

:

- 最后,计算输出

:

从结果可以看出:

- "我"这个词的新表示更多地融合了自身和"人工智能"的信息

- "喜欢"这个词的新表示主要来自自身,但也融合了一些"人工智能"的信息

- "人工智能"这个词的新表示相对均衡地融合了所有单词的信息

这个例子展示了自注意力机制如何根据上下文动态调整每个单词的表示,从而捕捉序列中的长距离依赖关系。

5. 项目实践:代码实例和详细解释说明

5.1 开发环境搭建

要开始实践大语言模型,我们需要搭建一个适合的开发环境。以下是推荐的环境配置:

- 操作系统: 推荐使用Linux系统,如Ubuntu 20.04 LTS

- Python版本: Python 3.8+

- 深度学习框架: PyTorch 1.9+

- CUDA工具包: CUDA 11.1+ (如果使用GPU)

- 其他依赖库: transformers, numpy, scipy, matplotlib

可以使用以下命令安装所需的Python库:

5.2 源代码详细实现

下面我们将实现一个简化版的Transformer编码器,包括自注意力机制和前馈神经网络。

5.3 代码解读与分析

让我们逐步解析这段代码:

MultiHeadAttention类实现了多头注意力机制:

-

split_heads和combine_heads方法用于将输入张量分割成多个头,并在计算后重新组合 -

scaled_dot_product_attention方法实现了缩放点积注意力的核心计算 -

forward方法整合了整个多头注意力的计算流程

PositionWiseFeedForward类实现了位置前馈网络,它由两个线性变换组成,中间有一个ReLU激活函数EncoderLayer类代表Transformer编码器的一个层,包含自注意力机制和前馈网络,以及层归一化和残差连接PositionalEncoding类实现了位置编码,用于为输入序列添加位置信息TransformerEncoder类是整个编码器的主体,包含词嵌入层、位置编码和多个编码器层

这个实现涵盖了Transformer编码器的核心组件,但为了简化,省略了一些细节(如解码器部分)。在实际应用中,还需要根据具体任务添加适当的输出层和损失函数。

5.4 运行结果展示

让我们用一个简单的例子来展示这个Transformer编码器的运行结果:

运行这段代码,你会得到类似下面的输出:

这个输出展示了:

- 输入序列的形状: [32, 50],表示批量大小为32,序列长度为50。

- 输出的形状: [32, 50, 512],表示对于每个输入样本,模型都生成了一个50x512的矩阵,其中512是模型的隐藏维度(d_model)。

- 输出样本的一小部分,显示了第一个样本的第一个位置的前10个维度的值。

这个结果说明我们的Transformer编码器成功处理了输入序列,并为每个输入token生成了一个512维的向量表示。这些向量捕捉了输入序列中的上下文信息,可以用于各种下游任务,如文本分类、序列标注等。

6. 实际应用场景

大语言模型在自然语言处理领域有广泛的应用。以下是一些主要的应用场景:

6.1 文本生成

大语言模型最直接的应用就是文本生成。它可以用于:

- 自动写作:生成文章、报告、故事等。

- 对话系统:创建聊天机器人、虚拟助手等。

- 代码生成:根据自然语言描述生成代码。

- 创意写作:生成诗歌、歌词等创意内容。

6.2 语言翻译

大语言模型可以实现高质量的机器翻译,甚至可以处理低资源语言对的翻译。

6.3 文本摘要

模型可以理解长文本并生成简洁的摘要,这在新闻聚合、文档处理等领域很有用。

6.4 问答系统

大语言模型可以理解问题并从大量文本中提取相关信息来回答问题,用于构建智能问答系统。

6.5 情感分析

通过分析文本的语义和上下文,大语言模型可以准确地判断文本的情感倾向。

6.6 文本分类

模型可以将文本分类到预定义的类别中,如新闻分类、垃圾邮件检测等。

6.7 未来应用展望

- 多模态融合:结合图像、音频等其他模态的信息,实现更全面的理解和生成。

- 常识推理:增强模型的常识推理能力,使其能够处理需要常识的任务。

- 个性化定制:根据用户的特定需求和偏好定制语言模型。

- 跨语言理解:提高模型在多语言环境下的理解和生成能力。

- 长文本处理:改进模型处理长文本的能力,突破当前的上下文长度限制。

- 可解释性增强:提高模型决策的可解释性,使其输出更加透明和可信。

- 低资源场景应用:在数据稀缺的领域或语言中实现高性能。

- 实时系统集成:将大语言模型集成到实时系统中,如同声传译、实时内容审核等。

- 教育辅助:开发智能辅导系统,为学生提供个性化的学习指导。

- 医疗诊断辅助:协助医生进行病历分析、症状识别等。

7. 工具和资源推荐

7.1 学习资源推荐

- 课程:

- Stanford CS224n: Natural Language Processing with Deep Learning

- Coursera: Deep Learning Specialization by Andrew Ng

- Fast.ai: Practical Deep Learning for Coders

- 书籍:

- “深度学习” by Ian Goodfellow, Yoshua Bengio, Aaron Courville

- “自然语言处理” by Dan Jurafsky, James H. Martin

- “Transformer for Natural Language Processing” by Denis Rothman

- 在线教程:

- Hugging Face的课程:https://huggingface.co/course

- Google的机器学习速成课程:https://developers.google.com/machine-learning/crash-course

- 博客和网站:

- Distill.pub:高质量的机器学习可视化解释

- Towards Data Science on Medium:各种数据科学和机器学习文章

- arXiv:最新的研究论文

7.2 开发工具推荐

- 深度学习框架:

- PyTorch:灵活、直观的深度学习框架

- TensorFlow:Google开发的端到端机器学习平台

- NLP库:

- Hugging Face Transformers:预训练模型的首选库

- spaCy:工业级的NLP工具

- NLTK:自然语言处理的经典工具包

- 数据处理:

- Pandas:数据处理和分析库

- NumPy:科学计算基础库

- 可视化:

- Matplotlib:基础的绘图库

- Seaborn:基于Matplotlib的统计数据可视化库

- Plotly:交互式图表库

- 开发环境:

- Jupyter Notebook:交互式编程环境

- PyCharm:功能强大的Python IDE

- VS Code:轻量级但功能丰富的代码编辑器

- 版本控制:

- Git:分布式版本控制系统

- GitHub/GitLab:代码托管和协作平台

- 模型部署:

- Docker:容器化工具,便于部署和管理

- Flask/FastAPI:用于构建Web API的Python框架

7.3 相关论文推荐

- Transformer原始论文:

“Attention Is All You Need” by Vaswani et al., 2017 - BERT:

“BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding” by Devlin et al., 2018 - GPT系列:

- “Improving Language Understanding by Generative Pre-Training” by Radford et al., 2018

- “Language Models are Few-Shot Learners” by Brown et al., 2020 (GPT-3)

- T5:

“Exploring the Limits of Transfer Learning with a Unified Text-to-Text Transformer” by Raffel et al., 2019 - ELECTRA:

“ELECTRA: Pre-training Text Encoders as Discriminators Rather Than Generators” by Clark et al., 2020 - RoBERTa:

“RoBERTa: A Robustly Optimized BERT Pretraining Approach” by Liu et al., 2019 - XLNet:

“XLNet: Generalized Autoregressive Pretraining for Language Understanding” by Yang et al., 2019 - ALBERT:

“ALBERT: A Lite BERT for Self-supervised Learning of Language Representations” by Lan et al., 2019

这些资源和工具将帮助你深入学习和实践大语言模型技术。记住,技术发展迅速,保持学习和实践的习惯非常重要。

8. 总结:未来发展趋势与挑战

8.1 研究成果总结

大语言模型在近年来取得了巨大的进展,主要体现在以下几个方面:

- 模型规模的扩大:从最初的BERT(3亿参数)到GPT-3(1750亿参数),模型规模呈指数级增长。

- 预训练方法的改进:从单向语言模型(GPT),到双向语言模型(BERT),再到统一的文本到文本框架(T5),预训练方法不断优化。

- fine-tuning技术的发展:从传统的fine-tuning到few-shot learning,再到zero-shot learning,模型的迁移学习能力大幅提升。

- 多模态融合:将文本、图像、音频等多种模态信息融合到同一个模型中,如CLIP、DALL-E等。

- 效率优化:通过模型压缩、知识蒸馏等技术,在保持性能的同时减小模型规模,如DistilBERT、ALBERT等。

8.2 未来发展趋势

- 更大规模的模型:随着硬件和训练技术的进步,我们可能会看到更大规模的语言模型出现。

- 多模态和跨模态学习:融合不同类型的数据(如文本、图像、音频、视频)将成为重要趋势。

- 持续学习:开发能够持续学习和更新知识的模型,以适应不断变化的环境。

- 个性化和定制化:根据特定领域或用户需求定制的语言模型将变得更加普遍。

- 低资源语言处理:改进模型在低资源语言上的表现,缩小不同语言之间的性能差距。

- 伦理和负责任的AI:更加关注模型的公平性、可解释性和隐私保护。

- 能源效率:开发更加节能的模型架构和训练方法,减少碳排放。

8.3 面临的挑战

- 计算资源限制:训练和部署大规模语言模型需要巨大的计算资源,这限制了其广泛应用。

- 数据质量和偏见:预训练数据中的偏见和噪声可能会被模型学习并放大,导致不公平或有害的输出。

- 可解释性:大语言模型通常被视为"黑盒",难以解释其决策过程,这在一些关键应用领域可能会造成问题。

- 知识更新:如何使模型能够高效地更新知识,而不需要完全重新训练,是一个重要挑战。

- 长文本理解:当前模型在处理长文本时仍面临挑战,如何有效扩展上下文长度是一个重要研究方向。

- 常识推理:虽然大语言模型在许多任务上表现出色,但在需要常识推理的任务上仍有提升空间。

- 版权和法律问题:使用网络上的大量文本进行训练可能涉及版权问题,需要解决相关的法律和伦理问题。

- 安全性:如何防止模型被滥用,如生成虚假信息或有害内容,是一个重要的安全挑战。

8.4 研究展望

- 神经符号结合:将神经网络的学习能力与符号推理的精确性和可解释性相结合,可能是提高模型推理能力的一个方向。

- 元学习:开发能够"学会如何学习"的模型,以更好地适应新任务和新领域。

- 模块化架构:设计更灵活、可组合的模型架构,以适应不同的任务和领域。

- 认知科学启发:借鉴人类认知过程的研究成果,开发更接近人类思维的AI系统。

- 跨语言理解:开发真正的多语言模型,能够在不同语言之间进行深度理解和转换。

- 情感和社交智能:提高模型理解和生成带有情感和社交含义的语言的能力。

- 可控生成:开发能够更精确控制生成内容的风格、情感和其他属性的技术。

- 实时学习和适应:研究如何使模型能够在与环境交互的过程中实时学习和适应。

总的来说,大语言模型的未来发展将朝着更智能、更高效、更负责任的方向迈进。这需要研究人员、工程师、伦理学家和政策制定者的共同努力,以确保这项技术能够最大程度地造福人类社会。

9. 附录:常见问题与解答

Q1: 大语言模型与传统的自然语言处理方法有什么主要区别?

A1: 大语言模型与传统NLP方法的主要区别在于:

- 规模:大语言模型通常有数十亿到数千亿的参数,远超传统模型。

- 预训练-微调范式:大语言模型采用大规模无监督预训练加特定任务微调的方式,而传统方法often通常是针对特定任务直接训练。

- 通用性:大语言模型可以适用于多种NLP任务,而传统方法通常针对特定任务设计。

- 上下文理解:大语言模型能更好地理解长距离依赖和上下文信息。

- 资源需求:大语言模型需要更多的计算资源和训练数据。

Q2: 如何评估大语言模型的性能?

A2: 评估大语言模型性能的方法包括:

- 标准NLP任务评测:如GLUE、SuperGLUE等基准测试。

- 特定任务评估:针对具体应用场景设计的评估指标。

- 人类评估:让人类评判者对模型输出进行评分。

- 多样性和创造性评估:评估模型生成内容的多样性和创造性。

- 鲁棒性测试:测试模型在噪声、对抗样本等情况下的表现。

- 伦理和偏见评估:检查模型输出是否存在偏见或不当内容。

Q3: 大语言模型的训练成本是否会成为发展的瓶颈?

A3: 大语言模型的训练成本确实是一个重要的考虑因素,但不一定会成为发展的绝对瓶颈。原因如下:

- 硬件进步:GPU和专用AI芯片的性能持续提升,同时价格逐渐降低。

- 分布式训练:通过分布式计算技术,可以更有效地利用计算资源。

- 模型优化:研究人员正在开发更高效的模型架构和训练方法。

- 迁移学习:预训练模型可以被多次复用,减少了重复训练的需求。

- 云计算:云服务提供商提供了更经济的训练资源选择。

尽管如此,为了降低成本和提高可持续性,业界正在探索更高效的模型设计和训练方法。

Q4: 大语言模型是否真的"理解"语言?

A4: 这是一个复杂的哲学和技术问题。大语言模型展现出了令人印象深刻的语言处理能力,但它们是否真正"理解"语言仍有争议:

- 统计模式:模型主要是学习统计模式,而非真正理解概念。

- 缺乏常识:模型在需要常识推理的任务上仍有不足。

- 可解释性:模型的决策过程难以解释,不像人类可以清晰地阐述推理过程。

- 鲁棒性:模型容易被对抗性输入欺骗,显示出理解的局限性。

- 语言基础性:语言学家和认知科学家对什么构成真正的语言理解仍有争议。

总的来说,虽然大语言模型在很多任务上表现出色,但它们的"理解"方式与人类有本质区别。

Q5: 如何处理大语言模型中的偏见问题?

A5: 处理大语言模型中的偏见是一个重要的研究方向,主要方法包括:

- 数据清洗:在预训练阶段使用更加平衡和多样化的数据集。

- 偏见检测:开发工具来检测模型输出中的偏见。

- 微调和后处理:通过特定任务的微调或输出后处理来减少偏见。

- 多样性提升:在训练过程中增加多样性目标。

- 伦理指导:在模型训练中加入伦理约束。

- 人机协作:结合人类监督来纠正模型的偏见输出。

- 模型透明度:提高模型的可解释性,以便更好地理解和处理偏见。

Q6: 大语言模型在小型设备上的应用前景如何?

A6: 虽然大语言模型通常需要强大的硬件支持,但在小型设备上的应用也在不断探索:

- 模型压缩:通过知识蒸馏、剪枝等技术减小模型大小。

- 量化:使用低精度表示减少模型存储和计算需求。

- 模型分割:将模型分割,部分在云端运行,部分在设备上运行。

- 专用硬件:开发针对AI任务优化的小型、高效硬件。

- 任务特定模型:为特定任务设计小型但高效的模型。

- 边缘计算:利用边缘设备的计算能力,减轻中心服务器负担。

随着技术的发展,我们可以期待在未来看到更多大语言模型在移动设备、物联网设备等小型平台上的应用。

Q7: 大语言模型对就业市场有什么影响?

A7: 大语言模型对就业市场的影响是复杂的:

- 自动化:某些涉及语言处理的工作可能被自动化,如部分客户服务、内容生成等。

- 新岗位创造:同时也创造了新的工作岗位,如AI训练师、提示工程师等。

- 效率提升:在许多领域,大语言模型可以作为辅助工具提高工作效率。

- 技能需求变化:对数据科学、机器学习等技能的需求增加。

- 创意行业影响:在写作、广告等创意领域,AI可能成为重要的辅助工具。

- 教育和培训:需要调整教育和培训体系以适应AI时代的需求。

总的来说,大语言模型可能会改变许多工作的性质,但也会创造新的机会。关键是要为这种变化做好准备,不断学习和适应新技术。

Q8: 大语言模型的未来发展方向是什么?

A8: 大语言模型的未来发展可能包括以下方向:

- 多模态融合:整合文本、图像、音频等多种模态的信息。

- 更强的推理能力:提高模型的逻辑推理和问题解决能力。

- 持续学习:开发能够不断更新知识的模型。

- 个性化:根据用户或领域需求定制的模型。

- 跨语言理解:更好的多语言和跨语言能力。

- 知识整合:更好地结合结构化知识和神经网络。

- 情感和社交智能:提高理解和生成带情感的语言的能力。

- 伦理和安全:更注重模型的公平性、安全性和可控性。

- 效率优化:开发更节能、更快速的模型架构。

- 与其他AI技术的结合:如强化学习、图神经网络等。

这些方向将推动大语言模型向更智能、更可靠、更有用的方向发展。

作者:禅与计算机程序设计艺术 / Zen and the Art of Computer Programming

大语言模型应用指南:什么是大语言模型

关键词:大语言模型、自然语言处理、深度学习、Transformer、预训练、微调、应用场景

1. 背景介绍

在人工智能和自然语言处理领域,大语言模型(Large Language Models,简称LLMs)已经成为了一个热门话题。这些模型在近年来取得了突破性的进展,不仅在学术界引起了广泛关注,也在工业界得到了广泛应用。大语言模型的出现标志着自然语言处理技术进入了一个新的阶段,为人机交互、信息检索、内容生成等领域带来了革命性的变化。

本文将全面介绍大语言模型的概念、原理、应用以及未来发展趋势,帮助读者深入理解这一前沿技术。

2. 核心概念与联系

大语言模型是一种基于深度学习的自然语言处理模型,它通过学习大量文本数据来理解和生成人类语言。这些模型通常具有数十亿甚至数千亿个参数,能够捕捉语言的复杂性和细微差别。

以下是大语言模型相关的核心概念及其联系:

大语言模型

Transformer架构

预训练

微调

自监督学习

注意力机制

编码器-解码器

掩码语言模型

下一句预测

迁移学习

特定任务适应

大规模语料库

无标注数据利用

3. 核心算法原理 & 具体操作步骤

3.1 算法原理概述

大语言模型的核心算法原理主要基于Transformer架构和自监督学习。Transformer架构通过注意力机制实现了对长序列依赖关系的有效建模,而自监督学习则允许模型从大量无标注数据中学习语言的本质特征。

3.2 算法步骤详解

- 数据预处理:收集和清洗大规模文本语料库。

- 分词:将文本切分为词或子词单元。

- 预训练:

a. 设计预训练任务(如掩码语言模型)

b. 使用Transformer架构构建模型

c. 在大规模语料上进行自监督学习 - 微调:针对特定任务对预训练模型进行适应性训练。

- 推理:使用训练好的模型进行文本生成或理解任务。

3.3 算法优缺点

优点:

- 强大的语言理解和生成能力

- 可迁移性强,适用于多种下游任务

- 能够捕捉长距离依赖关系

缺点:

- 计算资源需求大

- 训练和推理成本高

- 可能存在偏见和幻觉问题

3.4 算法应用领域

- 自然语言理解与生成

- 机器翻译

- 问答系统

- 文本摘要

- 对话系统

- 代码生成

4. 数学模型和公式 & 详细讲解 & 举例说明

4.1 数学模型构建

大语言模型的核心数学模型是基于Transformer架构的自注意力机制。自注意力机制允许模型在处理序列数据时,动态地关注输入的不同部分。

4.2 公式推导过程

自注意力机制的核心公式如下:

其中:

:查询矩阵

:键矩阵

:值矩阵

:键的维度

这个公式可以分解为以下步骤:

- 计算注意力分数:

- 缩放:

- 应用softmax:

- 加权求和:

4.3 案例分析与讲解

让我们以一个简单的句子 “The cat sits on the mat” 为例,说明自注意力机制的工作原理:

- 首先,我们将每个词转换为向量表示(嵌入)。

- 对于每个词,我们计算它与句子中所有其他词的注意力分数。

- 例如,对于 “sits”,我们可能会发现它与 “cat” 有较高的注意力分数,因为 “cat” 是动作的主语。

- 通过这种方式,模型可以捕捉到词与词之间的关系,从而理解句子的结构和含义。

在实际的大语言模型中,这个过程会在多个层和多个头上重复进行,以捕捉更复杂的语言特征。

5. 项目实践:代码实例和详细解释说明

5.1 开发环境搭建

要开始使用大语言模型,我们需要设置适当的开发环境。以下是使用Python和PyTorch库的基本设置:

5.2 源代码详细实现

以下是使用Hugging Face的Transformers库加载和使用预训练的GPT-2模型的示例代码:

5.3 代码解读与分析

- 首先,我们导入必要的类从Transformers库中。

- 我们加载预训练的GPT-2模型和相应的分词器。

- 准备输入文本并使用分词器将其转换为模型可以理解的格式。

- 使用模型的generate方法生成文本。我们设置了最大长度和其他参数来控制生成过程。

- 最后,我们将生成的token序列解码回人类可读的文本。

5.4 运行结果展示

运行上述代码可能会得到类似以下的输出:

这个例子展示了大语言模型如何基于给定的提示生成连贯和上下文相关的文本。

6. 实际应用场景

大语言模型在多个领域都有广泛的应用,包括但不限于:

- 内容创作:自动生成文章、故事、诗歌等。

- 对话系统:构建智能客服、虚拟助手等。

- 代码辅助:自动补全代码、生成注释、代码转换等。

- 语言翻译:提供更准确、更自然的多语言翻译。

- 文本摘要:自动生成长文档的摘要。

- 情感分析:分析文本中的情感倾向。

- 问答系统:构建能够回答复杂问题的系统。

6.4 未来应用展望

- 个性化教育:根据学生的学习风格和进度自动生成教材和练习。

- 医疗诊断辅助:分析病历和医学文献,辅助医生进行诊断。

- 法律文件分析:自动分析合同和法律文件,提取关键信息。

- 创意写作:辅助作家进行创意写作,提供灵感和建议。

- 多模态交互:结合图像、音频等多模态信息进行更自然的人机交互。

7. 工具和资源推荐

7.1 学习资源推荐

- 课程:

- Stanford CS224n: Natural Language Processing with Deep Learning

- Coursera: Deep Learning Specialization by Andrew Ng

- 书籍:

- “Speech and Language Processing” by Dan Jurafsky and James H. Martin

- “Natural Language Processing in Action” by Hobson Lane, Cole Howard, and Hannes Hapke

- 在线教程:

- Hugging Face’s Transformers Tutorials

- FastAI’s Practical Deep Learning for Coders

7.2 开发工具推荐

- 框架:

- PyTorch

- TensorFlow

- JAX

- 库:

- Hugging Face Transformers

- OpenAI GPT

- Google BERT

- 云平台:

- Google Colab

- Amazon SageMaker

- Microsoft Azure Machine Learning

7.3 相关论文推荐

- “Attention Is All You Need” by Vaswani et al. (2017)

- “BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding” by Devlin et al. (2018)

- “GPT-3: Language Models are Few-Shot Learners” by Brown et al. (2020)

- “T5: Exploring the Limits of Transfer Learning with a Unified Text-to-Text Transformer” by Raffel et al. (2019)

- “BART: Denoising Sequence-to-Sequence Pre-training for Natural Language Generation, Translation, and Comprehension” by Lewis et al. (2019)

8. 总结:未来发展趋势与挑战

8.1 研究成果总结

大语言模型在过去几年取得了巨大的进展,从BERT到GPT-3,再到更新的模型如GPT-4,它们不断刷新自然语言处理任务的性能记录。这些模型展示了强大的语言理解和生成能力,能够执行各种复杂的语言任务,甚至展现出了一定程度的推理能力。

8.2 未来发展趋势

- 模型规模继续增长:更大的模型可能会带来更好的性能和更广泛的能力。

- 多模态融合:结合文本、图像、音频等多种模态的信息。

- 少样本学习:提高模型在有限数据情况下的学习能力。

- 可解释性研究:深入理解模型的决策过程和内部表示。

- 高效训练和推理:开发更高效的训练和推理方法,降低计算成本。

- 领域特化:针对特定领域(如医疗、法律)开发专门的语言模型。

8.3 面临的挑战

- 计算资源需求:训练和运行大语言模型需要大量的计算资源。

- 数据隐私和安全:处理和使用大量文本数据涉及隐私和安全问题。

- 偏见和公平性:模型可能会继承训练数据中的偏见,导致不公平的结果。

- 幻觉问题:模型可能会生成看似合理但实际上不正确的信息。

- 长文本理解:虽有改进,但处理长文本仍然是一个挑战。

- 常识推理:提高模型的常识推理能力仍需更多研究。

- 伦理问题:大语言模型的广泛应用引发了一系列伦理问题,需要社会各界共同讨论和制定规范。

8.4 研究展望

- 神经符号融合:结合神经网络的学习能力和符号系统的推理能力。

- 持续学习:开发能够不断学习和更新知识的模型。

- 跨语言理解:提高模型在多语言环境下的表现。

- 认知科学结合:借鉴人类认知过程,改进模型架构和学习方法。

- 绿色AI:开发更环保、能耗更低的模型训练和部署方法。

- 个性化模型:根据用户需求和特征定制化语言模型。

- 人机协作:探索人类与大语言模型协作的新模式,提高整体效率和创造力。

9. 附录:常见问题与解答

Q1: 大语言模型和传统的自然语言处理方法有什么区别?

A1: 大语言模型采用深度学习和自监督学习方法,能够从大规模无标注数据中学习,而传统方法通常依赖于人工设计的特征和规则。大语言模型具有更强的泛化能力和更广泛的应用范围。

Q2: 如何评估大语言模型的性能?

A2: 评估方法包括使用标准的NLP任务benchmark(如GLUE、SuperGLUE),人工评估生成文本的质量,以及针对特定应用场景的自定义评估指标。

1014

1014

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?