1、连接Hadoop集群与MySQL

1-1 下载当前集群的Hbase配置文件

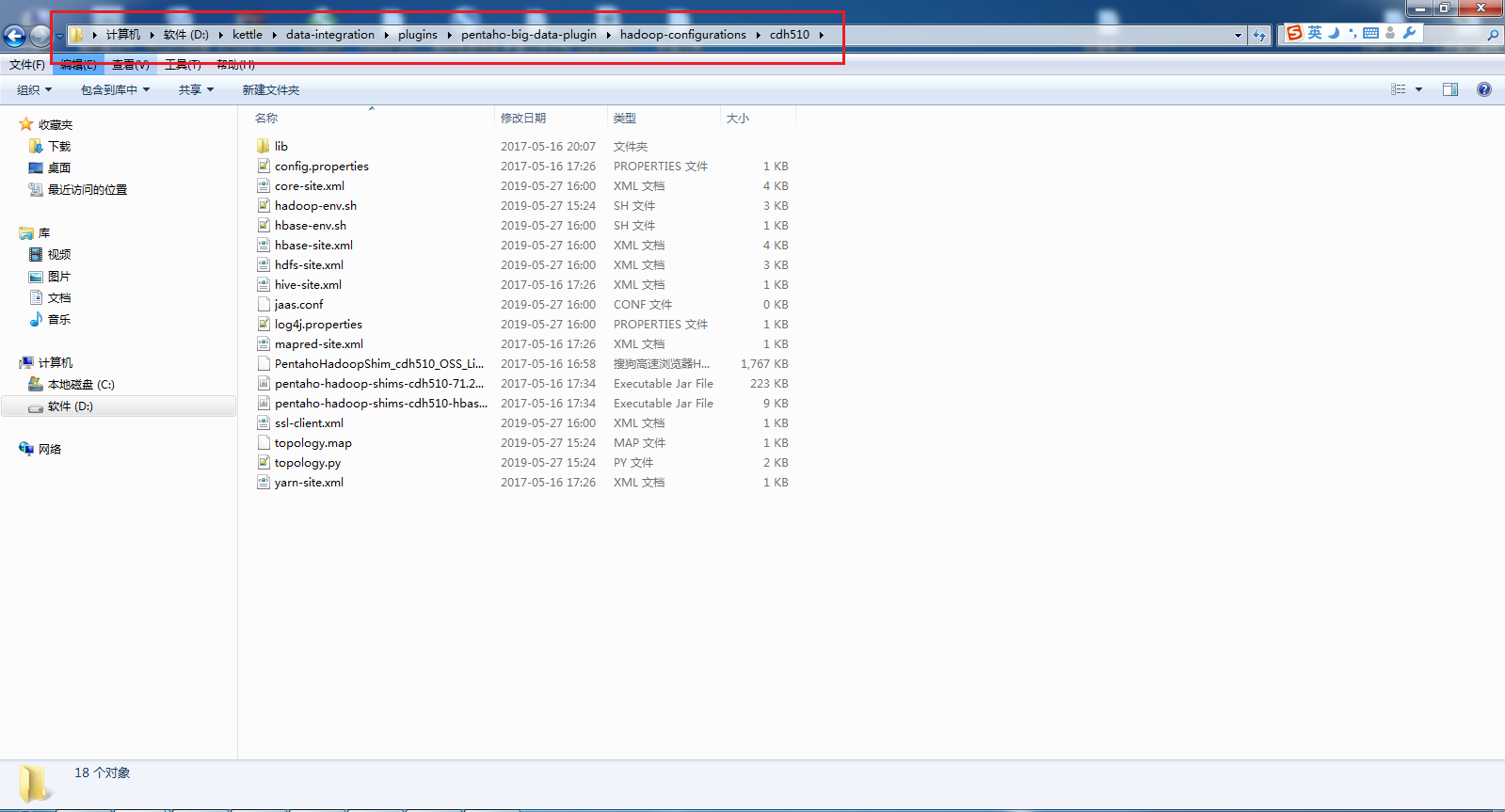

1-2 解压改配置文件至cdh510目录下

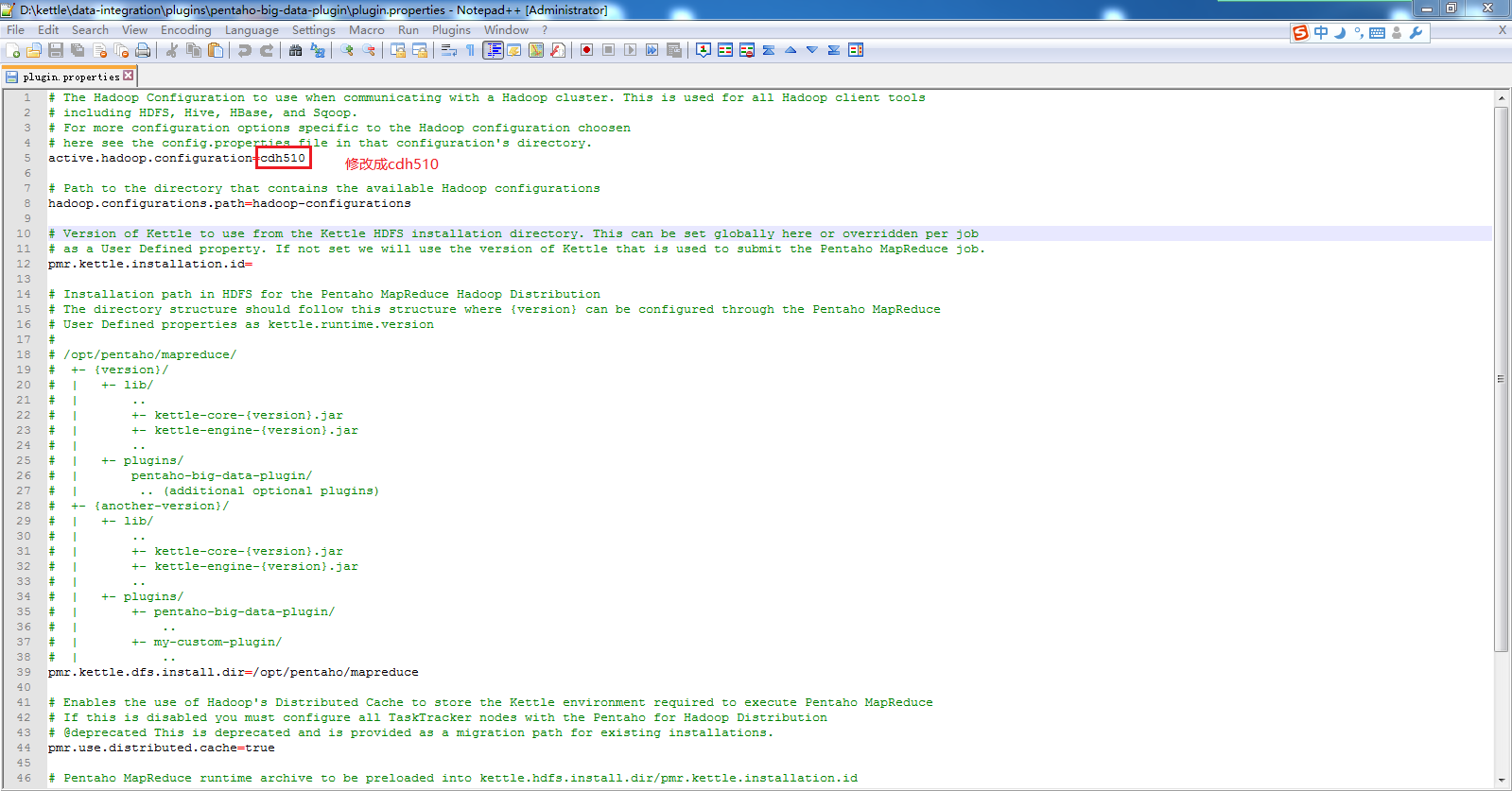

1-3 修改D:\kettle\data-integration\plugins\pentaho-big-data-plugin下plugin.properties配置

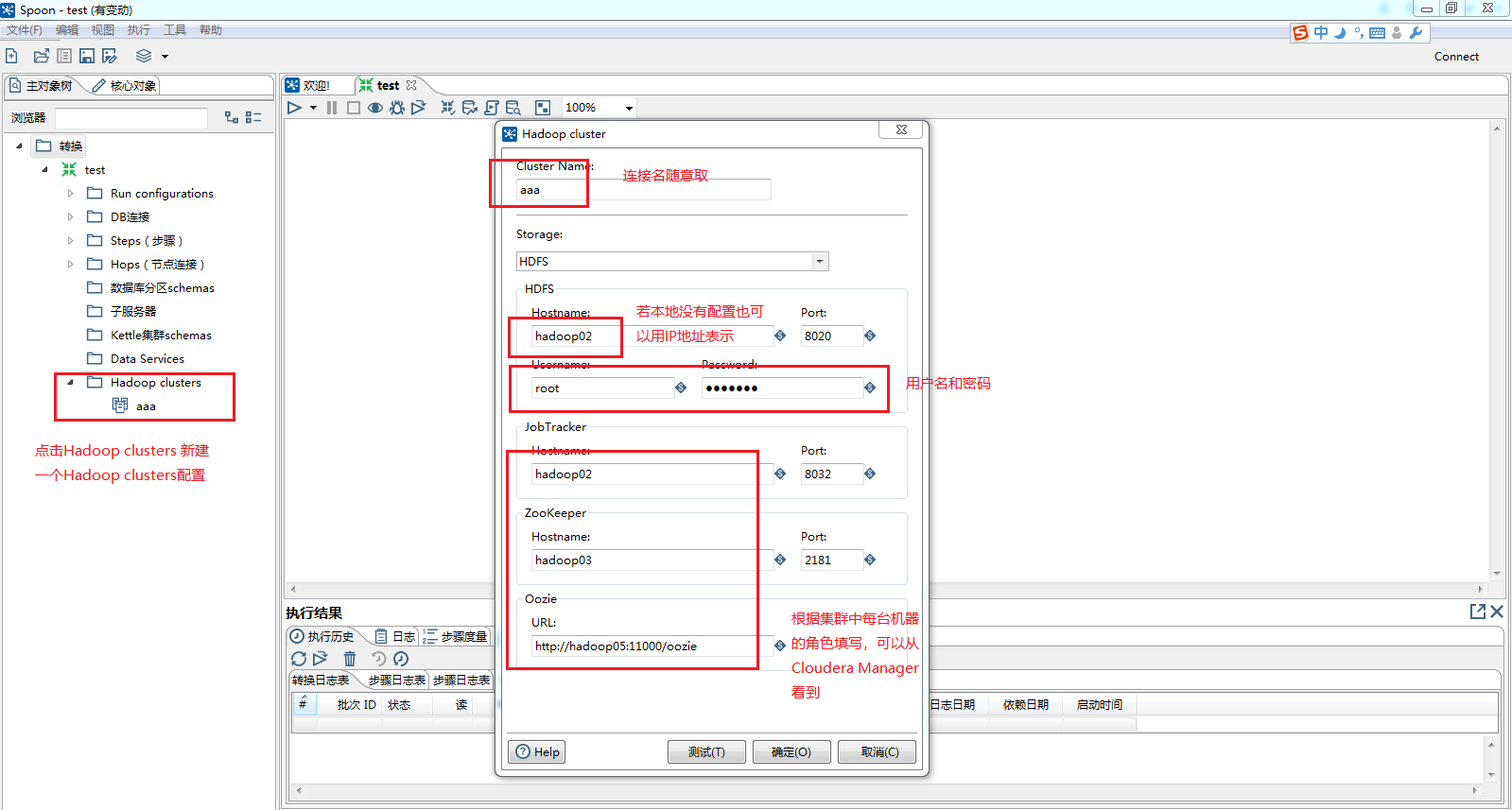

1-4 在Kettle中配置Hadoop集群

在测试连接后会发现User Home Directory Access 和 Root Directory Access 是报错的,这个可能是因为我们是在非集群的一台主机上操作Hadoop数据,会导致没有权限向Hbase内写入数据,没有尝试出一个确切的解决方案,但是不影响读取Hbase数据,所以这里暂时不管它。(有知道解决办法的大佬的话,求指导~~)

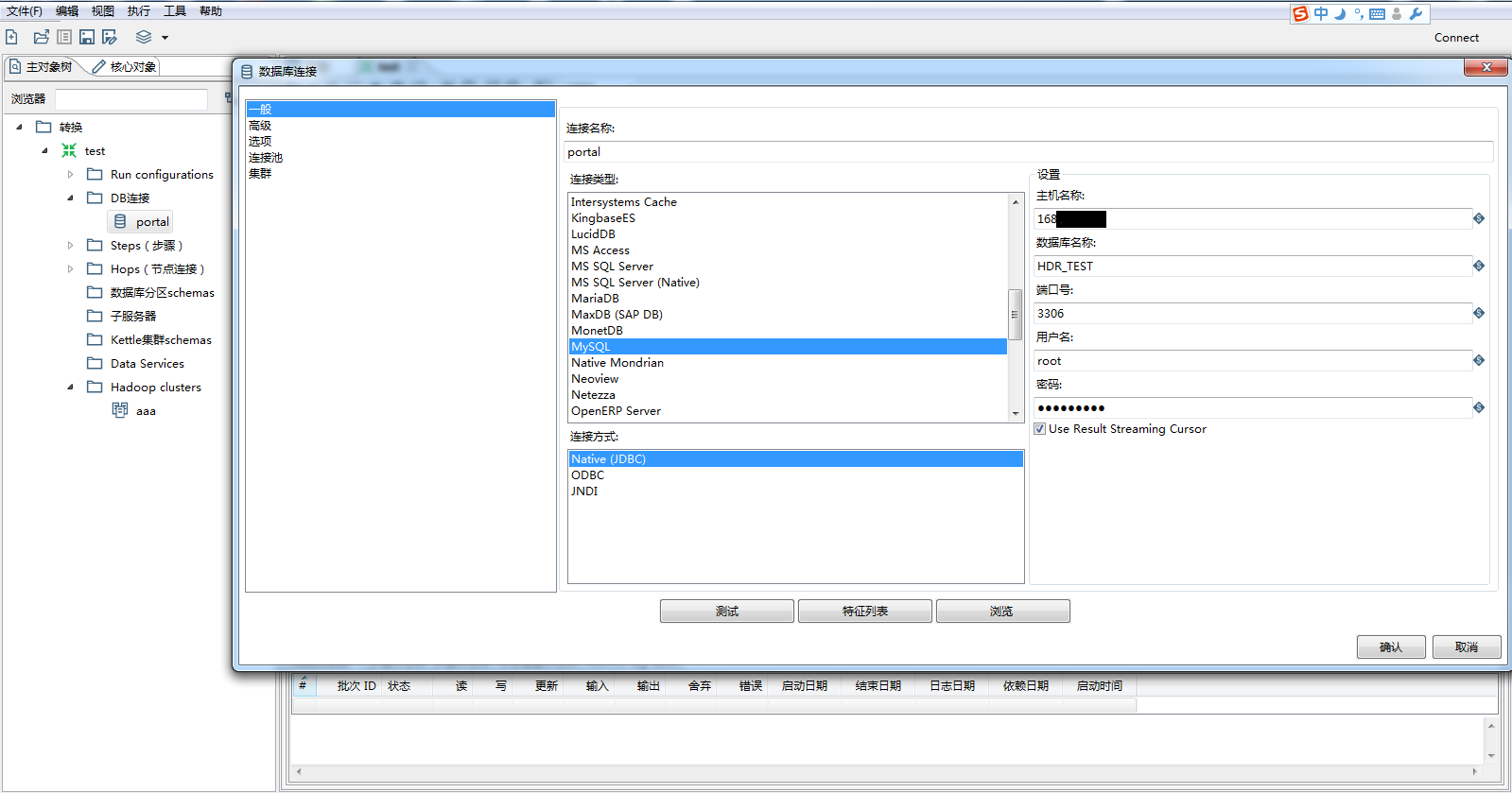

1-5 连接Mysql数据库

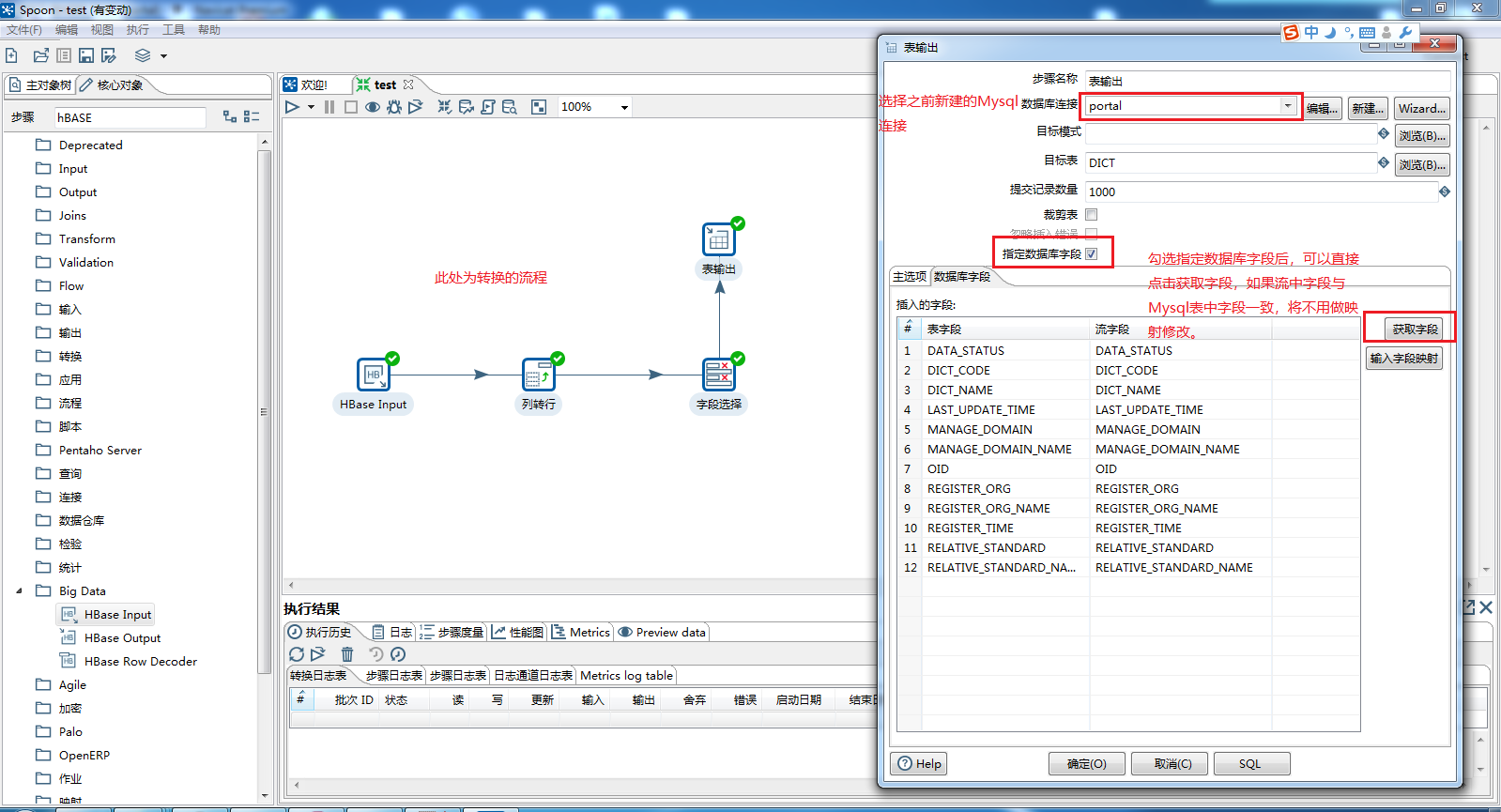

2、Kettle流程

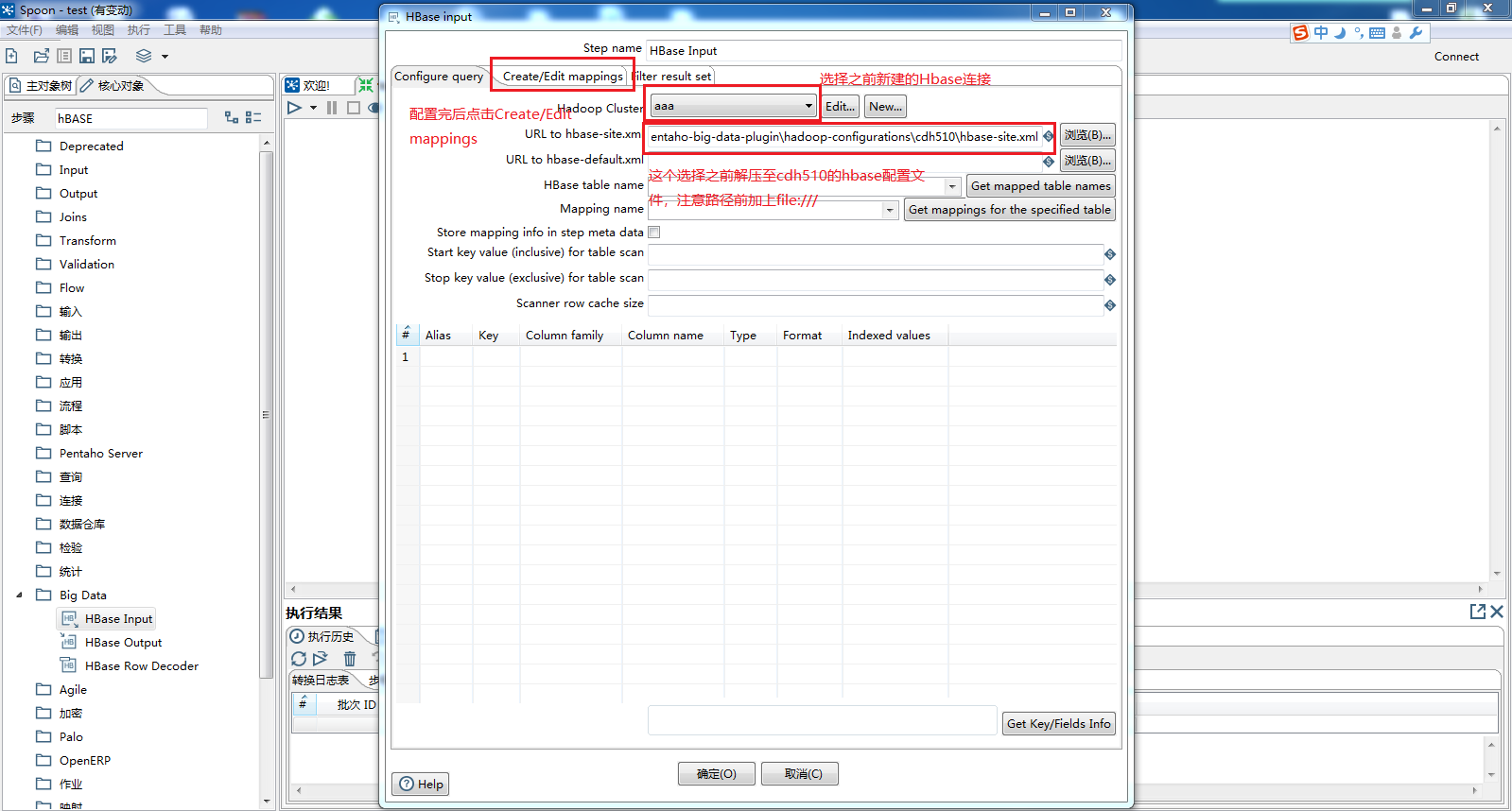

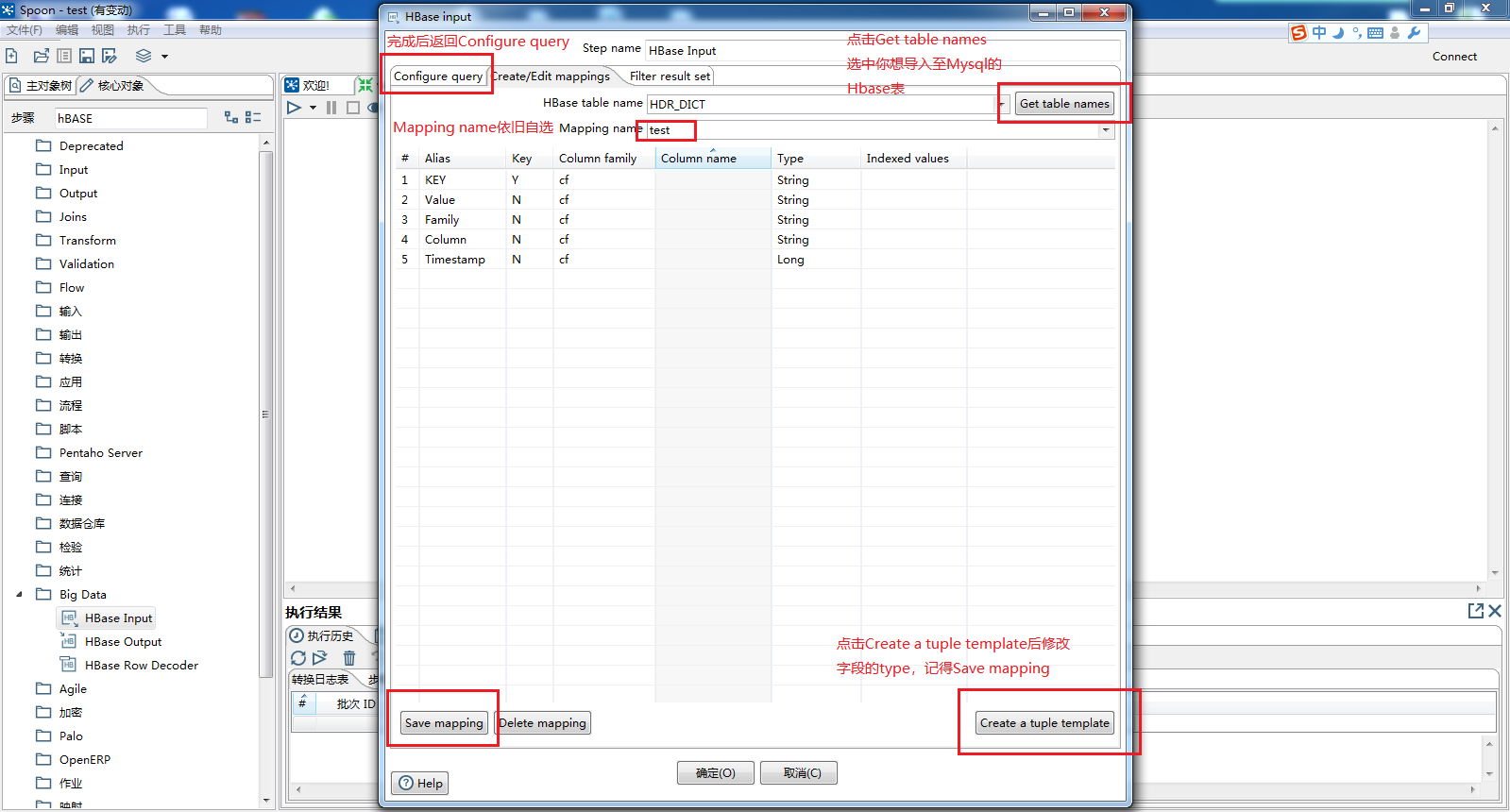

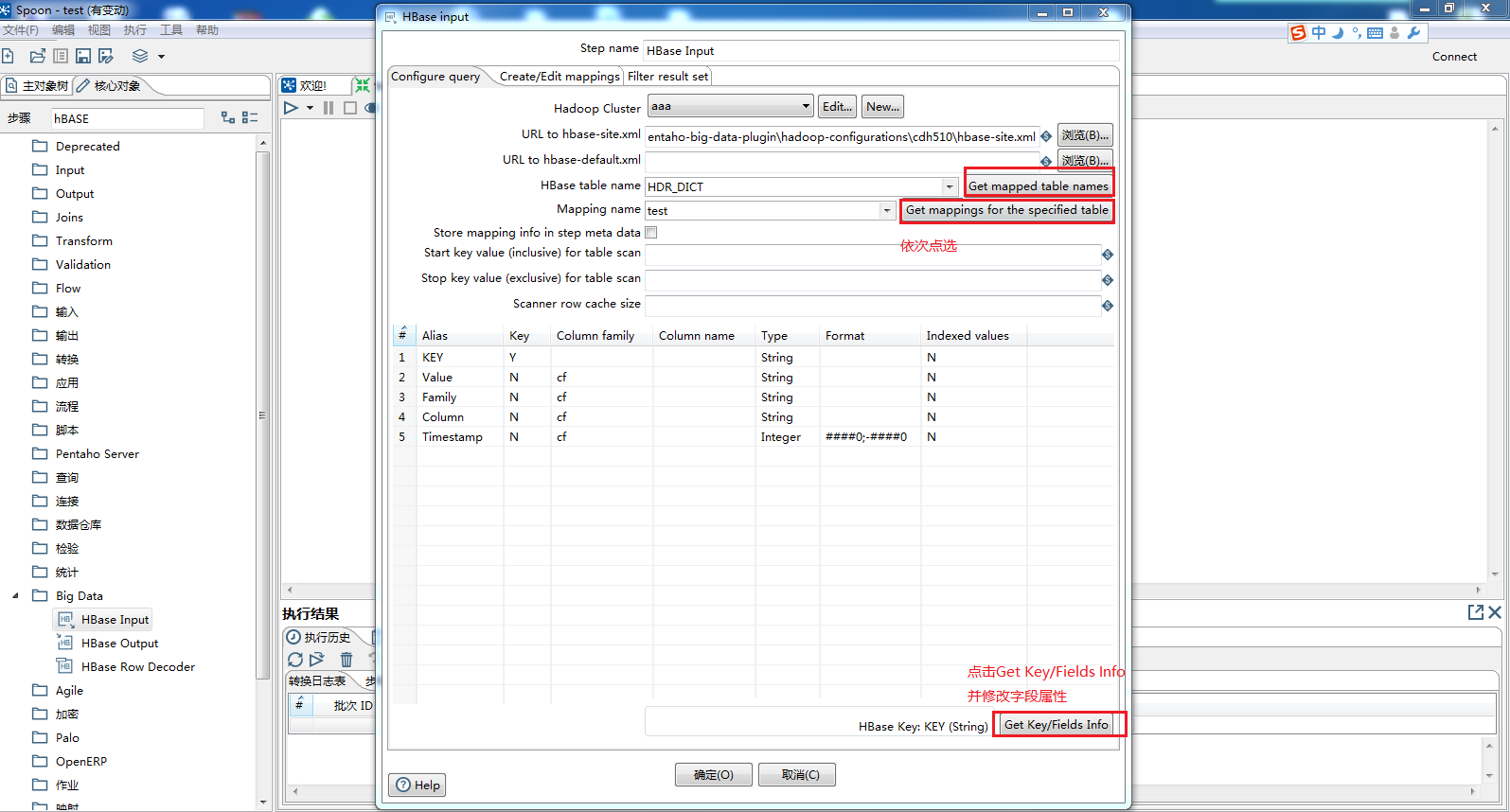

2-1 Hbase数据读取

2-2 行列变换

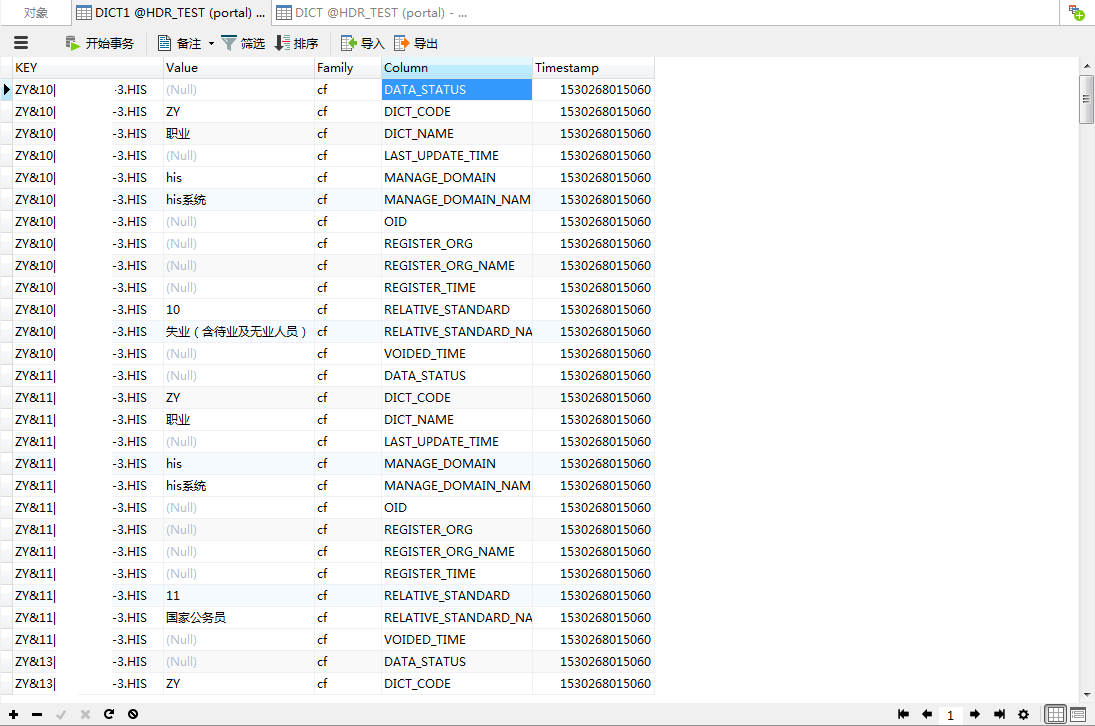

由于Hbase不是关系型数据库,所以我们要将其字段进行行列变换,否则导出数据会如下图所示

选中核心对象——转换——列转行

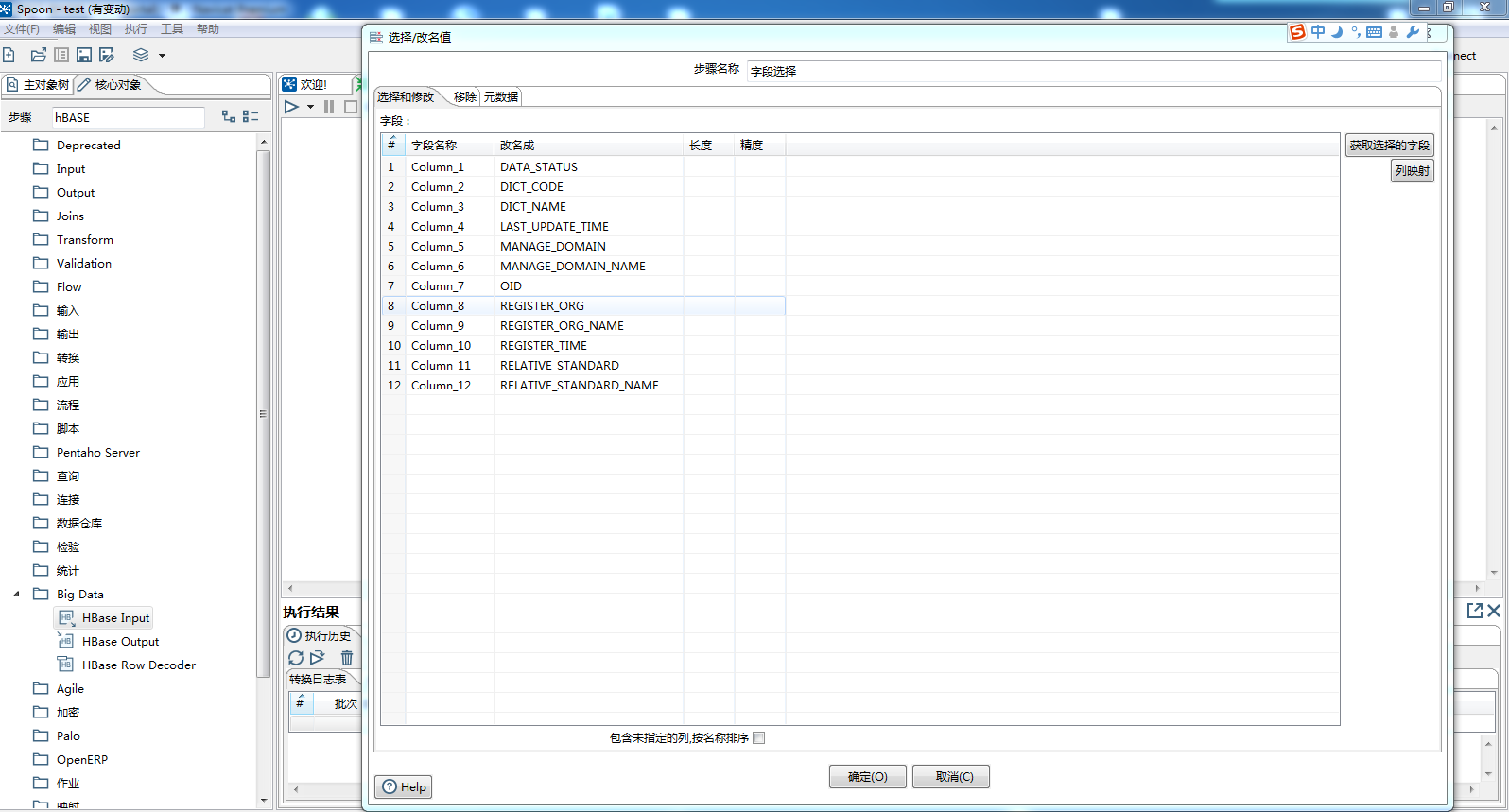

然后对流中字段进行改名,改成与转出Mysql表对应的字段,PS:此处字段对应要准确

2-3 表输出

将数据输出到目标Mysql表内

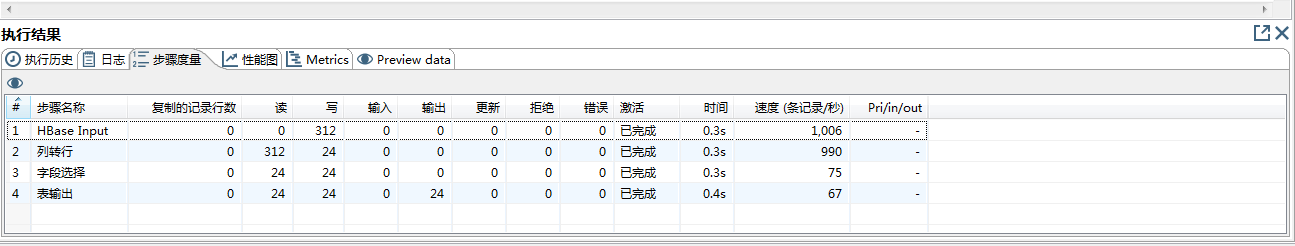

2-4 运行结果

PS:摸索学习中,欢迎相互讨论和指导~

本文记录了如何使用Kettle工具将Hbase数据导入到MySQL的过程,包括连接Hadoop集群与MySQL,处理Hbase数据的行列变换以适应MySQL的结构,以及最终的数据输出。虽然在连接Hadoop集群时遇到权限问题,但不影响数据读取,可以继续进行数据迁移。

本文记录了如何使用Kettle工具将Hbase数据导入到MySQL的过程,包括连接Hadoop集群与MySQL,处理Hbase数据的行列变换以适应MySQL的结构,以及最终的数据输出。虽然在连接Hadoop集群时遇到权限问题,但不影响数据读取,可以继续进行数据迁移。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?