Transformer工业部署落地!超越ResNet、CSWin

论文地址:https://arxiv.org/pdf/2207.05501.pdf

一种用于在现实工业场景中高效部署的下一代 Vision Transformer。它通过引入 Next Convolution Block (NCB) 和 Next Transformer Block (NTB),在局部和全局信息捕获方面取得了显著的性能改进。

NCB 和 NTB 分别使用新颖的部署友好的多头卷积注意力 (MHCA) 和轻量级的高低频信号混合器来增强建模能力。为了进一步提高性能,设计了 Next Hybrid Strategy (NHS),通过在每个阶段以新的混合范式堆叠 NCB 和 NTB,大大降低了 Transformer 块的比例,并在各种下游任务中最大程度地保留了 Vision Transformer 网络的高精度。

与现有的基于 CNN 和 ViT 的方法相比,Next-ViT 在延迟/准确性权衡方面表现出优越的性能。实验结果表明,Next-ViT 在各种下游任务中取得了最先进的结果,包括图像分类、目标检测和语义分割。因此,Next-ViT 是一个强大的模型,可以有效地应用于现实工业场景中的各种计算机视觉任务。

由于传统的卷积神经网络(CNN)和Vision Transformer(ViT)在现实的工业场景中存在一些局限性,因此该论文提出了Next-ViT模型。具体来说,传统的CNN在处理长序列时缺乏全局性,而ViT虽然具有全局性,但它们的注意力机制复杂,导致计算量大且效率低下。为了克服这些缺点,Next-ViT引入了Next Convolution Block(NCB)和Next Transformer Block(NTB),并设计了Next Hybrid Strategy(NHS)来提高模型的性能。

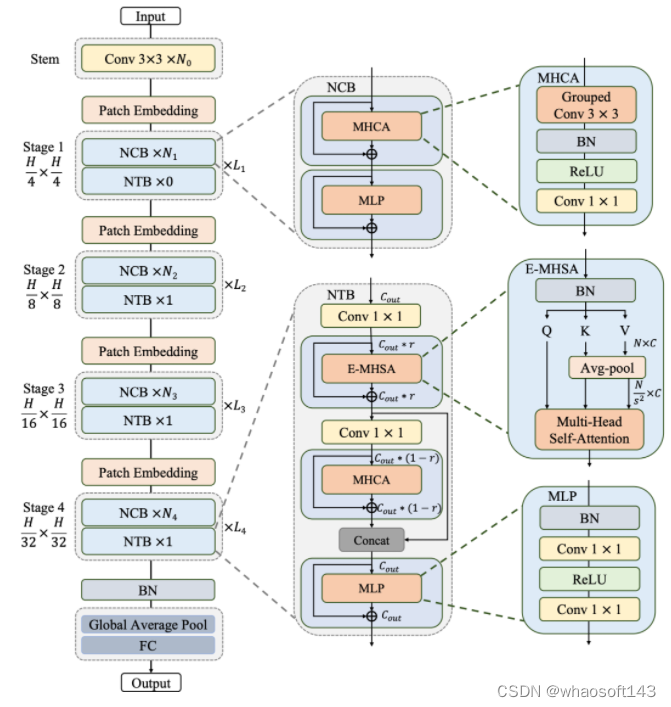

Next-ViT遵循分层的金字塔体系结构,在每个阶段都有一个patch embedding层和一系列的卷积或Transformer blocks。该模型使用MHCA(多头卷积注意力)来增强建模能力,通过创新的CNN和Transformer架构方式实现高性能和高效率相结合。Next-ViT在各种计算机视觉任务中取得了最先进的结果,包括图像分类、目标检测和语义分割。因此,Next-ViT是一个强大的模型,可以有效地应用于现实工业场景中的各种计算机视觉任务。

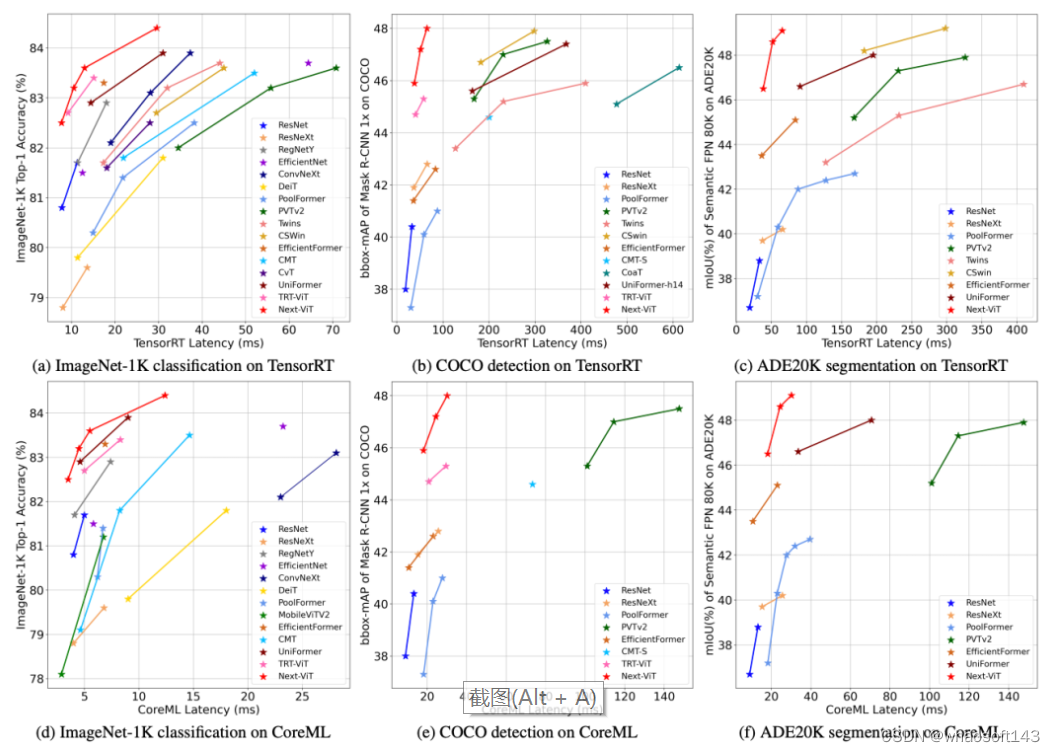

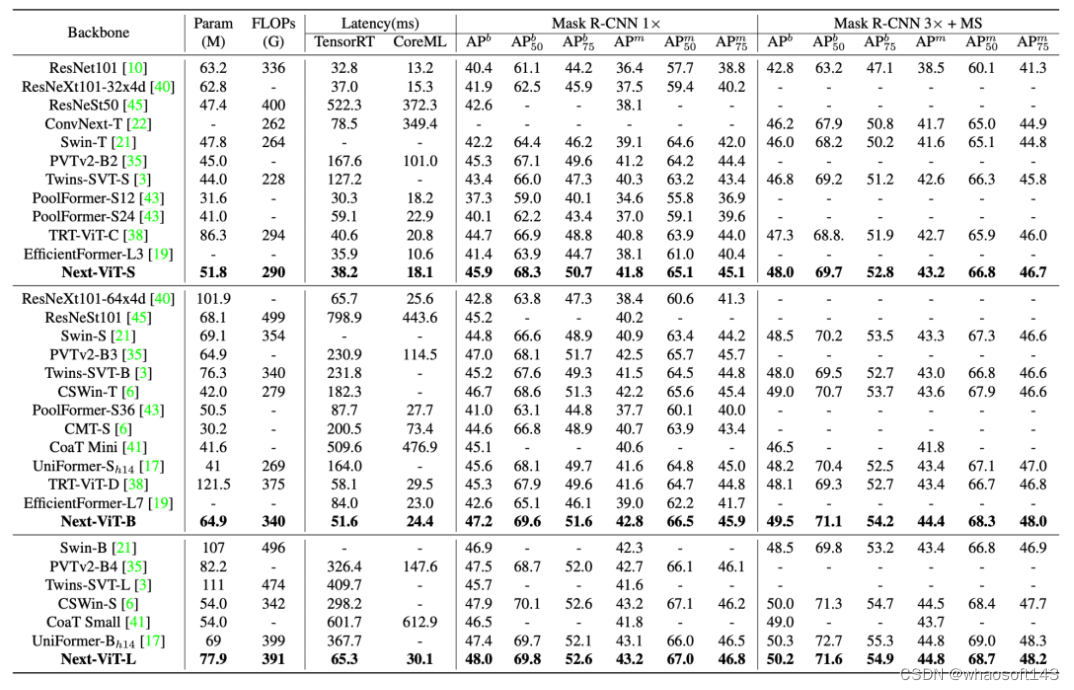

Next-ViT和高效网络在精度-延迟权衡方面的比较

按照惯例,Next-ViT遵循分层的金字塔体系结构,在每个阶段都有一个patch embedding层和一系列的卷积或Transformer blocks。空间分辨率将逐步降低32×,而通道尺寸将在不同的阶段中扩大。

Next Convolution Block (NCB)

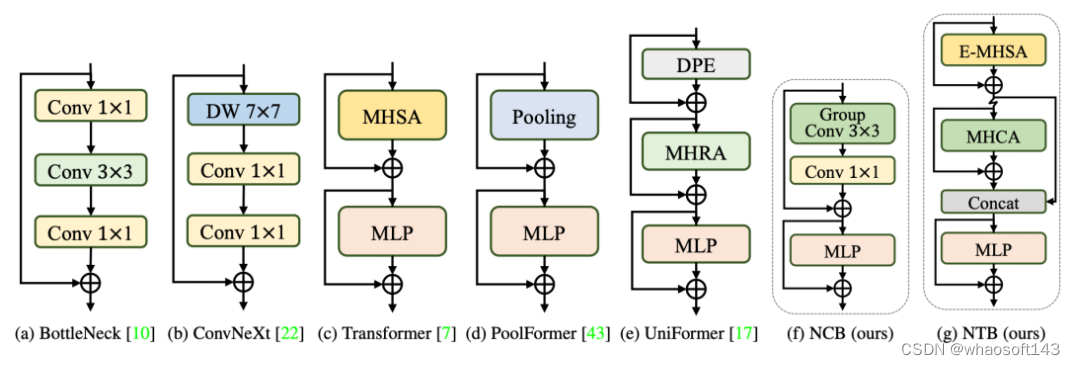

为了展示所提出的NCB的优越性,首先重新审视卷积和Transformer blocks的一些经典结构设计,下图所示。ResNet提出的BottleNeck块因其固有的归纳偏差和部署而在视觉神经网络中长期占据主导地位。大多数硬件平台的友好特性。

Next Transformer Block (NTB)

虽然通过NCB已经有效地学习了局部表示,但全局信息的捕获迫切需要解决。Transformer Block具有较强的捕获低频信号的能力,从而提供全局信息(例如全局形状和结构)。然而,相关研究观察到,Transformer Block可能会在一定程度上恶化高频信息,如局部纹理信息。不同频率段的信号在人类视觉系统中是不可缺少的,并将以某种特定的方式融合,提取更基本和明显的特征。

实验及结果

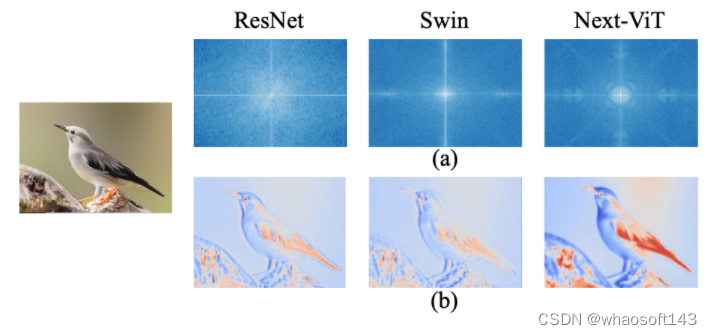

(a) Fourier spectrum of ResNet, Swin and Next-ViT. (b) Heat maps of the output feature from ResNet, Swin and Next-ViT.

1345

1345

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?