前言

数学的学习跟数学的计算是要分开的,现在回头再去看大学的高数和线性代数,如果只是学习的话,其实一门课程3天,也就学完了。

学校的课程之所以上那么久,其实是为了考试,也就是为计算准备的。计算是有意义的,但在有计算机的情况下,计算的意义并不是很大。

所以,如果大学数学没学好,只要花一星期,就能补回来。甚至你没上过大学,只要你上过初中,同样,只需要一个星期就能学会高数和线性代数。

但,但,但,问题是,没有人这样给你上课,也没有这样资料让你学习。至少国内是没有这样学习的信息,国内全是耽误我们学习效率的学习模式。

明明是一个星期的知识,非得浪费我们一年到一年半。而且大学数学学习的计算,也没有法应对考研的题,你想考研还是得报班或者自己再继续学习解题技巧。

总之,大学数学是个即浪费学习时间,又完全没有目的性的扯淡课程。

Gradient

上一篇介绍了一点梯度,正向传播,逆向传播。这里再详细介绍一下。

不要被这些名词吓住了,名词的本质都是总结,而总结的名词,其实是最阻碍我们学习的,我们要讨厌它,但不用害怕它。

先看一下requires_grad这个参数的使用,代码如下:

print("============求梯度1==============")

a = torch.randn(3) #这里是randn 不是rand torch.randn:生成服从标准正态分布(均值为0,标准差为1)的随机数。 torch.rand:生成服从均匀分布(在区间 [0, 1) 之间)的随机数。

print(a)

b=a+2

print(b) # 输出tensor是a+2计算后的结果

x = torch.randn(3,requires_grad=True) #这里是randn 不是rand

print(x)

y=x+2

print(y) # 输出tensor是x+2计算后的结果,同时记录了函数,grad_fn=<AddBackward0> 表示是加法函数 grad=gradient fn=Function

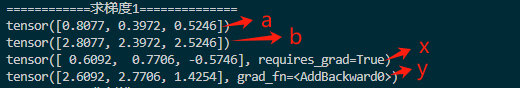

这里a和x分别是开启了requires_grad和没有开始requires_grad的模式。如下图:

开启了requires_grad的x,多了一个属性requires_grad=True。

经过y=x+2计算的y,多了一个属性grad_fn=< AddBackward0 >,这里grad=gradient fn=Function,就是梯度函数的意思;里面的Add是加法的意思。

而这个y=x+2,这个计算就是前向传播,前向传播就是这一堆我们定义的函数。

正态分布简介

上面提到了正态分布,这里简单解释一下。

正态分布 若以0为中心,称为均值为0。若均值为0,标准差为1,数据点在不同区间内的分布遵循68-95-99.7规则

均值0,标准差1(数据在68%[-1, 1]95%[-2, 2]99.7%[-3, 3])。即数据以0为中心,向两边扩散,68%的数据点位于均值的1个标准差范围内(即[-1, 1]区间)95%的数据点位于均值的2个标准差范围内(即[-2, 2]区间)。99.7%的数据点位于均值的3个标准差范围内(即[-3, 3]区间)。

均值0,标准差2,数据在68%[-2, 2]95%[-4, 4]99.7%[-6, 6])。

标量函数和逆向传播

上面我们使用了前向传播,并设置y=x+2这样的函数,现在我们在增加一个前向传播函数:z=y * y * 2,然后再设置标量函数,最后在执行逆向传播。

注1:在使用backward前,必须给一个scale value(标量值,即常数C) 比如z=z.mean(),或者给一个权度tensor,这里先介绍传递标量函数。

注2:标量函数就是前向传播中的计算损失的损失函数。

注3:标量函数其实是一个标量,或称常量,或称常数,或称值,或者称一个数。(这里要是说传递的是一个数,那就low了,但要说传了一个标量,就明显较高大上了,这就是名词阻碍我们学习的最完美体现了)。

x = torch.randn(3,requires_grad=True)

print(x)

y=x+2

z=y*y*2

print(z) # 这里会增加属性,grad_fn=<MulBackward0> ,这里的mul表示是乘法

z=z.mean() # 指定标量函数

#这里必须指定标量函数,如果删除z=z.mean() 这句话会提示 grad can be implicitly created only for scalar outputs

print(z) # 属性grad_fn=<MeanBackward0>,Mean表示平均值函数

z.backward() #逆向传播 如果requires_grad=False,则执行z.backward()回抛异常,因为没有记录grad_fn

print(x.grad)

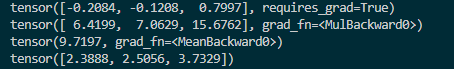

运行如下图:

代码简介如下

x 是启用了自动求导的张量。

y = x + 2,y 仍是一个启用了自动求导的张量。

z = y * y * 2,z 是一个启用了自动求导的张量。

z = z.mean(),z 是标量(因为 mean() 返回的是张量的平均值,结果是标量)。

调用 z.backward(),计算 z 对 x 的梯度,并将其存储在 x.grad 中。

此时,x.grad 中存储的是 z 对 x 的梯度,即 dz/dx;梯度的结构是跟x的结构一样的。

梯度清0

在第二次计算梯度(调用backward())之前需要清零梯度。

如果在第二次调用 backward() 之前没有清零梯度,那么第二次调用 backward() 计算出的梯度会叠加在第一次计算出的梯度上。

print("============清零grad==============")

weights =torch.ones(4,requires_grad=True)

for epoch in range(3):

model_output =(weights*3).sum()#设置标量值,这里是连写了,分开就是a=weight*3 model_output=a.sum()

model_output.backward()

print(weights.grad)

model_output.zero_()#可以注释这一行,看看不清零的效果

加权

在计算梯度(调用backward())之前没有设置标量或权度,就会报错。

上面说过了标量,现在来介绍加权。

代码如下:

x = torch.randn(3,requires_grad=True)

print(x)

y=x+2

z=y*y*2

v = torch.tensor([1.0,2.0,3.0],dtype=torch.float32)

z.backward(v)

print(x.grad)

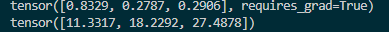

这里在z.backward(v)调用前,增加了一个创建权度tensor[v]的操作,这个tensor的结构要求和x是一样的,然后再把v做为参数给z.backward()。

像上面那样调用, backward() 时,没有传递参数,则默认会传递一个标量 1。

即:在使用backward时,要么指定一个标量(使用标量函数)要么指定一个权度tensor,如果不满足这两种情况,就会报错。

标量与加权的区别是,标量会乘到张量的每个元素里,而加权是把指定加权的tensor的元素乘到张量的对应行号和列号的元素里。

计算逻辑

在计算梯度时,会把梯度的计算结果,x,权度tensor,全提出来,然后相乘。

因为梯度,x,权度tensor的结构是相同的,而计算方式就是对应元素相乘,这个又叫做链式法则(就是对应项乘以对应项)。

具体计算

y=x+2,dy/dx=y导=1

z=2y²,dz/dy=z导=4y

dz/dx=(dz/dy) * (dy/dx)=1 * 4y=4y

因为y=x+2所以4y=4(x+2)

加权后是三个元素分别是 1 * 4(x1+2) 2 * 4(x2+2) 3 * 4(x3+2)

带入x即可得到梯度。

如下图,4 * (0.8329+2)=11.3316,下图是11.3317,这里应该是有个进位。

结语

上文介绍了通过求导,得出x和z的关系,然后利用这个关系(损失函数),求出了梯度。

这个梯度是我们后面优化模型参数使用的,但为什么要用这种模式呢,当初想出这个方法的人是如何思考的呢?

很显然,这是搜索不到答案的,绝大多数的开发人员和研究生导师,他们自己都不知道,所以不论是我们搜到的视频还是上的课,都不能解答,

当然,不了解这些,也不影响我们开发。

但这个小细节,就说明为什么咱们国家的数学比不上外国的核心原因,因为我们学的都是计算,而为什么这么计算,没人教,因为老师也不会。

传送门:

零基础学习人工智能—Python—Pytorch学习(一)

零基础学习人工智能—Python—Pytorch学习(二)

零基础学习人工智能—Python—Pytorch学习(三)

零基础学习人工智能—Python—Pytorch学习(四)

零基础学习人工智能—Python—Pytorch学习(五)

零基础学习人工智能—Python—Pytorch学习(六)

零基础学习人工智能—Python—Pytorch学习(七)

基础学习就先到这。

注:此文章为原创,任何形式的转载都请联系作者获得授权并注明出处!

若您觉得这篇文章还不错,请点击下方的【推荐】,非常感谢!

原创作者: kiba 转载于: https://www.cnblogs.com/kiba/p/18348414

453

453

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?