参考文章:Bag of Tricks for Image Classification with Convolutional Neural Networks

论文地址:http://openaccess.thecvf.com/content_CVPR_2019/papers/He_Bag_of_Tricks_for_Image_Classification_with_Convolutional_Neural_Networks_CVPR_2019_paper.pdf

有效trick:

1、在新的硬件上有效训练

2、在ResNet-50的基础上,对模型进行了一些微量的调整

3、训练的一些技巧

1、在新的硬件上有效训练:

在ResNet刚提出的时候,为了考虑当时的硬件条件,不得不做很多跟performance相关的trade-offs。但是随着这几年硬件(尤其是GPU)的快速发展,很多与performance相关的trade-offs已经改变。其中包括:

使用更大的batch size。例如从256到1024;

使用较低的数值精度。例如从FP32到FP16

使用更大的batch size会导致减缓训练进度。对于凸问题,收敛速度会随着batch size的增加而降低。也就是说,在相同的epoch下,使用更大的batch size可能会导致验证集accuracy更低。因此使用一些trick来解决这个问题。

Linear scaling learning rate:例如,当我们选择初始学习率为0.1,batch size为256时,那么当我们将batch size增大至b时,就需要将初始学习率增加至0.1×b/256

Learning rate warmup:例如,选择5个epoch去进行warmup,在这5个epoch中线性地从0开始增加学习率至初始学习率,然后再开始正常decay

Zero gamma :在residual block中的batch normalization(BN)中:BN首先标准化输入x,得到x’,然后进行线性变化gamma*x‘+beta,其中 和 都是可以学习的参数,其值被初始化为1s和0s。而在这里初始化

No bias decay:为了避免过拟合,对于权重weight和偏差bias,我们通常会使用weight decay。但在这里,仅对weight使用decay,而不对bias使用decay。

使用更低的数值精度 以前神经网络通常使用32-bit浮点数精度(FP32)来训练。但是现在的新的硬件增强了低精度数据类型的算术逻辑单元。例如Nvidia V100对FP32提供14 TFLOPS,而对FP16提供100 TFLOPS。因此,使用FP16时,总的训练速度加速了2~3倍

2、模型调整

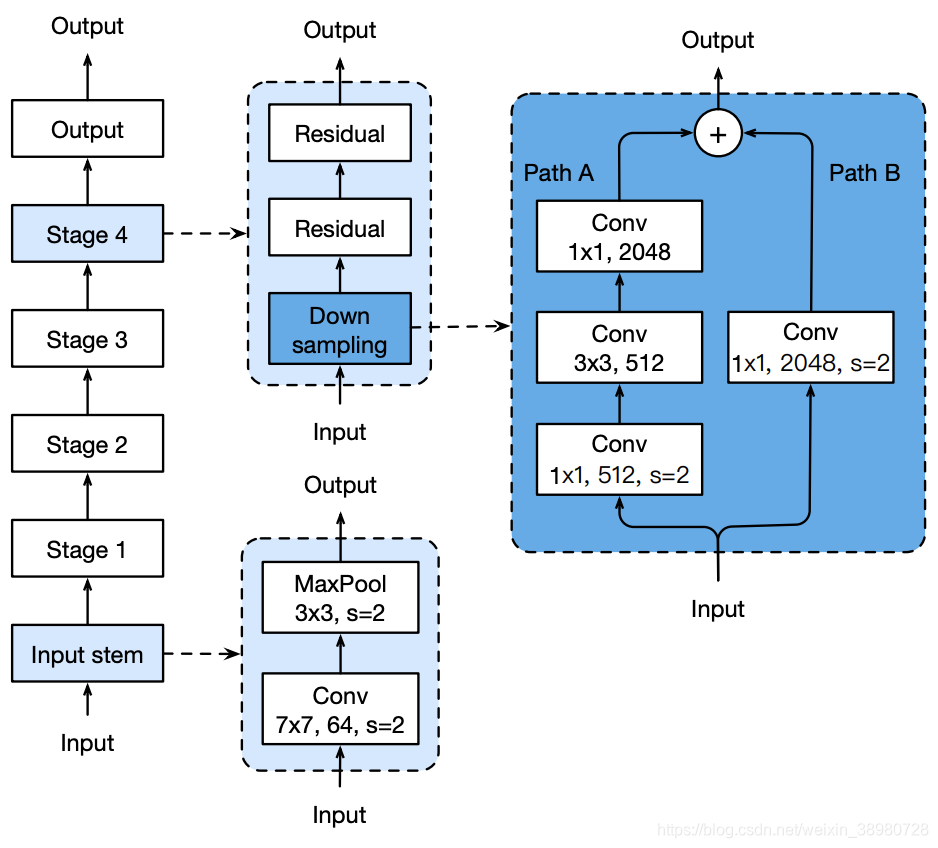

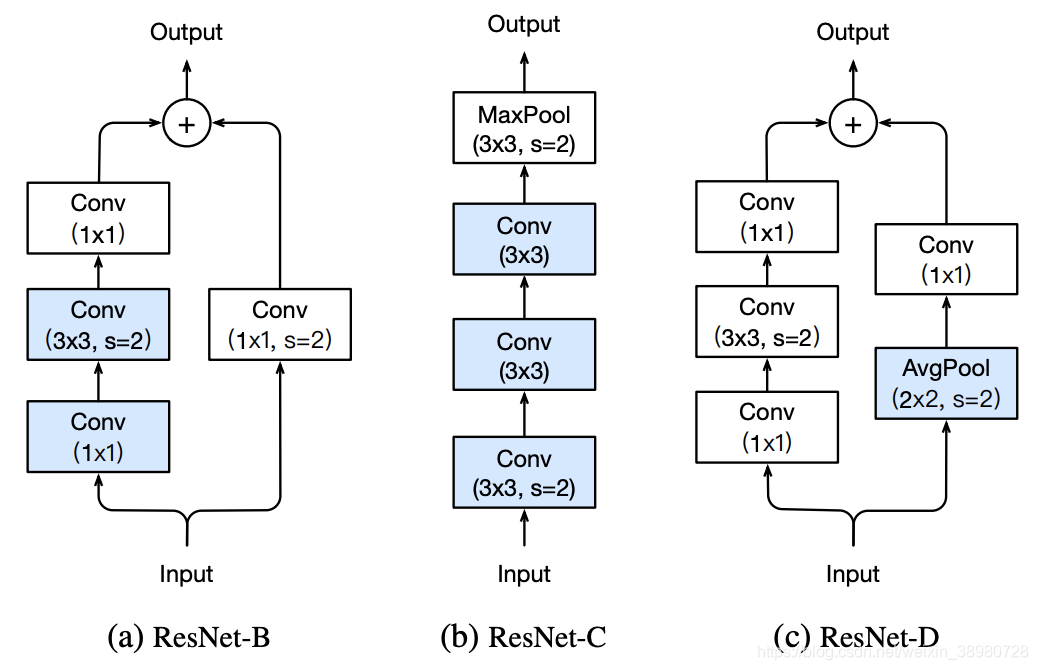

主要对downsampling block和input steam(上图指出部分)做了一些改动:downsampling做改动主要是由于使用stride=2的1×1 conv会忽略3/4的feature-map。因此,为了使输出的shape保持不变,将path A的前两个conv分别改为stride=1的1×1 conv和stride=2的3×3 conv,即ResNet-B;将path B换成stride=2的2×2 AvgPool和stride=1的1×1 conv,即ResNet-D

而input steam做的改动主要是由于使用7×7 conv的计算cost是3×3的5.4倍。因此将7×7 conv换成3个连续的3×3conv,即ResNet-C

3、训练技巧

Cosine Learning Rate Decay

以往学习率衰减的策略一般是"step decay",即每隔一定的epoch,学习率才进行一次指数衰减。而现在,学习率随着epoch的增大不断衰减:

Label Smoothing

Knowledge Distillation

Mixup Training

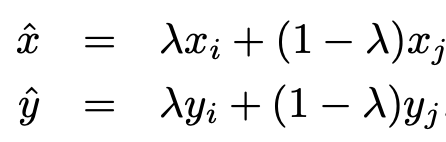

在mixup中,每次随机采样两个样本 [公式] 和 [公式] ,然后通过加权线性插值生成新的样本进行训练:

4632

4632

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?