整体 反弹无力 下周找个 时间会清仓 还是医药和消费涨的好

1.1 sklearn中的决策树

模块sklearn.tree

sklearn中决策树的类都在”tree“这个模块之下。这个模块总共包含五个类:

tree.DecisionTreeClassifier | 分类树 |

tree.DecisionTreeRegressor | 回归树 |

tree.export_graphviz | 将生成的决策树导出为DOT格式,画图专用 |

tree.ExtraTreeClassifier | 高随机版本的分类树 |

tree.ExtraTreeRegressor | 高随机版本的回归树 |

sklearn的基本建模流程

在那之前,我们先来了解一下sklearn建模的基本流程。

from sklearn import treeclf = tree.DecisionTreeClassifier()clf = clf.fit(X_train,y_train) result = clf.score(X_test,y_test)result = clf.score(X_test,y_test)2 DecisionTreeClassifier与红酒数据集

class(criterion=’gini’, splitter=’best’, max_depth=None,min_samples_split=2, min_samples_leaf=1, min_weight_fraction_leaf=0.0, max_features=None, random_state=None, max_leaf_nodes=None, min_impurity_decrease=0.0, min_impurity_split=None, class_weight=None, presort=False)2.1 重要参数

2.1.1 criterion

为了要将表格转化为一棵树,决策树需要找出最佳节点和最佳的分枝方法,对分类树来说,衡量这个“最佳”的指标 叫做“不纯度”。通常来说,不纯度越低,决策树对训练集的拟合越好。现在使用的决策树算法在分枝方法上的核心 大多是围绕在对某个不纯度相关指标的最优化上。

不纯度基于节点来计算,树中的每个节点都会有一个不纯度,并且子节点的不纯度一定是低于父节点的,也就是 说,在同一棵决策树上,叶子节点的不纯度一定是最低的。

Criterion这个参数正是用来决定不纯度的计算方的。sklearn提供了两种选择:

1)输入”entropy“,使用信息熵(Entropy)

2) 输入”gini“,使用基尼系数(Gini Impurity)

参数 | criterion |

如何影响模型? | 确定不纯度的计算方法,帮忙找出最佳节点和最佳分枝,不纯度越低,决策树对训练集 的拟合越好 |

可能的输入有哪些? | 不填默认基尼系数,填写gini使用基尼系数,填写entropy使用信息增益 |

怎样选取参数? | 通常就使用基尼系数 数据维度很大,噪音很大时使用基尼系数 维度低,数据比较清晰的时候,信息熵和基尼系数没区别当决策树的拟合程度不够的时候,使用信息熵 两个都试试,不好就换另外一个 |

建立一棵树

1. 导入需要的算法库和模块

from sklearn import treefrom sklearn.datasets import load_winefrom sklearn.model_selection import train_test_split2.探索数据

wine = load_wine()wine.data.shapepd.concat([pd.DataFrame(wine.data),pd.DataFrame(wine.target)],axis=1)wine.feature_names wine.target_names3分训练集和测试集

Xtrain, Xtest, Ytrain, Ytest = train_test_split(wine.data,wine.target,test_size=0.3)# 训练集的样本,训练集的目标值,测试集的样本,测试集的目标值Xtrain.shape Xtest.shape4建立模型

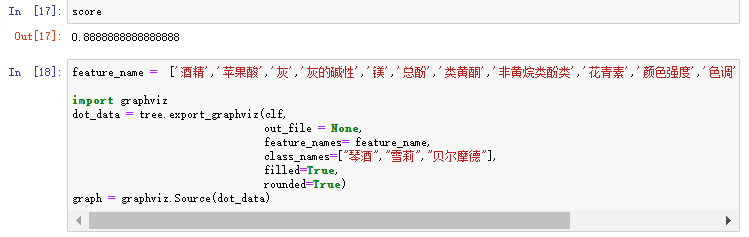

clf = tree.DecisionTreeClassifier(criterion="entropy") clf = clf.fit(Xtrain, Ytrain)score = clf.score(Xtest, Ytest) #返回预测的准确度score

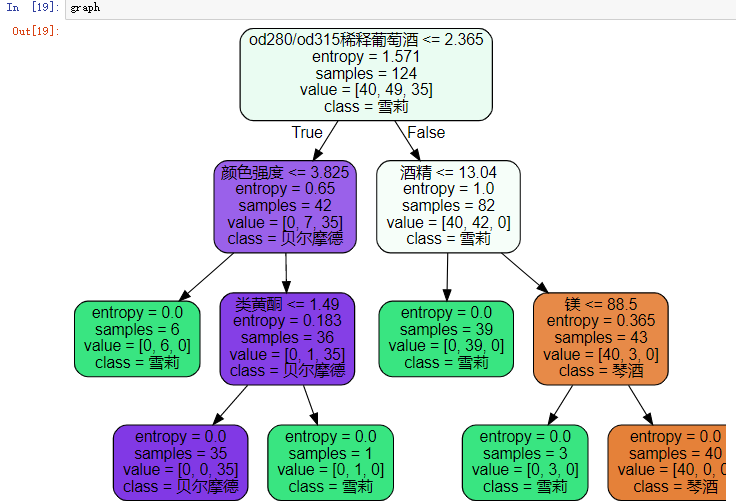

5 画图

feature_name = ['酒精','苹果酸','灰','灰的碱性','镁','总酚','类黄酮','非黄烷类酚类','花青素','颜色强度','色调','od280/od315稀释葡萄酒','脯氨酸']import graphvizdot_data = tree.export_graphviz(clf, out_file = None, feature_names= feature_name, class_names=["琴酒","雪莉","贝尔摩德"], filled=True, rounded=True)graph = graphviz.Source(dot_data)

6探索决策树

clf.feature_importances_random_state & splitter

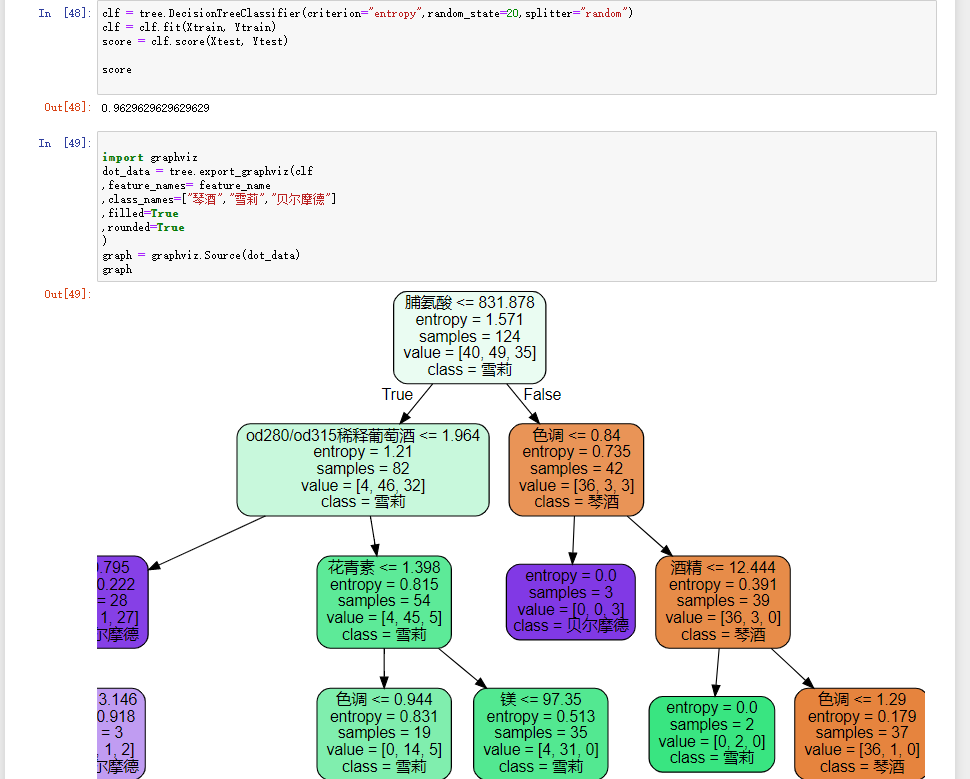

random_state用来设置分枝中的随机模式的参数,默认None,在高维度时随机性会表现更明显,低维度的数据(比如鸢尾花数据集),随机性几乎不会显现。输入任意整数,会一直长出同一棵树,让模型稳定下来。

random_state 随机数种子

splitter也是用来控制决策树中的随机选项的,有两种输入值,输入”best",决策树在分枝时虽然随机,但是还是会优先选择更重要的特征进行分枝(重要性可以通过属性feature_importances_查看),输入“random",决策树在分枝时会更加随机,树会因为含有更多的不必要信息而更深更大,并因这些不必要信息而降低对训练集的拟合。这 也是防止过拟合的一种方式。当你预测到你的模型会过拟合,用这两个参数来帮助你降低树建成之后过拟合的可能性。当然,树一旦建成,我们依然是使用剪枝参数来防止过拟合。

splitter = random / best

clf = tree.DecisionTreeClassifier(criterion="entropy",random_state=30,splitter="random")clf = clf.fit(Xtrain, Ytrain) score = clf.score(Xtest, Ytest)scoreimport graphvizdot_data = tree.export_graphviz(clf,feature_names= feature_name,class_names=["琴酒","雪莉","贝尔摩德"],filled=True,rounded=True)graph = graphviz.Source(dot_data) graph

2.1.3 剪枝参数

在不加限制的情况下,一棵决策树会生长到衡量不纯度的指标最优,或者没有更多的特征可用为止。这样的决策树 往往会过拟合,这就是说,它会在训练集上表现很好,在测试集上却表现糟糕。我们收集的样本数据不可能和整体 的状况完全一致,因此当一棵决策树对训练数据有了过于优秀的解释性,它找出的规则必然包含了训练样本中的噪 声,并使它对未知数据的拟合程度不足。

为了让决策树有更好的泛化性,我们要对决策树进行剪枝。剪枝策略对决策树的影响巨大,正确的剪枝策略是优化 决策树算法的核心

max_depth :限制树的最大深度,超过设定深度的树枝全部剪掉

min_samples_leaf:限定,一个节点在分枝后的每个子节点都必须包含至少min_samples_leaf个训练样本,否则分 枝就不会发生,或者,分枝会朝着满足每个子节点都包含min_samples_leaf个样本的方向去发生

min_samples_split:限定,一个节点必须要包含至少min_samples_split个训练样本,这个节点才允许被分枝,否则 分枝就不会发生、

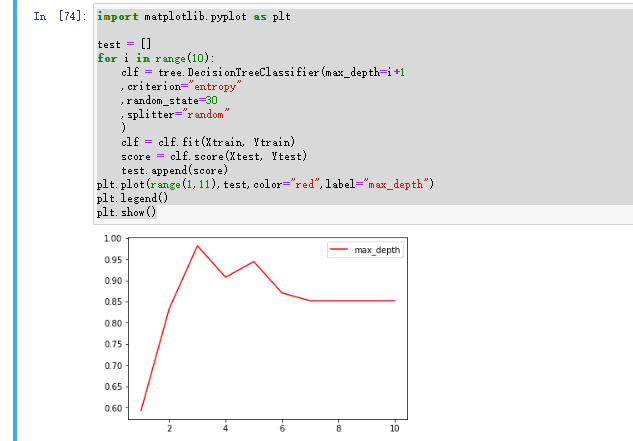

确定最优参数

import matplotlib.pyplot as plttest = []for i in range(10): clf = tree.DecisionTreeClassifier(max_depth=i+1 ,criterion="entropy" ,random_state=30 ,splitter="random" ) clf = clf.fit(Xtrain, Ytrain) score = clf.score(Xtest, Ytest) test.append(score)plt.plot(range(1,11),test,color="red",label="max_depth")plt.legend()plt.show()

回归树:

参数,属性及接口

criterion

回归树衡量分枝质量的指标,支持的标准有三种:

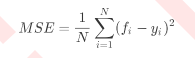

1) 输入"mse"使用均方误差mean squared error(MSE),父节点和叶子节点之间的均方误差的差额将被用来作为特征选择的标准,这种方法通过使用叶子节点的均值来最小化L2损失

2) 输入“friedman_mse”使用费尔德曼均方误差,这种指标使用弗里德曼针对潜在分枝中的问题改进后的均方误差

3)输入"mae"使用绝对平均误差MAE(mean absolute error),这种指标使用叶节点的中值来最小化L1损失

属性中最重要的依然是feature_importances_,接口依然是apply, fit, predict, score最核心。

其中N是样本数量,i是每一个数据样本,fi是模型回归出的数值,yi是样本点i实际的数值标签。所以MSE的本质, 其实是样本真实数据与回归结果的差异。在回归树中,MSE不只是我们的分枝质量衡量指标,也是我们最常用的衡 量回归树回归质量的指标,当我们在使用交叉验证,或者其他方式获取回归树的结果时,我们往往选择均方误差作 为我们的评估(在分类树中这个指标是score代表的预测准确率)。在回归中,我们追求的是,MSE越小越好。

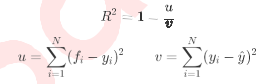

然而,回归树的接口score返回的是R平方,并不是MSE。R平方被定义如下:

其中u是残差平方和(MSE * N),v是总平方和,N是样本数量,i是每一个数据样本,fi是模型回归出的数值,yi 是样本点i实际的数值标签。y帽是真实数值标签的平均数。R平方可以为正为负(如果模型的残差平方和远远大于 模型的总平方和,模型非常糟糕,R平方就会为负),而均方误差永远为正。

值得一提的是,虽然均方误差永远为正,但是sklearn当中使用均方误差作为评判标准时,却是计算”负均方误差“(neg_mean_squared_error)。这是因为sklearn在计算模型评估指标的时候,会考虑指标本身的性质,均

方误差本身是一种误差,所以被sklearn划分为模型的一种损失(loss),因此在sklearn当中,都以负数表示。真正的均方误差MSE的数值,其实就是neg_mean_squared_error去掉负号的数字。

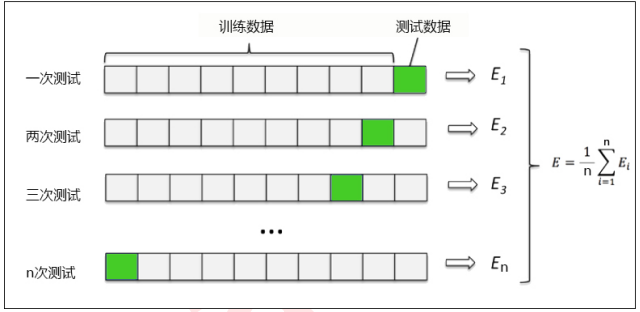

交叉验证:

交叉验证是用来观察模型的稳定性的一种方法,我们将数据划分为n份,依次使用其中一份作为测试集,其他n-1份 作为训练集,多次计算模型的精确性来评估模型的平均准确程度。训练集和测试集的划分会干扰模型的结果,因此 用交叉验证n次的结果求出的平均值,是对模型效果的一个更好的度量

boston = load_boston()regressor = DecisionTreeRegressor(random_state=0) cross_val_score(regressor, boston.data, boston.target, cv=10,scoring = "neg_mean_squared_error")回归树 数据准备

numpy.random.RandomState()是一个伪随机数生成器。那么伪随机数是什么呢?伪随机数是用确定性的算法计算出来的似来自[0,1]均匀分布的随机数序列。并不真正的随机,但具有类似于随机数的统计特征,如均匀性、独立性等

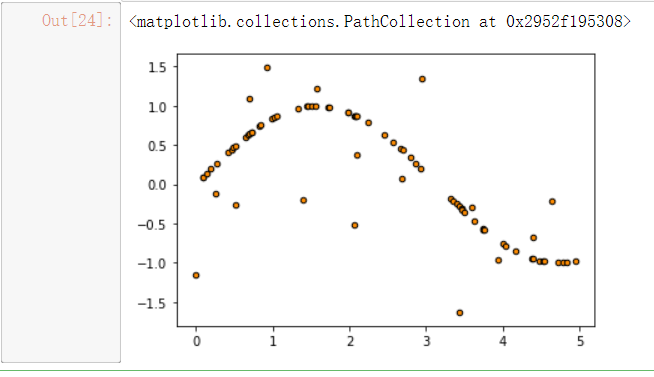

rng = np.random.RandomState(1)X = np.sort(5 * rng.rand(80,1), axis=0)y = np.sin(X).ravel()y[::5] += 3 * (0.5 - rng.rand(16))#np.random.rand(数组结构),生成随机数组的函数#了解降维函数ravel()的用法plt.scatter(X, y, s=20, edgecolor="black",c="darkorange", label="data")

测试集准备

X_test = np.arange(0.0, 5.0, 0.01)[:, np.newaxis] y_1 = regr_1.predict(X_test)y_2 = regr_2.predict(X_test)# plt.plot(X_test, y_1, color="cornflowerblue",label="max_depth=2", linewidth=2)双模型训练

regr_1 = DecisionTreeRegressor(max_depth=2) regr_2 = DecisionTreeRegressor(max_depth=5)regr_1.fit(X, y)regr_2.fit(X, y)画图

plt.figure()plt.scatter(X, y, s=20, edgecolor="black",c="darkorange", label="data")plt.plot(X_test, y_1, color="cornflowerblue",label="max_depth=2", linewidth=2)plt.plot(X_test, y_2, color="yellowgreen", label="max_depth=5", linewidth=2)plt.xlabel("data")plt.ylabel("target") plt.title("Decision Tree Regression")plt.legend()plt.show()

随机森林:

1 概述

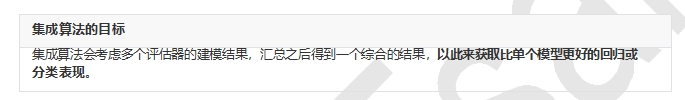

1.1 集成算法概述

集成学习(ensemble learning)是时下非常流行的机器学习算法,它本身不是一个单独的机器学习算法,而是通过在数据上构建多个模型,集成所有模型的建模结果。基本上所有的机器学习领域都可以看到集成学习的身影,在 现实中集成学习也有相当大的作用,它可以用来做市场营销模拟的建模,统计客户来源,保留和流失,也可用来预 测疾病的风险和病患者的易感性。在现在的各种算法竞赛中,随机森林,梯度提升树(GBDT),Xgboost等集成算法的身影也随处可见,可见其效果之好,应用之广。

多个模型集成成为的模型叫做集成评估器(ensemble estimator),组成集成评估器的每个模型都叫做基评估器(base estimator)

通常来说,有三类集成算法:装袋法(Bagging),提升法(Boosting)和stacking。

装袋法的核心思想是构建多个相互独立的评估器,然后对其预测进行平均或多数表决原则来决定集成评估器的结 果。装袋法的代表模型就是随机森林。

提升法中,基评估器是相关的,是按顺序一一构建的。其核心思想是结合弱评估器的力量一次次对难以评估的样本 进行预测,从而构成一个强评估器。提升法的代表模型有Adaboost和梯度提升树。

1.2sklearn中的集成算法

sklearn中的集成算法模块ensemble

ensemble.AdaBoostClassifier AdaBoost分类

ensemble.AdaBoostRegressor Adaboost回归

ensemble.BaggingClassifier 装袋分类器

ensemble.BaggingRegressor 装袋回归器

ensemble.ExtraTreesClassifier Extra-trees分类(超树,极端随机树)

ensemble.ExtraTreesRegressor Extra-trees回归

ensemble.GradientBoostingClassifier 梯度提升分类

ensemble.GradientBoostingRegressor 梯度提升回归

ensemble.IsolationForest 隔离森林

ensemble.RandomForestClassifier 随机森林分类

ensemble.RandomForestRegressor 随机森林回归

ensemble.RandomTreesEmbedding 完全随机树的集成

ensemble.VotingClassifier 用于不合适估算器的软投票/多数规则分类器

1.RandomForestClassifier

class sklearn.ensemble.RandomForestClassfier(n_estimators=’10’,criterion=’gini’, max_depth=None,min_samples_split=2, min_samples_leaf=1, min_weight_fraction_leaf=0.0,max_features=’auto’, max_leaf_nodes=None,min_impurity_decrease=0.0, min_impurity_split=None, bootstrap=True, oob_score=False, n_jobs=None, random_state=None, verbose=0, warm_start=False, class_weight=None)

criterion 不纯度的衡量指标,有基尼系数和信息熵两种选择

max_depth 树的最大深度,超过最大深度的树枝都会被剪掉

min_samples_leaf 一个节点在分枝后的每个子节点都必须包含至少min_samples_leaf个训练样 本,否则分枝就不会发生

min_samples_split 一个节点必须要包含至少min_samples_split个训练样本,这个节点才允许被分 枝,否则分枝就不会发生

max_features max_features限制分枝时考虑的特征个数,超过限制个数的特征都会被舍弃, 默认值为总特征个数开平方取整

min_impurity_decrease 限制信息增益的大小,信息增益小于设定数值的分枝不会发生

创建随机森林树

from sklearn.model_selection import train_test_splitXtrain, Xtest, Ytrain, Ytest = train_test_split(wine.data,wine.target,test_size=0.3)clf = DecisionTreeClassifier(random_state=0) rfc = RandomForestClassifier(random_state=0) clf = clf.fit(Xtrain,Ytrain)rfc = rfc.fit(Xtrain,Ytrain) score_c = clf.score(Xtest,Ytest) score_r = rfc.score(Xtest,Ytest)print("Single Tree:{}".format(score_c),"Random Forest:{}".format(score_r))画出随机森林和决策树在一组交叉验证下的效果对比

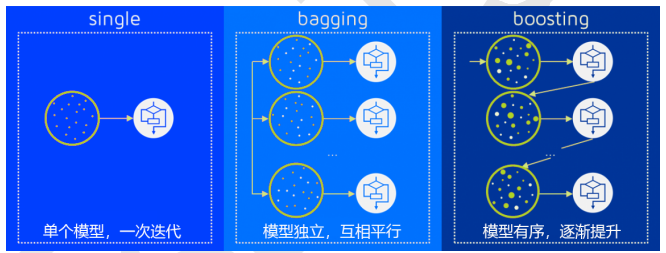

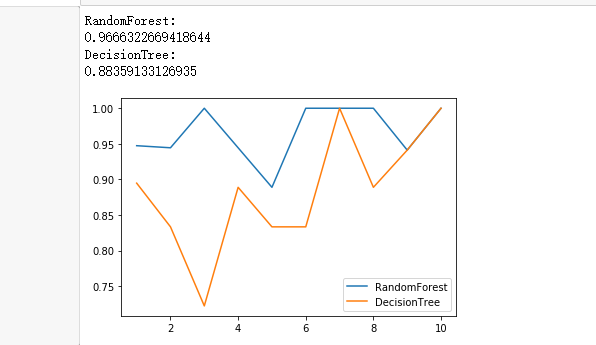

from sklearn.model_selection import cross_val_score import matplotlib.pyplot as pltrfc = RandomForestClassifier(n_estimators=25)rfc_s = cross_val_score(rfc,wine.data,wine.target,cv=10)clf = DecisionTreeClassifier()clf_s = cross_val_score(clf,wine.data,wine.target,cv=10)plt.plot(range(1,11),rfc_s,label = "RandomForest")plt.plot(range(1,11),clf_s,label = "Decision Tree") plt.legend()plt.show()

十次交叉验证结果

label = "RandomForest"for model in [RandomForestClassifier(n_estimators=25),DecisionTreeClassifier()]: score = cross_val_score(model,wine.data,wine.target,cv=10) print("{}:".format(label)),print(score.mean()) plt.plot(range(1,11),score,label = label) plt.legend() label = "DecisionTree"

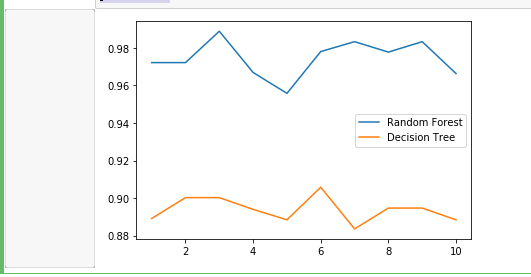

多次交叉验证的结果

rfc_l = []clf_l = []for i in range(10): rfc = RandomForestClassifier(n_estimators=25) rfc_s = cross_val_score(rfc,wine.data,wine.target,cv=10).mean() rfc_l.append(rfc_s) clf = DecisionTreeClassifier() clf_s = cross_val_score(clf,wine.data,wine.target,cv=10).mean() clf_l.append(clf_s)plt.plot(range(1,11),rfc_l,label = "Random Forest") plt.plot(range(1,11),clf_l,label = "Decision Tree") plt.legend()plt.show()

3405

3405

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?