这里整理一下平时所用的多模态情感数据集以备之用,后面会不断地去添加,也希望能够帮到其他人,欢迎大家补充。

作者:骑着白马的王子

地址:https://www.zhihu.com/people/pi-pi-57-67

01 双模态(一般是文本、图像和语音的两两组合)

1.《Multi-Modal Sarcasm Detection in Twitter with Hierarchical Fusion Model》--【多模态讽刺识别】2019年。

论文中建立的数据集,包含文本和图像两个模态,具体来说是三个模态,文本部分包含两个方面:一个是描述(文本模态),另一个是图像的属性,即图像包含那些东西,用文字描述(也可以归类为属性模态)。数据集较好之处是给出了原始数据,即有原始的文本,原始的图像和属性描述,可以任意操作成实验表征。

数据集和代码链接是https://github.com/headacheboy/data-of-multimodal-sarcasm-detection

2.《 Making the v in vqa matter: Elevating the role of image understanding in visual question answering》--【多模态问答】2017年。

论文中是VQA数据集,包括原始的图片、问答文本等各种属性。我们简单的可以通过word2vec或者Glove或者bert提取文本的embedding,通过Resnet来提取图片的feature,图片问题和回答三个方面通过对应的id来联系。

数据集下载链接在https://visualqa.org/download.html

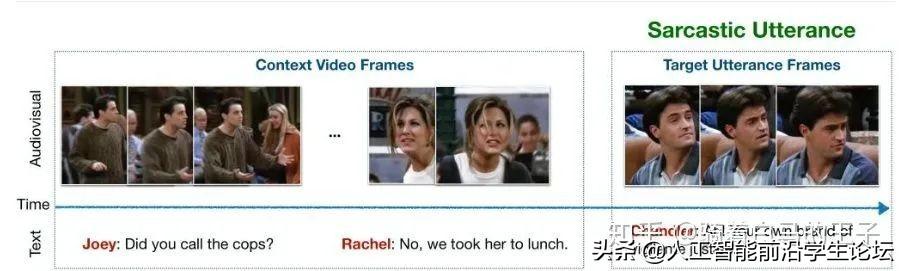

3.《Towards Multimodal Sarcasm Detection(An Obviously Perfect Paper)》--【多模态讽刺】2019年。

论文给的是图像和文本双模态讽刺视频。其中每个标签对应的图像包含多个,对应的文本是一组对话,具体如下图所示:

数据集链接是:https://github.com/soujanyaporia/MUStARD

4.《Microsoft COCO Captions Data Collection and Evaluation Server》--【多模态图片字幕】2015年。

论文给出的是经典的MS COCO数据集,现在还在广泛使用,数据集非常大,大部分设计到纯CV方面的数据集,标注一共分为5类:目标点检测,关键点检测,实例分割,全景分割以及图片标注,前面四个都是CV领域的,感兴趣的同学可以玩一下,简单的多模态方向只需要最后一个,当然如果你要通过目标检测辅助多模态分析等等方向前面几个标注也是有用的。简单的,我们这里需要的是图片和字幕两个模态,可以用来做多模态匹配之类的任务。数据集包括2014年发布的以及2017年发布的,每个都有超过几十万张图片的标注,图片给出的是原始图片,标注是基于JSON文件给出的,也是原始的文本数据,我们只要写出程序将字幕抽取出来就可以了,字幕和图片之间有id对应,非常方便。

数据集链接是:https://cocodataset.org/#download

02 三模态(一般是文本、图像加语音)

1.《Multimodal Language Analysis in the Wild_ CMU-MOSEI Dataset and Interpretable Dynamic Fusion Graph》--【多模态情感和情绪分析】2018年。

论文中描述的CMU-MOSEI数据集规模最大的三模态数据集,且具有情感和情绪两个标签。但是这里要注意,数据集是多标签特性,即每一个样本对应的情绪可能不止一种,对应情绪的强弱也不同,在[-3~3]之间。数据集的原始数据给出了,但是过于原始,即给出的是文本,音频和视频文件,图像还得自己去以固定频率捕获并且和文本语音对其还是比较麻烦的。大多实验都使用处理好的实验数据。

数据集的链接是:http://immortal.multicomp.cs.cmu.edu/raw_datasets/processed_data/

2.《UR-FUNNY: A Multimodal Language Dataset for Understanding Humor》--【多模态幽默分析】2019年。

论文中描述的是UR-FUNNY数据集,包含文本语音图像三个模态来分析幽默情感。具体目前没用到没有细看,日后再补充。

数据集和代码链接是:https://github.com/ROC-HCI/UR-FUNNY

3.《MOSI: Multimodal Corpus of Sentiment Intensity and Subjectivity Analysis in Online Opinion Videos》--【多模态情绪分析】。

论文中描述的是CMU-MOSI数据集,跟上述的CMU-MOSEI数据集名字很像,但是发布较早,规模小且只有情绪的标签。数据集跟MOSEI一样,有处理好的实验数据,但是也有部分原始数据,video部分依然是视频不是已经捕获好的图像。

数据集的链接是:http://immortal.multicomp.cs.cmu.edu/raw_datasets/processed_data/

4.《CH-SIMS: A Chinese Multimodal Sentiment Analysis Dataset with Fine-grained Annotations of Modality》--【中文多模态情绪】2020年。

论文中给出常规的文本、图片和语音的数据进行多模态情绪分类,其中标签更加细致,不仅有最终的标签,还有各个模态的标签。

具体如图所示。论文以及数据集具体我还没看,日后需要我将修改更仔细。

数据集链接是:https://github.com/thuiar/MMSA

本文目的在于学术交流,并不代表本号赞同其观点或对其内容真实性负责,版权归原作者所有,如有侵权请告知删除。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?