理论知识

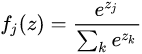

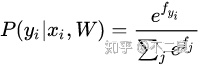

softmax函数如下:

一个样本在C个类别的评分为z,可以看出z为一个向量。softmax函数对

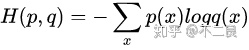

交叉熵定义如下:

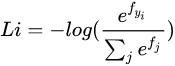

将softmax函数与交叉熵相结合,就可以得到如下式子:

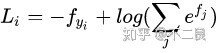

另一种等价的形式为:

从信息理论的角度来理解:

相对熵也被称为KL散度,它用于衡量同一个随机变量X的两个分布p(X)和q(X)之间的差异,p(X)表示样本的真实分布,q(X)表示预测的分布,DL散度的公式如下:

相对熵的特点是只有只有p(x)=q(x)时,其值才为0,若p(x)和q(x)略有差异,其值就会大于0。

整理之后可以得到:

由于真实概率分布是固定的(虽然我们现在不知道,但我们有训练集),但是它的概率质量都分布在正确的类别上(

概率论解释:

可以解释为是给定图像数据

现在我们想做的是找到使正确类别的概率最大的W,这正好是极大似然估计(MLE)的作用,即:

对其取负对数:

让似然函数的负对数最小就等价于似然函数最大,这和交叉熵的公式完全一样!

算法实现部分重点的就是求梯度和向量化了,这部分之后再统一写吧,之后的内容和SVM没什么差别,softmax分类器也是个模板匹配。

5875

5875

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?