Paper Card

论文标题:Learning Interactive Real-World Simulators

论文作者:Mengjiao Yang, Yilun Du, Kamyar Ghasemipour, Jonathan Tompson, Leslie Kaelbling, Dale Schuurmans, Pieter Abbeel

作者单位:UC Berkeley, Google DeepMind, MIT, University of Alberta

论文原文:https://arxiv.org/abs/2310.06114

论文出处:ICLR 2024 oral

论文被引:7(03/03/2024)

项目主页:https://universal-simulator.github.io/unisim/

论文代码:–

Abstract

基于互联网数据训练的生成模型已经彻底改变了文本,图像和视频内容的创建方式。生成模型的下一个里程碑或许是模拟人类,机器人和其他交互Agent所采取的行动(Actions)所带来的真实体验。真实世界模拟器(Real-World Simulator)的应用范围很广,从游戏和电影中的可控内容创建,到纯粹在模拟中训练可直接部署在真实世界中的具身智能体(Embodied Agent)。本文探讨了通过生成建模学习现实世界交互通用模拟器的可能性。首先提出了一个重要的观点:可用于学习现实世界模拟器的自然数据集通常在不同维度上都很丰富(例如,图像数据中的丰富物体,机器人数据中的密集采样动作以及导航数据中的各种运动)。通过对不同数据集的精心安排,可以从静态场景和物体中模拟出 “打开抽屉” 等高层次指令(high-level instructions)和 “通过 ∆x, ∆y 移动” 等低层次控制(low-level controls)的视觉结果。利用模拟器来训练高层次视觉语言策略和低层次强化学习策略,每种策略都可以在模拟训练后在现实世界中零样本部署。

Summary

研究问题:通过生成建模学习现实世界交互通用模拟器的可能性。

面临挑战:建立这种模拟器的一个障碍在于数据集——不同的数据集涵盖不同的信息,必须将这些信息整合在一起才能模拟出逼真的体验。

主要贡献:

- 我们将不同维度(如物体,场景,动作,运动,语言和运动控制)的各种数据集整合到一个统一的动作输入视频输出(action-in-video-out)生成框架中,从而迈出了构建通用真实世界交互模拟器的第一步。

- 我们将动作输入视频输出框架表述为以有限历史为条件,以视频扩散模型为参数的观察预测模型(observation prediction model)。我们说明了观察预测模型可以自回归方式推出,从而获得一致的长周期视频。

- 我们说明了模拟器如何使高层次语言策略,低层次控制策略和视频描述模型在纯粹的模拟训练中推广到现实世界,从而弥合模拟与现实之间的差距(sim-to-real gap)。

方法概述:我们将现实世界的模拟器定义为这样一个模型:在给定世界的某种状态(如图像帧)的情况下,它可以将某种动作作为输入,并将该动作的视觉结果(以视频的形式)作为输出。提出了处理每种类型数据的具体策略,以统一动作空间,并将不同长度的视频与动作对齐。有了统一的动作空间,我们就可以在第 2.2 节中训练一个以动作为条件的视频生成模型,通过一个将动作与视频相关联的通用接口来融合不同数据集的信息。

主要结论:

- 以 4 帧为条件比以单帧为条件更好,但过多的帧会影响性能。在 Ego4D 上,增加 4 帧以上的条件帧数并不能进一步提高性能,但对于需要记忆遥远过去的应用(如导航)来说,这可能会有所帮助。

- 在对 UniSim 进行多样化数据联合训练的过程中,将大小差异较大的数据集进行简单组合会导致低数据域的生成质量较低。将域标识符(如数据集名称)附加到动作条件中,可以提高低数据域的生成质量。

- UniSim 可以为其他机器学习子问题生成训练数据。这在自然数据稀少或难以收集的情况下(如犯罪或事故录像)尤其有用。

- UniSim 可以作为有效的数据生成器,用于改进更广泛的视觉语言模型。

- 以几帧近期历史为条件的模拟器无法捕捉长期记忆(例如,如果把苹果放进抽屉不是条件的一部分,那么抽屉打开后抽屉里的苹果就可能消失)。

- UniSim 不适用于那些不会引起视觉观察变化的操作环境(例如,抓握静态杯子时的不同力量)。真正的通用模拟器应能捕捉到视觉体验之外的模态信息,例如声音,感官等。

研究背景

生成模型的最终目标是能够模拟各种行为的视觉效果,从汽车如何在街道上行驶,到家具和饭菜是如何准备的。有了真实世界模拟器,人类就能与各种场景和物体交互,机器人就能从模拟经验中学习,同时还能模拟大量类似真实世界的数据,以训练其他类型的机器智能。

建立这种模拟器的一个障碍在于数据集——不同的数据集涵盖不同的信息,必须将这些信息整合在一起才能模拟出逼真的体验。例如,来自互联网的文本-图像配对数据包含丰富的场景和物体,但动作(Actions)却很少;视频描述和问答数据包含丰富的高层次描述,但低层次动作细节却很少;人类活动数据包含丰富的人类动作,但机械动作却很少;机器人数据包含丰富的机器人动作,但数量有限。

方法介绍

本文在条件视频生成框架中结合大量数据,实例化一个通用模拟器。在统一的动作-视频-输出接口(interface)下,该模拟器可通过对静态场景和物体的细粒度运动控制实现丰富的交互。为了支持长周期重复交互,将模拟器设计为一个观测预测模型,该模型可以自回归方式建模,以支持跨视频生成边界的一致模拟。

“通用” 的意思是模型可以通过动作和视频的统一接口来模拟,而不是能够模拟一切。例如,声音没有被模拟。

虽然模拟器的潜在应用范围很广,但展示了三个具体的案例。

- 如何通过对模拟经验的事后重新标注(hindsight relabeling),使视觉语言策略能够执行长周期目标条件任务。除了学习高层次视觉语言策略,还说明了模拟器如何利用基于模型的强化学习(RL)来学习低层次控制策略。

- 高层次视觉语言策略和低层次控制策略虽然纯粹是在模拟中训练出来的,但可以推广到真实的机器人环境中。通过使用在视觉上与真实世界几乎无差别的模拟器,可以实现这一点。

- 可以模拟数据收集成本高昂或危险的罕见事件(如自动驾驶汽车的碰撞)。这些模拟视频可用于改进其他机器智能,如罕见事件检测器(rare event detectors)。

主要贡献可归纳如下:

- 将不同维度(如物体,场景,动作,运动,语言和运动控制)的各种数据集整合到一个统一的动作输入-视频输出生成框架中,从而迈出了构建通用真实世界交互模拟器的第一步。

- 将动作输入视频输出框架表述为以有限历史为条件,以视频扩散模型为参数的观察预测模型。观察预测模型可以自回归方式建模,从而获得一致的长周期视频。

- 模拟器如何使高层次语言策略,低层次控制策略和视频描述模型在纯粹的模拟训练中推广到现实世界,从而减小模拟与现实之间的差距。

数据构建

Simulated execution and renderings

为真实世界的视频添加动作注释的成本很高,而 Habitat 等模拟引擎可以呈现各种各样的动作。使用以前从这些模拟器中收集的数据集,即 HM3D 的 Habitat 物体导航和Language Table数据来训练 UniSim。提取文本描述作为可用的动作。对于模拟的连续控制动作,通过语言嵌入对其进行编码,并将文本嵌入与离散控制值连接起来。

Real robot data

越来越多的真实机器人执行视频数据与任务描述(如 Bridge Data [18] 以及支持 RT-1 和 RT-2 [19]的数据)相匹配。尽管不同机器人的底层控制动作往往不同,但任务描述可以作为 UniSim 中的高层动作。在有类似模拟机器人数据的情况下,会进一步将连续控制动作离散化。

Human activity videos

丰富的人类活动数据,如 Ego4D,EPIC-KITCHENS和 Something-Something V2 等。与低层次的机器人控制不同,这些活动是人类与世界交互的高层次行为。但这些动作通常作为标签提供给视频分类或活动识别任务。在这种情况下,将视频标签转换为文本动作。此外,还对视频进行子采样,以捕捉有意义动作的帧率构建观察片段。

Panorama scans

Matterport3D 等3D扫描技术非常丰富。这些静态扫描不包含动作。通过截断全景扫描(truncating panorama scans)来构建动作(如左转),并利用两幅图像之间的相机位姿信息。

Internet text-image data

成对的文本图像数据集(如 LAION)包含各种物体的静态图像,没有任何动作。然而,描述通常包含运动信息,如 “一个人在走路”。为了在 UniSim 中使用图像数据,将单张图像视为单帧视频,将图像描述视为动作。

使用 T5 将文本 tokens 处理为连续表示,并与诸如机器人控制等低层次动作连接(concatenated)起来。这就是模拟器的最终统一动作空间。

模型架构

将现实世界的模拟器定义为这样一个模型:在给定世界的某种状态(如图像帧)的情况下,它可以将某种动作作为输入,并将该动作的视觉结果(以视频的形式)作为输出。学习这样的模拟器非常困难,因为不同的动作有不同的格式(如语言指令,机器人控制,摄像机动作),视频也有不同的帧频。以统一动作空间,并将不同长度的视频与动作对齐。有了统一的动作空间,就可以训练一个以动作为条件的视频生成模型,通过一个将动作与视频相关联的通用接口来融合不同数据集的信息。

Simulating Long-Horizon Interactions through Observation Prediction

通过将不同环境中的观察结果转换为视频,以及将不同格式的动作转换为连续嵌入,我们可以将与许多真实世界环境的交互表述为与通用模拟器的交互。然后,我们将通用模拟器表述为一个观察预测模型,该模型可根据动作和先前的观察结果预测观察结果,如图 2 所示。

UniSim 是一个视频扩散模型,经过训练,可以根据过去的观察(例如 ot-1)和−1 处的动作输入来预测下一个(可变长度)观察帧(ot)。UniSim 可以处理各种模态的时间扩展动作,如运动控制(∆x1,∆ω1,∆x2,…),语言描述 (“wipe table”) 以及从相机运动和其他来源中提取的动作。每个虚线箭头表示将下一个视频片段的初始噪声样本与前一帧连接起来。

Parametrizing and Training the Simulator.

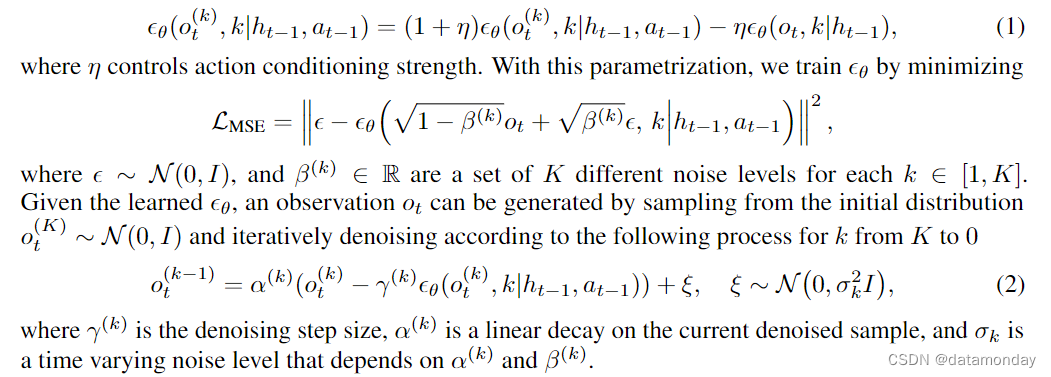

使用扩散模型作为图 2 所示 UniSim 的实例,对 p(ot|ht-1,at-1)进行参数化。具体来说,反向过程学习去噪模型 ε θ ( o t ( k ) , k ∣ h t − 1 , a t − 1 ) ε_θ (o^{(k)}_t , k|h_{t-1}, a_{t-1}) εθ(ot(k),k∣ht−1,at−1) ,该模型以历史记录为条件,通过 K 个去噪步骤从初始噪声样本中生成下一个观测值。在实际应用中,只使用以前的视频帧,而省略以前的动作作为历史记录,并将以前的视频帧与初始噪声样本 o t ( K ) ∼ N ( 0 , I ) o^{(K)}_t ∼ \mathcal{N}(0, I) ot(K)∼N(0,I) 按通道串联(concatenate)起来,作为去噪模型的条件输入。为了对动作 at-1 进行条件化,利用了 classifier-free diffusion guidance [27]。最终 T (ot|ht-1, at-1) 由方差表参数化:

Architecture and Training

使用 video U-Net 架构通过在下采样和上采样过程中使用交错时间和空间注意力和卷积层来实现 UniSim。对于历史条件(history conditioning),在所有未来的帧索引中复制条件帧(conditioning frame),并将条件帧与未来每一帧的噪声样本连接起来,作为 U-Net 的输入。UniSim 模型有 5.6B 参数,需要 512 个 TPU-v3 和 20 天来训练所有数据。

实验结果

通过模拟人类和机器人的丰富动作和长周期交互,演示了模拟真实世界的操纵和导航环境。

Action-Rich, Long-Horizon, and Diverse Interactions+

Action-Rich Simulation.

首先通过自然语言操作演示了富含动作的交互。图 3 显示了从相同的初始观察(最左列)开始的人类操作和导航模拟。可以指示初始帧中的人执行各种厨房任务(左上),按下不同的开关(右上)或浏览场景(下)。该模型仅在一般互联网数据上进行了训练,而未在 EPIC-KITCHENS [20] 等动作丰富的操作数据上进行训练,因此无法模拟动作丰富的操作(附录 13)。

Long-Horizon Simulation.

图 4 中展示了 8 个连续的交互过程。将先前的观察结果和新的语言操作作为每次交互的模拟条件。UniSim 成功地保留了之前指令所操作的物体(例如,橙子和罐子在放入第 4,5,7,8 列的抽屉后被保留下来)。

Diversity and Stochasticity in the Simulator.

UniSim 还能支持高度多样化和随机的环境转换,例如,取下上面的毛巾后会露出不同的物体(图 5 左),不同的物体颜色和位置(图 5 右中的杯子和笔)以及摄像机角度变化等真实世界的变化。扩散模型的灵活性促进了对无法通过行动控制的高度随机环境的模拟,从而使策略可以学会只控制可控部分[29]。

Ablation and Analysis

Frame Conditioning Ablations.

使用 Ego4D 数据集[9]的验证集,对过去帧数的选择进行了消减,该数据集包含以自我为中心的运动,需要正确处理观察历史。表 1 中比较了以不同数量的过去帧为条件的 UniSim。以 4 个帧为条件比以单个帧为条件更好,但以过去太远的历史为条件(距离呈指数增长的 4 个帧)会影响性能。在 Ego4D 上,增加 4 帧以上的条件帧数并不能进一步提高性能,但对于需要记忆遥远过去的应用(如导航检索)来说,这可能会有所帮助。

Simulating Low-Data Domains.

在对 UniSim 进行多样化数据联合训练的过程中,将大小差异较大的数据集进行简单组合会导致低数据域的生成质量较低。虽然可以在训练过程中增加这些域在数据混合物中的权重,但将域标识符(如数据集名称)附加到动作条件中,可以提高低数据域的生成质量,如图 6 所示。虽然这种域标识符能提高分布内的生成质量,但特定域标识符会影响对其他域的泛化,因此只有在测试域处于训练域的分布中时才应使用。

模型应用

Training Long-Horizon Vision-Language Policies through Hindsight Labeling.

语言模型和视觉语言模型(VLM)最近被用作可在基于图像或文本的观察和行动空间中运行的策略 [30, 31, 32]。学习此类Agent的一大挑战在于需要大量的语言动作标签。随着任务范围和复杂程度的增加,数据收集的劳动强度也会增加。UniSim 可以通过事后重新标注为 VLM 策略生成大量的训练数据。

Setup and Baseline.

[33] Language Conditioned Imitation Learning over Unstructured Data

使用 Language Table 中的数据来学习桌子上积木的几何重新排列。用 PALM-E 架构训练图像-目标条件 VLM 策略,以预测语言指令和起始图像与目标图像中的运动控制。对于基线,目标被设置为原始短视距轨迹的最后一帧。在每次评估运行中,通过修改 3-4 个区块的位置来设定长距目标,并在使用 VLM 策略执行 5 条指令后测量区块到目标状态的距离。将目标距离缩短度量定义为:

Generating Hindsight Data with the Simulator.

为了将模拟器用于长周期任务,从事后重标注(hindsight relabeling)中汲取了灵感。具体来说,通过在模拟器中对每条轨迹进行 3-5 次 rollouts 来创建总计 10k 条长周期轨迹,其中每次 rollouts 对应一条脚本语言指令。然后,将每次长周期 rollouts 的最终帧作为目标输入,并将脚本语言指令作为训练 VLM 策略的监督。

[34] Hindsight policy gradients

Results on Real-Robot Evaluation.

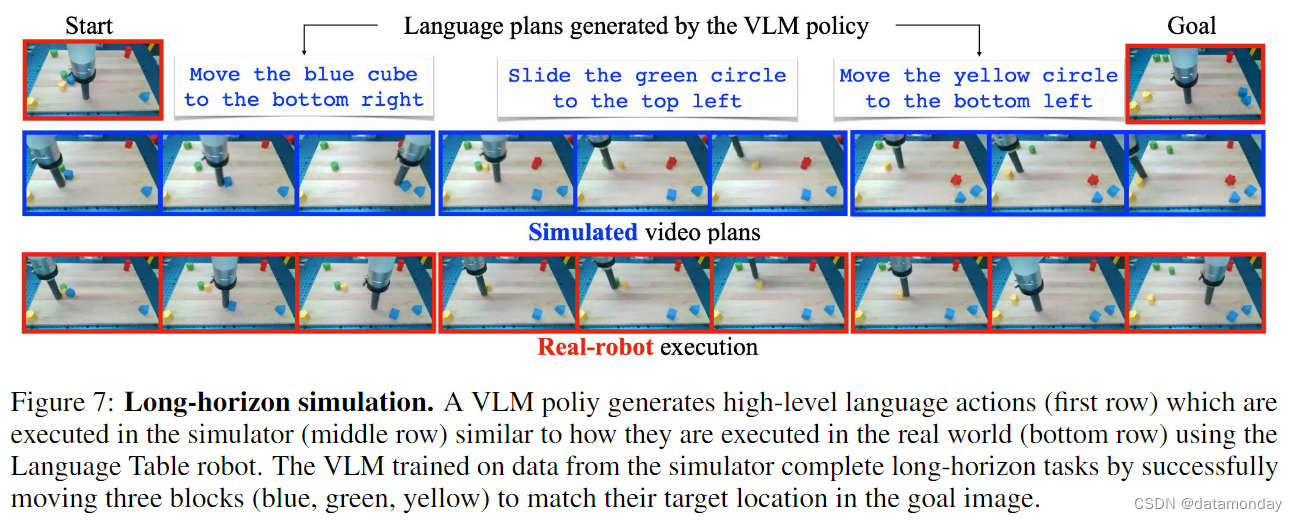

尽管 VLM 策略仅在模拟数据上进行了训练,但它仍能根据真实 Language Table 表域中的初始和目标图像生成有效的高层次语言动作,而训练模拟器的数据正是在该 Language Table 域中收集的。模拟器可以模拟来自初始真实观测数据的视频轨迹,并利用逆动力学模型(inverse dynamics model)从中恢复机器人动作,然后在真实机器人上执行。图 7 显示了 VLM 生成的语言动作,模拟器根据语言动作生成的视频以及在真实机器人上的执行情况。模拟视频轨迹已成功转化为真实世界中的机器人动作。

Results on Simulated Evaluation.

还进行了基于模拟器的评估,比较了使用生成的长周期数据和使用原始短视距数据的 VLM 策略对目标距离的减少(表 2)。使用生成的长周期数据训练的 VLM 在完成长周期目标条件任务时的表现比使用原始数据时好 3-4 倍。

Real-World Simulator for Reinforcement Learning

RL在下围棋和 Atari 游戏等高难度任务上取得了超人的表现,但在现实世界中的应用却很有限,原因之一是缺乏逼真的环境模拟器。模拟器能否通过为Agent提供可并行访问的逼真模拟器来实现对 RL Agent的有效训练。

Setup.

对 PaLI 3B 视觉语言模型进行了微调,利用行为克隆技术从图像观察和任务描述(如 “向右移动蓝色立方体”)中预测低层次控制动作(∆x,∆y 中的关节运动),作为低层次控制策略和基线,称之为 VLA 策略,与[32]类似。由于 UniSim 可以将底层控制动作作为输入,因此可以使用 VLA 策略生成的控制动作在模拟器中直接进行基于模型的 rollouts。为了获取奖励信息,使用训练数据中的完成步数作为Agent奖励,训练一个将当前观察结果映射到所学奖励的模型。然后,使用 REINFORCE 算法优化 VLA 策略,将模拟器中的rollouts 操作视为真实环境中的策略 rollouts 操作,并使用所学奖励模型预测模拟 rollouts 操作的奖励。

[32] RT-2: Vision-Language-Action Models Transfer Web Knowledge to Robotic Control

Results.

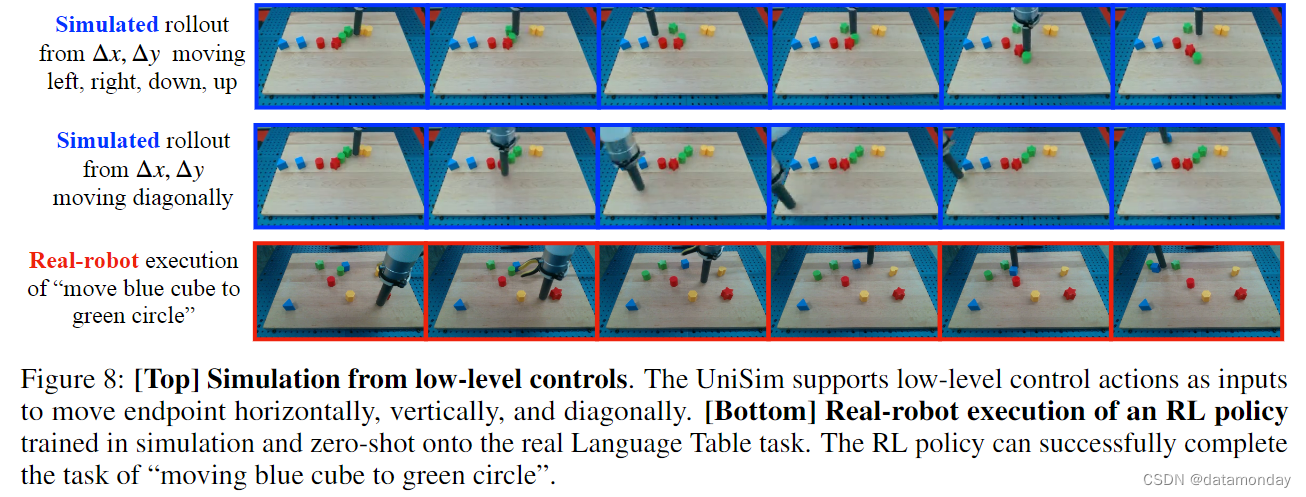

首先对模拟真实机器人的执行情况进行正确性检查,方法是在图 8(最上面两行)中反复应用低层次控制动作(例如,∆x = 0.05,δy = 0.05),持续 20-30 个环境步长,使端点向左,向右,向下,向上和向对角线移动。模拟 rollouts 既捕捉到了端点的移动,也捕捉到了碰撞的物理现象。为了将模拟训练的 RL 策略与 BC 策略进行比较,在模拟器中对模拟滚动进行了定性评估。表 3 显示,在一系列任务中,RL 训练显著提高了 VLA 策略的性能,尤其是在 "指向蓝色块 "等任务中。然后,将在模拟器中训练好的 RL 策略直接部署到真实机器人上,并观察到成功执行任务的情况,如图 8 所示(最下面一行)。

Realistic Simulator for Broader Vision-Language Tasks

UniSim 可以为其他机器学习子问题生成训练数据。这在自然数据稀少或难以收集的情况下(如犯罪或事故录像)尤其有用。在 UniSim 生成的纯数据上训练视觉语言模型,提供了这样一个概念验证,并观察到在视频描述方面的显著性能优势。

Results.

在表 4 中,将在纯生成视频上进行微调的 PaLI-X 与未进行微调的预训练 PaLI-X 以及在原始 ActivityNet 描述上进行微调的 PaLI-X 进行了比较。与在 ActivityNet 上完全不做微调相比,在生成的数据上进行纯微调能大幅提高描述性能(从 15.2 到 46.23),同时达到在真实数据上微调性能的 84%。此外,与在真实数据上进行微调的 PaLI-X 相比,在生成数据上进行微调的 PaLI-X 在 MSR-VTT[6],VATEX [41] 和 SMIT [42] 等其他描述任务中的应用效果更好,而在真实数据上进行微调的 PaLI-X 往往会过拟合 ActivityNet。这些结果表明,UniSim 可以作为有效的数据生成器,用于改进更广泛的视觉语言模型。

实验结论

可以根据从文本到机器人控制等各种动作输入来学习现实世界的模拟器。UniSim 可以模拟与人类交互和训练自主Agent的视觉真实体验。

局限性:

Hallucination.

当一个动作在场景中不现实时(例如,给桌面机器人下达 “洗手” 的指令),我们就会观察到幻觉(例如,桌子变成了水槽,或者视线从桌面机器人身上移开,出现了一个水槽)。理想情况下,我们希望 UniSim 能够检测到无法模拟的操作,而不是产生不切实际的结果。

Limited memory.

以几帧近期历史为条件的模拟器无法捕捉长期记忆(例如,如果把苹果放进抽屉不是条件的一部分,那么抽屉打开后抽屉里的苹果就可能消失)。需要多少历史记录取决于模拟器的应用(例如,模拟器是用于近马尔科夫环境下的策略学习,还是用于需要长期记忆的问答)。

Limited out-of-domain generalization.

对于训练数据中没有体现的领域,情况尤其如此。例如,模拟器主要是针对 4 种机器人形态进行训练的,因此它对未见过的机器人的泛化能力有限。进一步扩大训练数据的规模可能会有所帮助,因为训练数据与互联网上的所有视频数据相差甚远。

Visual simulation only.

我们的模拟器并不适用于那些不会引起视觉观察变化的操作环境(例如,抓握静态杯子时的不同力量)。真正的通用模拟器应能捕捉到视觉体验之外世界的方方面面(如声音,感官等)。

本文探讨通过生成建模学习现实世界交互通用模拟器的可能性。将不同数据集整合到统一框架,以视频扩散模型为参数构建观察预测模型。实验表明,该模拟器可模拟丰富交互,为视觉语言策略和强化学习提供训练数据,但存在幻觉、记忆有限等局限。

本文探讨通过生成建模学习现实世界交互通用模拟器的可能性。将不同数据集整合到统一框架,以视频扩散模型为参数构建观察预测模型。实验表明,该模拟器可模拟丰富交互,为视觉语言策略和强化学习提供训练数据,但存在幻觉、记忆有限等局限。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?