自适应参数化ReLU,就是一种动态ReLU(Dynamic ReLU)。该文章在2019年5月投稿至IEEE Trans. on Industrial Electronics,2020年1月录用,2020年2月在IEEE发布。

在调参记录14里,只有2个残差模块,结果遭遇欠拟合了。这次增加一个残差模块试试。

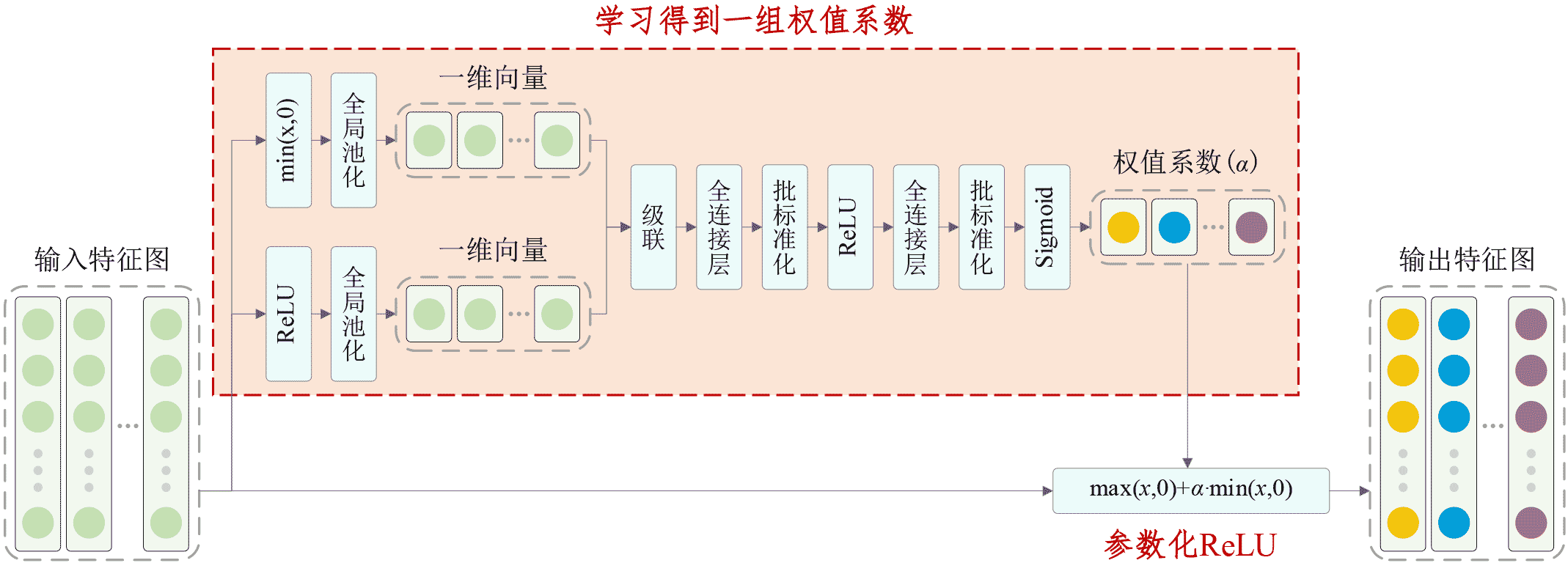

自适应参数化ReLU激活函数的基本原理如下:

Keras程序如下:

#!/usr/bin/env python3

实验结果如下:

Epoch 2575/5000

10s 197ms/step - loss: 0.3505 - acc: 0.9039 - val_loss: 0.4548 - val_acc: 0.8745

Epoch 2576/5000

10s 198ms/step - loss: 0.3571 - acc: 0.9003 - val_loss: 0.4483 - val_acc: 0.8732

Epoch 2577/5000

10s 194ms/step - loss: 0.3536 - acc: 0.9033 - val_loss: 0.4547 - val_acc: 0.8725

Epoch 2578/5000

10s 196ms/step - loss: 0.3514 - acc: 0.9033 - val_loss: 0.4429 - val_acc: 0.8766程序还没跑完,似乎也没必要跑完了。

训练集上还没拟合好,测试集准确率已经低于训练集准确率大约2.5%了。这是同时存在欠拟合和过拟合呀!

Minghang Zhao, Shisheng Zhong, Xuyun Fu, Baoping Tang, Shaojiang Dong, Michael Pecht, Deep Residual Networks with Adaptively Parametric Rectifier Linear Units for Fault Diagnosis, IEEE Transactions on Industrial Electronics, 2020, DOI: 10.1109/TIE.2020.2972458

Deep Residual Networks with Adaptively Parametric Rectifier Linear Units for Fault Diagnosisieeexplore.ieee.orgFrom

深度残差网络+自适应参数化ReLU激活函数(调参记录15)_人工智能_dangqing1988的博客-CSDN博客blog.csdn.net

631

631

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?