有两种情况不可逆:

(1) 当X中有线性相关的向量,也就是特征之间可能有重叠,或者互相影响的时候

(2) 当X 列数大于行数,对应于特征数大于样本数,此时不可逆 。两种情况X转置*X的行列式为0

克服:

(1)将高自相关的变量进行删除;

(2)岭回归也能够避免X’X的不可逆。

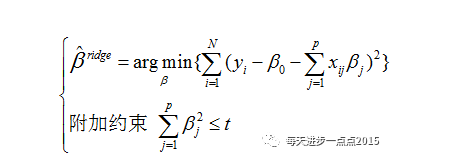

岭回归一般可以用来解决线性回归模型系数无解的两种情况

1970年Heer提出了岭回归方法,非常巧妙的化解了这个死胡同,即在X’X的基础上加上一个较小的lambda扰动 ,从而使得行列式不再为0。

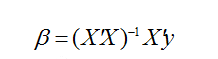

岭回归系数的求解表达式 ![]()

对于岭回归来说,随着lambda的增大,模型方差会减小(因为矩阵X’X行列式在增大,其逆就是减小,从而使得岭回归系数在减小)而偏差会增大。

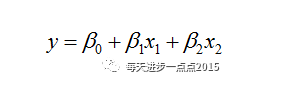

其实,LASSO回归于岭回归只是在惩罚函数部分有所不同,但这个不同却让LASSO明显占了很多优势,例如在变量选择上就比岭回归强悍的多。就以直观的图形为例,LASSO回归的惩罚函数映射到二维空间的话,就会形成“角”,一旦“角”与抛物面相交,就会导致beta1为0(如上图所示),这样beta1对应的变量就是一个可抛弃的变量。但是在岭回归过程中,没有“角”的圆形与抛物面相交,出现岭回归系数为0的概率还是非常小的。

参考:

http://f.dataguru.cn/thread-598486-1-1.html

2万+

2万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?