点一下关注吧!!!非常感谢!!持续更新!!!

目前已经更新到了:

- Hadoop(已更完)

- HDFS(已更完)

- MapReduce(已更完)

- Hive(已更完)

- Flume(已更完)

- Sqoop(已更完)

- Zookeeper(已更完)

- HBase(已更完)

- Redis (已更完)

- Kafka(已更完)

- Spark(正在更新!)

章节内容

上节我们完成了如下的内容:

- Spark Streaming DStream 有状态转换

- DStream 有状态转换 案例

基础介绍

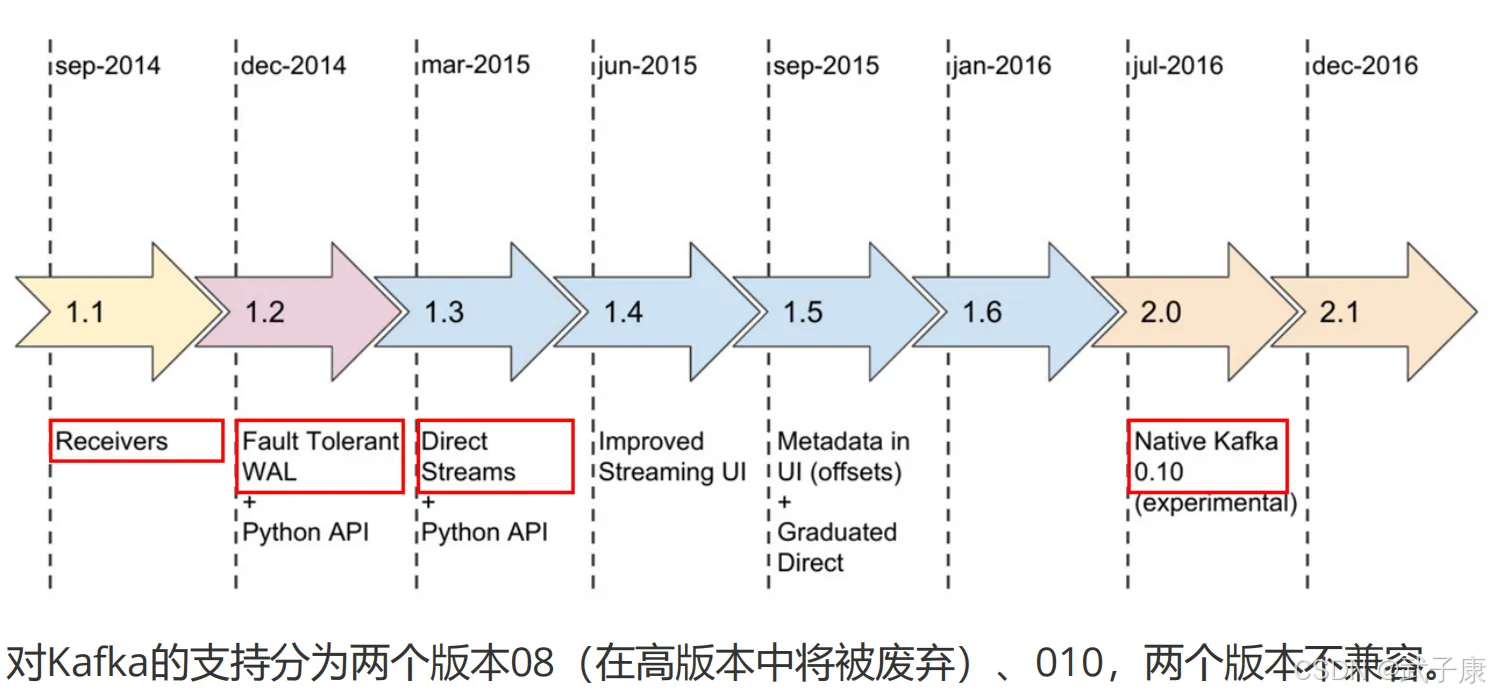

针对不同的Spark、Kafka版本,集成处理数据的方式有两种:

- Receiver Approach

- Direct Approach

对应的版本:

版本的发展:

Kafka-08 接口

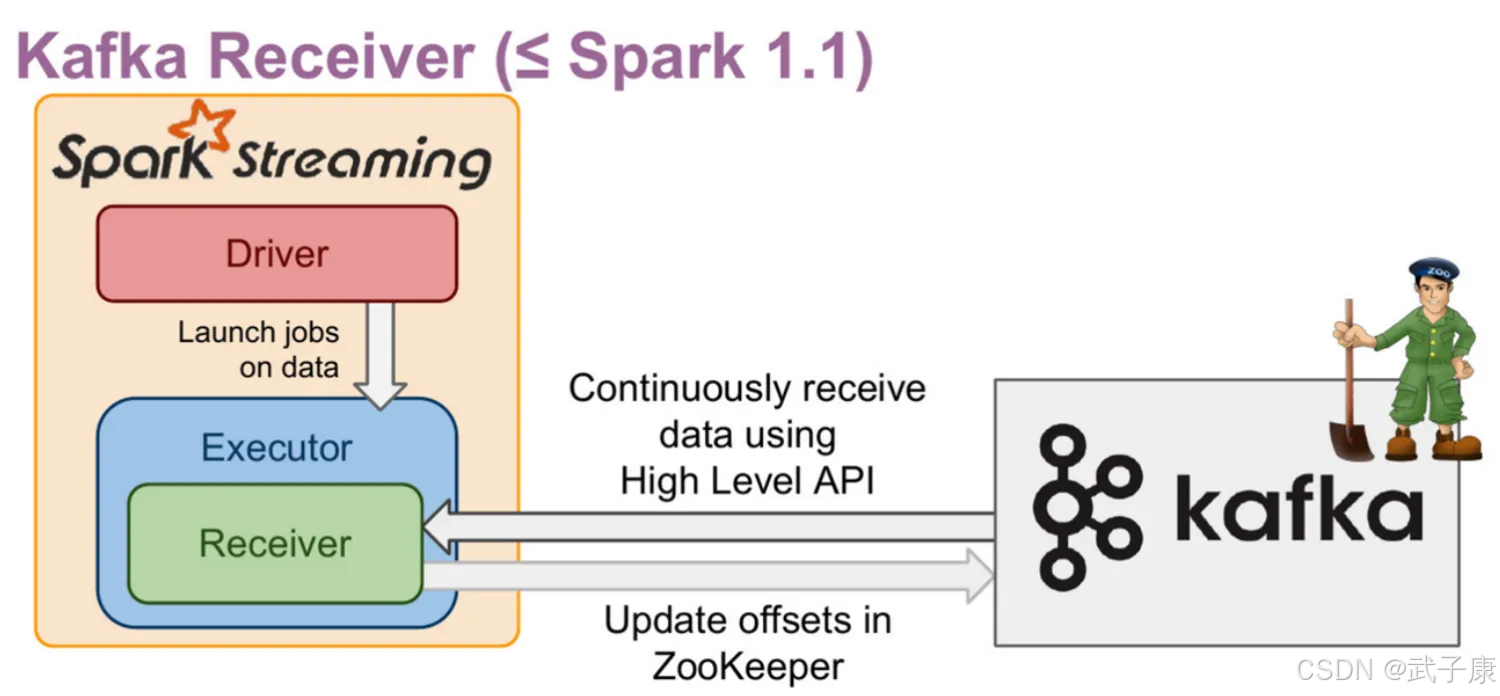

Receiver based Approach

基于 Receiver 的方式使用 Kafka 旧版本消费者高阶 API 实现。

对于所有的 Receiver,通过 Kafka 接收的数据被存储于 Spark 的 Executors 上,底层是写入 BlockManager中,默认200ms生成一个block(spark.streaming.blockInterval)

然后由SparkStreaming提交的Job构建BlockRDD,最终以SparkCore任务的形式运行。

对应Receiver方式,有以下几点需要注意:

- Receiver 作为一个常驻线程调度到Executor上运行,占用一个CPU

- Receiver 个数由 KafkaUtils.createStream 调用次数决定,一次一个Receiver

- Kafka 中的Topic分区并不能关联产生在 SparkStreaming中的RDD分区,增加在KafkaUtils.createStream() 中的指定的Topic分区数,仅仅增加了单个Receiver消费的Topic的线程数,它不会增加处理数据中的并行的Spark的数量。

- Receiver默认200ms生成一个Block,可根据数量大小调整Block生成周期,一个Block对应RDD一个分区

- Receiver接收的数据会放入到BlockManager,每个Executor都会有一个BlockManager实例,由于数据本地性,那些存在 Receiver的Executor会被调度执行更多的Task,就会导致某些Executor比较空闲

- 默认情况下,Receiver是可能丢数据的,可以通过设置spark.streaming.receiver.writeAheadLog.enable为true开启预写日志机制,将数据先写入一个可靠的分布式文件系统(HDFS),确保数据不丢失,但会损失一定的性能

Kafka-08接口(Receiver方式)

- Offset 保存在ZK中,系统管理

- 对应Kafka版本 0.8.2.1 +

- 接口底层实现使用Kafka旧版消费者 高阶API

- DStream底层实现为BlockRDD

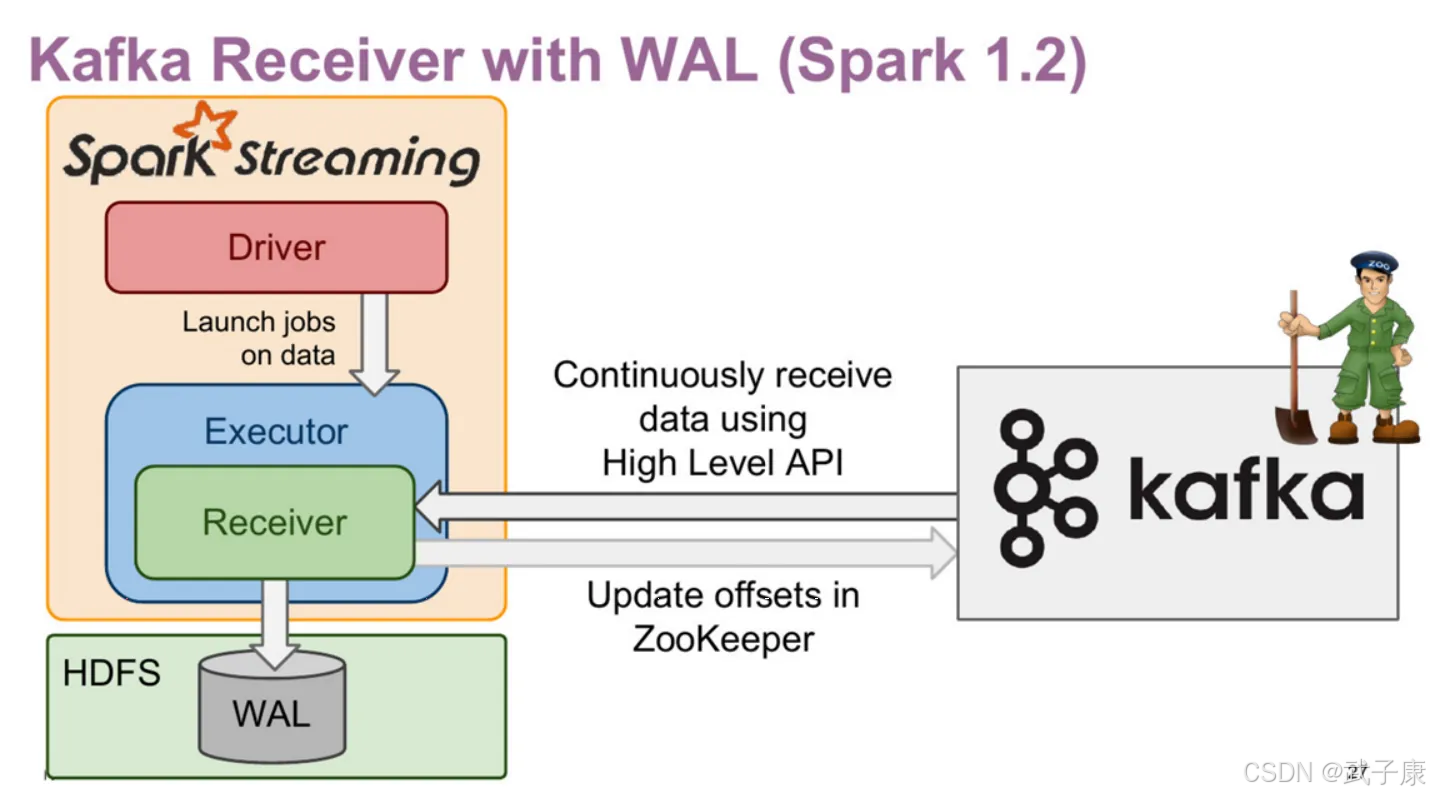

Kafka-08接口(Receiver with WAL)

- 增强了故障恢复的能力

- 接收的数据与Driver的元数据保存到HDFS

- 增加了流式应用处理的延迟

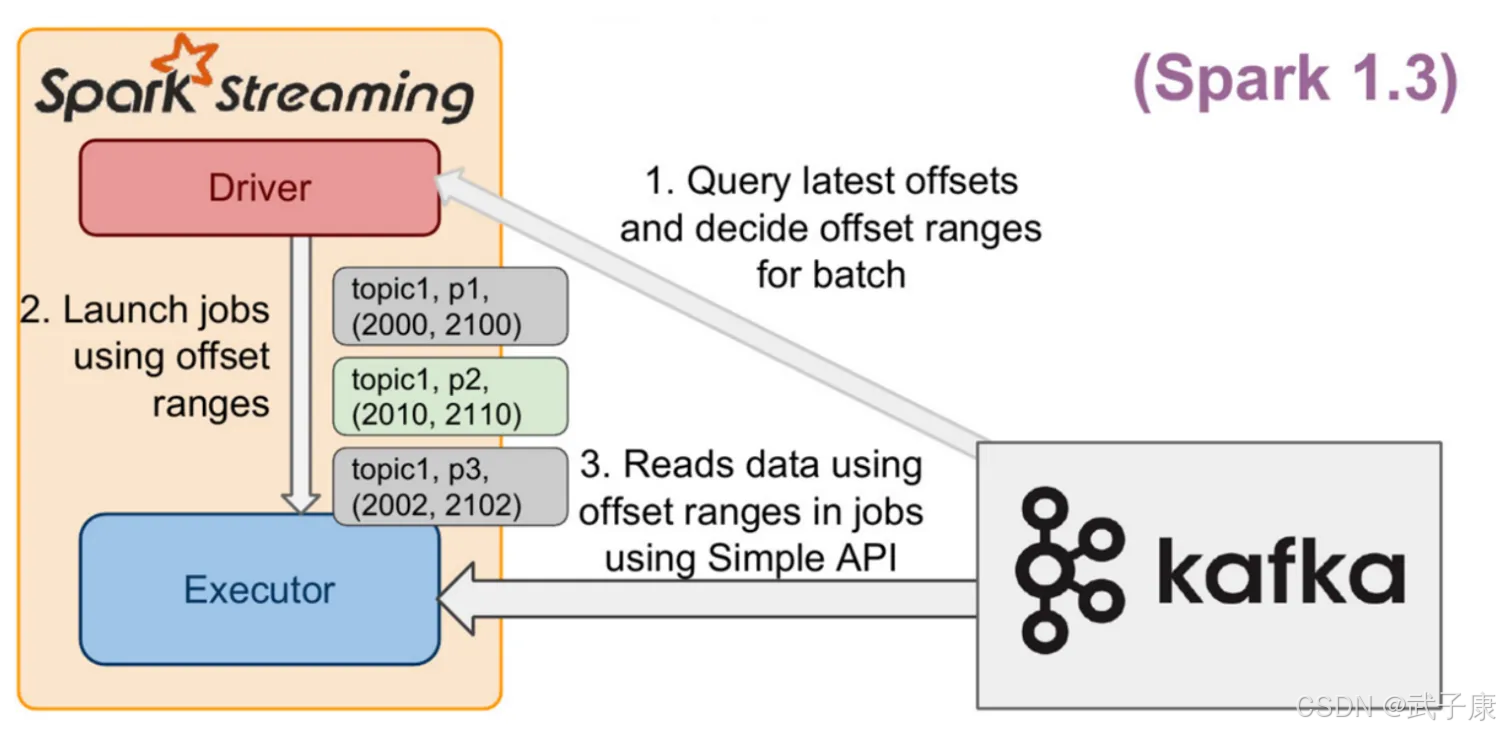

Direct Approach

Direct Approach 是 Spark Streaming 不使用 Receiver 集成 Kafka 的方式,在企业生产环境中使用较多,相较于 Receiver,有以下特点:

- 不使用 Receiver,减少不必要的CPU占用,减少了 Receiver接收数据写入BlockManager,然后运行时再通过 BlockId、网络传输、磁盘读取等来获取数据的整个过程,提升了效率,无需WAL,进一步减少磁盘IO

- Direct方式生的RDD是KafkaRDD,它的分区数与Kafka分区数保持一致,便于把控并行度。注意:在Shuffle 或 Repartition 操作后生成的 RDD,这种对应关系会失效

- 可以手动维护 Offset,实现 Exactly Once 语义

Kafka-10 接口

Spark Streaming 与 Kafka 0.10整合,和 0.8版本的Direct方式很像,Kafka的分区和Spark的RDD分区是一一对应的,可以获取 Offsets 和 元数据,API使用起来没有显著的区别。

添加依赖

不要手动添加 org.apache.kafka相关的依赖,如 kafka-clients,spark-streaming-kafka-0-10已经包含相关的依赖了,不同的版本会有不同程度的不兼容。

使用 kafka010接口从Kafka中获取数据:

- Kafka集群

- Kafka生产者发送数据

- Spark Streaming 程序接收数

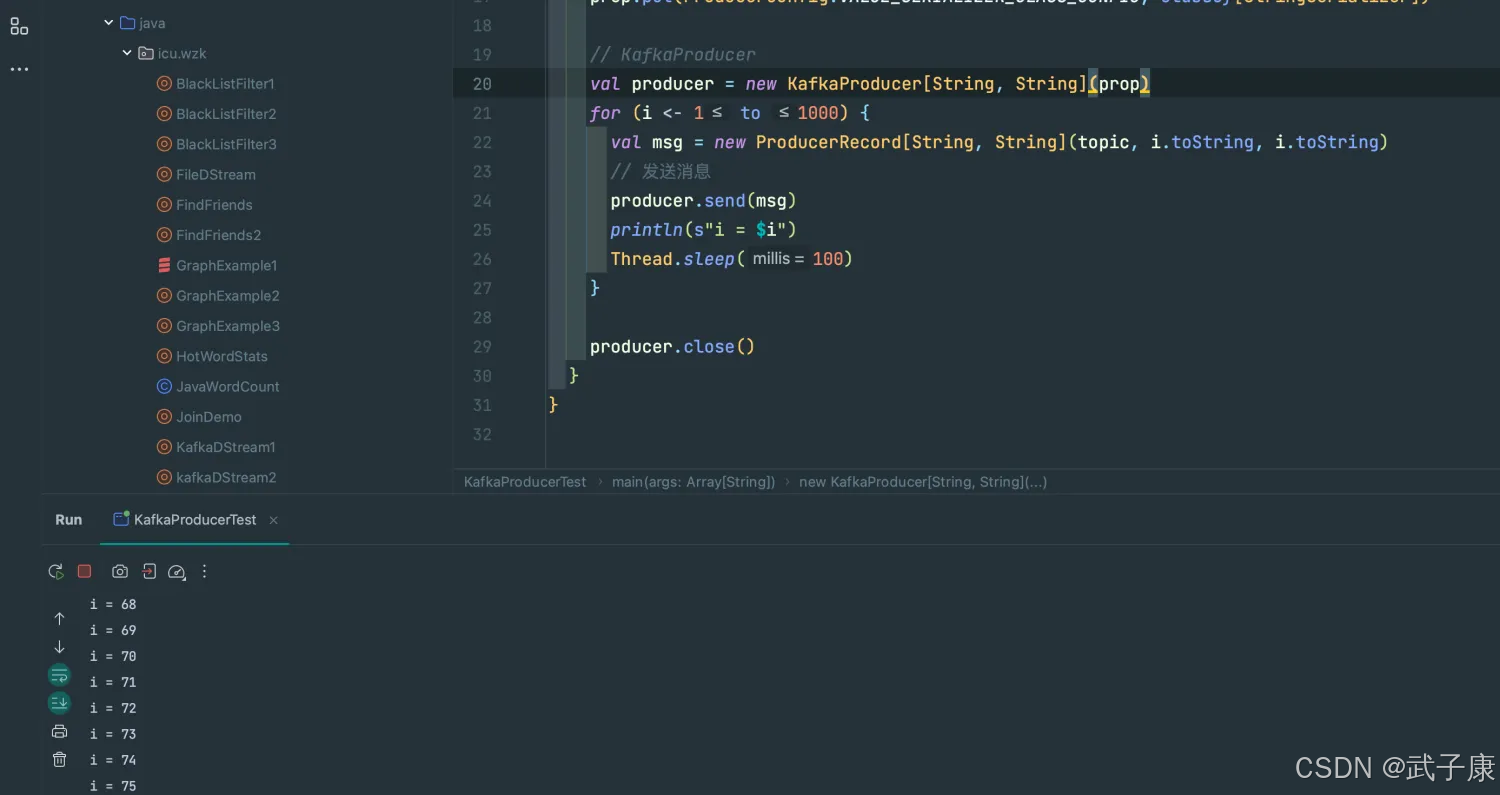

KafkaProducer

编写代码

运行测试

运行过程截图为:

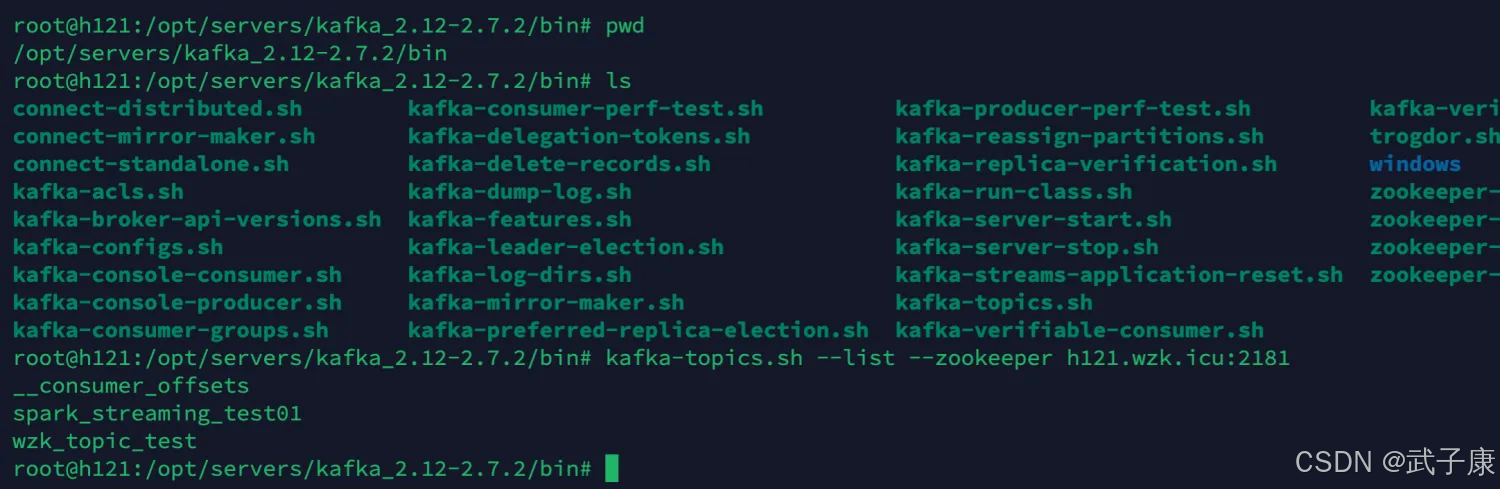

查看Kafka

我们在服务器上查看当前Kafka中的队列信息:

可以看到队列已经加入了,spark_streaming_test01:

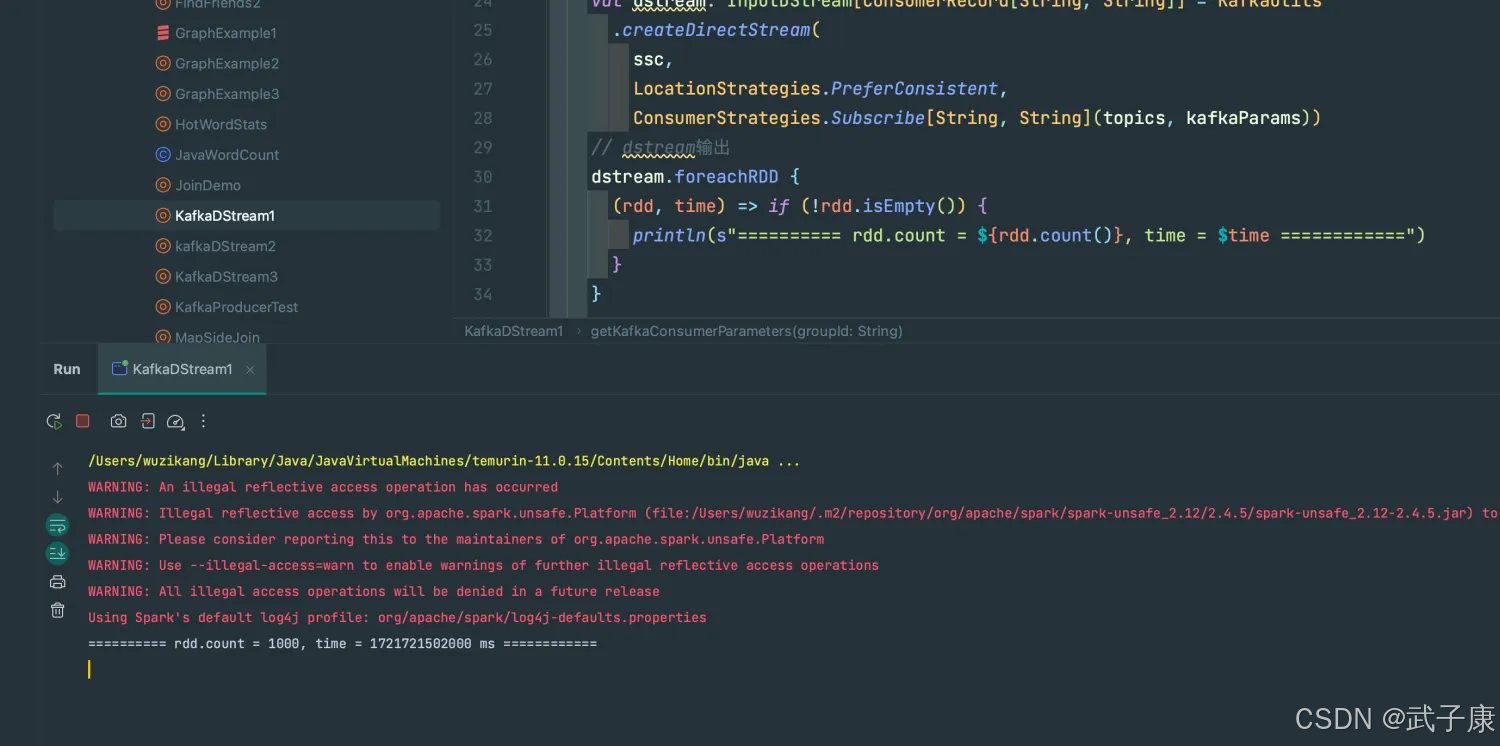

KafkaDStream

编写代码

运行结果

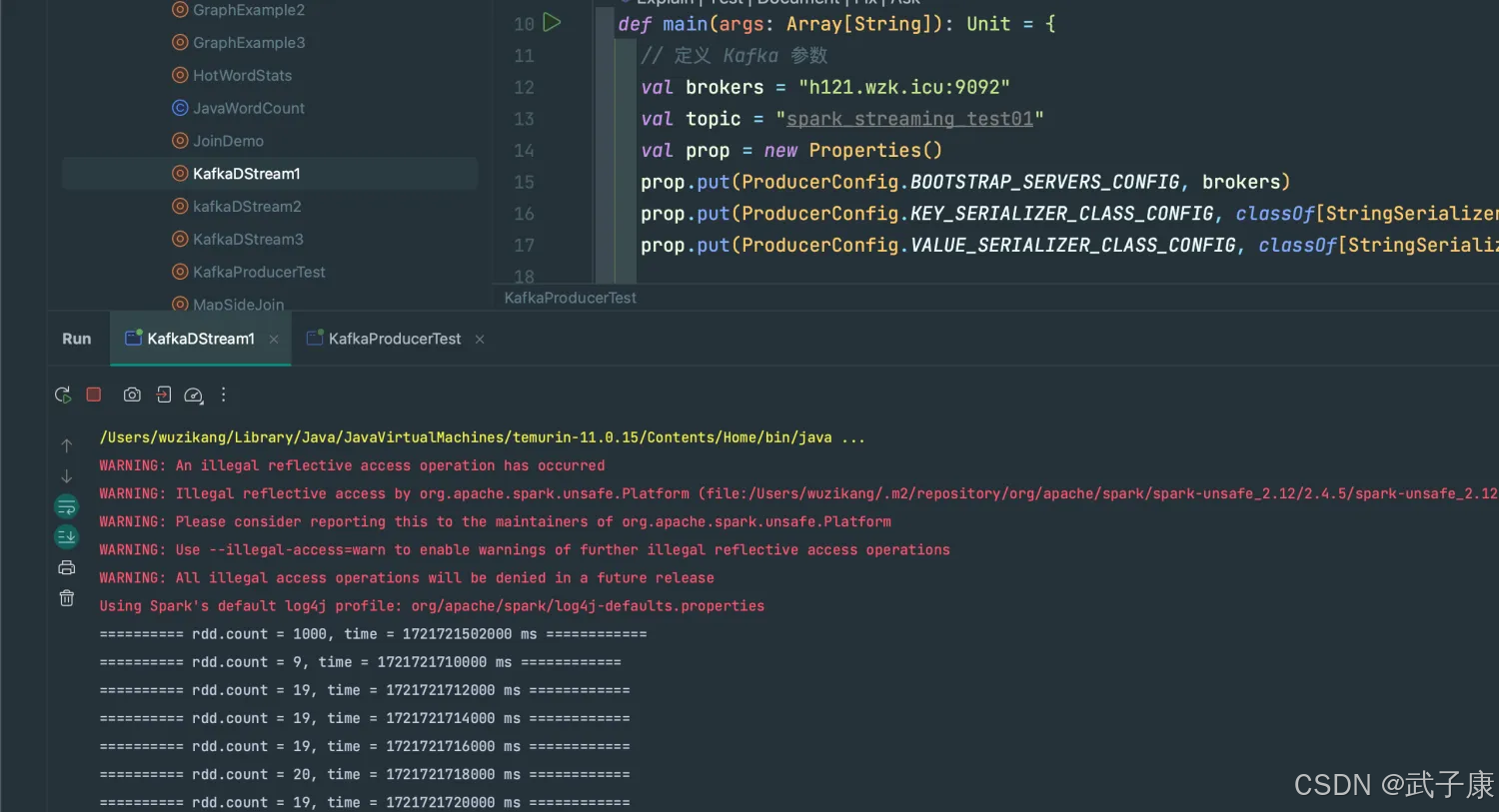

运行截图如下:

生成数据

继续启动 KafkaProducer 的程序,让数据不断地写入

我们会看到控制台输出内容如下:

运行结果如下图所示:

367

367

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?