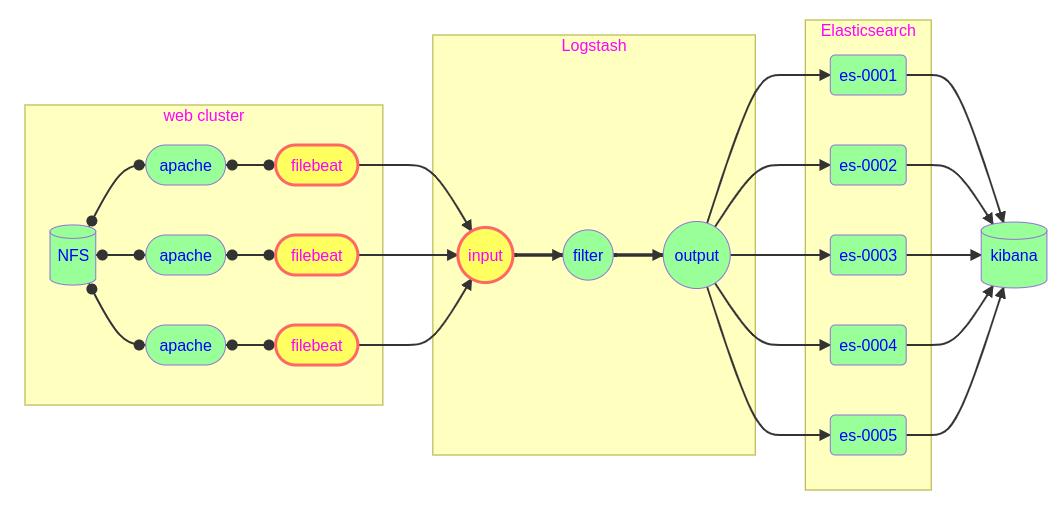

ELK:传统的ELK系统由Elasticsearch、Logstash、Kibana组成,由于Logstash由java语言开发的,占用资源巨大。Logstash的占用的资源甚至比Web服务本身消耗的资源还大,因此在每台web服务器上安装Logstash不合适。

ELFK: 后来在web服务器上部署filebeat日志采集程序,Logstash单独部署在服务器。filebeat由go语言开发,占用资源非常小。

filebeat 本质是一个agent,可以安装在应用服务器各个节点上,根据配置读取对应位置的日志文件,并通过网络上报道相应服务中。

EFK:Fluent软件由C语言开发,性能非常优秀,占用资源小,相当于替代了Logstash和filebeat的工作。

基本流程图

对于ELFK:Logstash使用beats插件接收filebeat的采集的数据

filebeat安装配置

配置Logstash服务器

安装kibana

833

833

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?