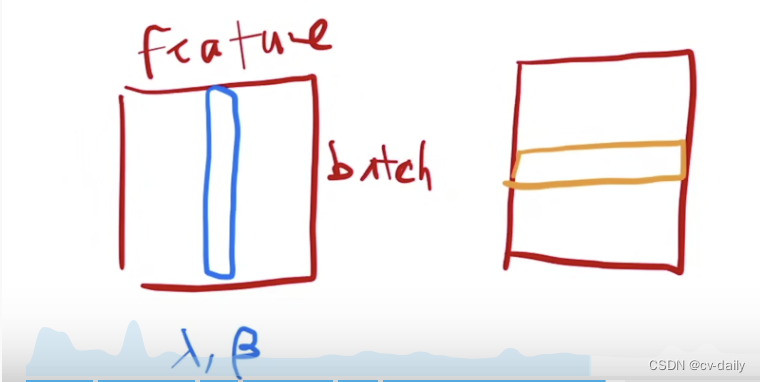

一、输入是二维数据

左侧是batchnorm,把每个特征计算均值方差,然后做归一化。

右侧是layernorm,把每个batch的数据计算均值和方差,然后归一化。可以理解为把数据转置之后做batchnorm,做完再转置回去。

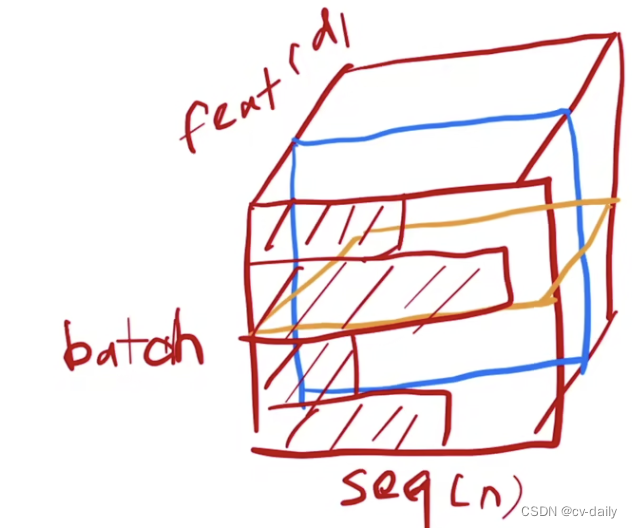

二、输入是三维

batchnorm是按照图中蓝色的切割,然后再去做归一化。

layernorm是按照图中黄色的切割,然后再去做归一化。

优缺点:在语音、翻译等领域,输入是不定长的。导致batchnorm,样本长度变化时,bn算的均值和方差抖动比较大。而且bn是在训练结束后存一个全局的均值和方差,预测时用。当预测的长度和训练时候长度差别较大时,bn效果较差。

layernorm没有这个缺点,因为layernorm是对每个样本计算的均值和方差,不需要保存一个全局均值方差。

batchnorm 和layernorm的区别

最新推荐文章于 2024-06-11 18:08:45 发布

4万+

4万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?