文章目录

摘要

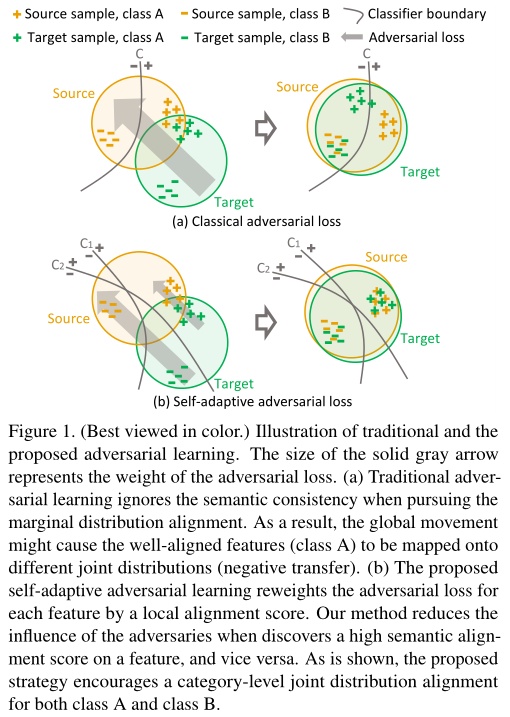

语义分割中的无监督域自适应问题的关键在于减少域偏移,即强制两个域的数据分布相似。常用的策略之一是通过对抗学习来对齐特征空间中的边缘分布。然而,这种全局对齐策略没有考虑类别级别的联合分布,这样源和目标之间最初很好对齐的一些类别可能被错误地映射,导致目标域中更差的分割结果。因此,作者引入了一个类级别的对抗网络,目的是在全局对齐过程中加强局部语义的一致性。作者的想法是研究类级别的联合分布,将每个类别与适应性对抗损失保持一致。具体来说,作者减少了类别级对齐特征的对抗损失的权重,同时增加了那些对齐不好的特征的对抗力量。在这个过程中,作者通过协同训练方法来决定一个特征在源和目标之间的类别级对齐情况。在领域自适应任务中,即GTA5和SYNTHIA中,验证了提出的方法在分割精度上符合当前的水平。

1.介绍

语义分割的目的是给照片中每个像素分配一个语义类标签,这样就需要像素级别的人工标注,成本太高。虽然可以通过计算机生成虚拟图像,获得标注数据,但是虚拟图像和现实图像间存在严重的视觉差异(域偏移),如纹理、光照、视角差异等等,这些差异导致在虚拟图像上训练出的深度模型往往在真实图像数据集上的分割精度很低。为了解决这一问题,通过域适应方法来弥合源域和目标域之间的差距。一种方法旨在对齐不同领域的特征分布,即最小化域之间的特征分布可以降低目标域上的误差上限。在这些域自适应方法中,一个共同且关键的步骤是最小化源和目标特征分布之间的距离度量。另一个流行的选择,借鉴了对抗性学习的思想,是最小化域预测的准确性。通过两个对抗网络之间的极小极大博弈,训练生成器产生混淆鉴别器的特征,而鉴别器需要正确地分类生成特征的域。

但是对抗性学习受到一个主要的限制:当生成网络完全骗过鉴别器时,仅对两个域特征的全局边界分布(即 P ( F s ) ≈ P ( F t ) P(F_s) \approx P(F_t) P(Fs)≈P(Ft),其中 F s F_s Fs和 F t F_t Ft表示潜在空间中源域和目标域的特征)进行对齐,而忽略了局部联合分布偏移,这与每个类别的语义一致性密切相关(即 P ( F s , Y s ) ≠ P ( F t , Y t ) P(F_s,Y_s) \neq P(F_t,Y_t) P(Fs,Ys)=P(Ft,Yt),其中 Y s , Y t Y_s,Y_t Ys,Yt分别表示特征的类别)。因此,对抗损失可能会导致那些在源域中已经与语义对应物很好对齐的目标域特征被映射到一个错误的语义类别(负迁移)。当在对抗损失上使用较大权重时,这种副作用会变得更加严重。

为了解决全局对抗学习的局限性,作者提出了一个类别级对抗网络(CLAN),它优先考虑类别级对齐,这自然会导致全局分布对齐。传统的对抗学习与本文中提出的对抗学习的对比如图1所示。CLAN的核心理念有两点:

(1)对于那些特性已经在源域和目标域之间很好地对齐的类,并保护这种类别级对齐不受对抗学习的副作用;

(2)识别特征在两个域间分布不同的类,并在训练过程中增加对抗损失的权重。

在这个过程中,作者使用协同训练,它可以使用两个不同的分类器进行置信预测,以预测每个特征在源和目标域之间的语义对齐程度。具体来说,如果两个分类器给出一致的预测,表明该特征是预测性的,并实现良好的语义对齐。在这种情况下,我们减少对抗损失的影响,以鼓励网络生成不变的特征可以保持域之间的语义一致性。相反,如果预测结果不一致,表明目标特征远没有被正确映射,则增加该特征上的对抗损失的权重,以加速对准。注意:

(1)我们的对抗学习方案直接作用于输出空间。该方法以输出预测为特征,共同促进分类器和提取器的优化;

(2)我们的方法不保证域之间的联合分布对齐严格。然而,与边缘分布对齐相比,我们的方法可以将目标特征更接近(或最坏没有负迁移)映射到相同类别的源特征。

主要贡献总结如下:

(1)通过提出对不同特征的对抗损失进行自适应加权,我们强调了类别级特征对齐在减少域偏移方面的重要性;

(2)在两个迁移学习任务上,我们的结果与最先进的UDA方法相同,即:GTA5→城市景观和SYNTHIA→城市景观。

2.相关工作

本节将重点讨论用于无监督领域适应的对抗学习和协同训练技术,这构成了我们方法的两个主要动机。

对抗学习。 适应损失受3个条件限制,源域上的期望损失、域发散以及理想联合假设在源域和目标域上的共享误差。由于第一项对应的是经过充分研究的监督学习问题,而第三项被认为是足够低的,可以达到准确的适应,所以近期大部分研究都把重点放在第2项上。对抗适应方法是这类方法的很好的例子,可以在不同的层次上进行研究。一些方法侧重于潜在的特征空间的分布偏移。在一个例子中,Hoffmanet等在对抗模型中添加了类别统计约束,旨在提高目标域的语义一致性。其他方法在像素水平上解决了适应问题,这与风格迁移方法有关,使图像跨域难以区分。还有研究了像素级域和特征级域的联合自适应问题。除了对底层特征层进行对齐外,Tsaiet等发现直接对输出空间进行对齐在语义分割中更有效。输出空间的域自适应使得预测和表示的联合优化成为可能,因此我们的方法利用了这一优势。

协同训练。 协同训练属于多视角学习,即学习者在未标记数据的两个具有置信标签的不同视角上交替训练。在UDA中,这种方法能够在目标域中对未标记的样本分配伪标签,可以直接测量,并最小化目标域中的分类损失。一般来说,协同训练使两个分类器的学习参数多样化,可以通过dropout、一致正则化或参数多样化等方式来实现。与协同训练类似,三体训练让两个分类器产生伪标签,并使用这些伪标签训练一个额外的分类器。Saikoet等除了给未标记的数据分配伪标签外,还使两个分类器在领域自适应方面的一致性最大化。

我们的工作没有遵循全局特征对齐或分类器一致性最大化的策略。相反,类别级特征对齐是通过协同训练实现的。据我们所知,我们在早期尝试根据局部对齐情况对分割任务中的特征对抗损失进行自适应加权。

3.方法

3.1. Problem Settings

作者关注语义分割中的无监督域自适应(UDA)问题,其中我们可以访问带有像素级标签 Y S Y_S YS的源数据 X S X_S XS和没有标签的目标数据 X T X_T XT。目标是学习一个模型 G G G能够正确预测目标数据的像素级标签 X T X_T XT。传统的基于对抗的网络(TAN)考虑了两个方面的域自适应。

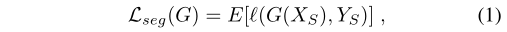

(1)首先,这些方法训练一个从标记数据中提取知识的模型 G G G,以最小化源域中的分割损失,该模型被形式化为一个全监督的问题:

其中 E [ ⋅ ] E[\cdot] E[⋅]表示统计期望, l ( ⋅ , ⋅ ) \mathcal{l}(\cdot,\cdot) l(⋅,⋅)是适当的损失函数,例如多类交叉熵。

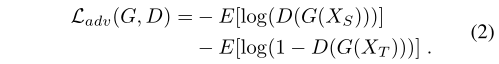

(2)其次,基于对抗的UDA方法还训练模型 G G G通过混淆能够区分源域和目标域样本的域判别器 D D D来学习域不变性特征。这一特性是通过最小化对抗损失来实现的:

然而,如上所述,传统的对抗学习方法有一个很大的局限性:即使在边缘分布完全对齐的情况下,也可能存在负迁移,导致来自不同领域但具有相同类别标签的样本在特征空间中映射得更远。在某些情况下,一些类已经在域间对齐,但在追求全局边缘分布对齐时,对抗性损失可能会解构现有的局部对齐。在本文中,我们将这种现象称为“缺乏语义一致性”,这是导致性能下降的一个重要原因。

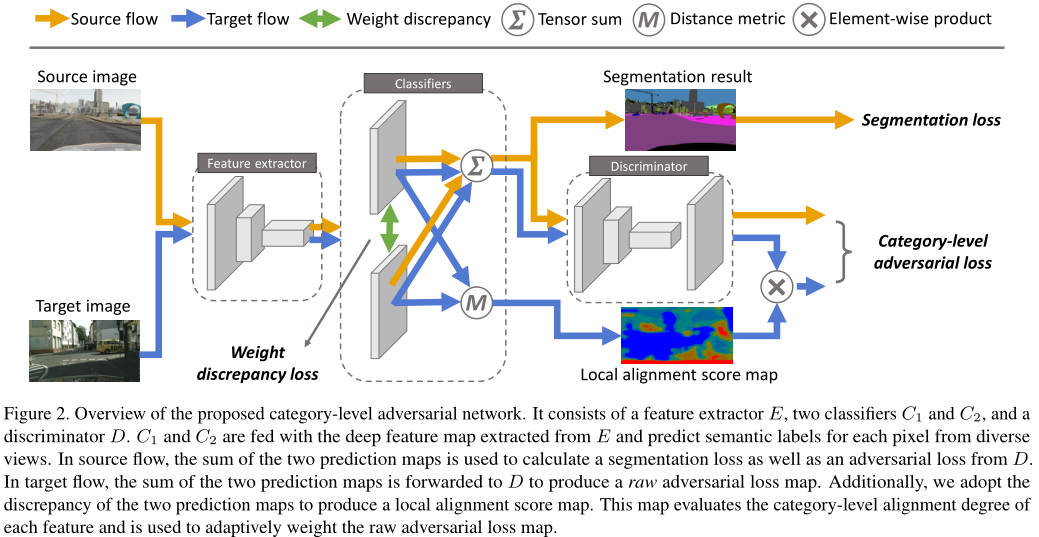

3.2. Network Architecture

我们的网络架构如图2所示。它由生成器 G G G和鉴别器 D D D组成。 G G G可以是任何基于FCN的分割网络, D D D是具有全卷积输出的基于CNN的二元分类器。在标准的协同训练算法中,生成器 G G G被分为特征提取器 E E E和两个分类器 C 1 C_1 C1和 C 2 C_2 C2。 E E E从输入图像中提取特征; C 1 C_1

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

3700

3700

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?