模型推理能耗优化的系统性技术框架

模型推理的能耗优化是AI技术可持续发展的核心挑战之一,需结合硬件、算法、系统架构等多维度手段,构建动态协同的能效管理体系。基于当前技术演进路径及工业实践,可归纳为以下六大类技术手段:

一、硬件层动态调节技术

1. 动态电压频率调整(DVFS)

- 原理:根据推理负载动态调节处理器电压与频率,在满足计算需求的前提下最小化功耗。

- 实验数据显示,DVFS可在性能损失<5%的条件下实现能耗降低20-40%。

- 实现路径:

\text{能效比} = \frac{\text{计算量}}{\text{功耗}} \propto \frac{f \cdot U_{\text{dd}}^2}{f \cdot U_{\text{dd}}^2} = \text{恒定}

通过卡尔曼滤波器预测未来计算负载,动态选择最优频率-电压对。

- 工业案例:

英伟达Ampere架构GPU支持动态频率缩放,推理任务下可节省15%能耗。

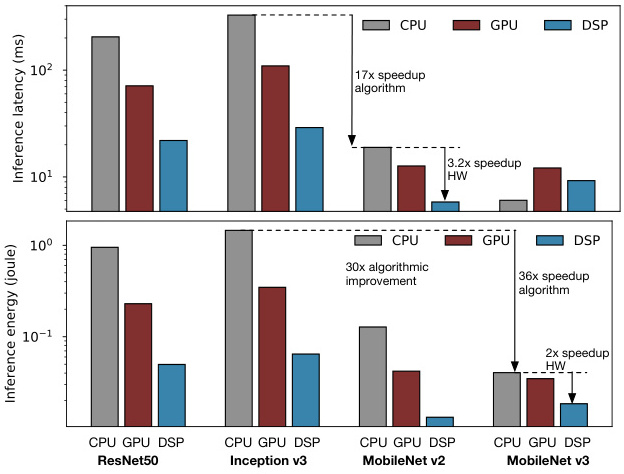

2. 异构计算加速

- 专用AI芯片:

谷歌TPU v4采用脉动阵列架构,推理能效比达CPU的30倍,延迟降低至1/10。 - 边缘芯片:

特斯拉FSD芯片集成稀疏计算单元,在自动驾驶场景下推理功耗较GPU降低50%。

二、算法层压缩与优化

1. 模型量化

-

技术细分:

- 低精度推理:将32位浮点模型转换为8位整型(INT8),在保持99%精度下减少75%内存占用和3倍计算加

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?