由于日后实习需要,新年假期在家里有空写了个抓取天mao评论的程序,并用python的snownlp模块进行简单的情感分析,由于本人刚接触python,项目可能有许多不足,请大家谅解!具体流程如下:

0. 主要流程

0. 数据采集

0. 目标网址获取

首先,获取自己要爬取的商品网页。如图:

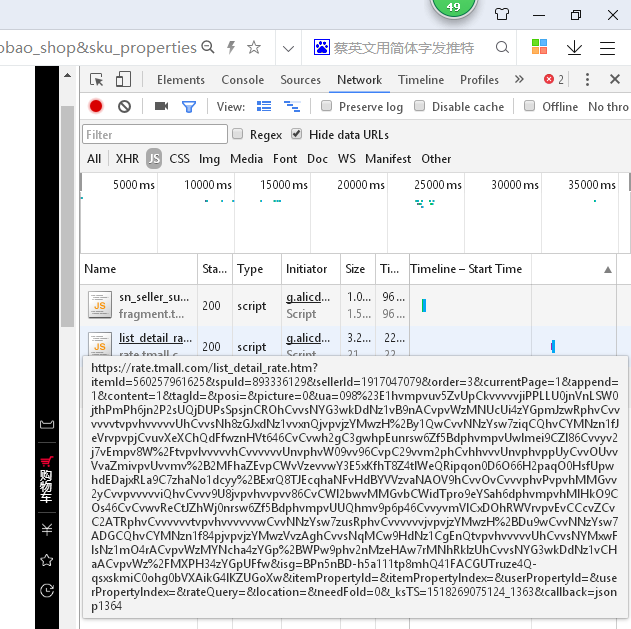

这里用iPhone x的商品做样例(博主目前使用的手机是小米3,穷鬼啊有没有!)。因为加载评论的页面用js封装起来了。因此需要用到浏览器开发者工具获取保存评论的页面,直接按F12打开。如图:

在NETwork//js目录下有一个形如上图的网址(巨长无比呀),细心发现会有一个page=1的字段,这个是控制不同页数的关键字!因此我们只需要改变page的值就能爬取不同页面的内容了!!具体代码如下:

# -*- coding: utf-8 -*-

import urllib.request

import json

import time

import re

import pymysql

def find_mes

本文介绍了作者作为爬虫新手,如何使用Python3爬取天猫商品评论,并通过snownlp模块进行情感分析。主要流程包括数据采集,通过获取目标网址,利用正则表达式解析JSON数据,再用json.loads转换为字典。在数据采集过程中,遇到了天猫的安全系统securitymatrix,采取了设置延时的方法降低页面丢失率。文章最后提到,爬虫框架还考虑过selenium和scrapy,但最终选择了request库实现。

本文介绍了作者作为爬虫新手,如何使用Python3爬取天猫商品评论,并通过snownlp模块进行情感分析。主要流程包括数据采集,通过获取目标网址,利用正则表达式解析JSON数据,再用json.loads转换为字典。在数据采集过程中,遇到了天猫的安全系统securitymatrix,采取了设置延时的方法降低页面丢失率。文章最后提到,爬虫框架还考虑过selenium和scrapy,但最终选择了request库实现。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

5259

5259

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?