一、机器学习定义

1、机器学习定义(ARTHUR SAMUEL定义)

1959年,ARTHUR SAMUEL给出的定义是:

(1)显著式的编程

开始前先告诉一些规律给计算机,随后计算机只要看到符合这些特征便把东西识别成已知的东西。

比如:告诉计算机玫瑰是红色的,菊花是黄色的,之后只要看到是红色的就当作玫瑰,而不去判断其他的

注:

- 显著式编程:定死了程序的输入和输出,所以识别率不会随着训练样本的增加而提高的。

- 事先需要帮助计算机调查好所需要的内容(比如路径规划),有这时间人就去做了

(2)非显著式的编程

计算机通过已有的输入自己去总结某种事物的规律。也即:我们事先并不约束计算机必须总结出什么规律,而是让计算机搭载我们写的程序自己去总结规律

注:ARTHUR SAMUEL说的机器学习正是这种非显著式的编程

(3)收益函数

计算机在规定的环境下,通过做某些事情所带来的收益(经验),因某事情出错,规定收益为负,成功完成某事收益为正。

2、Tom Mitshell给出的定义

一个计算机程序被称为可以学习,是指它能针对某个任务T和某个性能指标P,从经验E中学习。这种学习的特点是:它在T上的被P所衡量的性能,会随着经验E的增加而提高。

注:E越多,也即识别率会相应的增加(非显著性编程)

3、ARTHUR SAMUEL定义与Tom Mitshell定义的比较

Tom Mitshell的定义更加数学化,其中提到的经验E增加提高性能指标其实就是最优化问题,在数学中的求解最优化问题的思路都可以应用到这里。数学在机器学习中起到至关重要的作用。

注:经验E和性能指标P是由设计算法的人来指定的,不是确定的。

机器学习致力于研究如何通过计算的手段,利用经验来改善系统自身的性能的学科。

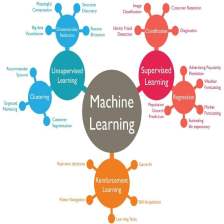

二、机器学习的分类

根据任务是否需要和环境交互获得经验,来把机器学习分为:监督学习和强化学习

下列四个案例中,(1)(4)属于一类,(2)(3)属于一类,划分的标准为:经验E的获取途径

(2)(3)中是否是垃圾邮件、是否识别正确人脸,其实是人为的先准备好很多数据提供给电脑,也即:所有的经验E都是由人工采集,对数据进行打标签,完了输入到计算机的,这种学习成为监督学习(Supervised Learning)

(1)(4)是由计算机和周围环境进行交互来获取经验E的,例如下棋时赢了就奖励,输了就惩罚。同时,我们需要设计算法让计算机通过改变自己的行为模式来最大化收益函数的学习,称为:强化学习(Reinforcement Learning)

按照任务性质的不同,机器学习可以分为:监督学习 和 强化学习

1、监督学习的分类(根据标签存在与否)

(1)传统的监督学习

也即:每一个训练数据都有对应的标签,包括算法如下:

(2)非监督学习

所有的训练数据都没有对应的标签

(3)半监督学习

一组数据中一部分有标签,一部分没标签

2、监督学习分类(基于标签的固有属性<是离散的还是连续的>)

注:分类和回归区分其实是很模糊的

三、机器学习算法的过程

- 提取特征(Feature Extraction)<不是机器学习的重点,但是对整体处理很重要>

- 特征选择(Feature Selection)

- 不同的算法对特征空间做不同的划分,获得不同的结果

注:机器学习的重点是:假设在已经提取好特征的前提下,如何构造算法获得更好的性能

本文介绍了机器学习的定义,包括ARTHURSAMUEL和TomMitshell的两种观点,并对比了两者之间的差异。机器学习被分为监督学习和强化学习,前者如垃圾邮件识别,后者如棋类游戏中的学习。此外,讨论了监督学习的分类和算法过程,强调了特征提取和假设构造的重要性。最后提到了没有免费的午餐定理,表明在机器学习中没有通用的最佳算法。

本文介绍了机器学习的定义,包括ARTHURSAMUEL和TomMitshell的两种观点,并对比了两者之间的差异。机器学习被分为监督学习和强化学习,前者如垃圾邮件识别,后者如棋类游戏中的学习。此外,讨论了监督学习的分类和算法过程,强调了特征提取和假设构造的重要性。最后提到了没有免费的午餐定理,表明在机器学习中没有通用的最佳算法。

413

413

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?