简介:本项目展示了如何利用Python和OpenCV库构建全景图像拼接系统。该系统通过合并多个图像来创建宽视场图像,广泛应用于旅游、摄影等领域。Python因其丰富的图像处理库而成为主要开发语言,而OpenCV提供的算法支持了图像的预处理、特征匹配、变换和融合等关键步骤。通过本项目,开发者可以深入学习图像处理和计算机视觉的基础知识,并有机会将系统扩展到更高级的应用。

1. Python在图像处理中的应用

在当今技术飞速发展的时代,图像处理已经成为一门极其重要的技术领域,而Python作为一门高效、简洁、易学易用的编程语言,在图像处理领域展现出了强大的生命力和潜力。Python在图像处理上的应用,不仅仅是简单地实现图像的读取、显示和保存,更重要的是,Python拥有丰富的图像处理库生态系统,如OpenCV、PIL、NumPy等,使得Python在图像处理的各个方面,包括图像识别、图像增强、图像分析等,都表现出了卓越的能力。

Python在图像处理中的优势主要体现在它的简洁性、高效性以及强大的库生态系统。Python的简洁性使得图像处理的代码易于编写和理解,提高了开发效率;Python的高效性则体现在其背后强大的算法库和高效的运行环境,使得图像处理的执行速度更快;Python强大的库生态系统为图像处理提供了丰富的功能,几乎涵盖了图像处理的所有方面。

在Python环境和库的配置上,我们需要安装Python解释器,并通过pip安装图像处理相关的库,如OpenCV等。在安装过程中,我们需要根据开发环境选择合适的Python版本和库版本,以保证后续章节中代码的顺利执行。

总的来说,Python在图像处理中的应用广泛,优势明显,适合各种复杂度的图像处理任务。通过本章的介绍,相信读者对Python在图像处理中的应用有了初步的认识,为后续章节的深入学习打下了基础。

2. OpenCV库及全景图像拼接简介

2.1 OpenCV基础及功能概述

2.1.1 OpenCV的安装和配置

OpenCV(Open Source Computer Vision Library)是一个开源的计算机视觉和机器学习软件库,由一系列 C++ 函数和少量 C 函数构成,实现了图像处理和计算机视觉方面的很多通用算法。在图像拼接过程中,OpenCV提供了强大的支持,包括但不限于图像读取、处理、特征检测与匹配、变换、融合等。

对于Python用户来说,安装OpenCV库非常简单,可以通过pip进行安装:

pip install opencv-python

或者安装包含Python、C++、Java等语言接口的完整版本:

pip install opencv-contrib-python

在安装完成后,可以通过简单的Python代码进行验证:

import cv2

print(cv2.__version__)

输出版本号表明安装成功。

2.1.2 OpenCV的核心功能模块

OpenCV库的核心功能模块众多,其中对图像处理至关重要的几个模块包括:

-

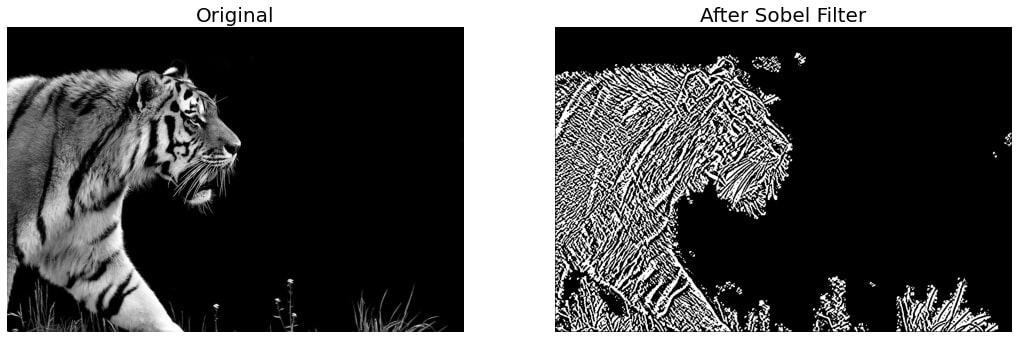

imgproc模块:包含基本的图像处理函数,如滤波、形态学操作、颜色空间转换等。 -

features2d模块:用于特征检测和描述,如SIFT、SURF、ORB等。 -

calib3d模块:包含三维重建及单应性矩阵的计算。 -

video模块:处理视频序列,如运动分析、背景减除等。

熟悉这些模块对于在图像处理和全景图像拼接中的应用至关重要。

2.2 全景图像拼接概念与应用场景

2.2.1 全景图像拼接的技术原理

全景图像拼接是一种将多张重叠的图片合成为一个宽视野的连续视图的技术。在技术上,全景图像拼接分为以下步骤:

- 图像特征检测与匹配 :在每张图像中检测出关键特征点,并在不同图像之间找到匹配的特征点。

- 估计单应性矩阵 :利用匹配的特征点估计图像之间的几何变换。

- 图像变换与校正 :对图像进行几何变换,使重叠区域对齐。

- 图像融合 :将变换后的图像合成一个平滑无缝的全景图像。

2.2.2 全景图像拼接的实际应用案例

全景图像拼接技术在众多领域有着广泛的应用。例如,在房地产行业,可以用来创建房屋的360度全景视图;在旅游领域,可以提供景点的沉浸式体验;在自动驾驶车辆中,全景图像可以提供四周的视觉信息,增强车辆的感知能力。

由于全景图像拼接可以将多个图像融合成一个连续的图像,它在增强视觉体验方面具有巨大潜力。不过,实现高质量的全景拼接仍然需要处理很多技术挑战,如图像对齐的精确性、拼接接缝的平滑处理以及最终图像的亮度一致性等。

以上就是第二章的内容,它为理解全景图像拼接技术奠定了基础,并介绍了OpenCV这一强大的图像处理工具。在接下来的章节中,我们将深入探讨图像处理的各个步骤以及如何利用OpenCV进行全景图像的拼接和优化。

3. 图像预处理步骤

在图像处理中,预处理是一个至关重要的步骤,它直接影响到最终处理效果的质量和效率。本章节将详细讨论图像预处理的基本步骤,包括图像的读取、显示、保存,以及图像缩放、裁剪和直方图均衡化处理。通过对这些技术的深入分析,读者将能够掌握图像预处理的核心概念和技术细节。

3.1 图像的读取、显示与保存

3.1.1 使用OpenCV读取图像文件

在使用OpenCV进行图像预处理之前,首先需要安装OpenCV库,然后通过Python代码读取图像文件。下面是读取图像文件的基础代码示例:

import cv2

# 读取图像文件

image = cv2.imread('example.jpg')

# 检查图像是否正确读取

if image is not None:

print("图像成功读取")

else:

print("图像读取失败,请检查文件路径")

在这段代码中, cv2.imread 函数用于读取图像文件,其参数是图像文件的路径。如果图像文件读取成功,函数会返回一个包含图像数据的数组;如果读取失败,将返回 None 。

3.1.2 图像的基本显示与保存方法

读取图像后,我们通常需要对图像进行查看和保存。以下展示了如何使用OpenCV显示和保存图像:

import cv2

# 读取图像

image = cv2.imread('example.jpg')

# 显示图像

cv2.imshow('Image', image)

cv2.waitKey(0) # 等待直到任意键被按下

# 保存图像

cv2.imwrite('output.jpg', image)

这段代码首先读取名为 'example.jpg' 的图像文件,然后使用 cv2.imshow 函数显示图像,并通过 cv2.waitKey(0) 函数等待用户按键,最后使用 cv2.imwrite 函数将处理后的图像保存为 'output.jpg'。这里 cv2.waitKey(0) 中的 0 参数表示无限等待,直到用户按下任意键。

3.2 图像缩放与裁剪技术

3.2.1 缩放算法的选择与应用

图像缩放是指改变图像的尺寸。在OpenCV中, cv2.resize 函数可以实现图像缩放。以下是缩放图像的一个例子:

import cv2

# 读取图像

image = cv2.imread('example.jpg')

# 获取图像的尺寸

height, width = image.shape[:2]

# 设置缩放比例

scale_percent = 50 # 缩放至原来的50%

new_height = int(height * scale_percent / 100)

new_width = int(width * scale_percent / 100)

# 对图像进行缩放

resized = cv2.resize(image, (new_width, new_height), interpolation=cv2.INTER_AREA)

# 保存缩放后的图像

cv2.imwrite('resized.jpg', resized)

在这段代码中,我们首先读取一个图像,然后计算新的高度和宽度,并通过 cv2.resize 函数对图像进行缩放。其中 interpolation=cv2.INTER_AREA 参数用于图像缩小操作,它可以在缩小图像时获得更好的图像质量。

3.2.2 图像裁剪的实战技巧

图像裁剪是指从原始图像中选取一部分区域并将其作为新图像的过程。下面的代码演示了如何使用OpenCV进行图像裁剪:

import cv2

# 读取图像

image = cv2.imread('example.jpg')

# 定义裁剪区域(左上角和右下角坐标)

x1, y1 = 200, 100 # 左上角坐标

x2, y2 = 400, 400 # 右下角坐标

# 裁剪图像

cropped = image[y1:y2, x1:x2]

# 显示裁剪后的图像

cv2.imshow('Cropped Image', cropped)

cv2.waitKey(0)

cv2.destroyAllWindows()

# 保存裁剪后的图像

cv2.imwrite('cropped.jpg', cropped)

在这段代码中,我们首先定义裁剪区域的坐标,然后使用这些坐标来选取原图中的一个子区域,最后显示和保存裁剪后的图像。

3.3 图像直方图均衡化处理

3.3.1 直方图均衡化的理论基础

图像直方图均衡化是一种增强图像对比度的方法,通过拉伸图像的直方图,使得其分布更加均匀,从而改善图像的整体亮度和对比度。在OpenCV中, cv2.equalizeHist 函数可以实现直方图均衡化。

3.3.2 实现图像亮度和对比度的改善

下面的代码展示了如何使用OpenCV进行图像的直方图均衡化:

import cv2

import numpy as np

# 读取图像

image = cv2.imread('example.jpg', cv2.IMREAD_GRAYSCALE)

# 应用直方图均衡化

equalized_image = cv2.equalizeHist(image)

# 计算原图和均衡化后图像的直方图

hist_original = cv2.calcHist([image], [0], None, [256], [0, 256])

hist_equalized = cv2.calcHist([equalized_image], [0], None, [256], [0, 256])

# 显示原图和均衡化后的图像

cv2.imshow('Original Image', image)

cv2.imshow('Equalized Image', equalized_image)

# 等待按键后关闭窗口

cv2.waitKey(0)

cv2.destroyAllWindows()

# 保存均衡化后的图像

cv2.imwrite('equalized.jpg', equalized_image)

在这段代码中,首先使用 cv2.imread 函数以灰度模式读取图像,然后通过 cv2.equalizeHist 对图像进行均衡化处理。通过 cv2.calcHist 函数,我们计算并展示了原始图像和均衡化后图像的直方图,以观察均衡化对图像直方图的影响。

以上内容涵盖了图像预处理的重要步骤,包括读取、显示、保存、缩放、裁剪和直方图均衡化处理,通过实例代码详细介绍了操作的具体方法和优化策略。在实际的图像处理项目中,这些预处理技术是确保高质量输出的关键步骤,对提升图像处理效率和效果都起着至关重要的作用。

4. 特征检测与匹配技术

4.1 特征检测技术概述

4.1.1 特征检测的重要性与应用场景

特征检测是图像处理和计算机视觉中的核心概念,它涉及从图像中提取出有意义的局部信息点,这些信息点在图像中位置固定,对旋转、缩放、亮度变化等具有一定的不变性。这些特征点对于图像之间的匹配、识别和拼接至关重要。特征检测在多个领域有着广泛的应用,如物体识别、场景重建、图像拼接以及视觉跟踪等。

4.1.2 特征检测技术的比较与选择

目前,存在多种特征检测技术,包括但不限于SIFT(尺度不变特征变换)、SURF(加速稳健特征)、ORB(Oriented FAST and Rotated BRIEF)等。每种技术都有其独特的优点和局限性。例如,SIFT在图像旋转和缩放方面表现稳定,但计算成本较高;SURF在SIFT的基础上做了优化,速度更快,但对光照变化敏感;ORB是一种基于FAST角点检测器和BRIEF描述子的二进制描述符,它在速度上更有优势,但对旋转的鲁棒性较弱。在选择特征检测技术时,需要根据应用的具体需求来进行权衡。

4.2 SIFT特征检测技术详解

4.2.1 SIFT算法原理与步骤

SIFT算法由David Lowe在1999年提出,是图像处理中非常经典的一种特征检测算法。它的关键步骤包括尺度空间的构建、关键点的检测、特征描述子的生成和特征向量的匹配。尺度空间的构建是为了检测到在不同尺度下稳定的特征点,关键点检测是通过寻找尺度空间极值点来完成,特征描述子的生成则是为了描述关键点周围的特征信息,最后通过特征向量的匹配来实现特征点的对齐。

import cv2

import numpy as np

# 读取图像

image = cv2.imread('image.jpg', 0)

# 初始化SIFT检测器

sift = cv2.SIFT_create()

# 寻找关键点和描述子

keypoints, descriptors = sift.detectAndCompute(image, None)

# 画出关键点

cv_keypoints = [cv2.KeyPoint(x=pt.pt[0], y=pt.pt[1], _size=pt.size, _angle=pt.angle, _response=pt.response, _octave=pt.octave, _class_id=pt.class_id) for pt in keypoints]

img_keypoints = cv2.drawKeypoints(image, cv_keypoints, None)

# 显示图像

cv2.imshow('SIFT Features', img_keypoints)

cv2.waitKey(0)

cv2.destroyAllWindows()

4.2.2 在全景图像拼接中的应用实例

在全景图像拼接中,SIFT用于检测多张图像中的关键点,并找出这些关键点之间的对应关系。这些对应关系可以用于估计图像之间的几何变换关系。以下是一个应用实例,展示了如何使用SIFT进行图像拼接。

def stitch_images(image1, image2):

# 创建SIFT检测器

sift = cv2.SIFT_create()

# 寻找关键点和描述子

kp1, des1 = sift.detectAndCompute(image1, None)

kp2, des2 = sift.detectAndCompute(image2, None)

# 创建BF匹配器

bf = cv2.BFMatcher()

# 进行匹配

matches = bf.knnMatch(des1, des2, k=2)

# 筛选好的匹配点

good_matches = []

for m, n in matches:

if m.distance < 0.75*n.distance:

good_matches.append(m)

# 提取匹配点的坐标

src_pts = np.float32([kp1[m.queryIdx].pt for m in good_matches]).reshape(-1, 1, 2)

dst_pts = np.float32([kp2[m.trainIdx].pt for m in good_matches]).reshape(-1, 1, 2)

# 估计变换矩阵

M, mask = cv2.findHomography(src_pts, dst_pts, cv2.RANSAC, 5.0)

# 获取图像的尺寸

h1, w1 = image1.shape[:2]

h2, w2 = image2.shape[:2]

# 获取图片点的坐标

pts = np.float32([[0, 0], [0, h1], [w1, h1], [w1, 0]]).reshape(-1, 1, 2)

dst = cv2.perspectiveTransform(pts, M)

# 计算拼接后的图像尺寸

result = cv2.addWeighted(image1, 0.5, image2, 0.5, 0)

result = result.astype(np.uint8)

dst = dst.reshape(-1, 2)

result = cv2.polylines(result, [dst.astype(np.int32)], True, 255, 3, cv2.LINE_AA)

return result

4.3 SURF特征检测技术详解

4.3.1 SURF算法原理与步骤

SURF算法是一种基于SIFT的改进算法,它在速度上进行了优化,并且在保持了相似的旋转和尺度不变性的同时,显著提高了特征检测和描述的速度。SURF通过使用积分图来加快计算速度,使用Hessian矩阵的行列式来确定关键点,然后通过计算关键点周围的Haar小波响应来构建特征描述子。

4.3.2 在全景图像拼接中的应用实例

在全景图像拼接中,SURF同样用于检测和匹配图像中的关键点。以下是SURF在图像拼接中的应用实例。

def surf_stitch(image1, image2):

# 初始化SURF检测器

surf = cv2.xfeatures2d.SURF_create()

# 寻找关键点和描述子

kp1, des1 = surf.detectAndCompute(image1, None)

kp2, des2 = surf.detectAndCompute(image2, None)

# 创建BF匹配器

bf = cv2.BFMatcher(cv2.NORM_L2, crossCheck=True)

# 进行匹配

matches = bf.match(des1, des2)

# 按照距离排序

matches = sorted(matches, key=lambda x: x.distance)

# 提取匹配点的坐标

src_pts = np.float32([kp1[m.queryIdx].pt for m in matches]).reshape(-1, 1, 2)

dst_pts = np.float32([kp2[m.trainIdx].pt for m in matches]).reshape(-1, 1, 2)

# 估计变换矩阵

M, mask = cv2.findHomography(src_pts, dst_pts, cv2.RANSAC, 5.0)

# 获取图像的尺寸

h1, w1 = image1.shape[:2]

h2, w2 = image2.shape[:2]

# 获取图片点的坐标

pts = np.float32([[0, 0], [0, h1], [w1, h1], [w1, 0]]).reshape(-1, 1, 2)

dst = cv2.perspectiveTransform(pts, M)

# 计算拼接后的图像尺寸

result = cv2.addWeighted(image1, 0.5, image2, 0.5, 0)

result = result.astype(np.uint8)

dst = dst.reshape(-1, 2)

result = cv2.polylines(result, [dst.astype(np.int32)], True, 255, 3, cv2.LINE_AA)

return result

通过本章节的介绍,我们了解了特征检测技术的重要性、应用场景、技术选择、SIFT和SURF技术的原理以及在全景图像拼接中的应用实例。特征检测为图像处理提供了丰富的局部信息,是实现复杂图像处理任务的基础。接下来的章节将深入探讨单应性矩阵的估计与应用,这是全景图像拼接过程中的另一个关键步骤。

5. 单应性矩阵的估计与应用

5.1 单应性矩阵的理论基础

5.1.1 单应性矩阵的定义与性质

单应性矩阵(Homography Matrix),在计算机视觉和图像处理中,是一个用于描述图像间几何变换关系的矩阵,它通常用于图像配准、图像拼接和三维重建等任务。在理想情况下,这个矩阵由4x4的浮点数构成,表示了一幅图像中的点如何通过投影变换映射到另一幅图像中的对应点。

单应性矩阵的性质包括:

- 它是8自由度的,因为有一个尺度因子可以任意变化而不影响映射关系。

- 它描述的是一个从一个平面到另一个平面的映射,而不是三维空间的变换。

- 它可以通过至少四个点的对应关系来估计,通常使用最小二乘法来计算得到。

单应性矩阵的计算关键在于找到两个视角下的对应点,并通过这些点来估计出一个最佳的单应性矩阵。

5.1.2 单应性矩阵的估计方法

单应性矩阵的估计通常分为以下几个步骤:

- 特征点检测与描述:在两幅图像中找到一些关键点,并为这些点计算特征描述符。

- 特征点匹配:基于描述符之间的相似性,找到对应图像间的匹配点对。

- 过滤匹配点对:为了减少错误的匹配,通常使用鲁棒的估计方法(如RANSAC)来筛选出正确的匹配点对。

- 计算单应性矩阵:利用筛选后的匹配点对,使用最小二乘法等方法计算出单应性矩阵。

下面是一个使用OpenCV库中的函数来计算单应性矩阵的示例代码:

import cv2

import numpy as np

# 假设img1Points和img2Points是两幅图像匹配的点集,每个点集至少包含4个点

img1Points = np.array([[x1, y1], [x2, y2], ...], dtype=np.float32)

img2Points = np.array([[x1', y1'], [x2', y2'], ...], dtype=np.float32)

# 计算单应性矩阵

H, _ = cv2.findHomography(img1Points, img2Points, cv2.RANSAC)

print("单应性矩阵 H 是:")

print(H)

在这段代码中, cv2.findHomography 函数的参数 cv2.RANSAC 表示使用随机采样一致性算法(Random Sample Consensus)来估计单应性矩阵,并过滤出可能的异常点。这样得到的单应性矩阵 H 就可以用来描述两幅图像之间的几何变换关系。

5.2 单应性矩阵在图像拼接中的作用

5.2.1 构建图像间的映射关系

在全景图像拼接中,单应性矩阵被用来确定相邻图像间的变换关系。这些图像通常是从不同角度拍摄的,有着部分重叠的视图。通过估计这些重叠区域中的匹配点,并计算它们的单应性矩阵,我们可以将一幅图像中的点映射到另一幅图像中去。

5.2.2 单应性矩阵的优化与应用实例

一旦得到了单应性矩阵,我们就可以利用它将一幅图像变换到另一幅图像的视角下,完成图像的对齐与拼接。在实际操作中,这个变换可能会引入一些扭曲或者失真,因此,我们需要对单应性矩阵进行优化,以提高拼接效果的质量。优化可以通过最小化重叠区域中的光度差异来实现,从而得到一个更好的视觉效果。

下面是一个简化的应用实例,展示了如何将一幅图像变换到另一幅图像上:

# 已知单应性矩阵H,要将img1变换到img2的视角下

img1 = cv2.imread('image1.jpg')

img2 = cv2.imread('image2.jpg')

# 获取img1的尺寸

(h1, w1) = img1.shape[:2]

# 将img1中的点变换到img2的视角中

img1Points = np.array([[0, 0], [0, h1], [w1, h1], [w1, 0]], dtype=np.float32)

img2Points = cv2.perspectiveTransform(img1Points.reshape(1, -1, 2), H)

# 为变换后的点添加1,为了进行透视变换

img2Points = np.concatenate((img2Points, np.ones((1, 4, 1), dtype=np.float32)), axis=2)

# 计算逆变换矩阵,得到重映射到img2空间的坐标

H_inv = np.linalg.inv(H)

img1_invPoints = cv2.perspectiveTransform(img2Points, H_inv)

# 提取整数坐标

img1_invPoints = np.int0(img1_invPoints.reshape(-1, 2))

# 创建掩模

mask = np.zeros(img2.shape, dtype=np.uint8)

# 用白色填充在掩模中

cv2.fillConvexPoly(mask, img1_invPoints, 255)

# 将img1变换到img2视角中

warped = cv2.remap(img1, img1_invPoints, None, interpolation=cv2.INTER_LINEAR, borderMode=cv2.BORDER_CONSTANT, borderValue=0)

# 在img2上叠加变换后的img1

result = img2.copy()

result[mask != 0] = result[mask != 0] * 0.5 + warped[mask != 0] * 0.5

# 保存最终结果

cv2.imwrite('stitched.jpg', result)

在这段示例代码中,我们首先定义了单应性矩阵 H ,然后使用 cv2.perspectiveTransform 来计算 img1 中每个点的变换位置,并通过 cv2.remap 函数实际执行了图像变换。最后,将变换后的图像与 img2 混合,创建了拼接后的全景图像。

这个简化的例子演示了如何使用单应性矩阵将一幅图像映射到另一幅图像上,并最终生成全景图像。在实际的全景图像拼接中,还需要考虑到色彩校正、细节融合优化等更多步骤来获得更加平滑和逼真的结果。

6. 图像变换与融合方法

在处理图像时,图像变换和融合是实现高质量全景拼接的核心技术。本章节将会详细介绍这些技术的理论基础、实现方法以及在全景图像拼接中的应用。

6.1 图像变换技术详解

图像变换是指将图像从一种形式转换为另一种形式的过程。这一节,我们将讨论两种常见的图像变换技术:仿射变换和透视变换。

6.1.1 仿射变换的原理与应用

仿射变换是一种保持图像的“平直性”和“平行性”的变换,可以理解为图像的旋转、平移、缩放和倾斜。在OpenCV中,仿射变换通过求解2x3的变换矩阵来实现。

仿射变换的代码实现

import cv2

import numpy as np

# 读取图像

image = cv2.imread('example.jpg')

rows, cols, channels = image.shape

# 设定仿射变换的三个控制点

pts1 = np.float32([[50, 50], [200, 50], [50, 200]])

pts2 = np.float32([[10, 100], [200, 50], [100, 250]])

# 计算仿射变换矩阵

matrix = cv2.getAffineTransform(pts1, pts2)

# 进行仿射变换

dst = cv2.warpAffine(image, matrix, (cols, rows))

# 显示结果

cv2.imshow('Affine Transformed Image', dst)

cv2.waitKey(0)

cv2.destroyAllWindows()

6.1.2 透视变换的原理与应用

透视变换是基于三维空间中点与投影平面之间的关系,模拟了现实世界中相机视角的变化。透视变换在图像拼接中尤其重要,因为它可以用于纠正图像中的视角畸变。

透视变换的代码实现

# 设定透视变换的四个控制点

pts1 = np.float32([[30, 30], [300, 30], [30, 300], [300, 300]])

pts2 = np.float32([[10, 10], [200, 10], [10, 200], [200, 200]])

# 计算透视变换矩阵

matrix = cv2.getPerspectiveTransform(pts1, pts2)

# 进行透视变换

dst = cv2.warpPerspective(image, matrix, (cols, rows))

# 显示结果

cv2.imshow('Perspective Transformed Image', dst)

cv2.waitKey(0)

cv2.destroyAllWindows()

6.2 图像融合技术详解

图像融合是将两个或多个图像合并为一个图像的过程,同时保留原始图像的重要信息。在全景图像拼接中,图像融合技术用于消除图像间的拼接痕迹,实现无缝连接。

6.2.1 图像融合的基本原则与方法

图像融合的基本原则是确保融合区域的颜色和亮度一致性,常用的融合方法包括加权平均、多分辨率融合等。

图像融合的代码示例

# 读取两个待融合图像

image1 = cv2.imread('image1.jpg')

image2 = cv2.imread('image2.jpg')

# 确保两幅图像尺寸一致

image2 = cv2.resize(image2, (cols, rows))

# 创建一个掩码图像,用于确定权重

mask = np.zeros((rows, cols), dtype=np.uint8)

mask[100:200, 50:150] = 1

# 使用掩码计算加权平均融合

dst = image1.copy()

dst[mask == 1] = image2[mask == 1] * 0.5 + image1[mask == 1] * 0.5

# 显示结果

cv2.imshow('Fused Image', dst)

cv2.waitKey(0)

cv2.destroyAllWindows()

6.2.2 图像融合在全景拼接中的高级技术

在全景拼接中,高级的图像融合技术如多带混合(Multi-band Blending)可以显著提高拼接效果的自然度。

6.3 系统性能优化与错误处理

处理大型图像或复杂的图像拼接任务时,性能优化和错误处理是至关重要的环节。

6.3.1 系统性能优化策略

性能优化策略包括使用高效的算法和数据结构、并行处理、GPU加速等。

6.3.2 错误处理和异常管理

错误处理包括输入验证、异常捕获和恢复机制等,确保系统的鲁棒性和稳定性。

本章小结

本章深入探讨了图像变换和融合的技术细节,以及它们在全景图像拼接中的应用。通过实例代码和详细的步骤说明,我们演示了如何在实际项目中应用这些技术。性能优化和错误处理的策略为创建稳定、高效的全景拼接系统提供了重要参考。在接下来的章节,我们将进一步整合这些知识,构建完整的全景图像拼接系统,并通过实例演示其功能和效果。

简介:本项目展示了如何利用Python和OpenCV库构建全景图像拼接系统。该系统通过合并多个图像来创建宽视场图像,广泛应用于旅游、摄影等领域。Python因其丰富的图像处理库而成为主要开发语言,而OpenCV提供的算法支持了图像的预处理、特征匹配、变换和融合等关键步骤。通过本项目,开发者可以深入学习图像处理和计算机视觉的基础知识,并有机会将系统扩展到更高级的应用。

7098

7098

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?