一、正则化-岭回归-频率角度

回顾:

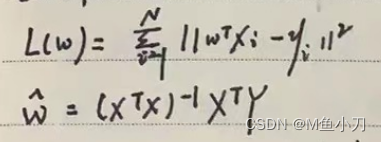

Loss Function:

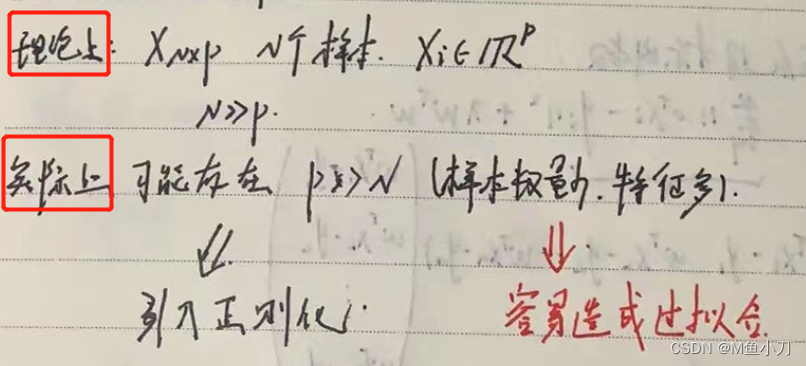

过拟合的解决方法:

①最直接:加数据

②降维(特征选择/特征提取(PCA))

③正则化(对参数空间,例如w的约束)

正则化的框架:

(L(w):Loss Function λ:惩罚系数 P(w):penalty(惩罚项))

即优化的目标为:

若为正则化:Lasso回归 P(w) =

若为正则化:岭回归 P(w) =

=

(备注正则化又叫权重衰减)

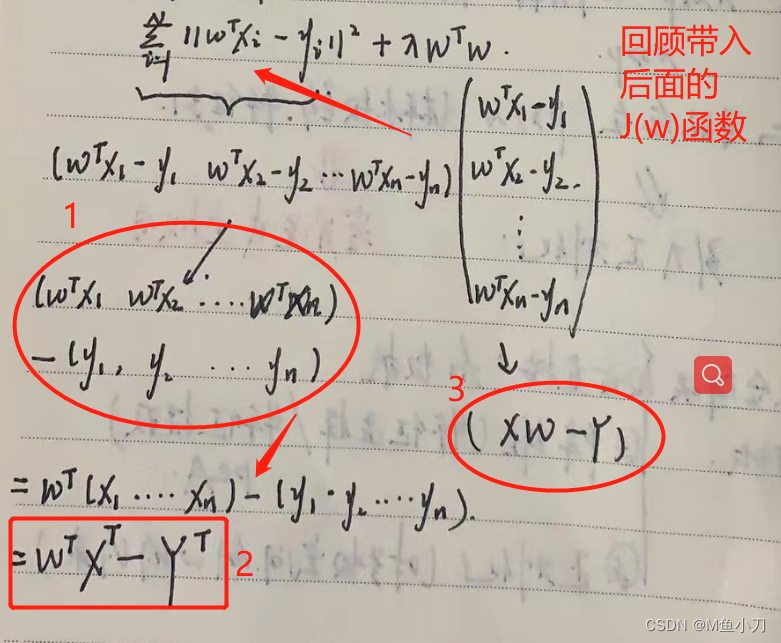

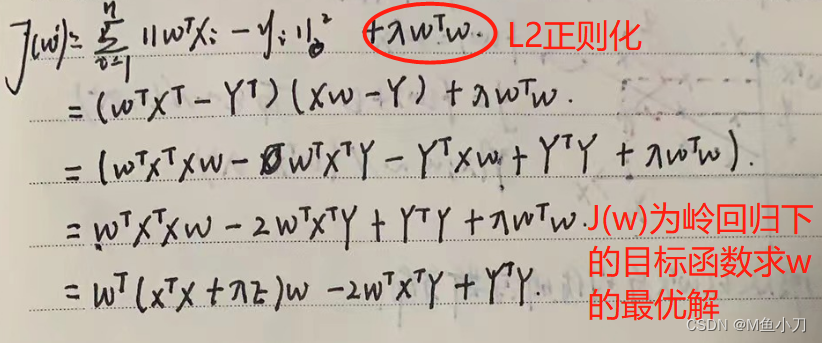

优化目标函数:

接下来就对J(w)求极值计算w的最优值:

目标:

过程:

(岭回归下得到的解析解)

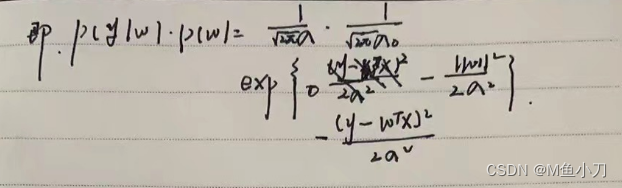

二、正则化-岭回归-贝叶斯角度

回顾:

目标:

结论:

①无正则化:最小二乘法(LSE) 等价于 最大似然估计(MLE)-(noise服从高斯分布)

②正则化:Regularized LSE 等价于 最大后验估计(MAP)-(noise服从高斯分布)

6万+

6万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?