“大数据”、“大算力”和“大模型”,是近些年人工智能领域的热点词汇。

与此同时,在这个追求“大”的时代,是否还存在其他道路和途径,来促进人工智能的发展和迈向通用智能的前沿探索?

生命是智能的第一载体,在自然中已经有亿万年的进化历史。作为代表自然界拥有最通用智能的生物大脑,可以通过低功耗和少量后天数据就能实现比现有人工智能更加通用及实现复杂环境下复杂任务的智能行为。因此,探索生物大脑智能认知的底层机理和复杂行为背后的神经科学基础,对于探索智能的本质、揭示心智的奥秘,迈向未来的通用人工智能研究具有重要意义。

在近期举办的“2021北京智源大会”的全体大会环节以及重大研究方向“人工智能的认知神经基础”专题论坛上,该方向的科学家邀请了来自于美国、瑞典、德国和日本的六位国际顶尖科学家分享了他们在类脑研究领域的经验和最新成果,以及人工智能未来发展可能存在什么样的瓶颈及相应的解决思路。此外,围绕“AI与脑科学的错位 —— 此认知非彼认知”这一主题,该方向也进行了深度探讨,并就智源“天演”模型研究进展做了工作汇报。

1观点一

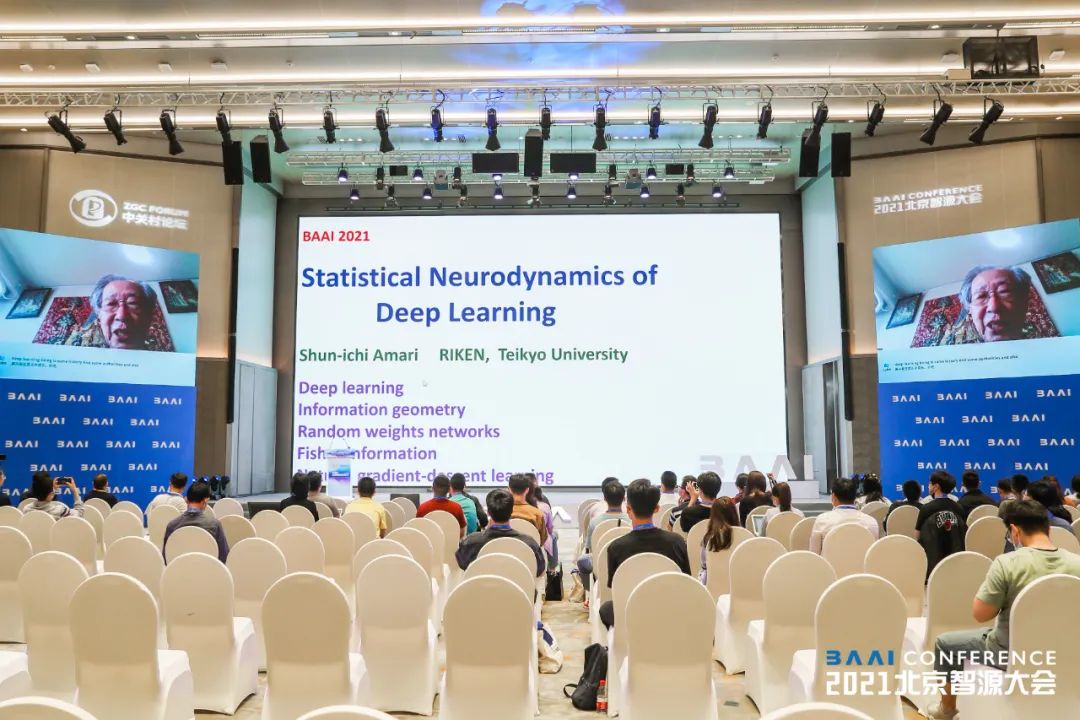

利用信息几何方法理解深度学习的泛化行为,解释深度神经网络的学习机制。

日本理化学所荣休教授甘利俊一(Shun-ichi Amari)先生在人工神经网络的发展历程做出了大量跨时代的工作,其在1967年就提出了随机梯度下降算法,并首次将其用于多层感知机训练(类似工作深度学习之父Hinton等人在1986年才提出),在1972年就提出了联想式记忆模型(类似的工作由Hopfield 1982年提出)。甘利先生用微分几何方法来解释概率模型学习,提出并发展了著名的信息几何理论来研究深度学习网络。

在深度网络学习中,可训练参数数量远多于训练样本数量,但是训练得到的网络却依然可以在测试集上表现出良好的泛化性能,而不是过拟合到有限的训练数据上去。

如何理解这一泛化行为?甘利先生梳理了近年来领域内发展的一些重要的理论方法,如信号变换方法,神经正切核方法等,进而介绍了其自己基于信息几何方法对此问题的研究,从理论上证明了在一个超大的随机网络权值空间中,总可以找到拟合任意目标函数的权值点,该方法为我们理解深度神经网络的学习机制提供了核心的理论工具。

2观点二

在高精度模型上探索大脑的通用智能,从大脑结构和功能入手探索通用人工智能的新方向。

瑞典皇家理工学院Jeanette Hellgren Kotaleski 教授是欧盟人类脑计划的负责人,也是欧洲神经信息学领域的领导者。

Jeanette教授在此次报告中详细介绍了欧盟脑计划中建立一个高精度基底核脑区模型的相关标准,以及如何在高精度模型上探索大脑的通用智能。基底核是大脑中多巴胺分泌最丰富的核团,在医学上和帕金森症密切相关,而人工智能领域目前最热的强化学习理论也来源自从基底核的工作原理。

Jeanette教授展现了如何从分子,细胞和神经回路的尺度上,精巧的还原了大脑运动和感知相结合的工作原理,成功模拟了鳗鱼在复杂水流的情况下,以无监督学习的方式,实现自感知、自适应、自驱动,同时进行躲避障碍与向目标物体游动的行为。Jeanette的一系列工作均发表在顶刊PNAS上,代表了欧洲神经学界的大脑精细模拟学派如何从大脑的结构和功能入手,探索通用人工智能的方向。

3观点三

借鉴人类大脑在概念表征、情境信息处理等方面的工作机理,提高机器智能的感知和认知能力。

曾任职德国马克斯普朗克脑研究所和法兰克福高等研究院,目前在人工智能领域创业的Danko Nikolic博士通过多个方面的对比研究阐述了大脑的工作机理和与深度学习的差异。这些差异使得一些对人来说很简单的事情对人工智能却很困难。也使得人工智能只能胜任特定任务,而不具备通用智能。

Danko Nikolic对比了人工智能在所犯错误类型、对概念的表征和理解、对情境的感知能力、学习的方式等各个方面与人脑的不同,指出这些不同使得人工智能在灵活性和泛化性上远远不如大脑,很难适应开放和未知的环境。

另外,在智能的可扩展性方面,人类大脑与类人猿大脑相似,但在智能水平上有极大的提升,体现了生物智能系统良好的可扩展性。而当前人工智能水平的提升则需要巨量的资源投入,并且随着资源投入的增大其边际效益快速下降。类脑智能的研究需要进一步深入理解这些本质差异并提出有效的解决方案,才能在可预见的未来让机器达到人类的智能水平。

4观点四

基于人类视觉感知机理设计和评估机器视觉算法,促进类脑视觉系统的创新研究。

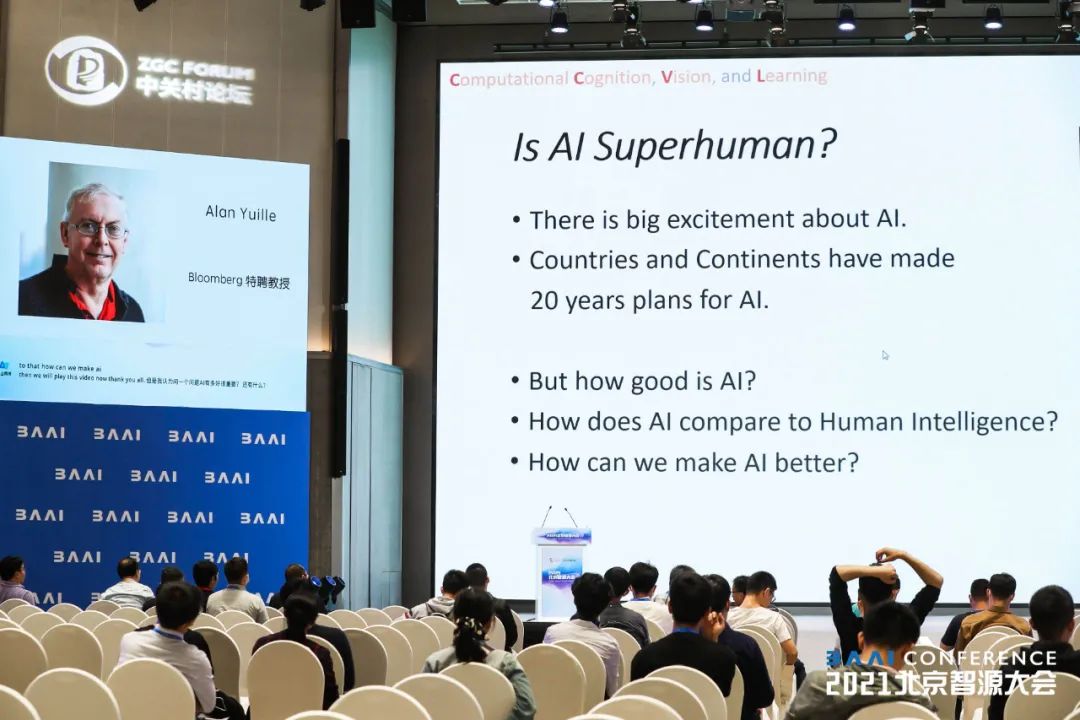

约翰霍普金斯大学认知科学系和计算机科学系Bloomberg特聘教授Alan Yuille教授师从霍金获理论物理学学位,后转向计算机视觉领域,曾获计算机视觉领域最高奖马尔奖(Marr Prize),是计算机视觉领域的权威。

Alan Yuille教授认为,虽然当前AI视觉算法在特定数据集上超过了人类水平,但这是因为人工智能是非常好的应试者,能够利用数据集里面的统计规律性来提高在特定数据集上的性能,但这样的解决方案缺乏人类视觉感知的鲁棒性和通用性。这在一定程度上由计算机视觉和机器学习领域当前普遍使用的研究范式造成。

目前,人工智能视觉算法主要是基于有限的数据量并对其进行标注来训练和实现的,显然无法适应现实世界各种视觉认知任务的复杂性,相关算法对不常见的但后果严重的情况经常缺乏足够的鲁棒性和泛化能力,也对其他场景不具有可推广性。同时,传统的机器视觉算法和模型对标注数据的依赖让大家倾向于解决容易标注而不是真实场景下重要的问题。

Alan Yuille教授认为,我们应该通过研究人类视觉感知的规律并使用更严格的性能指标来挑战和评估算法,例如采用与训练数据具有较大不同的分布外(out-of-distribution)测试集、探索新的神经网络架构等策略,解决对抗性攻击、对环境信息过于敏感等算法弱点。尤其是向人类视觉学习,开发具有组合性的模型,这将有助于鼓励研究界开发出性能与人类视觉系统一样好或更好的算法。

5观点五

融合人类视觉感知与注意选择的机制,完善人类视觉感知框架,启发类脑智能系统研究。

德国图宾根大学和马克斯普朗克脑研究所的李兆平教授从物理学转向计算神经科学,致力于推进对人类感知觉系统的理解。

李兆平教授在其报告中介绍了生物智能如人类大脑视觉系统的工作机理,强调了对视野中央与外周的二分(central-peripheral dichotomy)加工,并提供了直观的图片样例与丰富的实验证据。

现有的深度卷积网络只是在形式上借鉴了人类大脑视觉皮层的层状结构,模拟了大脑的部分视觉功能,却未能深入地理解大脑视觉系统运作背后的机理。

人类视觉系统对中央视野的输入存在反馈调节等机制,能在有限输入的环境中兼顾鲁棒性与通用性,并实现视觉理解,而对外周视野的加工则表现出与现有人工智能类似的不稳定性。

李兆平教授认为循着视觉皮层的层级结构和反馈机制更加深入地研究人类视觉系统,理解人类视觉系统的运作机制,有利于启发未来人工智能的研究和发展。

6观点六

借鉴最新的大脑学习机制,发展新一代的人工智能强化学习系统。

Peter Dayan在剑桥大学学习数学,并在爱丁堡大学获得博士学位,曾共同创建盖茨比计算神经科学组并担任该机构主任,同时也是马克斯·普朗克/加州大学学院计算精神病学和老龄化研究中心副主任。

Peter Dayan指出过去的强化学习研究主要集中在研究生物大脑中的有模型学习,无模型学习,以及简单的巴普洛夫条件下的强化学习行为。

近年来,大量新的研究表明,大脑中的经验回放,在生存压力和焦虑条件下对风险的偏好程度等,对于生物体的强化学习行为会产生重要的影响。

生物大脑在学习过程中,会产生丰富的经验回放现象,比如老鼠在进行觅食行为前,会产生前向的经验回放,而在完成觅食行为后,会产生反向的经验回放。如果干扰经验回放的进行,最终都会影响老鼠的学习行为。大量的理论假设被提出,比如经验回放为深度强化学习提供了一种记忆缓存机制,对以前的学习经验进行重组,前向经验回放可能是大脑在做在线规划等。

除了经验回放现象,最新的研究表明,大脑对风险的偏好程度决定着我们对于奖赏价值的衡量,这对于我们的决策行为有着重要的影响。除了经验回放和风险偏好,近年来,在有限理性、元控制、情境控制、社会互动等方面对生物大脑强化学习系统的研究,也可以对人工智能强化学习系统提供借鉴。

Peter Dayan认为大脑学习机制和人工智能有深刻的联系,我们可以从人工智能的算法获得启发解释脑科学机制,也可以从丰富而有效的大脑学习机制中获得启发和学习,发展更多新的人工强化学习方法,人工智能应与大脑“联姻”。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?