一、数据的预处理与特征构建

简介:在构建评分卡模型的工作中,数据预处理工作和特征构建工作是至关重要的一步。数据的预处理工作可以有效处理缺失值与异常值,从而增强模型的稳健性。而特征构建工作则可以将信息从字段中加以提炼,形成有业务含义的优异特征。

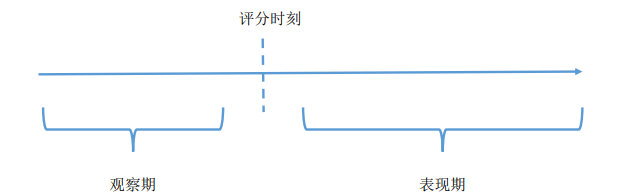

1.评分卡简介:

风控场景中的评分卡:1)以分数的形式来衡量风险几率的一种手段;2)是对未来一段时间内违约/逾期/失联概率的预测;3)有一个明确的(正)区间;4)通常分数越高越安全;5)数据驱动;6)反欺诈评分卡、申请评分卡、行为评分卡、催收评分卡。

申请评分卡(Application Scorecard)

用在贷前审核环节,评估放贷后是否会违约的模型。常用特征:个人信息、央行征信信息、申请行为信息、其他辅助信息

行为评分卡(Behavioral Scorecard)

用在贷后监控环节,做早期预警工作(包括巴塞尔2.5及之前的AIRB要求)。常用特征:贷后的还款行为、消费行为等。通常适用于还款周期长的产品或者循环授信类产品

催收评分卡(Collection Scorecard)

用在发生逾期后的管理环节,为催收工作提供指导。催收评分卡又可细分为预测失联的失联评分卡、预测逾期加重的滚动率评分卡和预测催收后的还款率的还款率评分卡。常用特征:个人信息、贷后的还款行为、消费行为、联系人信息等。

2.评分卡模型的开发步骤

1)立项:确定场景、产品和人群;

2)数据准备与预处理:选取数据、清洗数据、特征工程;

3)模型构建:参数估计;

4)模型评估:性能测试;

5)验证/审计:验证模型的合理性;

6)模型部署:上线

7)模型监控:持续监控并调优

3.评分卡开发常用的模型

逻辑回归

优点:简单,稳定,可解释性,技术成熟,易于监测和部署;

缺点:准确度不高

决策树

优点:对数据质量要求低,易解释;

缺点:准确度不高

组合模型

优点:准确度高,不易过拟合;

缺点:不易解释、部署困难、计算量大

4.数据集介绍(信贷审核相关)

1)信贷客户的申报信息和部分三方数据信息,以及需要预测的目标变量;

2)信贷客户的登录信息;

3)部分客户的信息修改行为。

建模工作就是从上述三个文件中对数据进行加工,提取特征并建立合适的模型,对贷后表现做预测。

关键字段:

| 字段 | 含义 |

|---|---|

| Idx | 用户的唯一标识 |

| Target | 目标变量,以1、0表示违约与非违约 |

| UserInfo_* | 用户属性,多以归属地内容,有缺失 |

| ThirdParty_info_Period* | 除-1外,其他都是非负整数,-1可能是特殊值 |

| ListgInfo | 用户贷款发放日期 |

| LogInfo3 | 登录日期 |

| LogInfo* | 登录时间代码 |

| UserupdateInfo1 | 更改信息所属字段 |

| UserupdateInfo2 | 更改日期 |

5.特征构造

特征构造的重要性:在评分卡模型开发中,特征构造是极其关键的步骤,其作用是将分散在不同字段中的信息加以组合,从中提炼出有价值的、可用的信息进而进行评分卡模型的开发,常用的方法:

求和:例如过去一段时间内的每月网购金额的总和

比例:例如申请贷款的月还款本息与月收入的占比

频率:例如过去一段时间内的境外消费次数

平均:例如过去一段时间内平均每次信用卡取现额度

好的特征需具备以下优势:

1)稳定性高:当人群分布稳定、产品营销稳定、宏观因素稳定、监管政策稳定时,特征的分布也需要稳定;

2)区分度高:未来的违约与非违约人群在特征上的分布需要显著不同;

3)差异性大:不能对全部人群或绝大部分人群上有单一的取值;

4)符合业务逻辑:特征与信用风险的关联关系要符合风控业务逻辑

案例

在该数据源中,我们有代表身份的idx、代表登录日期的LogInfo3和操作代码LogInfo1与LogInfo2。计算登录日期与放款日期之间的间隔天数,可以看到绝大部分的天数在180天以内。

注意到,虽然LogInfo1与LogInfo2取值为数值,但是其含义是类别。因此这类变量不能求和、平均值、最值等。但是可以求频率和个数。此外,我们需要考虑到间隔天数在变量构造中的作用。例如,对于计算某种操作的频率,我们可以考虑近30天内、近60天内、近90天内等等不同的时间窗口,称之为时间切片。

时间切片的设定:

不宜太长,否则大部分样本的时间跨度无法满足;

不宜太短,否则抓取不到足够多的信息,且变量不稳定

由于绝大部分观测样本的时间跨度在半年内,所以我们选取半年内的时间切片,考虑以月为单位的时间切片,则可以衍生出30天、60天、90天、120天、150天、180天等多种选择。

同时,对于类别型变量,可以考虑构造如下计算逻辑:

时间切片内的登录的次数

时间切片内不同的登录方式的个数

时间切片内不同登录方式的平均个数

不同的时间切片与不同的计算逻辑的交互可以产生多个特征。这些特征往往存在一定程度上的线性相关性。在接下来的多变量分析中,需要消除线性相关性对模型产生的影响。

注意:该数据源中,每个idx存在多条记彔。上述的特征构造是针对每个idx进行相应的计算。

6.数据的质量检验

1)数据的集中度

在信用风控模型的开发中,数据集中度是常见的问题。即在变量中,某单一数值的占比就占了全部样本值的绝大多数。例如,在一批训练样本中,学历为本科的样本占了全部样本的90%。具有极高的集中度的字段或者变量,需要按照风险程度进行区分:

- “多数值”与“少数值”对应的坏样本率没有显著差别。此时,由于包含的信息较少、对模型的开发没有太大价值,而且往往“少数值”的产生是由于误差或者噪声,我们可以直接将字段删除;

- “多数值”与“少数值”有显著差别,且“少数值”的坏样本率低于“多数值”。此时,尽管二者的差别很显著,但是由于我们更加关注风险度高的一组,所以“少数值”的存在并不会带来额外的意义,此时也可以直接将字段删除;

- “多数值”与“少数值”有显著差别,且“少数值”的坏样本率高于“多数值”。此时,“少数值”的存在表明该值对应的风险很高,字段需要保留。

本案例在衡量两组样本的坏样本率的差异时,用二者的坏样本率的比值的对数作为衡量。对数转换可以将互为倒数的两组数变为互为相反数。例如,当A为B的10倍时,取对数后为2.303。当A为B的十分之一时,取对数后为-2.303。我们针对以上第3点,即“少数值”的坏样本率是否高于“多数值”,以对数比例2.303为界限。我们检查多数值占比超过90%的字段,对每个字段都

检查多数值的坏样本率与少数值的对数比例。计算后发现,所有的对数比例都在2.303以内,说明少数值的存在并不会对风险产生影响,因此可以将这部分字段删除。

2)数据缺失(data missing)

数据缺失度是数据质量检验的一个重要项。需要从两个维度检验数据缺失度:

1.字段维度,即某个字段在全部样本上的缺失值个数的占比;

2.样本维度,即某条样本在所有字段上的缺失值的占比

一般而言,字段维度的缺失程度会大于样本维度的缺失程度

缺失值处理

1.舍弃该字段或该条记录:缺失占比太高;

2.补缺:缺失占比不高,可用均值法、众数法、回归法等

3.作为特殊值:将缺失看成一种特殊值

其中,补缺的方法依变量类型的不同而有所差异。比如,均值法和回归法适用于数值型变量,众数法适用于类别型变量。我们需要分辨出变量是属于类别型还是数值型。在实际业务中可按照下述的准则来判断变量的类型:

• 当且仅当变量取值为数值,且不同值的个数比较多时,视为数值型变量,这时可以用均值(完全随机缺失)、抽样法(完全随机缺失) 、回归法(针对随机缺失)进行补缺;

• 其他情况下均视为类别型变量,这时可以用抽样法、众数法进行补缺。

补缺工作的前提是,字段整体的缺失率不宜太高,否则会产生较大的偏差且对字段的使用(包括由该字段衍生的特征)的使用效果产生影响。

在信贷评分模型中,数据的缺失包含着多重意义。很多时候是完全非随机缺失,其缺失状态有着业务含义。例如,某些信贷产品的申请环节需要提供芝麻分,而且该字段的缺失本身对应的风险就比较高。有些时候缺失是完全随机缺失,缺失与否不影响信用风险。对于不同的缺失机制,对应的处理方法也有所不同。

• 完全非随机缺失:有缺失值的样本的违约率显著高于无缺失样本,此时应当将缺失当成一种特殊的状态;

• 完全随机缺失:有缺失值的样本的违约率与无缺失样本无明显差异,此时如果缺失样本的占比很少,可将样本删除。如果缺失样本的占比较高,需要将字段删除。

3)异常值(outliers)

与缺失值类似,异常值在一般的数据分析场景中也会对模型产生一定的干扰,需要对其做处理。异常值的判断通常有聚类法、分位点法等等,处理方法有删除法、替换法。

𝑥 > 𝑄3 + 3 (𝑄3 − 𝑄1)𝑜𝑟 𝑥 < 𝑄1 − 3 (𝑄3 − 𝑄1)

𝑄3,𝑄1分别是样本的75%与25%分位点

但是在信用评分模型中,异常值往往也带有特殊的意义,例如,在提交的申请资料中,如果PBOC征信记录查询次数过多,可能该申请人在一定时间内申请贷款的次数过多,则很有可能该申请人面临的资金需求很迫切,对未来的逾期概率产生不好的影响。对于这部分人,在数据预处理阶段是不宜直接删除或者用正常值进行替换。评分卡模型的开发中,也有相应的方法来处理这样的异常值。

4)数据含义的一致性

在实际工作中,数据的录入中往往会使得原本属于同一含义的记录值出现不同的记录。例如,通讯方式“QQ”与“qq”是一类性质,或者手机号码“+8613000000000”与“13000000000”均表示

同一个号码。因此,我们需要将具有相同含义的数据进行统一。本案例中,需要手动地将“QQ” 和“ qQ”,“Idnumber” 和“ idNumber”以及“MOBILEPHONE”和“PHONE”进行统一。

二、数据的预处理与特征构建(续)

简介:逻辑回归模型的特征需要是数值型,因此类别型变量不能直接放入模型中去,需要对其进行编码。此外,为了获取评分模型的稳定性,建模时需要对数值型特征做分箱的处理。最终在带入模型之前,我们还需要对特征做单变量与多变量分析的工作。

1.特征的分箱

1)分箱的概念

在评分卡模型开发中,变量需要进行分箱操作才能放入到模型当中,分箱操作定义如下:

对于数值型变量,将其分为若干有限的几个分段。例如,将收入分为<5K, 5K~10K, 10k~20k,>20k等

对于类别型变量,如果取值个数很多,将其合并为个数较少的几个分段。例如,将省份分为{北,上,广},{苏,浙,皖},{黑,吉,辽},{闽,粤,湘},其他。

评分卡模型引入变量分箱操作的原因:

➢评分结果需要有一定的稳定性。例如,当借款人的总体信用资质不变时,评分结果也应保持稳定;某些变量(如收入)的一点波动,不应该影响评分结果。例如,当收入按照上述划分时,即使月收入从6k变为7k,在其他因素不变的情况下评分结果也不会发生改变。

➢类别型变量,当取值个数很多时,如果不分箱将会导致变量膨胀。例如,对于31个省级行政区(不含港澳台),使用onehot编码将会产生31个变量;采用哑变量编码将会产生30个变量。

2)分箱的要求

不需要分箱的变量

对于类别型变量,如果取值个数较少,一般无需分箱

分箱结果的有序性

对于有序型变量(包括数值型和有序离散型,例如学历),分箱要求保证有序性

分箱的平衡性

在较严格的情况下,分箱后的每一箱的占比不能相差太大。一般要求占比最小的占比不低于5%

分箱的单调性

在较严格的情况下,有序型变量分箱后每箱的坏样本率要求与箱呈单调关系。

例如,将收入分为<5K, 5K~10K, 10K~20k, >20k后,坏样本率分别是20%,15%,10%,5%。

或者,将学历分为{低于高中},{高中,大专},{本科,硕士},{博士}后,坏样本率分别是15%,10%,5%,1%。

分箱的个数

通常要求分箱后,箱的个数不能太多,一般在7或5个以内

3)分箱的优点与缺点

优点:

稳定:分箱后,变量原始值在一定范围内的波动不会影响到评分结果;

缺失值处理:缺失值可以作为一个单独的箱,或者与其他值进行合并作为一个箱;

异常值处理:异常值可以和其他值合并作为一个箱;

无需归一化:从数值型变为类别型,没有尺度的

差异

缺点:

有一定的信息丢失:数值型变量在分箱后,变为取值有限的几个箱;

需要编码:分箱后的变量是类别型,不能直接带入逻辑回归模型中,需要进行一次数值编码

4)常用的分箱的方法

1.有监督:卡方分箱法,决策树分箱法

优点:与目标变量相结合,最大程度地将目标变量的信息反映在特征中;

缺点:计算量大

2.无监督:等距、等频、聚类

优点:计算简单;

缺点:合理性得不到保证;不能充分利用目标变量的信息

分箱的初衷是将相似度高的样本归为一组。

无监督分箱考虑的是特征在样本上的分布的相似度,有监督分箱考虑的是特征业务含义的相似度。

卡方分箱法

在有监督的分箱算法中,卡方分箱法是常用的一种方法。它以卡方分布和卡方值为基础,判断某个因素是否会影响目标变量。例如,在检验性别是否会影响违约概率时,可以用卡方检验来判断。

卡方检验的无效假设H0是:观察频数与期望频数没有差别,即该因素不会影响到目标变量。基于该假设计算出

χ

2

\chi^2

χ2值,它表示观察值与理论值之间的偏离程度。根据

χ

2

\chi^2

χ2分布及自由度可以确定在H0假设成立的情况下获得当前统计量及更极端情况的概率P。如果P值很小,说明观察值与理论值偏离程度太大,应当拒绝无效假设,表示比较资料之间有显著差异;否则就不能拒绝无效假设,尚不能认为样本所代表的实际情况和理论假设有差别。

卡方值的计算:

χ

2

=

∑

i

=

1

m

∑

j

=

1

k

(

A

i

j

−

E

i

j

)

2

E

i

j

\chi^2=\sum_{i=1}^m\sum_{j=1}^k\frac{(A_{ij}-E_{ij})^2}{E_{ij}}

χ2=i=1∑mj=1∑kEij(Aij−Eij)2

• m:该因素取值个数; k:类别数

•

A

i

j

A_{ij}

Aij:因素i组中,k类别的观察频数

•

E

i

j

E_{ij}

Eij:原假设下

A

i

j

A_{ij}

Aij的期望。

当样本总量比较大时,

χ

2

\chi^2

χ2统计量近似服从(m-1)(k-1)个自由度的卡方分布。

卡方检验案例:

| 性别 | 违约 | 正常 | 总计 |

|---|---|---|---|

| 男 | 120 | 200 | 320 |

| 女 | 80 | 220 | 300 |

总的违约率是(120+80)/(320+300)=32.25%

如果性别与违约不相关,意味着这男性与女性的违约率是同等的,

都是32.25%,则:男性违约的期望值为32032.25% ≈ 104,非违约的期望=320-104=216。

女性违约的期望值为30032.25% ≈ 97 ,非违约的期望=300-97=203

由于有随机因素的存在,即使“性别与违约不相关”的假设成立,

观察到的男性与女性的实际违约人群也不会精确地等于104和97。

卡方检验的思想就是衡量预测值与观察值的差究竟有多大的概率是

随机因素引起的。如果这个概率很小, “性别与违约不相关”的假

设是不成成立的,因此男、女性的违约率是不同的。此处概率需要

以卡方值对应的概率来描述:

χ

2

=

(

104

−

120

)

2

104

+

(

200

−

216

)

2

216

+

(

97

−

80

)

2

97

+

(

220

−

203

)

2

203

=

8.05

\chi^2= \frac{(104-120)^2}{104}+\frac{(200-216)^2}{216}+\frac{(97-80)^2}{97}+\frac{(220-203)^2}{203}=8.05

χ2=104(104−120)2+216(200−216)2+97(97−80)2+203(220−203)2=8.05

卡方(ChiMerge)分箱法(续)

ChiMerge法采取自底向上不断合并的方法完成分箱操作,在每一步的合并过程中,依靠最小的卡方值来寻找最优的合并项。其核心思想是,如果某两个区间可以被合并,那么这两个区间的坏样本需要有最接近的分布,进而意味着两个区间的卡方值是最小的。于是ChiMerge的步骤如下:

1)将数值变量A排序后分成区间较多的若干组,设为

A

1

A_1

A1,

A

2

A_2

A2,…

A

n

A_n

An,

2)计算

A

1

A_1

A1,与

A

2

A_2

A2,合并后的卡方值,

A

2

A_2

A2,与

A

3

A_3

A3,合并后的卡方值,直至

A

n

−

1

A_{n-1}

An−1,与

A

n

A_n

An,合并后的卡方值;

3)找出上一步所有合并后的卡方值中最小的一个,假设为

A

i

−

1

A_{i-1}

Ai−1与

A

i

A_i

Ai,将其合并成新的

A

i

−

1

A_{i-1}

Ai−1

4)不断重复2和3,直至满足终止条件

通用的ChiMerge的终止条件是:

1)某次合并后,最小的卡方值的p值超过0.9(或0.95,0.99等);

2)某次合并后,总的未合并的区间数达到指定的数目(例如5,10,15等)

3)每箱坏样本率单调;

4)每箱同时包含好、坏样本。

3的要求是为了使得分箱后具有风控业务含义。如果ChiMerge分箱达到1或者2的要求,我们需要检查是否满足3。如果不满足,则意味着坏样本率是不单调的,此时需要选择相邻的箱进行合并,直到坏样本率单调为止。如果有多种合并的方式,可按照某种准则挑选最优的合并方案(见下一页)。但是有些变量,如果它的坏样本率的非单调性有一定的业务含义,也是允许保留U型或者倒U型的坏样本率的。4的要求是为了后续能计算WOE。如果发现某一箱没有坏(好)

样本,则需要跟相邻的某一箱进行合并,使得合并后的所有的箱都满足4.选择左、右箱的哪一个,同样由较小的卡方值决定。

坏样本率非单调情形下的分箱合并

如前所述,当卡方分箱法完成分箱后,每一箱的坏样本率不一定满足单调的要求,此时需要做进一步的合并。此时有2种方案:

- 利用卡方分箱法缩减分箱数目。例如,当前分为5箱时出现坏样本率非单调情形,可以在卡方分箱法中设置分箱数为4,检验分箱数目为4时候的单调性。如果满足,即停止分箱;如不满足,可进一步地缩减分箱数目。分箱数目最小为2,因为只有两箱的情况下,单调性的存在性失去意义了。

- 对于当前不满足单调性的箱,可以与之前或之后的箱进行合并。如上一页图中,第3箱的的坏样本率低于前后两箱,于是需要合并。选择与之前或者之后的箱进行合并,可以依据以下原则:

a) 合并之后,非单调的程度减轻。例如将第3箱和第4箱进行合并后,整体的单调性得到保证,于是执行该方案;

b) 如果两种方案都可以减轻非单调性,则可以选择“较优”的一种。一般来讲,可以从2点考量是否“较优”。假设合并2、3箱优于合并3、4箱,因为

✓合并2、3箱后的卡方值低于合并3、4箱后的卡方值,或者

✓合并2、3箱后,所有箱的占比比合并3、4箱后的占比更加平衡。

判断分箱后的分布均匀性

假设将原变量分为m箱,每箱的占比分别是 p i p_i pi, ∑ i = 1 m p i = 1 \sum_{i=1}^mp_i=1 ∑i=1mpi=1

可以用以下公式衡量占比的均匀性:

b a l a n c e = ∑ i = 1 m p i 2 \it balance=\sum_{i=1}^mp_i^2 balance=i=1∑mpi2

由施瓦茨不等式可以知道,当 p 1 = p 2 = . . . p m = 1 m p_1=p_2=...p_m=\frac1m p1=p2=...pm=m1时, b a l a n c e \it balance balance最小,等于 1 m \frac1m m1。当 p 1 , p 2 , . . . p m p_1,p_2,...p_m p1,p2,...pm中有一个为1其余为0时, b a l a n c e \it balance balance最大,等于1.于是可以看出, b a l a n c e \it balance balance越小表明越均匀。

带有特殊值的分箱

在实际业务工作中,一些正常的观测值之外有时会有一些特殊值的存在,例如缺失。从之前的分析可以知道,本次案例的数据中部分变量含有一些缺失值。在评分卡模型中对于缺失值通常我们将其看成一种特殊的值。连续型变量的分箱工作需要预先将这些特殊值排除在外,即特殊值不参与分箱。当连续型变量存在特殊值时,需要将特殊值看成单独的一箱,其余正常值参与分箱,且分箱个数为预设个数减去特殊值的个数。这里需要注意:

• 由于特殊值无法和其他数值进行比较,故检验坏样本率的单调性时,不考虑特殊值的坏样本率;

• 当特殊值的占比很小(例如低于5%),可以考虑将特殊值与正常值中的一箱进行合并,且通常与最小的一箱或者最大的一箱进行合并

类别型(无序)变量的分箱

上述介绍的ChiMerge分箱法是针对数值型变量,例如收入、年龄等。分箱过程要保持原变量的有序性。对于类别型变量,如果是无序且取值个数较大,此时进行ChiMerge分箱之前需要先进行一次数值编码,用数字代替原来的类别型值。常用的数值编码是该数值对应的平均坏样本率。

例如,在评分模型里省份是一个常用的变量。在31个省级行政区(不含港澳台)中,我们用每个省在样本里的坏样本率代替原先的省级行政区。在这样的转换之下,类别型变量就转换成数值型变量。进而可以使用ChiMerge分箱法进行分箱操作。分箱后的省份可能是{北上广深},{苏浙鲁闽},{其他}等。

类别型(有序)变量的分箱

对于有序的类别型变量,例如学历={小学,初中,高中,大专,本科,硕士,博士},先将该变量进行排序,然后依然可以按照数值型变量的ChiMerge分箱法来进行分箱。“学历”这一边量最终的分箱结果可能是{小学,初中,高中},{大专,本科},{硕士,博士}

ChiMerge分箱法的优点与缺点

优点:

1)解释性强:以统计学中的卡方检验为原理选择最优的合并方案,具有很强的统计意义

2)能够解决多分类场景的分箱:卡方检验对需要检验的标签的类别数没有限制。如果分类对象不是二分类场景中的{违约,非违约},而是多分类场景中的{非违约,轻度违约,重度违约},ChiMerge法依然奏效

缺点:

计算量大:: 需要对数值型变量先做离散,然后迭代地选择最优分箱方法。假设原变量先离散成P个区间,最后合并为Q个区间,则需要计算

P

−

1

+

P

−

2

+

.

.

+

Q

=

(

P

−

Q

)

(

P

+

Q

−

1

)

2

P-1+P-2+..+Q=\frac{(P-Q)(P+Q-1)}2

P−1+P−2+..+Q=2(P−Q)(P+Q−1)个卡方值。

2.WOE与特征信息值

WOE编码

编码操作是一种用数值代替非数值的操作,目的是为了让模型能够对其进行数学运算。例如,可以用3组0~255之间的整数来对颜色进行编码。在评分卡模型开发中,完成变量的分箱后所有的变量都变成了组别。此时需要对其进行编码才能下一步的建模。评分卡模型里常用WOE(Weight of Evidence)的形式进行分箱后的编码。其计算公式如下:

| Bin | Bad Count | Good Count | Bad Percent | Good Percent | WOE |

|---|---|---|---|---|---|

| 1 | B 1 B_1 B1 | G 1 G_1 G1 | B 1 B \frac{B_1}B BB1 | G 1 G \frac{G_1}G GG1 | ln ( G 1 / G B 1 / B ) \ln(\frac{G_1/G}{B_1/B}) ln(B1/BG1/G) |

| 2 | B 2 B_2 B2 | G 2 G_2 G2 | B 2 B \frac{B_2}B BB2 | G 2 G \frac{G_2}G GG2 | ln ( G 2 / G B 2 / B ) \ln(\frac{G_2/G}{B_2/B}) ln(B2/BG2/G) |

| … | |||||

| N | B N B_N BN | G N G_N GN | B N B \frac{B_N}B BBN | G N G \frac{G_N}G GGN | ln ( G N / G B N / B ) \ln(\frac{G_N/G}{B_N/B}) ln(BN/BGN/G) |

| Total | B = ∑ B i B=\sum{B_i} B=∑Bi | G = ∑ G i G=\sum{G_i} G=∑Gi |

WOE编码的含义

注意到WOE公式

W

O

E

i

=

ln

(

G

i

/

G

B

i

/

B

)

=

ln

(

G

i

/

B

i

G

/

B

)

=

ln

(

G

i

B

i

)

−

ln

(

G

B

)

WOE_i=\ln(\frac{G_i/G}{B_i/B})=\ln(\frac{G_i/B_i}{G/B})=\ln(\frac{G_i}{B_i})-\ln(\frac{G}{B})

WOEi=ln(Bi/BGi/G)=ln(G/BGi/Bi)=ln(BiGi)−ln(BG)

我们有:

1)WOE的符号性质:

W

O

E

i

>

0

⇔

G

i

B

i

>

G

B

⇔

G

i

+

B

i

B

i

⇔

B

+

G

B

⇔

B

i

N

i

<

B

N

WOE_i>0\Leftrightarrow\frac{G_i}{B_i}>\frac{G}{B}\Leftrightarrow\frac{G_i+B_i}{B_i}\Leftrightarrow\frac{B+G}{B}\Leftrightarrow\frac{B_i}{N_i}<\frac{B}{N}

WOEi>0⇔BiGi>BG⇔BiGi+Bi⇔BB+G⇔NiBi<NB

即如果某箱的WOE是正的,表明该箱的坏样本率低于整个样本的平均坏样本率,相对更加容易出现好样本;

2)WOE的单调性质

W

O

E

i

>

W

O

E

j

⇔

ln

(

G

i

B

i

)

>

ln

(

G

j

B

j

)

⇔

G

i

B

i

>

G

j

B

j

⇔

G

i

+

B

i

B

i

>

G

j

+

B

j

B

j

⇔

B

i

N

i

<

B

j

N

j

WOE_i>WOE_j\Leftrightarrow\ln(\frac{G_i}{B_i})>\ln(\frac{G_j}{B_j})\Leftrightarrow\frac{G_i}{B_i}>\frac{G_j}{B_j}\Leftrightarrow\frac{G_i+B_i}{B_i}>\frac{G_j+B_j}{B_j}\Leftrightarrow\frac{B_i}{N_i}<\frac{B_j}{N_j}

WOEi>WOEj⇔ln(BiGi)>ln(BjGj)⇔BiGi>BjGj⇔BiGi+Bi>BjGj+Bj⇔NiBi<NjBj

即WOE的单调性与坏样本率的单调性相反

使

用

W

O

E

编

码

的

注

意

点

\color{red}{使用WOE编码的注意点}

使用WOE编码的注意点

1)从WOE的计算公式可以看出,要使得某一箱的

W

O

E

i

=

ln

(

G

i

/

G

B

i

/

B

)

WOE_i=\ln(\frac{G_i/ G}{B_i/B})

WOEi=ln(Bi/BGi/G)有意义,则

G

i

G_i

Gi与

B

i

B_i

Bi必须为大于0的正数。这也意味着在上一步的分箱操作中,每一箱都必须包含好坏样本

2)上式的对数计算中,好、坏样本的占比分别在分子和分母上。也可以好、坏样本的占比分别在分母和分子上,但是要求某一个模型里,所有变量的处理方式是一致的。同时,WOE的计算方式对后续逻辑回归模型的变量的符号是有一定的要求的

WOE编码的优点与缺点

优点

1)提高模型的性能:以每一箱中的相对全体的logodds的超出作为编码依据,能够提高模型的预测精度;

2)统一变量的尺度:经验上来看,WOE编码后的取值范围一般介意-4与4之间;

3)分层抽样中的WOE不变性:如果建模需要对好坏样本进行分层抽样,则抽样后计算的WOE与未抽样计算的WOE是一致的

缺点

1)要求每箱中同时包含好坏样本:已在之前有过说明;

2)对多类别标签无效:如果目标变量取值个数超过2个,分箱后的WOE是无法计算的

特征信息值(IV)

在评分卡模型中,衡量变量重要性的工作是一项必要的工作。在特征工程的初期我们往往能够衍生出数量较多的变量,但是并不能保证这些变量对于模型开发来说都很重要。通过衡量变量重要性,能够让我们从中挑选出相对更加重要的变量,为后续的分析提供降维的能力。此处我们通过计算特征信息值(Information Value)来衡量其重要性。其计算公式如下:

| Bin | Bad Count | Good Count | Bad Percent | Good Percent | WOE | IV |

|---|---|---|---|---|---|---|

| 1 | B 1 B_1 B1 | G 1 G_1 G1 | B 1 B \frac{B_1}B BB1 | G 1 G \frac{G_1}G GG1 | ln ( G 1 / G B 1 / B ) \ln(\frac{G_1/G}{B_1/B}) ln(B1/BG1/G) | ( G 1 G − B 1 B ) ln ( G 1 / G B 1 / B ) (\frac{G_1}{G}-\frac{B_1}{B})\ln(\frac{G_1/G}{B_1/B}) (GG1−BB1)ln(B1/BG1/G) |

| 2 | B 2 B_2 B2 | G 2 G_2 G2 | B 2 B \frac{B_2}B BB2 | G 2 G \frac{G_2}G GG2 | ln ( G 2 / G B 2 / B ) \ln(\frac{G_2/G}{B_2/B}) ln(B2/BG2/G) | ( G 2 G − B 2 B ) ln ( G 2 / G B 2 / B ) (\frac{G_2}{G}-\frac{B_2}{B})\ln(\frac{G_2/G}{B_2/B}) (GG2−BB2)ln(B2/BG2/G) |

| … | ||||||

| N | B N B_N BN | G N G_N GN | B N B \frac{B_N}B BBN | G N G \frac{G_N}G GGN | ln ( G N / G B N / B ) \ln(\frac{G_N/G}{B_N/B}) ln(BN/BGN/G) | ( G N G − B N B ) ln ( G N / G B N / B ) (\frac{G_N}{G}-\frac{B_N}{B})\ln(\frac{G_N/G}{B_N/B}) (GGN−BBN)ln(BN/BGN/G) |

| Total | B = ∑ B i B=\sum{B_i} B=∑Bi | G = ∑ G i G=\sum{G_i} G=∑Gi | ∑ ( G i G − B i B ) ln ( G i / G B i / B ) \sum(\frac{G_i}{G}-\frac{B_i}{B})\ln(\frac{G_i/G}{B_i/B}) ∑(GGi−BBi)ln(Bi/BGi/G) |

从上式的计算可以看出,某变量的IV是该变量每个箱的WOE的加权,权重是

(

G

i

G

−

B

i

B

)

(\frac{G_i}{G}-\frac{B_i}{B})

(GGi−BBi),如前所述,WOE的计算也可以是

ln

(

B

1

/

B

G

1

/

G

)

\ln(\frac{B_1/B}{G_1/G})

ln(G1/GB1/B).则此时权重也影响修正为

B

i

B

−

G

i

G

\frac{B_i}{B}-\frac{G_i}{G}

BBi−GGi.关于IV,我们有:

**非负性:**如果

G

i

G

>

B

i

B

\frac{G_i}{G}>\frac{B_i}{B}

GGi>BBi则

G

i

G

−

B

i

B

>

0

\frac{G_i}{G}-\frac{B_i}{B}>0

GGi−BBi>0,且

G

1

/

G

B

1

/

B

>

1

\frac{G_1/G}{B_1/B}>1

B1/BG1/G>1,进而有

ln

(

G

1

G

/

B

1

B

)

>

0

\ln(\frac{G_1}{G}/\frac{B_1}{B})>0

ln(GG1/BB1)>0,从而

(

G

1

G

−

B

1

B

)

ln

(

G

1

/

G

B

1

/

B

)

>

0

(\frac{G_1}{G}-\frac{B_1}{B})\ln(\frac{G_1/G}{B_1/B})>0

(GG1−BB1)ln(B1/BG1/G)>0,于是IV>0.

权重性:

WOE反映的是每箱中好坏比相对全体样本好坏比的超出(excess),而IV反映的是在该箱体量的意义下,这种超出的显著性。例如,某一箱的好、坏各自占了2%和1%,另一箱中的好、坏各自占了20%和10%。从WOE的角度看, 二者是一致的,都是ln(2)。但是前者的体量较少而后者的体量较大,分别是(2%-1%)=1%(20%-10%)=10%。所以后者的显著性更强一些。

关于IV,我们需要注意几点:

I. IV衡量的是特征总体的重要性,而非每一箱的重要性。IV值越大,则表明该变量的重要程度越高。但是IV的值不宜太大,否则有可能有过拟合的风险;

II. 与WOE一样,IV也要求每一箱中同时包含好坏样本;

III. IV不仅受到变量重要性的影响,同时也与分箱方式有关。通常来讲,一个变量分箱的粒度越细,则IV会升高。所以需要注意到分箱的合理性。若干个变量分箱的个数差异不大时,才能比较IV。

3.单变量分析与多变量分析

1)单变量分析(Single Factor Analysis)

完成变量分箱、WOE编码与IV计算后,我们需要做单变量分析。一般而言从两个角度进行分析:

I

.

变

量

的

重

要

性

\color{red}{I. 变量的重要性}

I.变量的重要性。变量的重要性可以从IV值的判断出发。不同的IV值反映出变量不同程度的重要性。

一般而言,IV的选择如下:

I

V

{

>

=

0.2

,

有较高的重要性

0.1

∽

0.2

,

有较弱的重要性

<

0.1

,

几乎没有重要性

IV \begin{cases} >=0.2,& \text{有较高的重要性} \\ 0.1\backsim0.2,& \text{有较弱的重要性} \\ <0.1,& \text{几乎没有重要性} \\ \end{cases}

IV⎩⎪⎨⎪⎧>=0.2,0.1∽0.2,<0.1,有较高的重要性有较弱的重要性几乎没有重要性

但是当IV异常高,例如超过1时,需要注意此时变量的分箱方式可能是不稳定的。

I

I

.

变

量

分

布

的

稳

定

性

\color{red}{II. 变量分布的稳定性}

II.变量分布的稳定性。合适的变量,各箱的占比不会很悬殊。如果某变量有一箱的占比远低于其他箱,则该变量的稳定性也较弱。

单变量分析是从重要性及分布的稳定性两个角度来考虑。通常先选择IV高于阈值(如0.2)的变量,再挑选出分箱较均匀的变量.

本次案例中,变量的IV普遍较低,需要放宽IV选择的条件。我们以0.02为阈值进行粗筛.

2)多变量分析(Multi Factors Analysis)

完成单变量分析后,我们还需要对变量的整体性做把控,利用多变量分析的技术进一步缩减变量规模,形成全局更优的变量体系。多变量分析从以下两个角度分析变量的特性并完成挑选工作:

➢变量间的两两线性相关性

➢变量间的多重共线性

变量间不允许存在太强的两两线性相关性。主要原因是:

✓若变量

f

1

f_1

f1和变量

f

2

f_2

f2的两两线性相关性较强,说明这两个变量间存在一定的信息冗余。同时保留在模型里,即无必要,同时也增加了模型开发、部署与维护的负担;

✓较强的线性相关性甚至会影响回归模型的参数估计。在回归模型的参数估计中,当两个变量间存在较强的线性相关性时,参数的估计会有较大的偏差

变 量 的 两 两 线 性 相 关 性 检 验 可 以 通 过 相 关 性 矩 阵 来 判 断 : \color{red}{变量的两两线性相关性检验可以通过相关性矩阵来判断:} 变量的两两线性相关性检验可以通过相关性矩阵来判断:

当两个变量间存在较强的线性相关性时,通常保留IV值较

高的一个。于是整个流程是:

① 将变量按照IV进行降序排列:

f

1

f_1

f1,

f

2

f_2

f2, … ,

f

p

f_p

fp

② 令i=1,计算相关系数:

σ

(

f

i

,

f

i

+

1

)

\sigma(f_i,f_{i+1})

σ(fi,fi+1),

σ

(

f

i

,

f

i

+

2

)

\sigma(f_i,f_{i+2})

σ(fi,fi+2) , … .

σ

(

f

i

,

f

p

)

\sigma(f_i,f_p)

σ(fi,fp)

③ 如果

σ

(

f

i

,

f

j

)

\sigma(f_i,f_j)

σ(fi,fj)较大,则剔除

f

i

f_i

fi

④ i=i+1

⑤ 重复2~4,直到剩余变量中不存在较高的线性相关性。

相关系数通常用较高的阈值来对比,可以用0.7~0.9之间的数。

完成变量间的两两线性相关性检验后,我们还需要检验是否存在多重共线性(multicolinearity)。多重共线性是指,一组变量中,某一个变量与其他变量的线性组合存在较强的线性相关性。同样地,存在较强的多重共线性意味着存在信息冗余,且对模型的参数估计产生影响。多重共线性通常用方差膨胀因子(VIF)来衡量,其计算方式如下:

V

I

F

(

f

i

∣

f

1

,

f

2

.

.

.

f

i

)

=

1

1

−

R

2

VIF(f_i|f_1,f_2...f_i)=\frac1{1-R^2}

VIF(fi∣f1,f2...fi)=1−R21

其中

R

2

R^2

R2是

f

1

f_1

f1,

f

2

f_2

f2, … ,

f

j

f_j

fj对

f

j

f_j

fj的线性回归的决定系数。

一般而言,我们用10来衡量是否存在多重共线性。对于VIF>10,可以认为变量间存在多重共线性。此时,需要逐步从

f

1

f_1

f1,

f

2

f_2

f2, … ,

f

j

f_j

fj剔除一个变量,剩余的变量与

f

i

f_i

fi计算VIF。如果发现当剔除

f

k

f_k

fk后剩余变量对

f

j

f_j

fj的VIF低于10,则从

f

i

f_i

fi与

f

k

f_k

fk中剔除IV较低的一个。如果每次剔除一个变量还不能降低VIF,则每次剔除2个变量,直至变量间不存在多重共线性。

三、逻辑回归模型在评分卡开发中的应用

**简介:**在分类场景中,逻辑回归模型是常用的一类算法。它具有结构简单、可解释性强,输出结果也是“软分类”的特点。评分模型多采用这类算法。同时逻辑回归模型也面临一些限制,因此在特征工程阶段我们对输入特征做相应的调整和约束。

1.逻辑回归模型的基本概念

1)伯努力概型

在分类模型中,目标变量是离散、无序型的变量。例如,违约预测模型中的目标变量(也称为标签)是{违约,非违约}。线性回归模型无法对这类标签进行建模,因为线性回归模型的结果的取值空间是整个实数空间𝑅.对于分类模型而言,我们建模的对象是每个类别在某条样本上出现的概率。

伯努力概型:

某个事件有“发生”与“不发生”两种互斥的状态。假设该事件发生的概率为𝑝,不发生的概率即为1 −𝑝.我们用1和0表示事件的发生与不发生,则有:

P

r

(

Y

=

y

)

=

{

p

,

y=1

1

−

p

,

y=0

P_r(Y=y)= \begin{cases} p,& \text{y=1} \\ 1-p,& \text{y=0} \\ \end{cases}

Pr(Y=y)={p,1−p,y=1y=0

可以统一成:

P

r

(

Y

=

y

)

=

p

y

(

1

−

p

)

1

−

y

P_r(Y=y)=p^y(1-p)^{1-y}

Pr(Y=y)=py(1−p)1−y

2)逻辑回归模型与logistic变换

在违约预测场景中,单个个体的违约事件可以看成伯努利概型:

p

r

(

y

i

)

=

p

i

y

i

(

1

−

p

i

)

1

−

y

i

p_r(y_i)=p_i^{y_i}(1-p_i)^{1-y_i}

pr(yi)=piyi(1−pi)1−yi

参数

p

i

p_i

pi即是我们需要预测的目标。

如何对概率做过拟合?

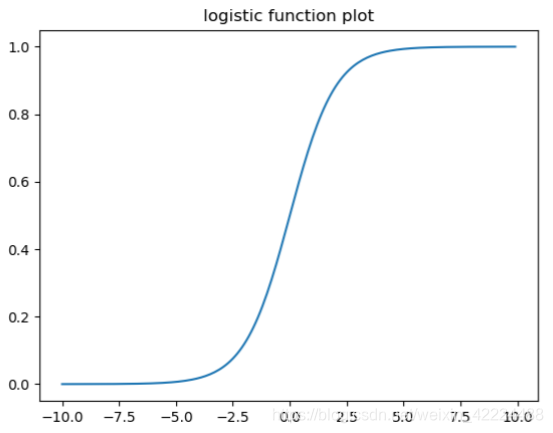

概率的取值范围是0~1.如前所述,线性回归的目标变量的取值空间是整个实数空间,因此不适合用线性回归模型做预测。引入下面的logistic变换(也称为sigmoid函数),能够是的拟合的目标函数的取值范围限定在0~1:

f

(

x

)

=

e

x

e

x

+

1

f(x)=\frac {e^x}{e^x+1}

f(x)=ex+1ex

f

(

x

)

f(x)

f(x)的特点:单调性,有界性,可到性;除此之外,

f

(

x

)

f(x)

f(x)还有一个性质,即

f

′

(

x

)

=

f

(

x

)

(

1

−

f

(

x

)

)

f'(x)=f(x)(1-f(x))

f′(x)=f(x)(1−f(x))

由于logistic变换有上述种种优点,我们将该变换应用在概率的刻画当中:

p

i

=

e

X

i

β

e

X

i

β

+

1

p_i=\frac {e^{X_i\beta}}{e^{X_i\beta}+1}

pi=eXiβ+1eXiβ

其中

X

i

=

(

1

,

x

i

1

,

x

i

2

,

.

.

.

x

i

p

)

,

β

=

(

β

0

,

β

1

.

.

.

β

p

)

X_i=(1,x_{i1},x_{i2},...x_{ip}),\beta=(\beta_0,\beta_1...\beta_p)

Xi=(1,xi1,xi2,...xip),β=(β0,β1...βp)分别表示第i个观测值上p个特征的取值和特征的权重。

于是整个逻辑回归模型的形式为:

p

(

Y

i

=

y

i

)

=

p

i

y

i

(

1

−

p

i

)

1

−

y

i

=

(

e

X

i

β

e

X

i

β

+

1

)

y

i

(

1

e

X

i

β

+

1

)

1

−

y

i

p(Y_i=y_i)=p_i^{y_i}(1-p_i)^{1-y_i}=\left(\frac {e^{X_i\beta}}{e^{X_i\beta}+1}\right)^{y_i}\left(\frac {1}{e^{X_i\beta}+1}\right)^{1-y_i}

p(Yi=yi)=piyi(1−pi)1−yi=(eXiβ+1eXiβ)yi(eXiβ+11)1−yi

需要注意的是,这里的回归模型是对违约概率做回归,而非对违约结果(0,1)做回归。

3)参数估计

通常用极大似然估计法(MLE)求出逻辑回归的参数

β

=

β

i

\beta=\beta_i

β=βi

对于样本{

x

i

,

y

i

x_i,y_i

xi,yi},逻辑回归模型的似然函数和对数似然函数分别为

L ( x , y ∣ β ) = ∏ i = 1 N ( e X i β e X i β + 1 ) y i ( 1 e X i β + 1 ) 1 − y i L(x,y|\beta)=\prod_{i=1}^N\left(\frac {e^{X_i\beta}}{e^{X_i\beta}+1}\right)^{y_i}\left(\frac {1}{e^{X_i\beta}+1}\right)^{1-y_i} L(x,y∣β)=i=1∏N(eXiβ+1eXiβ)yi(eXiβ+11)1−yi

L L ( x , y ∣ β ) = log ( L ( x , y ∣ β ) ) = log ( ∏ i = 1 N ( e X i β e X i β + 1 ) y i ( 1 e X i β + 1 ) 1 − y i ) = ∑ i = 1 N ( y i X i β − log ( 1 + e X i β ) ) LL(x,y|\beta)=\log(L(x,y|\beta))=\log\left(\prod_{i=1}^N\left(\frac {e^{X_i\beta}}{e^{X_i\beta}+1}\right)^{y_i}\left(\frac {1}{e^{X_i\beta}+1}\right)^{1-y_i}\right) =\sum_{i=1}^N(y_iX_i\beta-\log(1+e^{X_i\beta})) LL(x,y∣β)=log(L(x,y∣β))=log(i=1∏N(eXiβ+1eXiβ)yi(eXiβ+11)1−yi)=i=1∑N(yiXiβ−log(1+eXiβ))

参数估计的结果是为了让似然函数最大化。由于对数似然函数与似然函数单调上升且具有更紧凑的形式,同时也易于求导运算,因此将似然函数最大化转化为对数似然函数最大化,即

β

=

a

r

g

m

a

x

L

L

(

X

,

Y

∣

β

)

=

a

r

g

m

a

x

∑

i

=

1

N

(

y

i

X

i

β

−

log

(

1

+

e

X

i

β

)

)

\beta=argmaxLL(X,Y|\beta)=argmax\sum_{i=1}^N(y_iX_i\beta-\log(1+e^{X_i\beta}))

β=argmaxLL(X,Y∣β)=argmaxi=1∑N(yiXiβ−log(1+eXiβ))

对

L

L

(

X

,

Y

∣

β

)

LL(X,Y|\beta)

LL(X,Y∣β)求偏导,结果是

∂

L

L

(

X

,

Y

∣

β

)

∂

β

i

=

∑

i

=

1

N

(

y

i

x

i

j

−

x

i

j

e

X

i

β

e

X

i

β

+

1

)

\frac{\partial LL(X,Y|\beta)}{\partial \beta_i}=\sum_{i=1}^N(y_ix_{ij}-x_{ij}\frac {e^{X_i\beta}}{e^{X_i\beta}+1})

∂βi∂LL(X,Y∣β)=i=1∑N(yixij−xijeXiβ+1eXiβ)

显然,

∂

L

L

(

X

,

Y

∣

β

)

∂

β

i

=

0

\frac{\partial LL(X,Y|\beta)}{\partial \beta_i}=0

∂βi∂LL(X,Y∣β)=0的方程是没有解析解的。

无法得到解析解的情况下,只能通过数值求解的方式来计算参数的计。常用梯度上升法来迭代地计算

β

^

\hat\beta

β^。基本的算法步骤如下:

1.初始化参数

β

0

=

(

β

0

0

,

β

1

0

,

.

.

.

β

p

0

,

)

\beta_0=(\beta_0^0,\beta_1^0,...\beta_p^0,)

β0=(β00,β10,...βp0,)和步长

h

h

h;

2.计算当前梯度:

∇

=

X

′

y

−

X

′

w

其

中

w

i

=

e

X

i

β

e

X

i

β

+

1

\nabla=X'y-X'w其中w^i=\frac {e^{X_i\beta}}{e^{X_i\beta}+1}

∇=X′y−X′w其中wi=eXiβ+1eXiβ;

3.更新参数:

β

i

+

1

=

β

i

+

∇

∗

h

\beta^{i+1}=\beta^i+\nabla*h

βi+1=βi+∇∗h

4.直至满足终止条件

注:根据计算梯度使用的样本量的多少,梯度上升法分为批量梯度上升法、随机梯度上升法与小批量梯度上升法。

逻辑回归模型的优点

1)结构简单:变量之间的关系是线性可加关系;

2)可解释性高:输入变量对目标变量的影响是容易获得的;

3)支持增量训练:无需读入全部数据,可增量式地读取数据、训练模型;

4)给出概率而非判别类别:模型的结果是估计出属于某一类的概率,可用于更加复杂的决策;

5)工程化相对容易:模型的测试、部署、监控、调优等工作相对简单

逻辑回归模型的不足

1)预测精度一般:由于模型结构较为简单,导致预测精度不如其他模型

2)对变量要求高:输入变量需数值类型,需要对非数值变量进行编码

3)不能容忍缺失值,需要对缺失值做处理;

4)对异常值敏感,需要对异常值做处理;

5)变量尺度差异较大时,容易对模型有影响,需要做变量归一化;

6)变量间的线性相关性对模型有影响,需要做变量挑选或加上正则项

2.基于逻辑回归模型的评分卡构建工作

1)逻辑回归模型对变量的要求

当用逻辑回归模型来构建评分卡时,入模变量需要满足以下条件

① 变量间不存在较强的线性相关性和多重共线性

② 变量具有显著性

③ 变量具有合理的业务含义,即变量对于风控业务是正确的

其中,第1点已经在单变量分析与多变量分析中得到一定的约束,但是未必充分。

关于第2点,需要从系数的p值进行检验

关于第3点,需要从系数的符号进行检验

变量显著性

为了获取与目标变量(即违约标签)有较高相关性的变量,我们要求最终入模的变量的系数的p值很

小,例如低于0.1。如果发现模型中某些变量不显著,需要检验一下两种可能性:

① 该变量本身不显著

② 该变量显著,但是由于有一定的线性相关性或者多重共线性,导致该变量在多元回归下不显著

先检验1的可能性,如果排除,再检验2.

检验1的方法:

将该变量单独与目标变量做逻辑回归模型,如果在单变量回归的情况下系数的p值仍然较高,即表明该变量本身的显著性很低。

注:对于IV较高的变量,1的可能性较低。

变量正确性

在WOE的计算公式中,

W

O

E

i

=

log

(

G

o

o

d

P

e

r

c

e

n

t

i

B

a

d

P

e

r

c

e

n

t

i

)

=

log

G

i

B

i

−

log

G

B

WOE_i=\log(\frac{Good Percent_i}{Bad Percent_i})=\log\frac{G_i}{B_i}-\log\frac{G}{B}

WOEi=log(BadPercentiGoodPercenti)=logBiGi−logBG

当WOE为负时,表名当前箱的“危险性”高于平均样本的“危险性”,出现坏样本的概率更高。因此在逻辑回归模型中,所以变量对应的系数应该为负。

反之,如果采取的WOE的计算公式为:

W

O

E

i

=

log

(

B

o

o

d

P

e

r

c

e

n

t

i

G

a

d

P

e

r

c

e

n

t

i

)

=

log

B

i

G

i

−

log

B

G

WOE_i=\log(\frac{Bood Percent_i}{Gad Percent_i})=\log\frac{B_i}{G_i}-\log\frac{B}{G}

WOEi=log(GadPercentiBoodPercenti)=logGiBi−logGB

同理,所有变量对应的系数应该为正。

部分变量的p值不显著,WOE也存在正值,因此要检查显著性和正确性;

对上述所有p值超过0.1的变量单独做一元逻辑回归模型,p值全部低于0.1,说明不显著的p值是由于线性相关性引起的;

对上述所有正系数的变量单独做一元逻辑回归模型,系数全部为-1。

2)特征选择

从上述的单变量回归中可以发现,在full regression中,不显著、不正确的变量是由于线性相关性引起的。

因此需要在做一次变量挑选。变量挑选的目的是为了满足:

I. 入模变量正确并且显著

II. 入模变量的“重要性”是最高的

其中,我们可以用IV来衡量入模变量的重要性。

综上,变量挑选的步骤如下:

- 将变量根据IV进行降序排列,不妨设为𝑥1 > 𝑥2 > ⋯ > 𝑥𝑝,其中“>”代表重要性的次序

- 当前的入模变量集合为{𝑥1}

- 从剩余的变量中挑选第一个变量放入上一步的集合中,建立回归模型。如果该模型的所有的变量都满足p值小于阈值、系数为负,则在入模变量集合中保留该变量,否则剔除

- 遍历所有变量

此时所有变量的符号都为负,且p值小于阈值0.1。

3.尺度化

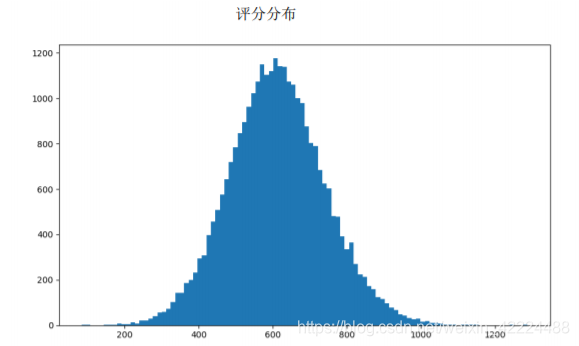

得到符合要求的逻辑回归模型后,通常还需要将概率转化成分数。分数的单调性与概率相反,即分数越高表明违约的概率越低,信用资质越好。在评分卡模型中,上述过程称为“尺度化”,转换公式为:

s

c

o

r

e

=

B

a

s

e

P

o

i

n

t

+

P

D

O

ln

(

2

)

(

−

y

)

score=Base Point+\frac{PDO}{\ln(2)}(-y)

score=BasePoint+ln(2)PDO(−y)

其中,

y

=

log

(

p

1

−

p

)

y=\log(\frac{p}{1-p})

y=log(1−pp),PDO:point to double odds

PDO的作用

假设当前的好坏比为

1

−

p

p

=

e

−

y

\frac{1-p}{p}=e^{-y}

p1−p=e−y,对应的分数为

s

c

o

r

e

1

score_1

score1;

当好坏比上升一倍时变为

2

∗

1

−

p

p

=

2

∗

e

−

y

=

e

ln

2

−

y

=

e

−

y

′

2*\frac{1-p}{p}=2*e^{-y}=e^{\ln2-y}=e^{-y'}

2∗p1−p=2∗e−y=eln2−y=e−y′,即

y

′

=

y

−

ln

2

y'=y-\ln2

y′=y−ln2,此时分数变为

s

c

o

r

e

2

=

B

a

s

e

P

o

i

n

t

+

P

D

O

ln

(

2

)

(

−

y

′

)

+

B

a

s

e

P

o

i

n

t

+

P

D

O

ln

(

2

)

(

ln

2

−

y

)

=

s

c

o

r

e

1

+

P

D

O

score_2=Base Point+\frac{PDO}{\ln(2)}(-y')+Base Point+\frac{PDO}{\ln(2)}(\ln2-y)=score_1+PDO

score2=BasePoint+ln(2)PDO(−y′)+BasePoint+ln(2)PDO(ln2−y)=score1+PDO

因此,PDO的含义为,当好坏比上升1倍时,分数上升PDO个单位

Base Point的选择:要满足所有的评分的取值为正

四、模型的验证,监控与调优

简介:得到评分卡模型后,还需要验证模型的性能。并且部署后还要持续监测模型的表现。

1.模型的区分布

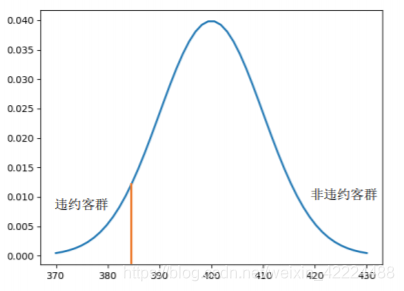

1)区分度的概念

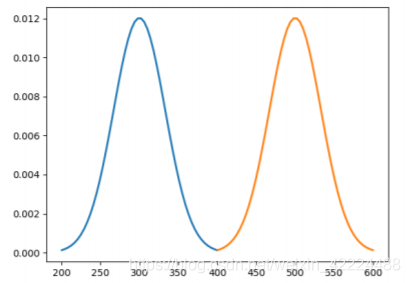

评分模型的作用是通过分数将好坏人群进行区分。从分数的性质可以看出,好的评分模型下违约人群的分数低、非违约人群的分数高。反之坏的评分模型下违约与非违约人群的分数是几乎无法区分的。在理想模型里,所有非违约人群的评分均高于违约人群。但在现实场景中无法达到这样的理想状态。因此我们需要借助某些统计量来衡量好坏人群分数的差异性,即评分模型的区分能力。

2)区分度的度量

从量化角度来说,我们需要找出一个指标来衡量分数对好坏样本的区分度,这样的一个指标需要满足一定的性质:

➢与区分能力单调相关,即指标越高(或越低)说明区分能力越强

➢与好坏样本的占比不相关。即在好、坏样本分层抽样的情况下依然不会发生显著的改变。例如,当好坏样本从100:1进行采样后变为10:1,度量指标依然不会发生显著的改变。

一般可以从以下几个方面衡量模型的区分度:

- 好、坏样本的分布的差异

- 好、坏样本在统计学意义下的“距离”

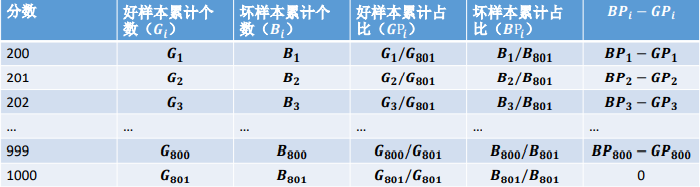

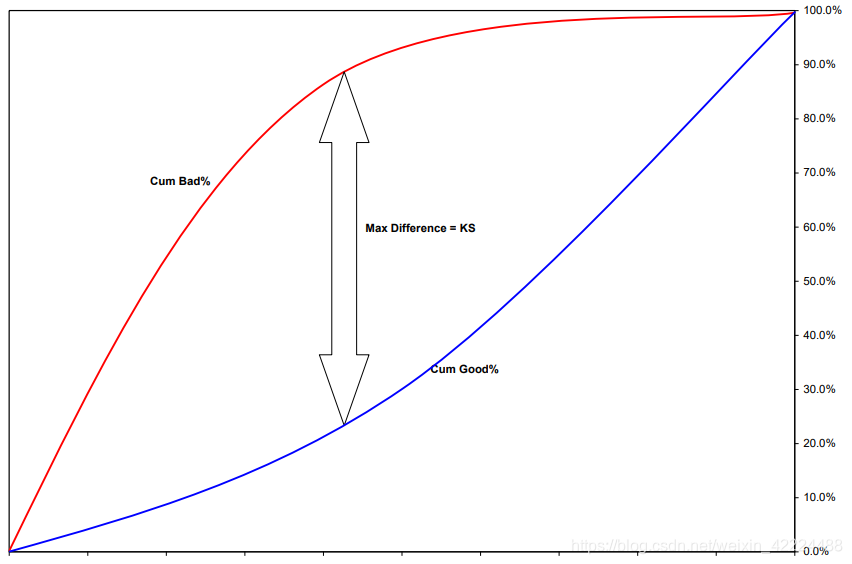

3)从分布的差异性看区分度-KS值

最直接的办法就是检验在评分的意义下两类样本的分布的差异性。在非参统计学里有多种指标可以计算两类样本的分布的差异性,最常用的就是KS(Kolmogorov-Smirnov)值。

K

S

=

m

a

x

(

B

P

i

−

G

P

i

)

KS=max(BP_i-GP_i)

KS=max(BPi−GPi)

需要注意的是,计算KS时需要将分数从低到高分进行排序。这是因为评分模型中,违约人群的分数低于非违约人群的分数。因此在低分段时,违约人群的累积速度会高于非违约人群。

1)正常情况下KS的范围时0~100%,当评分模型的结果与预期相反,即坏样本得分高于好样本时,KS为负;

2)KS越高,说明评分模型对好坏人群的区分能力越强,通常要求KS在训练样本上超过40%,在训练样本以及部署后超过30%;

3)KS对应的分数可以作为切分点(cut-off point)的选择之一。当两个模型在同一个样本集上的KS相等或者接近时,推荐使用切分点较小的模型。

3)从分布的差异性看区分度-Gini Score

除了KS值外,还可以通过Gini Score来评估区分度:

G

i

n

i

=

∑

N

n

i

(

1

−

p

i

2

−

(

1

−

p

i

)

2

)

=

2

∑

N

n

i

(

1

−

p

i

)

p

i

Gini=\sum_N^{n_i}(1-p_i^2-(1-p_i)^2)=2\sum_N^{n_i}(1-p_i)p_i

Gini=N∑ni(1−pi2−(1−pi)2)=2N∑ni(1−pi)pi

先将样本分为若干组,再计算每组的坏样本率

p

i

p_i

pi,进而得到Gini Score。Gini Score越小说明区分度越强。

需要注意的是:

a.Gini Score与分组方式相关。同一个模型下,将样本分为10组与20组得到的结果是完全不同的;

b.Gini Score不能反映分数在好坏人群上的有序性;

c.对好坏比敏感。改变好坏比后,Gini Score也会发生改变。

3)从样本距离看区分度-散度(Divergence)

在机器学习模型和统计学模型中,“距离”是频繁使用的度量之一,用以衡量单个样本或者样本集的差异。同样的,在评分模型中我们也可以计算好坏样本的距离来检验分数的区分度:

D

i

v

e

r

g

e

n

c

e

=

(

u

g

o

o

d

−

u

b

a

d

)

2

1

2

(

v

a

r

g

o

o

d

+

v

a

r

b

a

d

)

Divergence=\frac{(u_{good}-u_{bad})^2}{\frac12(var_{good}+var_{bad})}

Divergence=21(vargood+varbad)(ugood−ubad)2

u

g

o

o

d

u_{good}

ugood和

u

b

a

d

u_{bad}

ubad分别表示好坏样本的评分均值,

v

a

r

g

o

o

d

var_{good}

vargood和

v

a

r

b

a

d

var_{bad}

varbad分别表示好坏样本的评分的方差。

注意:

a.

D

i

v

e

r

g

e

n

c

e

Divergence

Divergence与好坏样本的比例无关。当对好坏样本进行抽样处理后,不会显著影响

D

i

v

e

r

g

e

n

c

e

Divergence

Divergence的值;

b.当好坏样本的分数分布比较接近正态分布时,

D

i

v

e

r

g

e

n

c

e

Divergence

Divergence最能真实刻画区分度;

c.

D

i

v

e

r

g

e

n

c

e

Divergence

Divergence没有参照的阈值。可以用来比较不同模型在同一样本上的表现,或者同一模型在不同样本上的表现。

2.模型的预测性与混淆矩阵

1)模型的预测性

除了区分度之外,预测性也是评分模型重要的评估性能之一。与其他预测模型不用评分模型预测的准确性并不是简单地评估有多少样本能被正确地分类。

考虑以下场景:有1000个样本,其中有10个违约样本,其他都是非违约的。现在某模型将所有的样本都预测为非违约。在这样的情况下,分类正确率为(1000-10)/1000=99%.

从正确率的角度看,该模型的预测性是很强的。但是,该模型未能识别出任何一例违约样本,对信用风控是没有帮助的。我们需要寻找出可以正确评估模型预测性的指标。

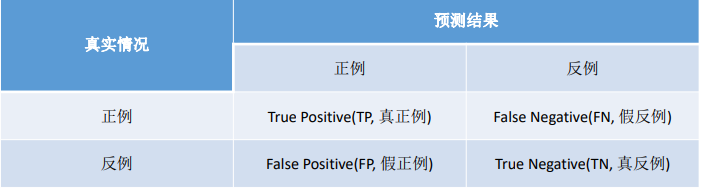

两类错误

Type I:将好样本预测为坏样本

Type II:将坏样本预测为好样本

两类错误的代价是不同的。通常第二类错误的代价高于第一类。

2)混淆矩阵(confusion matrix)

在评分模型中,混淆矩阵及其衍生量是在二分类(或多分类)场景中常用的预测性能度量的工具。混淆矩阵的作用是细分了上一页陈述的两类错误。二分类下的混淆矩阵是:

其中,对角线的值是预测正确的值;FP和FN表示第一类和第二类错误;在评分模型中,我们用正例代表违约类别,用反例代表非违约类别。

在混淆矩阵的基础上,我们衍生出一些常用的性能指标

P

r

e

c

i

s

i

o

n

=

T

P

T

P

+

F

P

Precision=\frac{TP}{TP+FP}

Precision=TP+FPTP,所有被预测为违约的样本中,真正违约的比例;

R

e

c

a

l

l

=

T

P

T

P

+

F

N

Recall=\frac{TP}{TP+FN}

Recall=TP+FNTP,所有真正违约的样本中,能被模型检测出来的比例。

我们希望𝑃𝑟𝑒𝑐𝑖𝑠𝑖𝑜𝑛和𝑅𝑒𝑐𝑎𝑙𝑙都能达到很高的数值。但是在非理想的情况下,二者是不能同时增大的。例如,当我们认为所有的样本都是违约样本时,Recall达到最大,但是Precision很小。或者,当我们认为评分最低的那些样本是违约样本时,Precision很高但是Recall很小。

F

1

=

2

P

r

e

c

i

s

i

o

n

∗

R

e

c

a

l

l

P

r

e

c

i

s

i

o

n

+

R

e

c

a

l

l

F1=2\frac{Precision*Recall}{Precision+Recall}

F1=2Precision+RecallPrecision∗Recall综合了Precision和Recall两个指标。

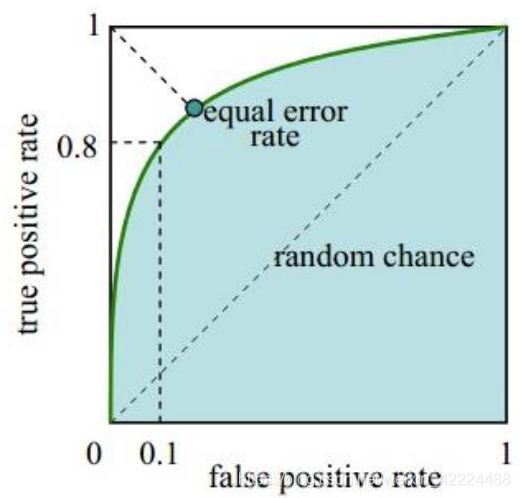

3)ROC与AUC

但上述的混淆矩阵是用于预测结果为类别的模型(例如SVM或者决策树)。评分模型的结果是分数(或者概率,二者等价)。此时不能直接将输出结果用来构建混淆矩阵。解决办法是,先用分数与某一阈值做比较,低于阈值的样本被分为违约样本,反之则是非违约样本。任何一个阈值下都能建立相应的混淆矩阵,继而可以计算出Precision,Recall,F1或者其他指标。将不同阈值下的新能指标用曲线图的方式展现出来是一个好的评估手段。ROC曲线是其中一种常用的度量曲线,描述的是TPR和FPR在不同阈值下的变化情况。

T

r

u

e

P

o

s

i

t

i

v

e

R

a

t

e

(

T

P

R

)

=

T

P

T

P

+

F

N

=

R

e

c

a

l

l

True\,Positive\;Rate(TPR)=\frac{TP}{TP+FN}=Recall

TruePositiveRate(TPR)=TP+FNTP=Recall

F

a

l

s

e

P

o

s

i

t

i

v

e

R

a

t

e

(

F

P

R

)

=

F

P

F

P

+

T

N

False\,Positive\;Rate(FPR)=\frac{FP}{FP+TN}

FalsePositiveRate(FPR)=FP+TNFP

FPR反应的是所有被预测为违约的样本中,真实为非违约样本的比例。

类似的,我们希望TPR达到最大100%,同时FRP达到最小0%,此时意味着所有的违约样本都能被识别出来,而没有违约样本被误判。但只有理想模型才能达到这种效果。

比较好的评分模型意味着当FPR较低时,TPR能相对达到比较大的值。反映在ROC曲线上,就是曲线尽可能的靠近(0,1)点;

坏的模型意味着好坏样本均匀散落在全部评分中,即TPR和FPR的增长速率相近。此时ROC曲线近似对角线,该模型近似随机判别的模型;

更坏的模型则将违约样本给予高分,将非违约样给予低分,此时ROC曲线低于对角线。

如何衡量ROC与(0,1)接近的程度呢?曲线下的面积是较好的度量工具。该面积被称为AUC(Area Under Curve)。当AUC较大时,说明模型的预测能力很强。通常用70%作为评估AUC的阈值

4)模型的预测性和区分性的总结

需要注意的是,在衡量模型的预测性和区分性的时候,需要知道样本的违约标签,意味着需要等待一个完整的表现期。如果表现期定位1年,则现在只能衡量模型在1年前的预测性和区分性。

3.模型的平稳性

评分模型追求平稳性,即当信贷产品、客群、宏观经济、监管政策等没有发生大的变化时,在不同客群或者相同客群不同时间上的评分的结果应该相对保持稳定。由于评分卡模型的入模变量已经经过分箱处理,消除了有细微的变化对评分结果带来的影响,因此“随机性”的因素已经得到了一定的控制。在这样的情况下,如果评分结果发生较激烈的变化,说明模型的平稳性发生弱化。

在评分模型中,通常用PSI指标来衡量模型的平稳性。计算如下:

P

S

I

=

∑

i

=

1

K

(

U

i

−

V

i

)

∗

l

o

g

(

U

i

V

i

)

PSI=\sum_{i=1}^K(U_i-V_i)*log(\frac{U_i}{V_i})

PSI=i=1∑K(Ui−Vi)∗log(ViUi)

同一个评分模型在两份样本(比如,同一个信贷产品在不同月份的申请人群的得分)上比较分布的平稳性。将两份样本分各自为K组,计算每组在各自总体中的比例,设为{

U

i

U_i

Ui},{

V

i

V_i

Vi},

∑

i

=

1

K

,

U

i

=

1

,

∑

i

=

1

K

,

V

i

=

1

\sum_{i=1}^K,U_i=1,\sum_{i=1}^K,V_i=1

∑i=1K,Ui=1,∑i=1K,Vi=1。

PSI越低说明两组样本上的分数越接近。

注:

• 常用的阈值为25%。高于25%说明模型的平稳性发生弱化。

• PSI同时也受到分组方式的影响。一般来说分地越细,PSI越低。

• PSI的计算与好、坏标签无关,因此不需要积累一个完整的表现期。

4.模型的调优

1)模型调优的必要性

模型需要进行必要的调优,当遇到如下情形时:

1,监控结果不满足要求

➢连续3个月的KS低于30%,AUC低于70%,PSI高于25%;

2,产品发生变化

➢额度提高,周期提高,利率降低;

3,人群发生变化

➢准入政策发生变化;

4,其他宏观因素发生变化

2)特征层面的调整

特征层面的调整通常分为2种:

1,舍弃或者新增特征

例如:舍弃“过去6个月的跨银行申请次数”,新增“过去3个月的跨银行申请次数”。

2,调整特征计算方法或者分箱方法

例如:对年龄进行重新分箱

调整的原则是:

当变量的PSI显著升高,或者IV显著降低时,需要做调整。

2)分数层面的调整

根据新的样本和(或)调整后的特征,重新进行模型训练,估计模型参数

要求:

• 新模型的KS、AUC等指标不低于原有模型以及30%和70%的标准;

• PSI不高于原有模型以及25%的标准

967

967

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?