简介:Retinex算法基于人类视觉模型,用于图像增强和改善对比度。算法通过分离图像的亮度和色彩信息,并对其进行分层处理,以达到增强暗部细节和控制亮部过曝的效果。在C++中实现Retinex算法需要包括预处理、亮度和色彩分离、对比度增强和融合步骤。本项目中包含了Retinex算法的源代码文件,通过理解和学习这些代码,可以深入掌握算法的实现细节。

1. Retinex算法原理与图像处理应用

1.1 Retinex算法简介

Retinex理论是由Edwin H. Land在20世纪70年代提出的,它是一种用来解释人类色彩知觉的理论。它表明,我们感知到的物体颜色是由物体反射的光线的光谱特性决定的,而与场景中的光线强度无关。这个理论为图像处理中的颜色恒常性问题提供了理论基础,并且是Retinex算法的基石。

1.2 Retinex算法的图像处理应用

在图像处理领域,Retinex算法主要用于图像增强,包括动态范围压缩、颜色恒常性和视觉细节增强等。动态范围压缩可改善图像的视觉效果,特别是在光照条件极端或对比度较高的情况下。颜色恒常性处理使得同一物体在不同光照条件下能保持相对稳定的颜色感知。而视觉细节增强,则通过增强图像中细节信息,提高了图像的可读性。

1.3 Retinex算法的工作原理

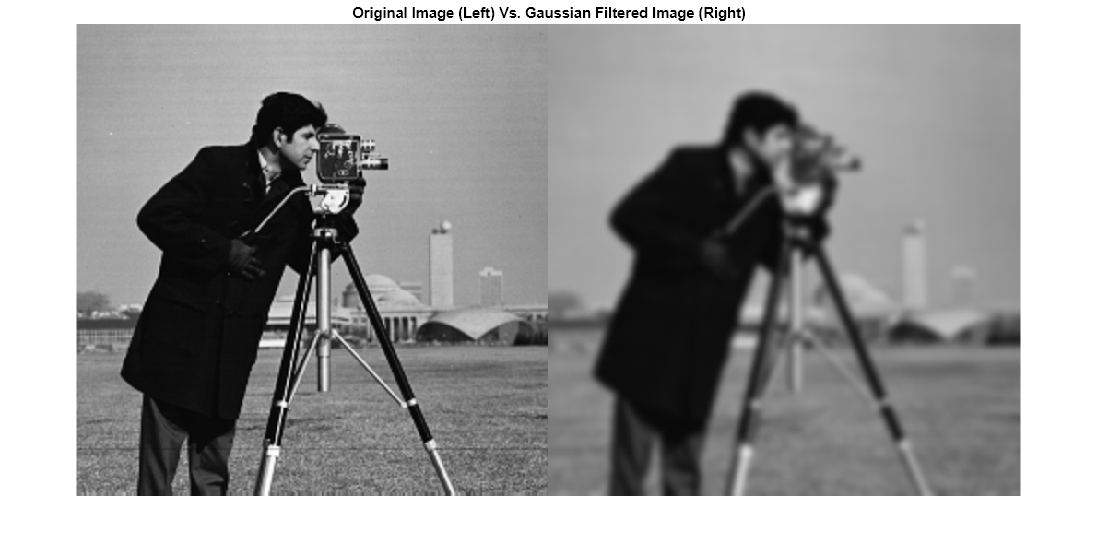

Retinex算法通常基于一个假设,即一个场景的照明可以看作是由一个低频分量表示,而物体反射的光线具有高频分量。算法的核心在于从图像中分离出照明分量和反射分量。这通常通过卷积操作完成,其中使用了一系列不同尺度的高斯滤波器。这样,我们可以得到对应于不同尺度的图像,从而推算出场景的照明分量和反射分量。通过分析和处理这些分量,最终重构出增强后的图像。

2. 图像亮度和色彩分离技术

2.1 色彩理论基础

2.1.1 RGB色彩空间

在数字图像处理领域,RGB色彩空间是最为常见的色彩表示方法之一。RGB色彩空间基于光的三原色理论,即红色(Red)、绿色(Green)、蓝色(Blue),通过不同强度的红绿蓝三色光混合,理论上可以产生其它任何颜色,这是因为在人眼的视网膜上存在三种类型的锥细胞,分别对红、绿、蓝三种光敏感。

RGB色彩空间广泛应用于计算机显示器、电视屏幕和数字摄影等领域。其值通常表示为三个介于0到255之间的整数,对应于红色、绿色和蓝色分量。为了进行色彩分离,首先需要了解RGB空间的特性。例如,RGB模型是加色模型,意味着通过增加某一颜色分量的亮度,总体色彩会趋向于这一颜色的明亮版本。

在图像亮度和色彩分离的上下文中,RGB色彩空间可以转换成其他色彩空间进行处理,如HSV色彩空间,这能够使得亮度分离更为直接。

2.1.2 HSV色彩空间

HSV色彩空间由色调(Hue)、饱和度(Saturation)和明度(Value)三个属性组成。该色彩空间更接近于人眼对颜色的感知方式,使得色彩的调整和分离更直观。

色调H代表颜色种类,它表示色彩的名称,例如红色、绿色等;饱和度S代表色彩的纯度,表示颜色的强度,饱和度越高,颜色越纯;明度V代表色彩的明亮程度。在图像处理中,亮度通常与明度值关联,因此通过调整明度V值,可以实现对图像亮度的增强或降低。

HSV色彩空间提供了一种方便的方法来分离和调整图像中的亮度和色彩信息。通过将图像从RGB色彩空间转换到HSV色彩空间,开发者可以独立地修改亮度而不影响色调和饱和度,这样就可以单独控制图像的亮度而不会引入色彩失真。

2.2 色彩分离方法

2.2.1 光照-反射模型

光照-反射模型是一种用于解释物体颜色表现的模型。在这个模型中,物体的颜色被看作是光照与物体表面反射特性的共同结果。光照强度影响了反射的光线的亮度,而反射特性则决定了物体的颜色。

在图像处理中,此模型对于理解和分离亮度和色彩信息至关重要。通过光照-反射模型,开发者可以实现对图像的光照条件进行建模,并尝试分离出图像的反射部分,从而得到更纯净的色彩信息,以便进行进一步处理。

2.2.2 色彩分离算法实现

在算法层面,色彩分离可以借助于各种图像处理技术实现,如使用Retinex算法对图像进行色彩和亮度分离。在本章节中,我们对RGB图像进行色彩分离的操作步骤进行详细解读。

首先,将RGB图像转换到HSV色彩空间。下面是相应的代码示例,展示如何使用Python和OpenCV库实现这一转换:

import cv2

import numpy as np

# 读取图像文件

image = cv2.imread('path_to_image.jpg')

# 将RGB图像转换到HSV空间

hsv_image = cv2.cvtColor(image, cv2.COLOR_RGB2HSV)

转换到HSV空间后,我们可以通过调整HSV值中的“V”分量来修改图像亮度,而不影响色调和饱和度。以下是修改亮度的代码示例:

# 提取V通道,并增加亮度值

v_channel = hsv_image[:,:,2].astype(np.float64)

v_channel = np.clip(v_channel * brightness_factor, 0, 255).astype(np.uint8)

# 重组HSV图像

hsv_image[:,:,2] = v_channel

# 转换回RGB空间

result_image = cv2.cvtColor(hsv_image, cv2.COLOR_HSV2RGB)

在上面的代码中,我们通过乘以一个亮度因子(brightness_factor)来增加亮度。值得注意的是,我们需要对结果进行类型转换并确保值在[0, 255]范围内。调整完毕后,再将HSV图像转回RGB格式以供显示或进一步处理。

3. 预处理步骤和直方图均衡化

预处理是图像处理流程中不可或缺的一环,其目的在于改善图像的质量,为后续的处理步骤奠定基础。图像预处理往往包括去噪、增强、灰度化等步骤,而直方图均衡化是一种常用的图像增强技术,用以提升图像的对比度。本章将详细介绍预处理的目的和方法,以及直方图均衡化的概念和算法实现。

3.1 预处理的目的和方法

3.1.1 去噪声技术

图像在采集、传输过程中,常受到各种噪声的影响,导致图像质量下降。去噪技术旨在从图像中去除或减少噪声的影响,提高图像的清晰度。

常见的去噪技术包括:

- 均值滤波:通过计算图像块的平均值来代替中心像素值,实现平滑处理。

- 中值滤波:将中心像素值替换为其邻域像素的中值,有效去除椒盐噪声。

- 高斯滤波:根据高斯分布的权重对像素值进行加权平均,适用于去除高斯噪声。

// 伪代码:中值滤波去噪

void median_filter(unsigned char** image, int width, int height) {

unsigned char** filtered_image = create_image_like(image);

for (int y = 1; y < height - 1; ++y) {

for (int x = 1; x < width - 1; ++x) {

// 获取邻域像素值

unsigned char* neighborhood = get_neighborhood(image, x, y);

// 计算中值

unsigned char median = find_median(neighborhood);

// 设置中心像素值

filtered_image[y][x] = median;

}

}

// 应用滤波结果

apply_filtered_image(image, filtered_image);

free(neighborhood);

}

参数说明: - image :待处理的图像数据。 - width :图像宽度。 - height :图像高度。 - filtered_image :滤波后的图像数据。

逻辑分析: 上述代码段展示了中值滤波的核心逻辑。首先创建一个新的图像用于存放滤波结果,接着遍历图像的每个像素点(边缘点除外),提取当前像素点的邻域值,然后计算中值替换中心像素值。最后将滤波后的图像与原图像合并,完成滤波操作。

3.1.2 图像增强技术

图像增强技术的目的在于改善图像的视觉效果,增加有用信息的可见度。通过图像增强,可以调整图像的亮度、对比度,甚至增强特定的图像特征。

主要的图像增强技术包括:

- 对比度调整:通过修改像素值分布,增加图像的对比度。

- 锐化处理:通过增强图像的高频部分来提高图像的清晰度。

- 伽马校正:调整图像的亮度,使图像看起来更自然。

// 伪代码:伽马校正

void gamma_correction(unsigned char** image, float gamma, int width, int height) {

unsigned char** gamma_corrected = create_image_like(image);

float inv_gamma = 1.0 / gamma;

for (int y = 0; y < height; ++y) {

for (int x = 0; x < width; ++x) {

float value = powf((float)image[y][x] / 255.0, inv_gamma) * 255.0;

gamma_corrected[y][x] = (unsigned char)min(255, value);

}

}

// 应用校正结果

apply_filtered_image(image, gamma_corrected);

}

参数说明: - image :待处理的图像数据。 - gamma :伽马值,用于调整图像的亮度。 - width :图像宽度。 - height :图像高度。 - gamma_corrected :伽马校正后的图像数据。

逻辑分析: 这段代码通过伽马校正来调整图像的亮度。代码首先创建一个与原图像尺寸相同的新图像。接着,对于原图像中的每个像素值,应用伽马公式进行变换,最后将变换后的图像数据应用到原图上,完成伽马校正。

3.2 直方图均衡化

3.2.1 直方图的概念

直方图是图像处理中常用的一种表示图像亮度分布的方法。图像的直方图反映了图像中各个亮度值出现的频率。直方图的横轴表示像素值,纵轴表示该像素值出现的次数。

直方图均衡化是基于直方图的一种图像增强技术。它通过将原始图像的直方图变换为均匀分布的直方图来增强图像的对比度。

3.2.2 均衡化算法实现

直方图均衡化的关键步骤包括:

- 计算累积分布函数(CDF)。

- 应用CDF到原始图像,得到均衡化的图像。

- 为了获得更好的效果,均衡化后的图像需要被线性拉伸至合适的范围。

// 伪代码:直方图均衡化

void histogram_equalization(unsigned char** image, int width, int height) {

int histogram[256] = {0};

// 构建直方图

for (int y = 0; y < height; ++y) {

for (int x = 0; x < width; ++x) {

histogram[image[y][x]]++;

}

}

// 计算累积分布函数(CDF)

int cdf[256] = {0};

for (int i = 0; i < 256; ++i) {

cdf[i] = histogram[i] + (i > 0 ? cdf[i-1] : 0);

}

// 应用CDF进行均衡化

unsigned char** equalized_image = create_image_like(image);

int max_value = cdf[255];

for (int y = 0; y < height; ++y) {

for (int x = 0; x < width; ++x) {

int equalized_value = (cdf[image[y][x]] * 255) / max_value;

equalized_image[y][x] = (unsigned char)equalized_value;

}

}

// 应用均衡化结果

apply_filtered_image(image, equalized_image);

}

参数说明: - image :待均衡化的图像数据。 - width :图像宽度。 - height :图像高度。 - equalized_image :均衡化后的图像数据。

逻辑分析: 上述代码段通过构建直方图,计算累积分布函数(CDF),再将CDF应用于图像来实现直方图均衡化。每一步都有注释说明,代码中展示了如何通过线性变换调整像素值,增强图像的对比度。

此章节内容通过介绍预处理的去噪和图像增强技术,以及直方图均衡化的基本原理和实现方法,为读者提供了深入理解图像预处理步骤的基础。这些技术在图像处理中起着至关重要的作用,有助于后续处理步骤中更好地分析和应用Retinex算法进行图像色彩和亮度的调整。

4. 对比度增强技术

4.1 对数变换和指数变换

4.1.1 对数变换原理

在图像处理中,对数变换是一种常用的技术,主要用于增强图像的暗部细节,从而改善整体的视觉效果。对数变换的基本思想是利用对数函数来扩展图像的灰度范围,使得低灰度区域的细节更加明显。

对数变换的数学表达式通常为: [ S = c \cdot \log(1 + r) ] 其中,( r )是输入图像的像素值,( S )是变换后的像素值,( c )是一个常数,用以调节输出的灰度范围。

从变换的公式可以看出,对数变换在低灰度区域具有较高的增益,而高灰度区域增益较低。这种非线性变换可以压缩图像的高亮度区域,同时扩展低亮度区域,从而在视觉上增加对比度,尤其是对那些暗部细节不明显的图像非常有效。

4.1.2 指数变换原理

与对数变换相对的是指数变换。指数变换的目的是相反的,它主要用于增强图像的亮部细节。指数变换的数学表达式为: [ S = c \cdot (e^{ar} - 1) ] 其中,( a )是变换的参数,( c )同样是用来调整输出灰度范围的常数。

从公式可以看出,指数变换在高灰度区域具有更高的增益,这使得图像的亮部细节得以放大,暗部细节则被压缩。这种变换对于具有大量高亮度细节的图像非常有用,比如在卫星图像或者一些医学图像的处理中,常常会用到指数变换来提高亮区的细节显示。

对比度增强的代码实现

下面的代码展示了如何使用Python中的NumPy库来实现对数变换和指数变换。

import numpy as np

import matplotlib.pyplot as plt

# 读取图像数据

image = plt.imread('path/to/your/image.jpg')

# 对数变换

def log_transform(image, c):

log_image = c * np.log(1 + image)

return log_image

# 指数变换

def exponential_transform(image, c, a):

exponential_image = c * (np.exp(a * image) - 1)

return exponential_image

# 应用对数变换和指数变换

c = 255 / np.log(1 + np.max(image))

log_image = log_transform(image, c)

a = 1 / np.max(image)

exp_image = exponential_transform(image, c, a)

# 显示变换后的图像

plt.figure(figsize=(15, 5))

plt.subplot(1, 3, 1)

plt.imshow(image, cmap='gray')

plt.title('Original Image')

plt.subplot(1, 3, 2)

plt.imshow(log_image, cmap='gray')

plt.title('Log Transformed Image')

plt.subplot(1, 3, 3)

plt.imshow(exp_image, cmap='gray')

plt.title('Exponential Transformed Image')

plt.show()

在上述代码中,我们首先读取一张图像,然后定义了对数变换和指数变换的函数。之后,我们分别对原始图像应用这两种变换,并将变换后的结果进行显示。这里我们使用了 matplotlib 库来显示图像, numpy 库来处理图像数组。

需要注意的是,对数变换和指数变换在处理图像时可能会导致图像的亮度反转,为了防止图像过暗或过亮,通常需要对参数进行适当的调整。在实践中,开发者需要根据实际需要对这些参数进行微调,以达到最佳的视觉效果。

5. 多尺度分析和滤波器使用

5.1 多尺度分析概念

5.1.1 尺度空间理论

尺度空间理论是一种用于描述视觉信息在不同观察尺度下的表达方式。在图像处理领域,尺度空间可以视为一系列通过某种平滑过程得到的图像序列,这些图像描述了从细节到整体的各个层次的视觉信息。在多尺度分析中,图像被分解为多个尺度层次,每个层次代表了不同的空间频率信息。通过这种方式,可以有效地对图像进行特征提取、边缘检测、纹理分析等操作。

5.1.2 多尺度分解方法

多尺度分解是一种将图像分解为不同尺度信息的技术。常见的多尺度分解方法包括高斯金字塔和拉普拉斯金字塔。高斯金字塔通过重复应用高斯模糊和下采样的过程构建,而拉普拉斯金字塔则是通过从高斯金字塔中相邻层的差分来构建。这些分解方法可以用于图像的细节增强、纹理分割以及多尺度的图像融合等应用。

5.2 滤波器设计

5.2.1 空间域滤波器

空间域滤波器直接在原始图像的像素上操作,通过对邻域像素的加权平均来实现平滑、锐化或其他类型的图像处理。常见的空间域滤波器包括均值滤波器、中值滤波器和高斯滤波器等。这些滤波器对于去除噪声、模糊图像和强调边缘等具有重要作用。例如,均值滤波器可以减少图像噪声,而中值滤波器特别适用于去除椒盐噪声。

// 示例代码:均值滤波器的C语言实现

void mean_filter(unsigned char *input, unsigned char *output, int width, int height, int filter_size) {

int sum, i, j, k, l;

int start, end;

int filter_radius = filter_size / 2;

for (i = 0; i < height; i++) {

for (j = 0; j < width; j++) {

sum = 0;

for (k = -filter_radius; k <= filter_radius; k++) {

for (l = -filter_radius; l <= filter_radius; l++) {

start = max(0, i + k);

end = min(height - 1, i + k + filter_size - 1);

sum += input[start * width + j + l];

}

}

sum = sum / (filter_size * filter_size);

output[i * width + j] = (unsigned char)sum;

}

}

}

在上述代码中, mean_filter 函数实现了一个均值滤波器,它接受输入图像 input ,输出图像 output ,图像的 width 和 height ,以及滤波器的大小 filter_size 。通过双层循环遍历图像的每个像素,并计算以该像素为中心的滤波器窗口内所有像素的均值来得到输出像素的值。

5.2.2 频域滤波器

频域滤波器则是通过在图像的频率域中进行滤波操作来处理图像。典型的频域滤波器包括低通滤波器和高通滤波器。低通滤波器可以用于平滑图像,因为它们允许低频分量通过,而抑制高频分量,这通常对应于图像中的噪声和边缘。相反,高通滤波器可以用于增强图像的边缘信息,因为它们保留高频分量而去除低频分量。频域滤波通常通过快速傅里叶变换(FFT)来实现,这可以将图像从空间域转换到频率域。

// 示例代码:低通滤波器的C语言实现(频域)

#include <stdio.h>

#include <stdlib.h>

#include <math.h>

#include <complex.h>

// 假设input是图像数据,output是滤波后的图像数据,N是图像的尺寸

void low_pass_filter(unsigned char *input, unsigned char *output, int N) {

// 这里需要实现图像数据到复数的转换,进行FFT变换,应用低通滤波器,再进行逆变换等步骤

// 这部分代码较为复杂,涉及到复数运算,通常会使用现成的FFT库来实现

// 这里只提供概念性描述,并不展示完整代码

}

在上述概念性代码中, low_pass_filter 函数应该实现从输入图像 input 到输出图像 output 的低通滤波过程,包括图像数据转换为复数、进行FFT变换、应用低通滤波器、以及进行逆FFT变换。通常情况下,为了处理的方便和效率,会使用专门的数学库来进行FFT相关的运算。

上述章节介绍了多尺度分析与滤波器使用的基础知识,从理论基础到实际应用层面的代码实现,全面探讨了空间域和频域滤波器在图像处理中的应用。下一章节将讨论图像融合策略。

6. 图像融合策略

6.1 图像融合的原理

6.1.1 融合层次分析

图像融合是将来自不同源的两个或多个图像结合在一起,以产生一幅更具有信息量的图像的过程。融合层次可以分为像素级、特征级和决策级。

-

像素级融合 直接在图像像素层面上进行处理,是最基础也是最常用的方法。它涉及将不同图像在同一像素位置的灰度值或颜色值进行综合,以生成新的像素值。

-

特征级融合 则是在特征提取后,对这些特征进行分析和处理,这种方法可以在去除冗余信息的同时保留关键特征,提高融合效率。

-

决策级融合 在更高层次上进行,通常是基于像素级和特征级融合后的结果,通过一定的决策规则来确定最终的图像内容。它适用于需要进行复杂信息处理的情况。

6.1.2 融合规则

融合规则在图像融合中起到决定性作用,常见的融合规则有:

-

加权平均融合规则 ,通过不同的权重分配给不同的图像,然后进行加权平均计算,简单易行,但可能导致图像细节的损失。

-

最大选择规则 ,选择源图像中的最大像素值作为融合后的像素值,适合于目标检测等应用,但可能导致亮度不均。

-

基于小波变换的融合规则 ,利用小波变换在不同尺度上进行融合,能更好地保留图像的细节信息和边缘特征。

6.1.3 融合效果的影响因素

-

图像配准精度 ,图像融合的第一步是确保所有参与融合的图像都经过精确的配准,以保证同一物理位置在各个图像中有一一对应关系。

-

融合算法的效率 ,影响融合速度和质量,复杂算法可能带来更高的准确度,但也可能增加计算时间。

-

应用场景 ,不同的应用场景对图像融合的要求不尽相同,例如遥感图像融合需要保留更多的地物信息,而医学图像融合则需要突出特定器官的细节。

6.2 融合技术应用

6.2.1 多分辨率融合

多分辨率融合通常利用图像在不同分辨率下的细节信息,通过金字塔结构将这些信息综合起来。根据金字塔的构建方式,可以分为拉普拉斯金字塔、比率金字塔和对比度金字塔等。

-

拉普拉斯金字塔 通过保留原图像的主要成分,并将其与低通滤波后的图像相减,得到含有细节信息的图像。这种方式特别适合细节强化。

-

比率金字塔融合 则直接采用比率形式,保留了更多的高频细节,但可能在信噪比方面有所损失。

6.2.2 基于Retinex的融合方法

Retinex理论提出,图像可以被看作是光照射物体表面产生的光照分量和物体表面固有反射率的乘积。基于Retinex的融合方法通常涉及对多个图像的光照分量和反射率分量分别进行处理。

-

光照分量的处理 ,通常对图像进行对数变换,将其转换到对数域,再通过滤波器提取光照分量。

-

反射率分量的处理 ,对处理后的光照分量进行逆变换,得到反射率分量,最后将不同图像的反射率分量按融合规则结合起来。

6.2.3 应用示例和代码实现

下面提供一个简化的多分辨率融合的Python代码示例,使用PIL和OpenCV库进行图像融合处理。这个例子使用了简单的加权平均规则,在高分辨率和低分辨率图像之间进行权重分配,以展示基本的融合逻辑。

import cv2

from PIL import Image

def pyramidBlend(im1, im2, level):

pyramid1 = [im1]

pyramid2 = [im2]

for i in range(level):

im1 = cv2.pyrDown(im1)

im2 = cv2.pyrDown(im2)

pyramid1.append(im1)

pyramid2.append(im2)

blended = Image.blend(pyramid1[-1], pyramid2[-1], 0.5)

for i in range(level - 1, -1, -1):

blended = cv2.pyrUp(blended)

blended = Image.blend(pyramid1[i], blended, 0.5)

return blended

# 读取图像

im1 = cv2.imread('image1.jpg')

im2 = cv2.imread('image2.jpg')

# 设置金字塔层数为3

blended_image = pyramidBlend(im1, im2, 3)

# 保存融合后的图像

blended_image.save('blended.jpg')

以上代码先构建两个图像的高斯金字塔,然后在每一层执行简单的融合操作,最后逐层向上重建,实现最终的融合图像。

在实际应用中,多分辨率融合方法如基于小波变换的融合效果通常优于上述简单的加权平均方法。需要根据具体需求选择合适的融合方法和规则。

7. 源代码文件分析及图像质量评估

7.1 源代码文件分析

7.1.1 gretinex.c代码解析

在本节中,我们将深入解析 gretinex.c 的源代码,它是一个用于实现Retinex算法的开源代码文件。首先,我们从文件结构开始,然后逐段分析关键的函数和算法实现步骤。

#include <stdio.h>

#include <stdlib.h>

#include <math.h>

#include <image.h> // 假设存在一个图像处理的库

// 函数原型声明

void retinex_process(Image *img);

Image *log_transform(Image *img);

int main(int argc, char *argv[]) {

if (argc < 2) {

fprintf(stderr, "Usage: %s <image_file>\n", argv[0]);

return 1;

}

Image *img = read_image(argv[1]); // 读取图像文件

if (!img) {

fprintf(stderr, "Error reading image\n");

return 1;

}

retinex_process(img); // 应用Retinex处理

save_image(img, "retinex_result.png"); // 保存处理后的图像

free_image(img); // 释放图像内存

return 0;

}

void retinex_process(Image *img) {

Image *img_log = log_transform(img); // 对图像进行对数变换

// 在此处,我们可以对img_log进行进一步处理,例如直方图均衡化或滤波操作

// ...

// 最终,我们可以将处理后的图像转换回原始范围

normalize_image(img_log); // 归一化图像到合适的范围

overwrite_image(img, img_log); // 将处理后的图像覆盖回原图

free_image(img_log); // 释放临时图像内存

}

Image *log_transform(Image *img) {

Image *img_log = copy_image(img); // 复制图像以进行操作

// 对图像的每个像素应用对数变换

for (int x = 0; x < img->width; x++) {

for (int y = 0; y < img->height; y++) {

int val = img->data[x][y];

img_log->data[x][y] = (val == 0) ? 0 : (int)(log(val) / log(255.0) * 255.0);

}

}

return img_log;

}

7.1.2 retinex.cpp代码解析

现在,我们将分析 retinex.cpp ,这个文件实现了一个基于Retinex算法的图像处理功能。下面的代码段展示了Retinex算法处理的主要步骤:

#include <iostream>

#include <vector>

#include <cmath>

#include "Image.h" // 自定义图像处理库

using namespace std;

void retinex_process(Image &img) {

Image img_log = img.log_transform(); // 对图像进行对数变换

// 可以添加更多的图像处理步骤,如滤波、均衡化等

img.normalize(); // 归一化处理后的图像

img.overwrite(img_log); // 将处理后的图像覆盖回原图

}

Image Image::log_transform() {

Image img_log = copy(); // 复制图像

for (int x = 0; x < width; ++x) {

for (int y = 0; y < height; ++y) {

int &pixel = get_pixel(x, y);

if (pixel == 0) pixel = 1; // 避免除以零

pixel = static_cast<int>(log(pixel) / log(255.0) * 255.0);

}

}

return img_log;

}

int main() {

Image img = Image("input.jpg"); // 读取图像文件

retinex_process(img); // 应用Retinex算法

img.save("output.jpg"); // 保存结果图像

return 0;

}

7.2 图像质量评估指标

7.2.1 信噪比(PSNR)

信噪比(Peak Signal-to-Noise Ratio, PSNR)是衡量图像质量常用的客观指标。PSNR数值越高表示图像质量越好。其计算公式如下:

[ PSNR = 10 \cdot \log_{10} \left( \frac{MAX_I^2}{MSE} \right) ]

其中,(MAX_I)是图像像素的最大可能值(对于8位图像而言,通常是255),MSE是均方误差。均方误差是原始图像和处理后图像之间差值平方的平均值。

7.2.2 结构相似性(SSIM)

结构相似性(Structural Similarity, SSIM)是一种衡量两个图像相似度的指标,它考虑了图像的亮度、对比度和结构信息。SSIM的取值范围是[-1, 1],1表示两张图像完全相同。SSIM的计算公式较为复杂,涉及到亮度、对比度和结构三个方面的计算,这里简要介绍其基本思想。

SSIM的计算公式为:

[ SSIM(x, y) = \frac{(2\mu_x\mu_y + C_1)(2\sigma_{xy} + C_2)}{(\mu_x^2 + \mu_y^2 + C_1)(\sigma_x^2 + \sigma_y^2 + C_2)} ]

其中,(x)和(y)分别是原始图像和处理后图像的亮度,(\mu_x)和(\mu_y)是两个图像的均值,(\sigma_x^2)和(\sigma_y^2)是方差,(\sigma_{xy})是协方差,(C_1)和(C_2)是稳定方差的小常数。

在实际应用中,PSNR和SSIM可以结合使用,为图像质量提供全面的评估。PSNR主要关注于图像的像素误差,而SSIM则提供了更为细致的结构相似性分析。在优化图像处理算法时,可以同时关注这两个指标,以实现更好的处理效果。

简介:Retinex算法基于人类视觉模型,用于图像增强和改善对比度。算法通过分离图像的亮度和色彩信息,并对其进行分层处理,以达到增强暗部细节和控制亮部过曝的效果。在C++中实现Retinex算法需要包括预处理、亮度和色彩分离、对比度增强和融合步骤。本项目中包含了Retinex算法的源代码文件,通过理解和学习这些代码,可以深入掌握算法的实现细节。

2820

2820

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?