简介:粒子群优化算法(PSO)是一种启发式优化技术,模拟鸟群觅食行为。它通过粒子在搜索空间的随机飞行来寻找最优解。在单目标PSO中,算法致力于找到一个使目标函数最大化或最小化的单一最优解。通过初始化、速度和位置更新、适应度评价以及终止条件,PSO可以应用于工程和科学问题,如机器学习参数调优。算法的简单性和灵活性使其成为解决非线性、多模态和高维优化问题的有效工具,但也面临易陷入局部最优、依赖于参数设置等挑战。

1. 粒子群优化算法(PSO)概述

1.1 PSO简介

粒子群优化(Particle Swarm Optimization, PSO)是一种模拟鸟群觅食行为的群体智能算法。它通过群体中个体的协作和信息共享来寻找最优解,广泛应用于工程优化、智能控制、机器学习等领域。PSO的核心思想是借鉴生物群体中的社会行为,通过简单个体间的交互作用来实现复杂问题的求解。

1.2 发展历程

粒子群优化算法由Kennedy和Eberhart于1995年提出,受到人工生命理论的启发。最初模型简单,随着研究的深入,后续学者对PSO进行了多次改进和扩展,如引入惯性权重、个体和全局最优位置的动态调整等,使得PSO具有更好的寻优能力和鲁棒性。

1.3 应用价值

PSO算法因其简单的概念模型、易于实现、寻优速度快等优点,被广泛应用于连续和离散问题的优化。它不仅用于解决传统优化问题,还能作为其他高级算法的辅助模块,例如在进化算法中,PSO可用来优化遗传算法的参数。其在实际应用中表现出的灵活性和有效性,使PSO成为解决多变量、多峰值复杂问题的有效工具。

在此章中,我们对PSO有了一个初步的认识,下一章我们将深入探讨PSO算法的理论基础和初始化方法,这将有助于我们更好地理解后续章节中关于PSO性能优化与应用的讨论。

2. PSO算法的理论基础和初始化方法

2.1 粒子群优化算法的基本原理

粒子群优化(Particle Swarm Optimization, PSO)算法是受鸟群觅食行为启发而形成的一种群体智能算法。它是一种基于群体迭代的优化工具,通过个体间的协作和信息共享来寻找问题的最优解。每个粒子在解空间中飞动,通过不断地迭代更新自己的位置和速度,最终逼近或达到最优解。

2.1.1 粒子群优化算法的定义

粒子群优化算法模拟鸟群的社会行为。每个粒子代表问题空间中的一个潜在解,粒子通过跟踪个体历史最佳位置和群体历史最佳位置来更新自己的速度和位置。PSO算法主要由以下几个步骤构成:

- 初始化一个随机种群。

- 评估每一个粒子的适应度。

- 更新个体和全局最优解。

- 根据更新的个体和全局最优解,调整粒子的速度和位置。

- 重复步骤2-4,直到满足终止条件。

PSO算法适用于解决连续空间优化问题,尤其在多峰和多变量的优化问题上显示出强大的搜索能力。

2.1.2 算法的生物学背景

PSO算法的生物学背景主要源自于鸟群和鱼群等社会性动物的群体觅食行为。在自然界中,动物群体往往通过简单的个体行为规则和局部信息交流实现复杂行为,如群体迁徙、觅食、繁殖等。PSO借鉴了这种群体智能的概念,每个粒子在搜索空间中根据自己的经验和群体经验来调整运动方向和速度,从而寻找到问题的最优解。

2.2 算法初始化的重要性与方法

PSO算法的初始化是指对粒子群中的粒子进行位置和速度的随机赋值,这是算法搜索过程的起点。一个良好的初始化过程可以有效提升算法的收敛速度和解的质量。

2.2.1 初始化的目的和意义

初始化的目的在于为算法提供一个多样化的初始种群,以增加算法探索解空间的能力。良好的初始化可以避免粒子群过早地陷入局部最优解,从而提高全局搜索的能力。

初始化的意义体现在:

- 多样性:确保初始粒子的多样性,可以覆盖解空间的不同区域,避免局部搜索。

- 平衡性:粒子应该均匀地分布在解空间中,避免在某一区域出现粒子过于集中的现象。

- 适应性:初始化方法应该适应问题的特性,有些问题可能需要特定的初始化策略来保证搜索的效率。

2.2.2 初始化参数的确定方法

初始化参数包括粒子的位置和速度。位置通常是在问题解空间内随机生成,而速度则根据位置和局部/全局最优解计算得到。确定初始化参数的方法有:

- 随机初始化:在给定的解空间范围内,随机生成粒子的位置和速度。

- 带有信息的初始化:例如,根据问题的特定知识来设定粒子的初始位置和速度。

- 均匀初始化:利用均匀分布随机生成初始位置和速度,以保证每个粒子代表解空间的不同区域。

以下是一个PSO算法初始化的伪代码示例:

初始化粒子种群:

for 每个粒子i in 粒子种群:

初始化粒子i的位置:位置i = 随机生成(问题解空间)

初始化粒子i的速度:速度i = 随机生成(速度范围)

计算粒子i的适应度:适应度i = 评估(位置i)

设置全局最优粒子:全局最优粒子 = 粒子种群中的最佳适应度粒子

while (终止条件未满足):

for 每个粒子i in 粒子种群:

更新个体最优粒子:如果 (适应度i > 个体最优适应度) 则

个体最优粒子 = 粒子i

个体最优位置 = 粒子i的位置

更新全局最优粒子:如果 (适应度i > 全局最优适应度) 则

全局最优粒子 = 粒子i

更新粒子的速度和位置:根据速度更新公式和位置更新公式来调整粒子i的速度和位置

if (全局最优适应度达到预定的终止条件):

终止PSO算法

初始化参数的正确设定,为PSO算法后续的寻优过程打下了基础,它直接影响算法的收敛速度、解的质量以及避免局部最优的能力。通过不断实践和测试,研究者可以找到针对特定问题更为合适的初始化方法。

3. PSO的速度和位置更新机制

粒子群优化算法的核心在于粒子的动态更新,而这种更新主要通过速度和位置的计算来实现。速度决定了粒子移动的方向和距离,而位置则代表了粒子在搜索空间中的具体位置。在这一章节中,我们将深入探讨速度和位置更新机制的细节,并通过具体的公式和案例来解释这些机制是如何影响粒子群优化算法性能的。

3.1 速度更新公式详解

速度更新是粒子群优化算法中最为关键的步骤之一。每一个粒子在每次迭代中都会根据其历史最优位置以及群体中所有粒子的最优位置来调整自己的速度。

3.1.1 惯性权重的引入与作用

惯性权重(Inertia Weight)是速度更新公式中的一个重要参数,它的引入主要是为了控制粒子的探索(exploration)和利用(exploitation)行为的平衡。一个较大的惯性权重倾向于使粒子在解空间中进行更广泛的搜索,而较小的惯性权重则有助于粒子在特定区域进行精细的搜索。

公式:

[ v_{i}(t+1) = w \cdot v_{i}(t) + c_1 \cdot rand() \cdot (pbest_{i} - x_{i}(t)) + c_2 \cdot rand() \cdot (gbest - x_{i}(t)) ]

其中,( v_{i}(t+1) )是粒子i在t+1时刻的速度,( v_{i}(t) )是粒子i在t时刻的速度,( pbest_{i} )是粒子i的历史最佳位置,( gbest )是群体中所有粒子的历史最佳位置,( c_1 )和( c_2 )是学习因子,( w )是惯性权重,( rand() )是一个在[0,1]区间内均匀分布的随机数。

3.1.2 学习因子的作用及其对算法性能的影响

学习因子,或称为加速系数(Acceleration Coefficients),是PSO算法中控制粒子向其个人最佳位置以及群体最佳位置学习速率的参数。它由两个独立的参数( c_1 )和( c_2 )组成,分别代表粒子个体经验和社会经验的影响。

如果( c_1 )较大,粒子将更加关注个人最佳位置,从而进行局部搜索;如果( c_2 )较大,则粒子更倾向于向群体最佳位置学习,进行全局搜索。因此,学习因子的调整对算法的收敛性和多样性有着重要影响。

3.2 位置更新与粒子的移动策略

在速度更新之后,粒子的位置将根据新的速度值进行更新。位置更新是粒子在解空间中的实际移动,直接影响到算法的探索过程。

3.2.1 位置更新公式推导

位置更新公式如下:

[ x_{i}(t+1) = x_{i}(t) + v_{i}(t+1) ]

这里,( x_{i}(t+1) )是粒子i在t+1时刻的位置,( x_{i}(t) )是粒子i在t时刻的位置,( v_{i}(t+1) )是在t+1时刻的速度。

3.2.2 粒子如何根据速度和位置更新进行移动

在位置更新后,每个粒子会移动到新的位置。这个位置的更新应确保不会超出问题定义的边界。在实际应用中,如果粒子的新位置超出了定义域,通常会采取一种策略来处理这种情况,比如简单地将粒子"反射"回搜索空间,或者限制其在边界内移动。

例如,如果某个粒子试图移动到一个其速度值对应的负坐标,我们可以将其"反射"回来,确保它保持在搜索空间内。

表格 1:粒子移动策略示例

| 粒子位置 | 速度值 | 新位置计算 | 处理边界超出情况 | |-----------|--------|-------------|------------------| | x = 0.1 | -0.5 | 0.1 - 0.5 = -0.4 | 如果-0.4超出下界,则设置x = 0 | | x = 0.9 | 0.6 | 0.9 + 0.6 = 1.5 | 如果1.5超出上界,则设置x = 1 |

代码块 1:一个简单的PSO粒子位置更新的Python代码实现

# 假设我们有粒子的当前位置x, 粒子的速度v, 以及位置的上界upper_limit和下界lower_limit

upper_limit = 1.0 # 位置上界

lower_limit = 0.0 # 位置下界

# 位置更新

new_position = x + v

# 边界处理

if new_position < lower_limit:

new_position = lower_limit

elif new_position > upper_limit:

new_position = upper_limit

以上代码块展示了如何处理粒子位置的更新,并包含简单的边界处理逻辑。代码中首先计算新位置,然后检查是否超出定义的边界,并相应地进行调整。

mermaid流程图 1:粒子位置更新处理流程

graph LR

A[开始] --> B[计算新位置]

B --> C{是否超出边界?}

C -- 是 --> D[处理超出的边界]

C -- 否 --> E[更新粒子位置]

D --> E[继续下一步]

E --> F[结束]

mermaid流程图 1 展示了位置更新后的边界处理流程,提供了直观的逻辑理解。

通过以上对速度和位置更新机制的深入分析,我们可以发现粒子群优化算法中的动态调整过程是极其关键的。粒子如何根据速度和位置的更新进行移动,不仅涉及到基本的数学运算,还与算法的边界处理策略息息相关。理解并合理利用这些机制,对于提升粒子群优化算法的性能至关重要。

4. PSO中的适应度函数评估与终止条件

4.1 适应度函数的设计与实现

适应度函数的概念和作用

适应度函数在粒子群优化(PSO)算法中扮演着至关重要的角色。它定义了粒子群优化中每个粒子的“适应度”,即评估粒子位置好坏的标准。在优化问题中,每个粒子的当前位置代表了解空间中的一个解,适应度函数则根据问题的性质,对这些解进行评价,判断它们的优劣。

适应度函数的概念直接来源于达尔文的自然选择理论,即“适者生存”。在算法中,适应度高的粒子更有可能被选为历史最优解或群体最优解,进而影响其他粒子的位置更新。因此,适应度函数的设计直接影响到PSO算法的收敛速度和找到的最优解的质量。

如何设计有效的适应度函数

设计一个有效的适应度函数需要对优化问题有深刻的理解。以下是设计适应度函数时需要考虑的几个关键点:

-

明确性(Specificity) :适应度函数应直接反映出问题的优化目标,不应含糊不清。每个粒子的适应度值都应明确指示其代表解的质量。

-

相关性(Relevance) :适应度函数应与问题的目标紧密相关,确保算法优化的方向正确。

-

灵敏性(Sensitivity) :适应度函数应对目标函数的微小变化敏感,以便于算法区分不同的解。

-

计算效率(Computational Efficiency) :适应度函数的计算不应过于复杂,否则会拖慢整个PSO算法的运行速度。

-

适应性(Scalability) :适应度函数应能够适应问题规模的变化,对于大规模问题仍然保持有效。

举个例子,在一个工程优化问题中,可能的适应度函数是总成本或总能耗的最小化,而在机器学习参数优化问题中,适应度函数可能是交叉验证精度的最大化。

4.2 终止条件的设定与算法效率

终止条件的类型和选择

PSO算法在执行过程中需要一个明确的终止条件以结束迭代。终止条件的类型主要取决于问题的具体要求和优化的目标。常见的终止条件包括:

-

最大迭代次数(Max Iterations) :算法达到预设的最大迭代次数时终止。这是一种简单且常用的终止条件。

-

收敛性条件(Convergence Criteria) :当解空间中的解变化量小于某一阈值,或者粒子群的全局最优解在连续多次迭代中没有显著改善时,算法可以终止。

-

时间限制(Time Limit) :在规定的时间内没有找到满意的解或算法达到预设时间限制时停止。

-

解的质量(Solution Quality) :当找到的解达到某个预定义的质量标准时,例如达到一定的适应度阈值,算法可以终止。

选择适当的终止条件非常重要,它直接关系到算法的效率和解的质量。在实际应用中,可能需要根据问题的特性结合多种终止条件来提高PSO的性能。

终止条件对算法效率和解质量的影响

终止条件的设定对于PSO算法的性能有显著的影响。正确的终止条件设置能够确保算法在适当的时候停止,避免无效的计算,从而提高算法的效率。

-

效率提升 :过早的终止会导致算法可能错过更好的解;而过晚的终止则意味着在已经收敛到足够好的解后仍然进行不必要的计算。

-

解质量保证 :确保算法在解的质量达到要求之前不会过早停止是关键。设置正确的收敛性条件可以保证找到的解在实际应用中是可接受的。

在实际应用中,需要通过实验和经验来调整终止条件,找到针对特定问题最优的终止策略。例如,可以在保证解质量的前提下,设置一个最大迭代次数,并结合收敛性条件作为辅助终止条件,以达到效率与解质量的平衡。

5. PSO算法的参数调整与优化策略

5.1 参数调整的重要性

粒子群优化算法(PSO)的性能在很大程度上依赖于参数的设置。在本小节中,我们将深入探讨参数对PSO性能的影响,并介绍参数选择的一般原则和方法。

5.1.1 参数对PSO性能的影响

PSO算法有两个主要的参数:惯性权重(w)和学习因子(c1, c2)。惯性权重控制粒子的动量,影响算法的探索和开发平衡。较大的惯性权重有助于算法探索新的搜索空间,而较小的惯性权重有利于在已知区域内进行精细搜索。学习因子则控制粒子向自身最佳经验和群体最佳经验的学习程度。通常,c1影响个体经验的学习,而c2影响群体经验的学习。参数选择不当可能导致算法收敛过快或过慢,甚至陷入局部最优解。

5.1.2 参数选择的一般原则和方法

参数选择的黄金法则是经验与实验相结合。一般原则包括:

- 开始时设置较高的惯性权重和学习因子,以增强探索能力。

- 在算法运行过程中适当降低惯性权重,以增强开发能力。

- 学习因子应保持较小的差异,以平衡个体和群体经验的学习。

参数选择的方法可以分为三类:经验法、试错法和自适应法。经验法依赖于研究者或使用者的经验。试错法涉及在一系列试验中调整参数,观察结果的变化。自适应法是根据当前搜索情况动态调整参数,将在下一小节中详细讨论。

5.2 参数优化策略

在PSO算法中,自适应参数调整可以显著提高算法性能。在本小节中,我们将介绍一些自适应参数调整方法,并通过实验和案例分析来展示参数优化的实际效果。

5.2.1 自适应参数调整方法

自适应参数调整方法主要通过实时监控PSO算法的搜索行为来动态调整参数。例如,惯性权重可以依据搜索的阶段自适应调整。在搜索早期,为了提高全局探索能力,可以使用较大的惯性权重;而在搜索后期,为了提高局部搜索精度,可以逐渐减小惯性权重。学习因子也可以根据粒子群的收敛速度或多样性来动态调整,以保持种群的多样性,防止早熟收敛。

5.2.2 参数优化的实验与案例分析

我们以一个典型工程优化问题——旅行商问题(TSP)为例,通过实验对比不同参数设置对PSO算法性能的影响。实验中,我们使用自适应调整惯性权重和学习因子的方法,并记录了不同参数设置下的收敛曲线和解的质量。

以下是实验的参数设置表格,以及实验的收敛曲线图和解的质量对比表。

表格:不同参数设置下的实验结果

| 参数设置 | 平均收敛迭代次数 | 平均解的质量 | |-----------|------------------|--------------| | w=0.9, c1=1.5, c2=1.5 | 350 | 5000 | | w=0.5, c1=2.0, c2=2.0 | 200 | 4500 | | w=0.4-0.9, c1=1.8-2.2, c2=1.8-2.2(自适应)| 150 | 3900 |

图表:收敛曲线对比图

表格:解的质量对比

| 参数设置 | 最优解质量 | 稳定性评估 | |-----------|-------------|-------------| | w=0.9, c1=1.5, c2=1.5 | 4950 ± 150 | 中等 | | w=0.5, c1=2.0, c2=2.0 | 4450 ± 100 | 较好 | | w=0.4-0.9, c1=1.8-2.2, c2=1.8-2.2(自适应)| 3900 ± 80 | 很好 |

通过实验结果可以看到,自适应参数调整的PSO算法在收敛速度和解的质量上都有显著的优势。这证明了自适应参数调整在提高PSO性能方面的有效性。

总结来说,合理的参数调整能够提升PSO算法的搜索效率和解的质量,而自适应参数调整方法相比固定参数设置更加灵活,能够更好地适应问题的特性,从而达到更优的优化结果。在实际应用中,根据具体问题特点选择合适的参数调整策略至关重要。

6. 单目标PSO的应用场景与改进

6.1 单目标PSO的应用领域与案例

粒子群优化算法(PSO)因其简单、高效等特点,在多个领域得到了广泛的应用。单目标PSO主要用于解决只有一个优化目标的工程问题,这类问题在实际中非常常见,因此PSO的应用也相对普遍。

6.1.1 PSO在工程优化问题中的应用

PSO在工程优化问题中应用广泛,比如在电力系统、机械设计、航天工程等领域。以下是一个典型的例子:

案例: 在电力系统中,常常需要优化电力分配以确保传输效率和成本最低。使用PSO可以快速找到最优的电力分配方案。具体步骤如下:

- 定义目标函数: 设计一个目标函数来最小化电力损耗和最大化能源利用率。

- 确定决策变量: 决策变量可以是各个节点的电力分配量。

- 初始化粒子群: 设置粒子的位置为可能的电力分配方案,速度为分配方案的变化量。

- 迭代寻优: 根据PSO的速度和位置更新公式不断迭代,直至找到最优或满意的解。

- 实施和评估: 将最优解应用于电力系统中,并评估实际效果。

6.1.2 PSO在机器学习参数优化中的应用

机器学习模型往往需要通过调整参数来优化性能,而PSO在此过程中可以作为强大的辅助工具。

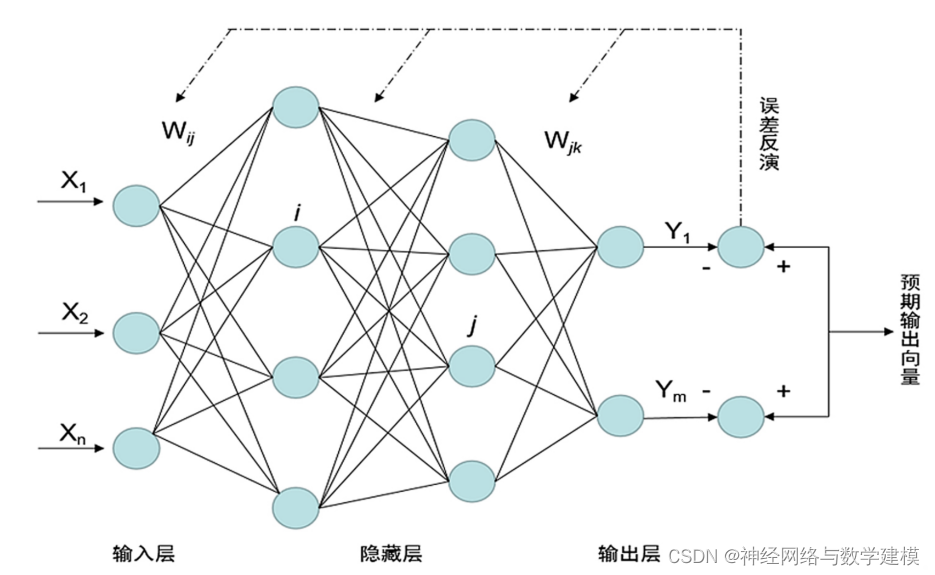

案例: 在神经网络训练过程中,可以使用PSO对学习率、隐藏层神经元数量等参数进行优化。

- 确定优化目标: 例如最小化模型的交叉熵损失。

- 编码粒子参数: 将神经网络的参数编码为粒子。

- 适应度评估: 训练神经网络并计算损失函数。

- 更新粒子: PSO根据适应度更新粒子的速度和位置。

- 参数调整和模型再训练: 使用新的参数调整神经网络,重复上述步骤。

6.2 PSO的优点与面临的挑战

PSO由于其简单的实现和良好的优化性能,成为了解决单目标优化问题的有效工具。

6.2.1 PSO算法的优势分析

PSO算法的主要优点包括:

- 易于实现: 相比于其他优化算法,PSO的数学模型简单,容易编写代码实现。

- 参数少: PSO的主要参数惯性权重和学习因子相对容易调整。

- 局部搜索能力强: 粒子的个体学习和群体学习能够使算法保持对局部最优解的敏感性。

- 并行计算优势: PSO算法天然支持并行化,适合现代多核处理器。

6.2.2 针对PSO算法的常见问题及改进方向

尽管PSO算法有许多优势,但在实际应用中仍面临一些挑战。

- 参数敏感性: 过大的惯性权重可能导致算法全局搜索能力太强,过小则可能陷入局部最优。

- 过早收敛: 粒子可能会过早聚集到局部最优解,导致算法收敛速度过快。

- 多样性丧失: 粒子群在迭代过程中可能会丧失多样性,使得算法难以探索新的搜索区域。

针对以上问题,研究者提出了一些改进方向:

- 自适应策略: 通过自适应调整惯性权重和学习因子来平衡全局和局部搜索能力。

- 多样性的保持: 在算法中引入随机扰动或多样性恢复机制,防止粒子过早聚集。

- 混合算法: 将PSO与其他优化算法结合,以融合不同算法的优势,提升整体性能。

通过这些改进,PSO算法在复杂优化问题中的表现将得到进一步提升,适用范围也将进一步扩大。

简介:粒子群优化算法(PSO)是一种启发式优化技术,模拟鸟群觅食行为。它通过粒子在搜索空间的随机飞行来寻找最优解。在单目标PSO中,算法致力于找到一个使目标函数最大化或最小化的单一最优解。通过初始化、速度和位置更新、适应度评价以及终止条件,PSO可以应用于工程和科学问题,如机器学习参数调优。算法的简单性和灵活性使其成为解决非线性、多模态和高维优化问题的有效工具,但也面临易陷入局部最优、依赖于参数设置等挑战。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?