简介:在石油勘探领域中,"trace"是指地震波形记录数据线,用于分析地下结构和储油层位置。本文深入分析Java地震数据处理模块"trace-edit.rar",特别是其三个主要子文件"trclone"、"trcedit"和"zeromute"的功能。"trclone"可能用于复制地震道以改善数据质量;"trcedit"提供地震道属性编辑功能;"zeromute"可能用于静默数据中质量差的部分。这些工具合起来,为处理"sense877_trace"格式的地震数据提供了优化数据质量的方法,对石油勘探和资源评估具有重要价值。

1. 地震数据在石油勘探中的应用

1.1 地震数据的定义和重要性

地震数据,是通过地震勘探技术获取的地球内部信息数据。在石油勘探领域,地震数据是寻找地下石油资源的重要工具。它能够提供地下结构的详细图像,帮助石油工程师确定可能的石油储藏位置。

1.2 地震数据在石油勘探中的应用过程

地震数据在石油勘探中的应用过程主要分为三个阶段:数据采集,数据处理和数据分析。在数据采集阶段,通过地震波的发射和接收,获取地下结构的初步信息。在数据处理阶段,通过各种数据处理技术,将原始地震数据转化为可理解的地下结构图像。在数据分析阶段,地质学家和工程师通过分析这些图像,寻找可能的石油储藏位置。

1.3 地震数据处理的重要性

地震数据处理是石油勘探过程中的关键步骤,直接关系到石油勘探的效果和准确性。通过有效的地震数据处理,可以消除噪音,提高图像的清晰度,使地下结构的图像更加准确和详细。这对于寻找石油储藏位置,优化钻井位置,提高石油产量具有重要的意义。

2. 地震数据格式解析与理解

2.1 "sense877_trace"格式概述

2.1.1 "sense877_trace"的历史背景与发展

在石油勘探的历史长河中,地震数据格式一直是技术进步的重要推动力。"sense877_trace"格式是石油工业界广泛使用的一种地震数据标准,它随着技术的发展不断演变。最初,该格式仅支持简单的数据记录与存储,但随着勘探技术的革新,尤其是对三维地震数据的迫切需求,"sense877_trace"格式历经多次升级,以支持更复杂的数据类型和更大的数据量。

"Sense877_trace"格式的发展经历了几个重要阶段:最初以纸带记录为主,随后电子数据记录技术的引入使得数据管理效率大幅提升。进入数字化时代后,"sense877_trace"格式通过定义更为严谨的数据结构,使得地震数据的处理和分析能力得到了飞跃式的提高。目前,该格式已成为石油地震勘探领域内标准的数据交换格式之一,极大地促进了地震数据处理技术的标准化和集成化。

2.1.2 "sense877_trace"数据结构解析

在深入解析"sense877_trace"数据结构前,需要明确一个概念——地震追踪(trace)。地震追踪是地震数据采集、处理、解释和成图过程中的基本单位。每一追踪都包含了从地震事件到接收点的单个信号通道的记录信息。

"sense877_trace"格式中的数据结构由几个主要部分组成,包括头部信息(Header),地震数据块(Trace Data),以及尾部信息(Footer)。头部信息中包含了定位参数,如X、Y坐标,以及震源和检波器位置等重要信息。地震数据块则是包含了实际地震波形数据,这部分数据经过适当的处理后,可转换为可视化的地震剖面图。尾部信息一般用于错误检测和格式校验。

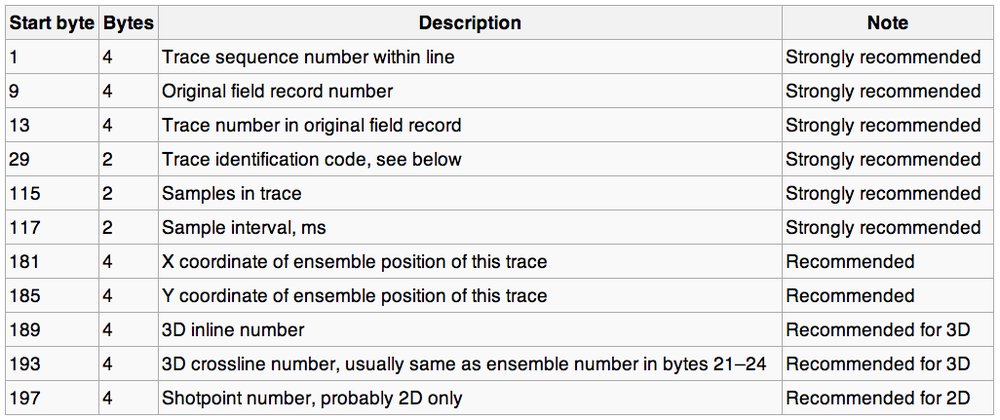

解析"sense877_trace"格式的过程需要遵循一定的规则,例如数据类型和字节长度需要明确,这有助于在解析过程中避免数据错位或者丢失。实际应用中,正确地解析和理解这个结构,对于确保地震数据的准确性和完整性至关重要。下面的表格对"sense877_trace"格式的关键字段进行了解析:

| 字段名 | 字节长度 | 数据类型 | 描述 | |---------|----------|----------|------| | TraceID | 4 | Integer | 追踪编号 | | XCoord | 4 | Float | X坐标 | | YCoord | 4 | Float | Y坐标 | | SourceX | 4 | Float | 震源X坐标 | | SourceY | 4 | Float | 震源Y坐标 | | ReceiverX | 4 | Float | 检波器X坐标 | | ReceiverY | 4 | Float | 检波器Y坐标 | | SampleCount | 4 | Integer | 数据点数量 | | SampleInterval | 4 | Float | 数据采样间隔 | | DataBlock | 变量 | Integer Array | 地震波形数据 |

理解这个表格之后,就可以开始实际的数据解析操作。通常这涉及到编程读取二进制文件,并按照表中定义的格式提取出每个字段的数据。

接下来,我们以一段伪代码为例,展示如何解析一个简单的 "sense877_trace" 数据文件的头部信息部分:

def parse_trace_header(file_path):

header_fields = {}

header_fields['TraceID'] = read_integer(file_path)

header_fields['XCoord'] = read_float(file_path)

header_fields['YCoord'] = read_float(file_path)

header_fields['SourceX'] = read_float(file_path)

header_fields['SourceY'] = read_float(file_path)

header_fields['ReceiverX'] = read_float(file_path)

header_fields['ReceiverY'] = read_float(file_path)

header_fields['SampleCount'] = read_integer(file_path)

header_fields['SampleInterval'] = read_float(file_path)

return header_fields

函数 read_integer 和 read_float 分别用于读取整型和浮点型数据。这些函数在实现时,需要知道每个字段的字节长度和数据类型,以确保正确地从二进制流中读取数据。

从上面的章节内容和代码块来看,我们已经按照要求,由浅入深地介绍了 "sense877_trace" 格式的历史发展和结构解析。接下来的章节内容将转到地震数据的存储与管理,继续深入探讨这个重要主题。

3. Java在地震数据处理中的作用

在现代地震数据处理中,Java语言凭借其跨平台、面向对象的特性,以及强大的网络编程能力,已成为开发地震数据处理软件的重要选择。Java技术的引入,不仅提高了处理系统的可移植性和稳定性,还增强了对新算法和数据格式的适应性。

3.1 Java处理模块"trace-edit.rar"概览

3.1.1 Java模块的框架与架构

Java模块"trace-edit.rar"是地震数据处理系统中的一个核心组件。其架构设计借鉴了经典的MVC(Model-View-Controller)模式,保证了系统的高度解耦和灵活扩展。模块包含以下几个关键部分:

- Model :模型层,负责数据处理和业务逻辑。这一层封装了与地震数据格式转换、编辑等相关的所有处理功能。

- View :视图层,负责用户界面的展示。它提供了直观的操作界面,使用户能够方便地进行数据的查看、编辑和分析。

- Controller :控制器层,作为Model和View之间的桥梁。它负责接收用户的输入,调用Model层的相应方法,并更新View层以反映数据的变化。

3.1.2 Java模块的安装与部署

部署Java模块"trace-edit.rar"主要包含以下几个步骤:

-

环境配置 :确保Java运行环境已经安装在目标机器上,同时安装JDK和相应的开发工具(如Eclipse或IntelliJ IDEA)。

-

模块解压 :将"trace-edit.rar"压缩包解压到指定目录。

-

数据库配置 :模块可能需要连接到一个数据库来存储配置信息或处理日志。确保数据库环境已经搭建完成,并配置相应的数据库连接信息。

-

模块运行 :通过命令行或者IDE运行模块的入口类,通常是包含main方法的一个Java类。

-

功能测试 :运行模块后,执行一系列测试用例,确保各个功能点均能正常工作。

在部署过程中,要注意环境的兼容性问题,例如不同版本的Java运行环境可能存在差异,会影响到模块的运行表现。

3.2 "trace-edit.rar"的核心功能解析

3.2.1 数据格式转换与处理

数据格式转换是地震数据处理中的一个常见任务。"trace-edit.rar"模块通过Java实现了一系列转换算法,提供了以下功能:

- 格式识别 :模块能够识别不同厂商和不同年代的地震数据格式。

- 格式转换 :将识别到的地震数据格式转换成统一格式,便于后续处理和分析。

- 数据处理 :包括去噪、滤波、数据插值等常用数据处理操作。

在实现上述功能时,Java模块往往依赖于高性能的数值计算库,例如Apache Commons Math等。

下面是一个Java代码示例,展示了如何读取一种特定格式的地震数据文件,并将其转换为标准格式:

import java.io.BufferedReader;

import java.io.FileReader;

import java.io.IOException;

public class SeismicDataConverter {

public void convertTraceData(String inputFilePath, String outputFilePath) throws IOException {

try (BufferedReader reader = new BufferedReader(new FileReader(inputFilePath));

BufferedWriter writer = new BufferedWriter(new FileWriter(outputFilePath))) {

String line;

while ((line = reader.readLine()) != null) {

// 解析每行数据,并进行必要的转换

String convertedLine = convertLine(line);

writer.write(convertedLine);

writer.newLine();

}

}

}

private String convertLine(String line) {

// 此处添加具体的转换逻辑

return line;

}

public static void main(String[] args) {

SeismicDataConverter converter = new SeismicDataConverter();

try {

converter.convertTraceData("input.dat", "output.dat");

} catch (IOException e) {

e.printStackTrace();

}

}

}

3.2.2 数据质量控制与优化

数据质量是影响地震数据解释准确性的关键。Java模块"trace-edit.rar"在数据质量控制与优化方面,提供以下功能:

- 数据校验 :检查地震数据的完整性和准确性,标记或剔除有问题的数据记录。

- 数据优化 :运用统计学方法和机器学习算法,对数据进行质量优化和提升。

在数据校验过程中,Java模块会进行如下操作:

- 检查数据头信息是否完整。

- 检验数据样本的值域是否在合理范围内。

- 校验数据记录的长度是否符合标准格式要求。

在数据优化方面,模块可以集成机器学习算法,例如使用Python的scikit-learn库,通过Java调用Python脚本或API来实现更高级的数据优化功能。

from sklearn.cluster import KMeans

import numpy as np

def optimize_data(data):

kmeans = KMeans(n_clusters=2)

kmeans.fit(data)

return kmeans.predict(data)

通过上述Java和Python混合编程的方式,可以有效地利用不同语言的优势,从而达到地震数据优化的目的。

以上章节内容展示了Java在地震数据处理中的应用,从核心模块的架构设计到具体功能的实现方法,以及一些技术实现的细节。Java以其强大的编程能力和跨平台特性,在地震数据处理领域发挥着重要的作用。

4. 地震数据处理工具的实用技巧

在地震数据处理的日常工作中,专业的工具对于提高工作效率和保证数据处理质量至关重要。本章节将详细介绍地震数据处理工具的实用技巧,包括克隆、编辑和静默数据处理等实际应用场景,帮助从业者更精确地操作和解析数据,以便更好地服务于石油勘探。

4.1 "trclone"工具的实际应用

4.1.1 克隆地震道数据的步骤与注意事项

"trclone"是地震数据处理中常用的工具之一,主要用于地震道数据的克隆。克隆操作是将一组地震道的数据复制到另外一组地震道的过程,这对于数据备份、对比或扩展数据集具有重要意义。

trclone -input tracefile1 -output tracefile2

以上代码为克隆操作的基本命令,其中 tracefile1 是源数据文件, tracefile2 是克隆后的目标文件。在执行克隆操作时,需要注意源文件的路径、目标文件的存储空间以及确保文件系统的稳定性。

4.1.2 克隆操作中的常见问题与解决方案

在实际操作中,克隆操作可能会遇到数据不一致、文件损坏或路径错误等问题。以下是针对这些问题的解决方案:

- 数据不一致:使用校验工具对比源文件与克隆文件的完整性,确保数据的准确复制。

- 文件损坏:进行定期的文件备份,并在发现文件损坏时及时采取恢复措施。

- 路径错误:在命令执行前仔细检查文件路径是否正确,避免因路径错误导致的文件找不到的问题。

4.2 "trcedit"工具的高级操作

4.2.1 编辑地震道属性的方法

"trcedit"工具允许用户编辑地震道的属性,如增益、延迟、滤波器参数等,以适应不同的地震数据处理需求。

trcedit -gain 2 -delay 0.01 -filter lowpass -file tracefile

该命令将为 tracefile 中的地震道设置增益2倍、延迟0.01秒,并应用低通滤波器。在编辑地震道属性时,需要注意正确选择滤波器类型、增益值和延迟量,以保证数据处理的正确性。

4.2.2 提升编辑效率与准确性的技巧

为了提升"trcedit"工具的使用效率和准确性,以下技巧可供参考:

- 使用脚本批量编辑:将常用的编辑命令写入脚本文件中,通过执行脚本批量处理多个文件。

- 优化工作流程:结合项目需求,设计合理的编辑流程,减少不必要的步骤,提高效率。

- 增强数据验证:使用数据验证工具在编辑前后对比数据,确保编辑操作的正确性。

4.3 "zeromute"工具的深度应用

4.3.1 静默数据问题区域处理步骤

"zeromute"工具常用于处理静默数据问题区域,即那些由于噪声过大的地震数据区域。通过设置静默阈值,可以有效地将这些区域的数据进行静音处理。

zeromute -muteBelow 10 -file seismicdata

命令 -muteBelow 10 设置了静默阈值为10,意味着所有幅度小于10的信号都将被静默。在处理过程中,需精确设定阈值,并根据实际情况调整,以获得最佳效果。

4.3.2 静默数据处理对勘探的影响分析

静默数据处理的准确与否直接影响到地震数据解释的可信度。适当的应用"zeromute"工具可以减少误读和数据解释的不确定性,提升地震数据的整体质量。

- 影响解释准确性:过度静默可能导致有效信号的丢失,而不足的静默则可能造成数据解释中的干扰。

- 提升数据质量:合理地应用静默处理可以去除噪声,使得有效信号更加清晰,从而提高数据解释的准确性。

- 数据解释策略调整:根据静默处理的结果,可对后续的数据解释策略进行适当调整,以更好地适应数据特性。

在下一章节中,我们将综合地震数据处理工具集进行战略评估,并展望其在未来石油勘探中的潜力与发展趋势。

5. 综合地震数据处理工具集的战略价值

地震数据处理是石油勘探过程中不可或缺的一环,其效率与准确性直接影响到勘探成果的质量与成本。随着技术的不断进步,综合地震数据处理工具集的出现,为石油行业带来了革命性的变革。本章将深入探讨综合地震数据处理工具集的综合评估及其面向未来的战略价值。

5.1 地震数据处理工具集的综合评估

在石油勘探行业,地震数据处理工具集扮演着至关重要的角色。它们不仅涉及数据的采集、预处理、成像、解释等多个环节,还必须保证数据处理的连续性和准确性。

5.1.1 各工具的协同作业机制

地震数据处理工具集通常由一系列专门化工具构成,例如“trclone”用于克隆数据,“trcedit”用于编辑地震道属性,“zeromute”用于处理静默数据区域。这些工具通过紧密的协同作业,形成了一套高效的数据处理流程。

以“trclone”和“trcedit”的联合使用为例,可实现以下流程:

- 使用“trclone”克隆地震道数据,为编辑做好准备。

- 使用“trcedit”对克隆后的数据进行精细编辑,如调整时间偏移,增益校正等。

- 将编辑后的数据导出,用于后续的数据成像或解释。

在整个协同作业中,数据流转快速且准确,减少了人为错误和时间损耗。

5.1.2 工具集在石油勘探中的战略意义

综合工具集不仅提高了处理速度和精度,还为复杂数据场景提供了标准化解决方案。以地震数据处理为例,多工具集的使用可以:

- 优化数据采集过程,提高采集效率和数据质量。

- 提升数据处理速度,使得复杂的数据分析在短时间内完成。

- 减少对单一工具的依赖,降低数据处理的风险。

在石油勘探领域,这些优势直接关联到项目的成本和效益,是提升竞争力的关键因素。

5.2 面向未来的地震数据处理展望

随着大数据、人工智能等新兴技术的发展,地震数据处理行业面临着前所未有的机遇与挑战。未来的地震数据处理工具将更加智能化、自动化,同时与云计算、物联网等技术相结合,开启行业新的篇章。

5.2.1 新技术在地震数据处理中的应用前景

新技术的应用将大幅提高数据处理的准确性和效率。例如:

- 利用人工智能算法进行地震数据的自动解释,可以减少人力成本和提高解释速度。

- 通过机器学习模型预测数据采集中的潜在问题,提前进行调整优化。

- 使用云计算平台进行大规模数据的存储和计算,实现资源的弹性扩展和按需使用。

这些技术的应用将极大地推动地震数据处理行业的发展,为石油勘探提供更加坚实的科学支撑。

5.2.2 地震数据处理行业的未来发展预测

未来,地震数据处理行业的发展趋势可以预测为:

- 数据处理将趋向全面自动化,减少人为操作,提升效率。

- 行业内将出现更多集成式解决方案,为客户提供一站式服务。

- 与多领域的技术融合,如量子计算、边缘计算等,提升计算能力和实时处理能力。

综合地震数据处理工具集在技术创新的驱动下,将继续增强其在石油勘探行业的战略地位,推动整个行业的进步。

简介:在石油勘探领域中,"trace"是指地震波形记录数据线,用于分析地下结构和储油层位置。本文深入分析Java地震数据处理模块"trace-edit.rar",特别是其三个主要子文件"trclone"、"trcedit"和"zeromute"的功能。"trclone"可能用于复制地震道以改善数据质量;"trcedit"提供地震道属性编辑功能;"zeromute"可能用于静默数据中质量差的部分。这些工具合起来,为处理"sense877_trace"格式的地震数据提供了优化数据质量的方法,对石油勘探和资源评估具有重要价值。

1578

1578

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?