简介:生僻字带增强图片数据集是一项计算机视觉与自然语言处理结合的资源,用于训练高准确度的生僻汉字识别模型。该数据集包含经过旋转、缩放、翻转和噪声注入等处理的图片,以模拟现实视觉条件并提高模型泛化能力。数据集的构建涉及到深度学习模型,如CNN和RNN,以及特征提取和分类技术。训练流程包括数据预处理、模型构建、训练、验证和测试,采用技术如迁移学习和注意力机制进一步提升模型性能。

1. 生僻字图像增强数据集介绍

在探索计算机视觉和自然语言处理的交叉领域时,一个关键且挑战性的任务是生僻字图像增强数据集的研究与应用。本章将为您提供一个关于生僻字图像增强数据集的概览,为后续章节的深入讨论奠定基础。

1.1 数据集的重要性

数据集是机器学习和深度学习项目的基础,尤其是对于生僻字识别这样的任务。一个高质量的数据集可以极大提高模型的性能,特别是在数据稀疏的生僻字领域。图像增强技术通过改进图像质量、增加数据多样性和量级来提高数据集的整体质量,从而提升模型的识别准确率。

1.2 数据集的内容与结构

生僻字图像增强数据集通常包含成千上万的汉字图像样本,这些样本往往覆盖不同的字体、大小、背景和噪声类型。数据集的构建需要进行详细的规划,包括样本的选择、标注规则的制定、数据增强方法的应用等。此外,为了更有效地使用这些数据,数据集还需附带相应的元数据,比如图像来源、字体信息、汉字属性等。

1.3 数据增强的必要性

由于生僻字使用频率低,可获得的样本量有限,直接训练深度学习模型效果往往不佳。数据增强通过对已有数据进行处理,如旋转、缩放、翻转和噪声注入等操作,生成新的训练样本,这有助于提高模型的泛化能力。下一章,我们将深入探讨数据增强策略及其在生僻字识别中的具体应用。

2. 数据集在计算机视觉和自然语言处理中的应用

在现代AI领域的研究中,图像数据集和文本数据集是支撑计算机视觉(Computer Vision,简称CV)和自然语言处理(Natural Language Processing,简称NLP)两大领域的基石。生僻字图像增强数据集(以下简称为数据集)可以将计算机视觉和自然语言处理有机地结合起来,以达到更高的识别和处理精度。这一章节我们将深入探讨数据集在这两个领域中的应用,以及它们在不同应用场景下的具体实践。

2.1 计算机视觉中的应用

2.1.1 图像识别

在计算机视觉领域,图像识别是识别和分类图像中的对象、场景和活动的基本任务。生僻字图像增强数据集在此扮演了至关重要的角色。例如,在自动化文档处理、历史文化信息保护和数字图书馆建设等应用中,图像识别技术可以帮助我们从扫描或拍摄的图片中准确地识别出生僻字。

例如,当我们用深度学习模型处理一张包含生僻字的扫描文档图片时,该模型需要首先对图像进行处理,如调整对比度、增强图像边缘、进行降噪等。这是为了将生僻字清晰地从背景中分离出来,提高识别的准确性。具体操作步骤如下:

import cv2

def preprocess_image(image_path):

# 读取图像

img = cv2.imread(image_path, cv2.IMREAD_GRAYSCALE)

# 调整对比度

alpha = 1.2 # 控制对比度

beta = 10 # 控制亮度

enhanced_img = cv2.convertScaleAbs(img, alpha=alpha, beta=beta)

# 高斯模糊降噪

blur = cv2.GaussianBlur(enhanced_img, (5, 5), 0)

return blur

# 使用图像预处理函数

preprocessed_img = preprocess_image('path_to_image.jpg')

在上述代码中,我们首先使用OpenCV读取了图像文件,并将其转换为灰度图。然后通过 convertScaleAbs 函数调整了图像的对比度和亮度,最后应用高斯模糊进行降噪处理。

2.1.2 图像分类

图像分类是另一种常见的计算机视觉任务,它将图像分配给一个或多个类别。生僻字图像增强数据集在这里能够提供丰富的样本,帮助深度学习模型理解生僻字的特点和类别,从而提高分类的准确性。

以卷积神经网络(CNN)为例,它在图像分类任务中表现出色。CNN通过自动学习图像中的特征来进行分类,因此,为CNN提供足够的训练数据是至关重要的。通过使用生僻字图像增强数据集,可以训练一个专门用于分类生僻字的CNN模型。

import keras

# 构建简单的卷积神经网络模型

model = keras.models.Sequential([

keras.layers.Conv2D(32, (3, 3), activation='relu', input_shape=(64, 64, 1)),

keras.layers.MaxPooling2D((2, 2)),

keras.layers.Conv2D(64, (3, 3), activation='relu'),

keras.layers.MaxPooling2D((2, 2)),

keras.layers.Conv2D(128, (3, 3), activation='relu'),

keras.layers.Flatten(),

keras.layers.Dense(64, activation='relu'),

keras.layers.Dense(num_classes) # 假设num_classes是分类数目

])

***pile(optimizer='adam',

loss=tf.keras.losses.SparseCategoricalCrossentropy(from_logits=True),

metrics=['accuracy'])

# 训练模型

model.fit(preprocessed_images, labels, epochs=10)

在此代码块中,我们构建了一个简单的CNN模型,并使用增强后的生僻字图像进行训练。

2.2 自然语言处理中的应用

2.2.1 文本识别

文本识别通常是指从图片或者扫描文档中提取文本信息的过程。生僻字图像增强数据集在这里提供大量的带有生僻字的图像样本,用于训练文本识别模型。

文本识别任务中,光学字符识别(Optical Character Recognition,OCR)技术是关键。现代OCR系统通常包括预处理、文本行检测、字符分割、字符识别和后处理等步骤。生僻字图像增强数据集使得系统能够更加精准地识别和处理这些难以辨认的字符。

from google.cloud import vision

from google.cloud.vision_v1.types import image_annotator

client = vision.ImageAnnotatorClient()

# 准备带有生僻字的图像数据

image_path = 'path_to_image.jpg'

with open(image_path, 'rb') as image_***

***

* 调用OCR接口

response = client.text_detection(image=image)

texts = response.text_annotations

for text in texts:

print('\n'.join(page.text for page in text.pages))

# 处理生僻字识别的特殊情况

# 可能需要自定义的字典或模型来辅助识别

上述代码展示了如何使用Google Cloud Vision API进行图像中的文本识别。由于生僻字可能不在常规OCR字典中,所以在识别后可能需要额外的步骤来处理这些字。

2.2.2 语音识别

语音识别技术允许用户通过说话来与计算机交互。生僻字图像增强数据集虽然与语音识别无直接关联,但是通过图像增强我们可以更好地构建多模态数据集,使得计算机可以利用图像和语音的结合来理解和识别生僻字,提高语音识别的准确性。

在构建多模态生僻字数据集中,数据融合技术发挥了关键作用。数据融合可以在不同模态之间提取互补信息,从而提高整体识别性能。例如,语音信号中包含的声学信息可以与图像数据中包含的视觉信息进行互补,从而提升对生僻字的识别精度。

import speech_recognition as sr

# 使用语音识别库

recognizer = sr.Recognizer()

# 从音频文件中获取音频数据

with sr.AudioFile('path_to_audio_file.wav') as source:

audio_data = recognizer.record(source)

# 识别音频中的内容

try:

text = recognizer.recognize_google(audio_data, language='zh-CN')

print(text)

except sr.UnknownValueError:

print("Google Speech Recognition could not understand audio")

except sr.RequestError as e:

print(f"Could not request results from Google Speech Recognition service; {e}")

在这个示例中,我们展示了如何使用 speech_recognition 库来处理一个中文音频文件,并尝试将其转化为文本。对于生僻字的语音识别,可能需要自定义的语音模型进行改进。

以上章节内容介绍了数据集在计算机视觉和自然语言处理中的应用。在接下来的章节中,我们将进一步探讨数据增强策略及效果评估,以及在生僻字识别中深度学习模型的应用。

3. 数据增强策略及效果

3.1 数据增强的基本策略

3.1.1 旋转

图像的旋转是一种常用的数据增强手段,通过旋转原图可以产生新的视角,从而增加模型对旋转变化的鲁棒性。图像旋转通常可以通过几何变换实现,变换角度可以是固定的,也可以是随机的。以随机旋转为例,其基本原理是在图像上应用一个随机的旋转角度,从而生成新的图像。

import cv2

import numpy as np

def rotate_image(image, angle):

"""

该函数将图像旋转指定的角度。

参数:

image -- 原始图像

angle -- 旋转角度

返回值:

rotated_image -- 旋转后的图像

"""

(h, w) = image.shape[:2]

center = (w // 2, h // 2)

M = cv2.getRotationMatrix2D(center, angle, 1.0)

cos = np.abs(M[0, 0])

sin = np.abs(M[0, 1])

nW = int((h * sin) + (w * cos))

nH = int((h * cos) + (w * sin))

M[0, 2] += (nW / 2) - center[0]

M[1, 2] += (nH / 2) - center[1]

rotated_image = cv2.warpAffine(image, M, (nW, nH))

return rotated_image

# 示例用法

image = cv2.imread('path_to_image.jpg')

rotated_image = rotate_image(image, 45) # 旋转45度

在上面的代码中, cv2.getRotationMatrix2D 生成了一个旋转矩阵,然后 cv2.warpAffine 使用该矩阵来旋转图像。旋转角度 angle 参数可以根据需要设置为不同的值,甚至是一个随机值,以创建多样化的训练数据。

3.1.2 缩放

图像缩放是指根据指定的比例对图像的尺寸进行调整,这在数据增强中也很常见。缩放可以是均匀的(保持图像的宽高比不变),也可以是不均匀的(改变图像的宽高比)。对于生僻字图像增强,均匀缩放通常更适用,因为它可以保持字的结构不变。

def resize_image(image, scale):

"""

该函数将图像按照指定的缩放比例进行缩放。

参数:

image -- 原始图像

scale -- 缩放比例

返回值:

resized_image -- 缩放后的图像

"""

resized_image = cv2.resize(image, None, fx=scale, fy=scale, interpolation=cv2.INTER_LINEAR)

return resized_image

# 示例用法

image = cv2.imread('path_to_image.jpg')

resized_image = resize_image(image, 0.8) # 缩放比例为0.8

在这里, cv2.resize 函数用于图像缩放,其中 fx 和 fy 参数分别指定水平和垂直方向上的缩放比例。 interpolation 参数用于指定插值方法,这里使用线性插值方法 cv2.INTER_LINEAR 。

3.2 数据增强的效果评估

3.2.1 翻转

图像翻转是数据增强中的一个简单而有效的策略,可以通过水平翻转或垂直翻转来增加数据集的多样性。对于生僻字识别,水平翻转尤其有用,因为它可以模拟生僻字在不同阅读方向下的变化。

def flip_image(image, flip_code):

"""

该函数将图像沿水平轴或垂直轴进行翻转。

参数:

image -- 原始图像

flip_code -- 翻转方式

-1 代表水平翻转

0 代表垂直翻转

>0 代表水平和垂直同时翻转

返回值:

flipped_image -- 翻转后的图像

"""

flipped_image = cv2.flip(image, flip_code)

return flipped_image

# 示例用法

image = cv2.imread('path_to_image.jpg')

flipped_image = flip_image(image, 1) # 水平翻转

3.2.2 噪声注入

噪声注入是通过在图像中引入随机噪声来模拟图像在传输或捕获过程中的噪声干扰。这可以提高模型对噪声的容忍度,提高其鲁棒性。噪声可以通过各种方式添加,例如高斯噪声、椒盐噪声等。

def add_noise(image, noise_type='gaussian', mean=0, var=10):

"""

该函数在图像中添加高斯噪声或椒盐噪声。

参数:

image -- 原始图像

noise_type -- 噪声类型,可以是 'gaussian' 或 'salt_and_pepper'

mean -- 高斯噪声的均值

var -- 高斯噪声的方差

返回值:

noisy_image -- 添加噪声后的图像

"""

if noise_type == 'gaussian':

row, col, ch = image.shape

sigma = var**0.5

gauss = np.random.normal(mean, sigma, (row, col, ch))

gauss = gauss.reshape(row, col, ch)

noisy_image = image + gauss

elif noise_type == 'salt_and_pepper':

s_vs_p = 0.5

amount = 0.04

noisy_image = np.copy(image)

# Salt mode

num_salt = np.ceil(amount * image.size * s_vs_p)

coords = [np.random.randint(0, i - 1, int(num_salt)) for i in image.shape]

noisy_image[coords] = 1

# Pepper mode

num_pepper = np.ceil(amount * image.size * (1. - s_vs_p))

coords = [np.random.randint(0, i - 1, int(num_pepper)) for i in image.shape]

noisy_image[coords] = 0

else:

raise ValueError("Noise type should be 'gaussian' or 'salt_and_pepper'")

return noisy_image

# 示例用法

image = cv2.imread('path_to_image.jpg')

noisy_image = add_noise(image, noise_type='gaussian', mean=0, var=10)

在上面的代码中,我们定义了一个函数 add_noise ,它可以根据指定的噪声类型在图像中添加噪声。高斯噪声是通过生成具有特定均值和方差的随机数来添加的,而椒盐噪声则是在图像中随机改变像素值为0或255(假设图像为灰度图)。

在下一章中,我们将探讨生僻字图像增强数据集在计算机视觉和自然语言处理中的应用,以及这些技术如何进一步推动生僻字识别的精确度。

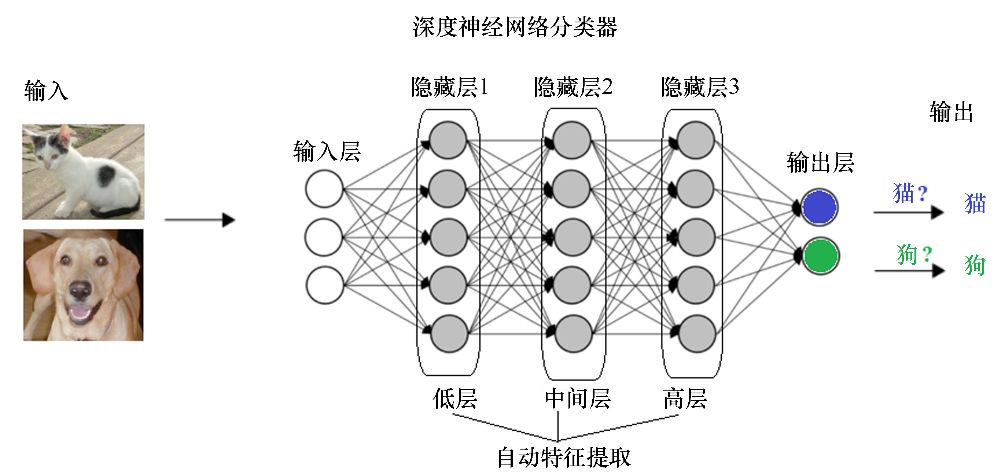

4. 生僻字识别深度学习模型

生僻字识别在计算机视觉和自然语言处理领域有着广泛的应用前景。深度学习技术的飞速发展为此类问题提供了新的解决方案。本章将介绍在生僻字识别任务中广泛应用的两种深度学习模型:卷积神经网络(CNN)和循环神经网络(RNN)。

4.1 卷积神经网络(CNN)

4.1.1 CNN的基本原理

CNN是一种在图像处理领域得到广泛应用的深度学习模型。其核心思想是利用局部感受野、权重共享和池化操作来减少参数数量,并有效地提取图像特征。CNN通过卷积层、激活函数、池化层以及全连接层等多个层次的组合,使得网络具有从简单特征到复杂特征的层次化学习能力。

4.1.2 CNN在生僻字识别中的应用

在生僻字识别任务中,CNN能够自动从图像中学习到文字的局部特征,如笔画、结构和形状。CNN的一个典型应用是使用预训练的模型,如VGG、ResNet等,在大量图像数据上进行微调,以适应生僻字识别的特定需求。通过卷积层的逐层抽象,CNN可以捕捉到生僻字的细微特征,并通过全连接层对特征进行分类。

import tensorflow as tf

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import Conv2D, MaxPooling2D, Flatten, Dense, Activation

# 定义一个简单的CNN模型

model = Sequential([

Conv2D(32, (3, 3), activation='relu', input_shape=(64, 64, 3)),

MaxPooling2D(pool_size=(2, 2)),

Conv2D(64, (3, 3), activation='relu'),

MaxPooling2D(pool_size=(2, 2)),

Flatten(),

Dense(64, activation='relu'),

Dense(num_classes, activation='softmax') # 假设num_classes为生僻字的种类数

])

***pile(optimizer='adam', loss='categorical_crossentropy', metrics=['accuracy'])

# 模型逻辑分析:

# 第一层是具有32个过滤器的卷积层,每个过滤器大小为3x3。

# 之后是一个2x2的池化层,它降低数据的空间维度。

# 第二个卷积层有64个过滤器,同样后跟一个池化层。

# Flatten层将多维的卷积层输出展平为一维。

# 最后是两个全连接层,第一个有64个神经元,并使用ReLU激活函数。

# 输出层的神经元数目与生僻字的种类数相对应,使用softmax激活函数进行分类。

在实际应用中,CNN模型的构建和训练需要大量标注好的图像数据,并且可能需要通过数据增强来扩充数据集,提高模型的泛化能力。训练完成后,模型可以对输入的生僻字图像进行准确识别。

4.2 循环神经网络(RNN)

4.2.1 RNN的基本原理

与CNN不同,RNN是专门用于处理序列数据的深度学习模型。其核心思想是利用隐藏层的循环连接,处理序列数据中的时间依赖关系。在自然语言处理任务中,RNN可以利用前文信息预测当前词,或者生成文本。RNN具有简单、易于实现的特点,但也存在梯度消失或梯度爆炸的问题,这些问题限制了其在长序列数据上的应用。

4.2.2 RNN在生僻字识别中的应用

RNN在生僻字识别中的应用主要体现在序列标注问题,例如识别图像中的文字序列,并判断每个字符的位置。通过RNN的循环连接,模型能够处理文字的顺序信息,从而提高识别精度。长短期记忆网络(LSTM)和门控循环单元(GRU)作为RNN的变种,通过引入门控机制解决了传统RNN的梯度问题,适合处理更长的序列。

import tensorflow as tf

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import LSTM, Dense, Embedding

# 定义一个简单的LSTM模型

model = Sequential([

Embedding(input_dim=num_chars, output_dim=embedding_dim), # num_chars为字符的总数,embedding_dim为嵌入层的维度

LSTM(units=128, return_sequences=True),

LSTM(units=128),

Dense(num_classes, activation='softmax') # num_classes为生僻字的种类数

])

***pile(optimizer='adam', loss='categorical_crossentropy', metrics=['accuracy'])

# 模型逻辑分析:

# Embedding层将输入的字符索引映射为固定大小的向量。

# 两个LSTM层可以处理字符序列中的时间依赖关系。

# 第一个LSTM层的return_sequences参数设置为True,这样它会输出每个时间步的隐藏状态,以供第二个LSTM层使用。

# 输出层的神经元数目与生僻字的种类数相对应,使用softmax激活函数进行分类。

在实际应用中,RNN模型需要对生僻字图像进行序列分割和预处理,然后通过训练模型来识别序列中的字符。虽然RNN适合处理序列数据,但在图像文字识别任务中,由于CNN在空间特征提取方面的优势,通常会将CNN与RNN相结合,以实现更高效的特征提取和识别。

综上所述,CNN和RNN在生僻字识别任务中扮演着关键角色。选择合适的模型和训练策略对于提高识别精度至关重要。在后续章节中,我们将进一步探讨深度学习框架以及如何构建一个完整的训练流程,以实现高效且准确的生僻字识别系统。

5. 深度学习框架

深度学习框架为研究人员和开发者提供了构建和训练深度学习模型的工具和库。在生僻字识别领域,使用得较多的深度学习框架有TensorFlow和PyTorch,它们各自有着不同的设计理念和用法,但是都致力于简化模型开发流程,加速研究和生产部署。

5.1 TensorFlow

TensorFlow,由Google Brain团队开发,是一个开源的深度学习框架,适用于从研究到生产的所有规模。TensorFlow拥有一套强大的计算图概念,可以支持多种设备和平台的部署。

5.1.1 TensorFlow的基本使用

TensorFlow的主要组件是其计算图,该图由节点(ops)和边(tensors)构成,节点表示数学操作,而边表示在它们之间的多维数据数组,也就是张量。以下是使用TensorFlow建立一个简单计算图的代码示例:

import tensorflow as tf

# 创建两个常量节点

node1 = tf.constant(3.0, dtype=tf.float32)

node2 = tf.constant(4.0) # 也可以不显式指定数据类型

# 创建一个加法运算节点

sum = tf.add(node1, node2)

# 运行计算图

with tf.Session() as sess:

result = sess.run(sum)

print(result) # 输出为: 7.0

在上面的代码中,我们首先导入了TensorFlow库,并定义了两个常量节点,然后通过 tf.add() 创建了一个加法运算节点。最后,在一个会话(Session)中运行这个图,得到运算结果。

5.1.2 TensorFlow在生僻字识别中的应用

在生僻字识别任务中,TensorFlow可以被用于设计复杂的深度学习模型,包括卷积神经网络(CNN)和循环神经网络(RNN)。由于其灵活性和扩展性,TensorFlow支持从构建简单模型到实现最新研究的所有功能。

在构建一个用于生僻字识别的CNN模型时,可以使用TensorFlow的高级API,如tf.keras,这简化了模型构建和训练流程:

from tensorflow.keras import layers, models

# 定义一个序贯模型

model = models.Sequential()

# 添加一个卷积层,32个3x3的卷积核,使用ReLU激活函数

model.add(layers.Conv2D(32, (3, 3), activation='relu', input_shape=(64, 64, 3)))

# 添加一个最大池化层

model.add(layers.MaxPooling2D((2, 2)))

# 添加一个全连接层

model.add(layers.Flatten())

model.add(layers.Dense(64, activation='relu'))

# 输出层,使用softmax激活函数进行多分类

model.add(layers.Dense(10, activation='softmax'))

# 编译模型

***pile(optimizer='adam',

loss='sparse_categorical_crossentropy',

metrics=['accuracy'])

# 模型摘要,展示了模型的层结构和参数详情

model.summary()

上面的代码演示了如何构建一个简单的CNN模型,并准备用于训练。通过使用tf.keras,模型结构清晰明了,且易于扩展。

5.2 PyTorch

PyTorch是Facebook的AI研究团队开发的另一个流行的开源深度学习框架,其设计哲学侧重于灵活性和易用性。PyTorch的一个显著特点是其动态计算图(也称为即时执行),它允许开发者更加直观地进行实验和模型调试。

5.2.1 PyTorch的基本使用

PyTorch使用Python本身定义计算图,这意味着你可以利用Python语言的控制流特性(如条件语句和循环)动态地构建图。下面是一个使用PyTorch实现相同加法操作的例子:

import torch

# 创建两个张量

tensor1 = torch.tensor(3.0, dtype=torch.float32)

tensor2 = torch.tensor(4.0, dtype=torch.float32)

# 执行加法操作

sum = tensor1 + tensor2

print(sum) # 输出为: tensor(7.)

不同于TensorFlow的是,PyTorch在定义完操作后立即执行,无需显式创建和运行会话。

5.2.2 PyTorch在生僻字识别中的应用

在生僻字识别方面,PyTorch提供了强大的工具来构建和训练复杂的神经网络。下面是如何使用PyTorch构建一个用于生僻字识别的简单CNN模型的示例:

import torch

import torch.nn as nn

import torch.optim as optim

# 定义一个CNN模型

class SimpleCNN(nn.Module):

def __init__(self):

super(SimpleCNN, self).__init__()

self.conv1 = nn.Conv2d(3, 32, kernel_size=3, padding=1)

self.pool = nn.MaxPool2d(2, 2)

self.conv2 = nn.Conv2d(32, 64, kernel_size=3, padding=1)

self.fc1 = nn.Linear(64 * 16 * 16, 512)

self.fc2 = nn.Linear(512, 10)

def forward(self, x):

x = self.pool(torch.relu(self.conv1(x)))

x = self.pool(torch.relu(self.conv2(x)))

x = x.view(-1, 64 * 16 * 16) # 展平特征图以适应全连接层

x = torch.relu(self.fc1(x))

x = self.fc2(x)

return x

# 创建模型实例

model = SimpleCNN()

# 定义损失函数和优化器

criterion = nn.CrossEntropyLoss()

optimizer = optim.Adam(model.parameters(), lr=0.001)

# 模型摘要,打印模型结构

print(model)

通过上述代码,我们定义了一个简单的CNN模型,随后可以进行训练、评估和预测。

5.2.3 比较TensorFlow和PyTorch

TensorFlow和PyTorch各有千秋,TensorFlow在企业级应用和生产部署上拥有广泛的支持和成熟的生态系统,而PyTorch的动态计算图特性让它在学术界和研究领域尤为受欢迎。选择哪一个框架取决于项目需求、团队熟悉度以及特定任务的性能要求。

在生僻字识别这一特定任务中,两者都提供了强大的工具和函数库来实现高效的模型构建和训练。最终选择哪一个框架,可能更多地取决于开发者的偏好、协作团队的技术栈以及项目长期维护和扩展的需求。

6. 训练流程

6.1 数据预处理

6.1.1 数据清洗

在处理任何形式的数据之前,都需要经过一个清洗的阶段,以确保输入到模型中的数据是高质量且一致的。数据清洗涉及多个步骤,每个步骤都旨在识别和修正数据集中的不一致性、错误或缺失值。

一个常见的数据清洗步骤是去除重复的样本。在生僻字图像增强数据集中,可能会出现同一个生僻字的不同图像,这些图像在某些情况下可能非常相似或完全相同。通过移除重复项,可以减少训练时间并提高模型的泛化能力。

另一个重要的步骤是处理缺失值。如果某些图像信息丢失(例如,因为损坏或其他原因),这些图像就应该从数据集中移除。或者,如果可能的话,可以尝试使用图像恢复技术来重建缺失的信息。

代码示例:

import pandas as pd

# 假设我们有一个包含图像信息的DataFrame

dataframe = pd.read_csv('data.csv')

# 移除重复项

dataframe = dataframe.drop_duplicates()

# 处理缺失值

dataframe = dataframe.dropna()

# 保存清洗后的数据

dataframe.to_csv('cleaned_data.csv', index=False)

在这个示例中,我们使用了Pandas库来处理CSV格式的数据。首先,我们读取包含数据的CSV文件,然后使用 drop_duplicates 方法移除重复项,并用 dropna 方法来移除缺失值。最后,清洗后的数据被保存到一个新的CSV文件中。

6.1.2 数据标注

数据标注是机器学习尤其是监督学习中不可或缺的一部分。在生僻字识别任务中,我们需要为每张图像中的字标记出正确的标签。这个标签告诉模型该图像中包含的是哪个生僻字,这是训练模型进行识别的关键。

数据标注过程不仅需要精确,还要求具有高度的一致性。不准确或不一致的标签可能导致模型学习到错误的信息,进而影响到最终的识别效果。

为了提高标注过程的效率和准确性,通常会使用一些标注工具来辅助完成这项工作。例如,LabelImg是一个流行的图像标注工具,它可以加快标注过程,并确保标注的一致性。

6.2 模型构建

6.2.1 模型选择

在训练模型之前,选择一个合适的模型架构是关键的一步。对于生僻字识别问题,通常会从卷积神经网络(CNN)开始,因为CNN在图像识别领域表现出色。

选择模型时,我们需要考虑数据集的大小、生僻字的复杂性以及我们希望模型达到的准确度和速度。对于小数据集,可以考虑使用预训练的模型如ResNet或VGG,并对模型进行微调以适应我们的特定任务。对于更大的数据集,可能会选择构建一个从头开始训练的深度CNN架构。

6.2.2 模型训练

模型训练是机器学习的中心环节,这一过程涉及使用训练数据来调整模型的权重。在深度学习中,这个过程通常涉及到反向传播算法和梯度下降优化方法。

训练时,我们还需要决定多个超参数,例如学习率、批量大小、训练周期(epochs)等。这些参数的选择会直接影响到模型训练的稳定性和性能。

代码示例:

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import Dense, Conv2D, Flatten

from tensorflow.keras.optimizers import Adam

# 创建一个简单的CNN模型

model = Sequential([

Conv2D(32, (3,3), activation='relu', input_shape=(64, 64, 1)),

Flatten(),

Dense(128, activation='relu'),

Dense(num_classes, activation='softmax') # num_classes是类别总数

])

# 编译模型

***pile(optimizer=Adam(), loss='categorical_crossentropy', metrics=['accuracy'])

# 训练模型

model.fit(x_train, y_train, batch_size=32, epochs=10, validation_data=(x_val, y_val))

在这个示例中,我们构建了一个简单的CNN模型,包含一个卷积层和两个全连接层。模型使用Adam优化器和交叉熵损失函数进行编译。之后,模型使用训练数据进行训练,同时进行了10个周期的验证。

6.3 验证和测试

6.3.1 模型验证

模型验证是训练过程中的一个关键步骤,它帮助我们监控模型在未知数据上的表现。通常,数据集会被分为训练集和验证集。模型的性能在验证集上的评估用于判断模型是否过度拟合训练数据。

在深度学习中,常见的做法是在每个训练周期(epoch)结束时,记录模型在验证集上的损失和准确率。通过绘制训练和验证的损失/准确率曲线,我们可以分析模型的收敛性能。

6.3.2 模型测试

模型测试是在模型的训练完成后进行的最终评估。这个步骤中,模型会在一个完全独立的测试集上进行评估。测试集中的数据是在模型开发过程的任何时间点都没有看到的。

测试结果是评价模型泛化能力的最终指标。我们通过比较模型在测试集和训练集上的性能来确定模型是否具有良好的泛化能力。

在测试后,如果模型表现不佳,可能需要返回模型设计阶段进行调整,或者检查数据预处理和模型训练过程中的潜在问题。如果测试结果令人满意,则模型可以被部署到实际应用中。

7. 先进技术在生僻字识别中的应用

7.1 迁移学习

7.1.1 迁移学习的基本原理

迁移学习是一种机器学习方法,其核心思想是将一个领域(源领域)中获得的知识应用到另一个不同但相关的领域(目标任务领域)。在深度学习中,这意味着利用在大型数据集上预训练得到的模型作为起点,通过少量的任务特定数据对模型进行微调,从而解决目标任务。

迁移学习在生僻字识别中的应用能够减少从头开始训练模型所需的大量标注数据,并缩短训练时间。这种方法特别适合那些样本较少且训练数据难以获得的领域。

7.1.2 迁移学习在生僻字识别中的应用

在生僻字识别任务中,通常可以采用在大规模图像数据集(如ImageNet)上预训练的卷积神经网络模型。为了适应生僻字识别任务,我们会进行以下步骤: 1. 选取预训练模型,如ResNet、VGG等。 2. 移除模型最后几层全连接层,并替换为与生僻字数据集类别数相匹配的新全连接层。 3. 使用生僻字数据集对新层进行微调,同时可能需要调整学习率和训练策略以适应新任务。

代码示例:

import torch

import torchvision.models as models

from torchvision import transforms

from torch.utils.data import DataLoader

# 选择预训练模型

model = models.resnet50(pretrained=True)

# 替换全连接层

num_ftrs = model.fc.in_features

model.fc = torch.nn.Linear(num_ftrs, num_classes) # num_classes是生僻字数据集的类别数

# 数据转换

data_transforms = ***pose([

transforms.Resize(256),

transforms.CenterCrop(224),

transforms.ToTensor(),

transforms.Normalize(mean=[0.485, 0.456, 0.406], std=[0.229, 0.224, 0.225]),

])

# 加载数据集并创建DataLoader

train_dataset = ... # 定义训练数据集

train_loader = DataLoader(train_dataset, batch_size=32, shuffle=True)

# 微调模型

optimizer = torch.optim.Adam(model.fc.parameters())

model.train()

for epoch in range(num_epochs):

for inputs, labels in train_loader:

optimizer.zero_grad()

outputs = model(inputs)

loss = criterion(outputs, labels)

loss.backward()

optimizer.step()

# 评估模型

# ...

7.2 注意力机制

7.2.1 注意力机制的基本原理

注意力机制是受人类视觉注意力系统启发的神经网络机制,它允许模型在处理数据时更加“关注”于任务相关的关键信息。在深度学习中,注意力机制可以增强模型对于输入数据中的重要部分的敏感性,同时抑制不那么重要的部分。

注意力机制在生僻字识别中的作用显著,因为生僻字往往具有复杂的笔画和结构,注意力机制可以帮助模型集中于识别的关键特征。

7.2.2 注意力机制在生僻字识别中的应用

在使用卷积神经网络进行生僻字识别时,可以将注意力机制集成到模型中。一个常见的方式是使用空间注意力机制,它专注于图像的特定区域,这些区域对于识别目标生僻字可能更为重要。这可以通过在CNN的卷积层之后添加注意力模块来实现。

代码示例:

import torch.nn as nn

import torch.nn.functional as F

class AttentionModule(nn.Module):

def __init__(self, in_channels):

super(AttentionModule, self).__init__()

self.avg_pool = nn.AdaptiveAvgPool2d(1)

self.conv1 = nn.Conv2d(in_channels, in_channels // 8, 1, bias=False)

self.conv2 = nn.Conv2d(in_channels // 8, in_channels, 1, bias=False)

self害羞激活函数 = nn.Sigmoid()

def forward(self, x):

b, c, _, _ = x.size()

y = self.avg_pool(x).view(b, c, 1, 1)

y = self害羞激活函数(self.conv2(self害羞激活函数(self.conv1(y))))

out = x * y.expand_as(x)

return out

# 将注意力模块集成到生僻字识别模型中

# ...

在以上代码中,我们首先创建了一个注意力模块类,该类包含一个自适应平均池化层、两个卷积层和一个Sigmoid激活函数。在前向传播过程中,模块会计算输入数据的注意力图,并与输入特征图相乘,从而突出重要特征,抑制不重要的特征。

在构建生僻字识别模型时,可以将注意力模块插入到适当的位置,比如在卷积层之后或全连接层之前,以提升模型识别生僻字的性能。

通过结合迁移学习和注意力机制,可以显著提高生僻字识别的准确性和效率。这些技术不仅在生僻字识别任务中展现了强大的应用价值,也为计算机视觉和自然语言处理领域的其他复杂任务提供了新的解决思路和工具。

简介:生僻字带增强图片数据集是一项计算机视觉与自然语言处理结合的资源,用于训练高准确度的生僻汉字识别模型。该数据集包含经过旋转、缩放、翻转和噪声注入等处理的图片,以模拟现实视觉条件并提高模型泛化能力。数据集的构建涉及到深度学习模型,如CNN和RNN,以及特征提取和分类技术。训练流程包括数据预处理、模型构建、训练、验证和测试,采用技术如迁移学习和注意力机制进一步提升模型性能。

1831

1831

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?