用爬虫爬取网站小说

目标网站

url

https://www.juyit.com/xiaoshuo/159/159107/

爬行主页面

原理简述

选择有所有个章节标题的总览页面为爬虫主页面

爬取所有章节的名称和url

爬取书名

通过url进入章节后爬取章节内容

将内容写入txt文件,将无用字符替换为空,再进行保存

通过循环进入下一章节

直到所有章节爬行完毕

代码

import re

import requests

# 路径

url = 'https://www.juyit.com/xiaoshuo/159/159107/'

response = requests.get(url)

# 设置编码格式为“gbk”

response.encoding = 'gbk'

html = response.text

#获取目录列表

dl = re.findall(r'<dt><h3>霸王与娇花全文阅读</h3></dt>.*?</dl>',html,re.S)[0]

#获取章节url和名称

chapter_info_list = re.findall(r'href="(.*?)">(.*?)<',dl)

#获取书名

title = re.findall(r'<h1>(.*?)</h1>',html)[0]

#创建txt

fb = open('%s.txt' % title,'w',encoding='gbk')

#循环导出文件

for chapter_info in chapter_info_list:

# 获取文章章节名

chapter_title = chapter_info[1]

# 获取章节url

chapter_url = chapter_info[0]

chapter_url = "https://www.juyit.com/xiaoshuo/159/159107/%s" % chapter_url

chapter_response = requests.get(chapter_url)

# 设置编码格式为“gbk”

chapter_response.encoding = 'gbk'

chapter_html = chapter_response.text

#获取文本内容

chapter_content = re.findall(r'book_hzh\(\);</script>(.*?)</p>',chapter_html,re.S)[0]

#替换字符

chapter_content = chapter_content.replace(' ','')

chapter_content = chapter_content.replace('<br />','\n\t')

# 写入txt

fb.write(chapter_title)

fb.write("\n")

fb.write(chapter_content)

fb.write("\n")

print(chapter_url)

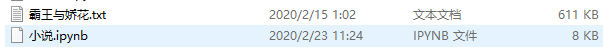

爬行结果预览

结论与感想

1、编码格式要根据网页进行更改,中文一般为“utf-8”和“gbk”,否则会出现乱码

2、在设置爬取内容时,正则表达式前后选择要唯一,否则会出现列表超出的错误情况

3、活用替换和写入时的空格“ ”和换行“\n”,可对文本格式进行简单调整,让阅读更流畅

3、本爬虫为基础爬虫代码,不适用于复杂网页,需要自己再进行修改

4、不推荐爬虫爬取小说的做法,建议购买正版

1808

1808

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?