《Structured Knowledge Distillation for Semantic Segmentation》论文阅读笔记

作者:Yifan Liu, Ke Chen,Chris Liu,Zengchang Qin,Zhenbo Luo,Jingdong Wang

论文链接:https://openaccess.thecvf.com/content_CVPR_2019/papers/Liu_Structured_Knowledge_Distillation_for_Semantic_Segmentation_CVPR_2019_paper.pdf

GitHub地址:https://github.com/irfanICMLL/structure_knowledge_distillation

介绍

文章提出一种利用大型网络训练小型语义分割网络的知识蒸馏策略。

主要贡献包括:

1.研究了知识蒸馏策略,有助于训练小型的语义分割网络,提升精度;

2.提出了两种结构化知识蒸馏方法:成对蒸馏(pair-wise distillation)和整体蒸馏(holistic distillation)。

方法

1. 像素蒸馏(Pixel-wise distillation)

将分割问题看作是一组独立像素分类问题的集合,直接使用知识蒸馏来对齐teacher网络和student网络中每个像素的类别概率,即将从teacher中得到的类别概率作为软目标来训练teacher网络。

2. 成对蒸馏(Pair-wise distillation)

受到被广泛采用的改善空间标记连续性的成对马尔可夫随机场框架的启发,作者提出转换这种成对的关系。论文的实现的方法是转换像素之间的成对相似性。具体来说,即分别计算teacher和student网络输出结果中像素点之间的相似性,然后对齐两个similarity map,其中两个像素之间的相似性的计算是通过a

i

j

_{ij}

ij=f

i

_{i}

i

T

^{T}

Tf

j

_{j}

j/(||f

i

_{i}

i||

2

_{2}

2||f

j

_{j}

j||

2

_{2}

2)计算得到的。

** 整体蒸馏(Holistic distillation)**

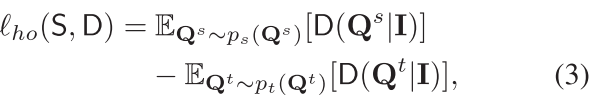

采用条件生成式对抗学习来构造整体蒸馏问题,对齐student网络和teacher网络的输出。损失的形式如下:

其中D是一个五卷积的全卷积神经网络。在最后三层之间插入两个自注意模块以获取结构信息。

网络整体架构如下:

部分实验结果如下

2268

2268

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?