Flink安装部署

1.安装

解压缩 flink-1.10.1-bin-scala_2.12.tgz,进入conf目录中。

1)修改 flink/conf/flink-conf.yaml 文件:

jobmanager.rpc.address: hadoop102

2)修改 /conf/slaves文件:

hadoop102

hadoop103

hadoop104

3)分发给另外两台机子:

[atguigu@hadoop102 module]$ xsync flink/

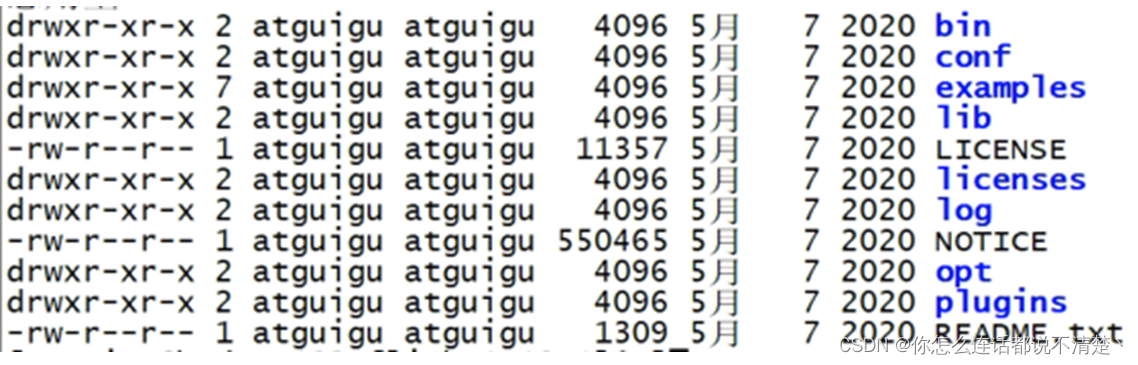

2.flink 目录结构

1.Bin目录

存放脚本,包括flink集群的启停脚本、flink提交job脚本

2.lib目录

存放flink 依赖的jar包,如果要导入外部依赖,需要放进这个目录

3.conf

flink配置文件目录

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

335

335

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?