1、转到目标目录

切换目录到想要部署的模型文件夹下,本次示例为yolov5

2、下载编译工具链

apt install cmake

apt-get install gcc-aarch64-linux-gnu g++-aarch64-linux-gnu

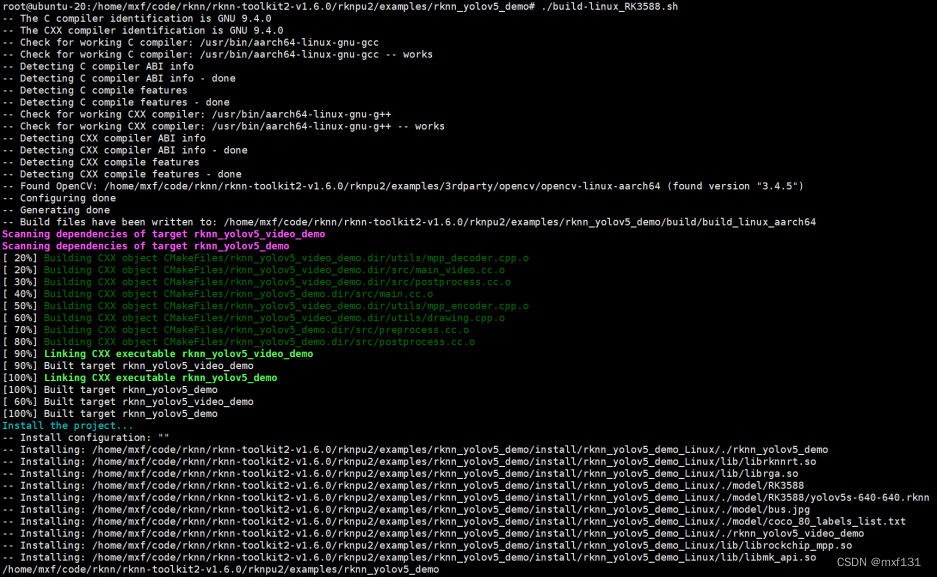

3、使用示例脚本编译

4、复制编译安装的文件夹到linux板子

编译安装好的文件在 ./install 目录下,方式有很多,在同一个局域网络下,传输工具就可以;实在不行拿U盘拷贝也是可以的。

5、给执行权限

在linux板子上执行,之后的步骤也都是在RK3588的板子上操作。

chmod +x rknn_yolov5_demo

6、执行测试

./rknn_yolov5_demo ./model/RK3588/yolov5s-640-640.rknn ./model/bus.jpg letterbox ./result.jpg

7、测试结果

6385

6385

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?