机器学习之线性分类以及Fisher线性判别

一、什么是线性分类器和Fisher判别

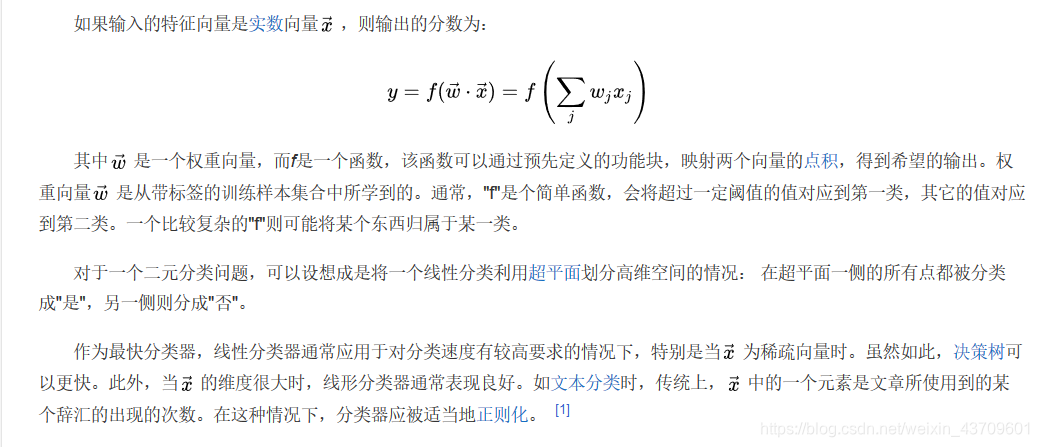

在机器学习领域,分类的目标是指将具有相似特征的对象聚集。而一个线性分类器则透过特征的线性组合来做出分类决定,以达到此种目的。对象的特征通常被描述为特征值,而在向量中则描述为特征向量。

线性分类器定义:

Fisher线性判别:

Fisher判别法是判别分析的方法之一,它是借助于方差分析的思想,利用已知各总体抽取的样品的p维观察值构造一个或多个线性判别函数y=l′x其中l= (l1,l2…lp)′,x= (x1,x2,…,xp)′,使不同总体之间的离差(记为B)尽可能地大,而同一总体内的离差(记为E)尽可能地小来确定判别系数l=(l1,l2…lp)′。数学上证明判别系数l恰好是|B-λE|=0的特征根,记为λ1≥λ2≥…≥λr>0。所对应的特征向量记为l1,l2,…lr,则可写出多个相应的线性判别函数,在有些问题中,仅用一个λ1对应的特征向量l1所构成线性判别函数y1=l′1x不能很好区分各个总体时,可取λ2对应的特征向量l′2建立第二个线性判别函数y2=l′2x,如还不够,依此类推。有了判别函数,再人为规定一个分类原则(有加权法和不加权法等)就可对新样品x判别所属 。

基本介绍:

两个总体的Fisher判别函数:

多个总体的Fisher判别函数:

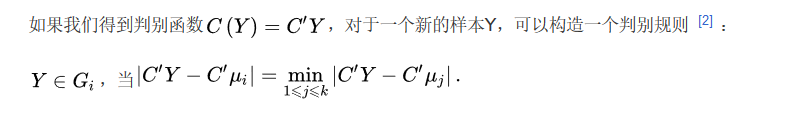

判别规则:

二、判别下一模式属于哪类

三、Fisher判别python代码的推导

Iris数据集的 Fisher线性分类判断及准确率计算:

#导入相关库

import pandas as pd

import numpy as np

import matplotlib.pyplot as plt

import seaborn as sns

#构建数据集

path=(r'http://archive.ics.uci.edu/ml/machine-learning-databases/iris/iris.data')

df = pd.read_csv(path, header=0)

Iris1=df.values[0:50,0:4]

Iris2=df.values[50:100,0:4]

Iris3=df.values[100:150,0:4]

#构建样本类内离散度矩阵

m1=np.mean(Iris1,axis=0)

m2=np.mean(Iris2,axis=0)

m3=np.mean(Iris3,axis=0)

s1=np.zeros((4,4))

s2=np.zeros((4,4))

s3=np.zeros((4,4))

for i in range(0,30,1):

a=Iris1[i,:]-m1

a=np.array([a])

b=a.T

s1=s1+np.dot(b,a)

for i in range(0,30,1):

c=Iris2[i,:]-m2

c=np.array([c])

d=c.T

s2=s2+np.dot(d,c)

for i in range(0,30,1):

a=Iris3[i,:]-m3

a=np.array([a])

b=a.T

s3=s3+np.dot(b,a)

sw12=s1+s2

sw13=s1+s3

sw23=s2+s3

#投影方向

a=np.array([m1-m2])

sw12=np.array

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

3万+

3万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?