数据集介绍

本文所使用的数据集为三种水果数据集,下载链接为:https://download.csdn.net/download/weixin_43799388/84425688

- 数据集文档结构如下:

|——-Fruit

|---Annotations

|---001.xml

|---002.xml

... ...

|---340.xml

|---images

|---001.jpg

|---002.jpg

... ...

|---340.jpg

- 该数据使用精灵标注助手进行标注,并导出xml格式

- 若数据集数量巨大,且命名不规范,要按规范批量修改文件名,建议使用菲菲更名宝贝软件进行批量更改文件名,使用方式如下:

- 从官网下载并安装最新版本软件

- 打开软件后,点击左上角添加一个文件或文件夹,将要修改的文件导入软件

- 之后按照下图所示逐步进行修改,最后点击左上角开始更名,完成批量规范重命名操作

xml2txt

标注格式介绍

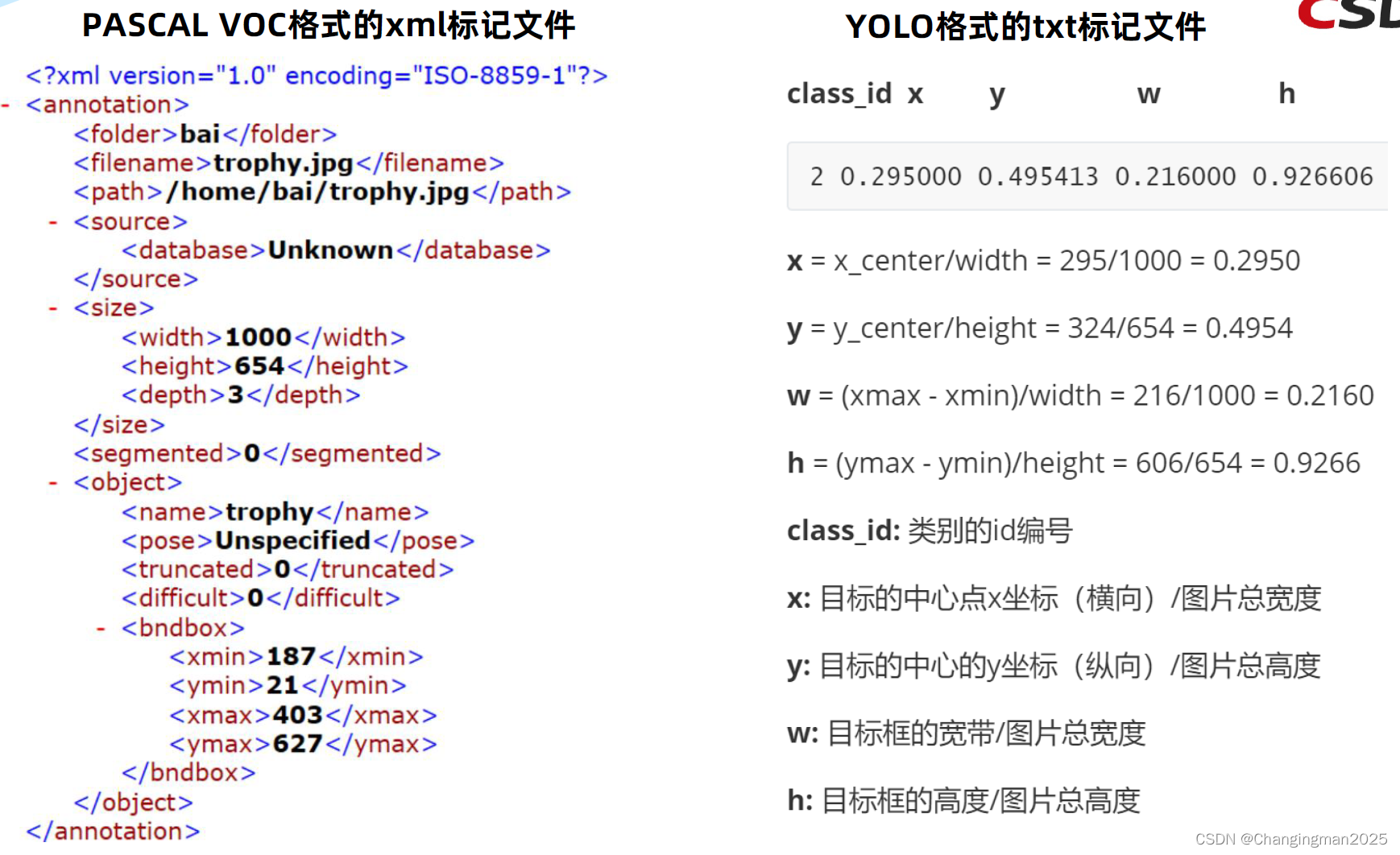

xml格式的标注信息中,box坐标信息是以xyxy格式标注的,也就是GT框的左上角坐标(xmin, ymin)和右下角坐标(xmax, ymax)

YOLOv5中使用的数据标注文件为.txt,GT框坐标信息是以xywh格式标注的,也就是GT框的归一化中心点坐标(x, y)和归一化宽高(width, height),二者的区别去下图所示:

转换步骤

1、maketxt.py

- 将原数据集划分为train、val和test三部分,其中train+val(组合成trainval部分)占总数据集90%,test部分占10%,train部分有占trainval部分的90%,因此,train: val: test = 8: 1: 1

- 程序执行结果如下:

|——-Fruit

|---Annotations

|---001.xml

|---002.xml

... ...

|---340.xml

|---images

|---001.jpg

|---002.jpg

... ...

|---340.jpg

|---ImageSets

|---test.txt # 存放测试集图片名称

|---train.txt # 存放训练集图片名称

|---trainval.txt # 存放训练验证集图片名称

|---val.txt # 存放验证集图片名称

- Pytorch源码如下:

import os

import random

'''

对图片数据集进行随机分类

以8: 1: 1的比例分为训练数据集,验证数据集和测试数据集

运行后在ImageSets文件夹中会出现四个文件

'''

ROOT = '../datasets/Fruit/'

trainval_percent = 0.9

train_percent = 0.9

xmlfilepath = ROOT + 'Annotations'

txtsavepath = ROOT + 'ImageSets'

# 获取该路径下所有文件的名称,存放在list中

total_xml = os.listdir(xmlfilepath)

num = len(total_xml)

list = range(num)

tv = int(num * trainval_percent)

tr = int(tv * train_percent)

trainval = random.sample(list, tv)

train = random.sample(trainval, tr)

ftrainval = open(ROOT + 'ImageSets/trainval.txt', 'w')

ftest = open(ROOT + 'ImageSets/test.txt', 'w')

ftrain = open(ROOT + 'ImageSets/train.txt', 'w')

fval = open(ROOT + 'ImageSets/val.txt', 'w')

for i in list:

# 获取文件名称中.xml之前的序号

name = total_xml[i][:-4] + '\n'

if i in trainval:

ftrainval.write(name)

if i in train:

ftrain.write(name)

else:

fval.write(name)

else:

ftest.write(name)

ftrainval.close()

ftrain.close()

fval.close()

ftest.close()

2、voc2txt.py

- 将xml文件转化为txt文件,xml文件包含了对应的GT框以及图片长宽大小等信息,通过对其解析,并进行归一化最终读到txt文件中

- 同时生成train、val和test数据集中图片的绝对路径,用于索引到图片位置

- 程序执行结果如下:

|——-Fruit

|---Annotations

|---001.xml

|---002.xml

... ...

|---340.xml

|---images

|---001.jpg

|---002.jpg

... ...

|---340.jpg

|---ImageSets

|---test.txt # 存放测试集图片名称

|---train.txt # 存放训练集图片名称

|---trainval.txt # 存放训练验证集图片名称

|---val.txt # 存放验证集图片名称

|---labels

|---001.txt

|---002.txt

... ...

|---340.txt

|---test.txt # 存放测试集图片绝对路径

|---train.txt # 存放训练集图片绝对路径

|---val.txt # 存放验证集图片绝对路径

- Pytorch源码如下:

import xml.etree.ElementTree as ET # xml解析包

import os

sets = ['train', 'test', 'val']

classes = ['apple', 'banana', 'grape']

# 进行归一化操作

def convert(size, box): # size:(原图w,原图h) , box:(xmin,xmax,ymin,ymax)

dw = 1. / size[0] # 1/w

dh = 1. / size[1] # 1/h

x = (box[0] + box[1]) / 2.0 # 物体在图中的中心点x坐标

y = (box[2] + box[3]) / 2.0 # 物体在图中的中心点y坐标

w = box[1] - box[0] # 物体实际像素宽度

h = box[3] - box[2] # 物体实际像素高度

x = x * dw # 物体中心点x的坐标比(相当于 x/原图w)

w = w * dw # 物体宽度的宽度比(相当于 w/原图w)

y = y * dh # 物体中心点y的坐标比(相当于 y/原图h)

h = h * dh # 物体宽度的宽度比(相当于 h/原图h)

return (x, y, w, h) # 返回 相对于原图的物体中心点的x坐标比,y坐标比,宽度比,高度比,取值范围[0-1]

# year ='2012', 对应图片的id(文件名)

def convert_annotation(root, image_id):

'''

将对应文件名的xml文件转化为label文件,xml文件包含了对应的bunding框以及图片长宽大小等信息,

通过对其解析,然后进行归一化最终读到label文件中去,也就是说

一张图片文件对应一个xml文件,然后通过解析和归一化,能够将对应的信息保存到唯一一个label文件中去

labal文件中的格式: calss x y w h,同时,一张图片对应的类别有多个,所以对应的buinding的信息也有多个

'''

# 对应的通过year 找到相应的文件夹,并且打开相应image_id的xml文件,其对应bund文件

in_file = open(root + 'Annotations/%s.xml' %

(image_id), encoding='utf-8')

# 准备在对应的image_id 中写入对应的label,分别为

# <object-class> <x> <y> <width> <height>

out_file = open(root + 'labels/%s.txt' %

(image_id), 'w', encoding='utf-8')

# 解析xml文件

tree = ET.parse(in_file)

# 获得对应的键值对

root = tree.getroot()

# 获得图片的尺寸大小

size = root.find('size')

# 如果xml内的标记为空,增加判断条件

if size != None:

# 获得宽

w = int(size.find('width').text)

# 获得高

h = int(size.find('height').text)

# 遍历目标obj

for obj in root.iter('object'):

# 获得difficult

if obj.find('difficult'):

difficult = int(obj.find('difficult').text)

else:

difficult = 0

# 获得类别 =string 类型

cls = obj.find('name').text

# 如果类别不是对应在我们预定好的class文件中,或difficult==1则跳过

if cls not in classes or int(difficult) == 1:

continue

# 通过类别名称找到id

cls_id = classes.index(cls)

# 找到bndbox 对象

xmlbox = obj.find('bndbox')

# 获取对应的bndbox的数组 = ['xmin','xmax','ymin','ymax']

b = (float(xmlbox.find('xmin').text), float(xmlbox.find('xmax').text), float(xmlbox.find('ymin').text),

float(xmlbox.find('ymax').text))

print(image_id, cls, b)

# 带入进行归一化操作

# w = 宽, h = 高, b= bndbox的数组 = ['xmin','xmax','ymin','ymax']

bb = convert((w, h), b)

# bb 对应的是归一化后的(x,y,w,h)

# 生成 calss x y w h 在label文件中

out_file.write(str(cls_id) + " " +

" ".join([str(a) for a in bb]) + '\n')

if __name__ == '__main__':

ROOT = '../datasets/Fruit/'

for image_set in sets:

'''

对所有的文件数据集进行遍历

做了两个工作:

1.将所有图片文件都遍历一遍,并且将其所有的全路径都写在对应的txt文件中去 方便定位

2.同时对所有的图片文件进行解析和转化,将其对应的 bundingbox 以及类别的信息全部解析写到 label 文件中去

最后再通过直接读取文件 就能找到对应的 label 信息

'''

# 先找labels文件夹如果不存在则创建

if not os.path.exists(ROOT + 'labels/'):

os.makedirs(ROOT + 'labels/')

# 读取在 ImageSets 中的train、test..等文件的内容

# 包含对应的文件名称

image_ids = open(ROOT + 'ImageSets/%s.txt' %

(image_set)).read().strip().split()

# 打开对应的.txt 文件对其进行写入准备

list_file = open(ROOT + '%s.txt' % (image_set), 'w')

# 将对应的文件_id以及全路径写进去并换行

for image_id in image_ids:

list_file.write(ROOT + 'images/%s.jpg\n' % (image_id))

# 开始解析xml文件的标注格式

convert_annotation(root=ROOT, image_id=image_id)

# 关闭文件

list_file.close()

xml2json

标注格式介绍

COCO全称是Common Objects in COntext,是微软团队提供的一个可以用来进行图像识别的数据集。MS COCO数据集中的图像分为训练、验证和测试集,总共有80个类别;COCO数据集现在有3种标注类型:object instances(目标实例), object keypoints(目标上的关键点), 和image captions(看图说话),使用json文件存储;本文以目标实例检测为例,官方下载地址为:http://images.cocodataset.org/annotations/annotations_trainval2017.zip

COCO目标检测实例的标注信息本身是一个大的字典,其中又包含5个字段信息:info, licenses, images, annotations,categories,每个字段中又分为多个字典存储各自的信息,在实际中,‘info’ 和‘license’一般用不上,我们可以把它置空;详细介绍可以参考这篇博客COCO数据集标注格式及意义

需要注意的是,COCO目标检测实例的标注信息中,box坐标信息是以xywh格式标注的,是GT框的左上角坐标(xmin, ymin)和宽高(width, height),和YOLO格式的标注信息有所不同。

转换步骤

1、maketxt.py

- 同xml2txt中的maketxt.py

- 这里只划分train和val数据集

|——-Fruit

|---Annotations

|---001.xml

|---002.xml

... ...

|---340.xml

|---images

|---001.jpg

|---002.jpg

... ...

|---340.jpg

|---ImageSets

|---train.txt # 存放训练集图片名称

|---val.txt # 存放验证集图片名称

2、split_datasets.py

- 用于将train和val数据集放置在各自的文件夹中

|——-Fruit

|---Annotations

|---001.xml

|---002.xml

... ...

|---340.xml

|---images

|---001.jpg

|---002.jpg

... ...

|---340.jpg

|---ImageSets

|---train.txt # 存放训练集图片名称

|---val.txt # 存放验证集图片名称

|---train

|---001.jpg

|---002.jpg

... ...

|---val

|---046.jpg

|---049.jpg

... ...

- Pytorch源码如下:

"""

用于数据集的划分,将全部图片分为train和val,并拷贝到不同文件夹下

"""

import shutil

if __name__ == '__main__':

sets = ['train', 'val'] # 划分数据集的类型

ROOT = './data/Fruit/' # 数据集路径

IMG_ROOT = ROOT + 'images' # 图片路径

# 开始遍历数据集 并进行划分拷贝

for img_set in sets:

NEW_ROOT = ROOT + img_set # 获取要目标文件夹路径

# 读取在 ImageSets 中的train.txt和val.txt 获取图片名称

img_ids = open(ROOT + 'ImageSets/%s.txt' %

(img_set)).read().strip().split()

# 获取图片原路径和要拷贝的路径 进行图片拷贝

for img_id in img_ids:

src_root = IMG_ROOT + '/' + img_id + '.jpg'

dst_root = NEW_ROOT + '/' + img_id + '.jpg'

shutil.copy(src=src_root, dst=dst_root)

3、voc2coco.py

- 生成train和val的标注文件,也就是json格式的标注文件,存放在annotations文件夹中

|——-Fruit

|---annotations

|---Fruit_train.json

|---Fruit_val.json

|---Annotations

|---001.xml

|---002.xml

... ...

|---340.xml

|---images

|---001.jpg

|---002.jpg

... ...

|---340.jpg

|---ImageSets

|---train.txt # 存放训练集图片名称

|---val.txt # 存放验证集图片名称

|---train

|---001.jpg

|---002.jpg

... ...

|---val

|---046.jpg

|---049.jpg

... ...

- Pytorch源码如下:

import shutil

import cv2

from tqdm import tqdm

import sys, os, json, glob

import xml.etree.ElementTree as ET

category_list = ['apple', 'banana', 'grape']

def convert_to_cocodetection(dir, datasets_name, output_dir):

"""

input:

dir:the path to DIOR dataset

output_dir:the path write the coco form json file

"""

annotations_path = os.path.join(dir, "Annotations_xml")

namelist_path = os.path.join(dir, "ImageSets")

train_images_path = os.path.join(dir, "train")

val_images_path = os.path.join(dir, "val")

id_num = 0

# 将数据集的类别信息 存放到字典中

label_ids = {name: i + 1 for i, name in enumerate(category_list)}

categories = []

for k, v in label_ids.items():

categories.append({"name": k, "id": v})

# 读取xml文件并转化为json

for mode in ["train", "val"]:

images = []

annotations = []

print(f"start loading {mode} data...")

if mode == "train":

f = open(namelist_path + "/" + "train.txt", "r")

images_path = train_images_path

else:

f = open(namelist_path + "/" + "val.txt", "r")

images_path = val_images_path

# 依次读取训练集或测试集中的每一张图片的名字

for name in tqdm(f.readlines()):

# 图片基本信息处理

image = {}

name = name.replace("\n", "")

image_name = name + ".jpg"

annotation_name = name + ".xml"

# 获取图像的height和width

height, width = cv2.imread(images_path + "/" + image_name).shape[:2]

# 向image字典中添加信息

image["file_name"] = image_name

image["height"] = height

image["width"] = width

image["id"] = name

images.append(image)

# xml标注文件信息解析

tree = ET.parse(annotations_path + "/" + annotation_name)

root = tree.getroot()

for obj in root.iter('object'):

annotation = {}

# 获得类别 =string 类型

category = obj.find('name').text

# 如果类别不是对应在我们预定好的class文件中则跳过

if category not in category_list:

continue

# 找到bndbox 对象

xmlbox = obj.find('bndbox')

# 获取对应的bndbox的数组 = ['xmin','xmax','ymin','ymax']

bbox = (float(xmlbox.find('xmin').text), float(xmlbox.find('ymin').text),

float(xmlbox.find('xmax').text), float(xmlbox.find('ymax').text))

# 整数化

bbox = [int(i) for i in bbox]

# 将voc的xyxy坐标格式,转换为coco的xywh格式

bbox = xyxy_to_xywh(bbox)

# 将xml中的信息存入annotations

annotation["image_id"] = name

annotation["bbox"] = bbox

annotation["category_id"] = category_list.index(category)

annotation["id"] = id_num

annotation["iscrowd"] = 0

annotation["segmentation"] = []

annotation["area"] = bbox[2] * bbox[3]

id_num += 1

annotations.append(annotation)

# 汇总所有信息,保存在字典中

dataset_dict = {}

dataset_dict["images"] = images

dataset_dict["annotations"] = annotations

dataset_dict["categories"] = categories

json_str = json.dumps(dataset_dict)

save_file = f'{output_dir}/{datasets_name}_{mode}.json'

with open(save_file, 'w') as json_file:

json_file.write(json_str)

print("json file write done...")

def xyxy_to_xywh(boxes):

width = boxes[2] - boxes[0]

height = boxes[3] - boxes[1]

return [boxes[0], boxes[1], width, height]

if __name__ == '__main__':

# 数据集的路径

DATASET_ROOT = './data/Fruit'

# 数据集名称

DATASET_NAME = 'Fruit'

# 输出coco格式的存放路径

JSON_ROOT = './data/Fruit/annotations'

# 递归删除之前存放帧图片的文件夹,并新建一个

try:

shutil.rmtree(JSON_ROOT)

except OSError:

pass

os.mkdir(JSON_ROOT)

convert_to_cocodetection(dir=DATASET_ROOT, datasets_name=DATASET_NAME, output_dir=JSON_ROOT)

4045

4045

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?