PipAttack: Poisoning Federated Recommender Systems for Manipulating Item Promotion–《通过操纵物体推广攻击联邦推荐系统》

核心思想:

- 利用数据驱动型推荐系统中普遍存在的热门偏差;

- 攻击模型使目标项目在嵌入空间中具有热门商品的特征;

- 通过少数恶意用户精心制作上传的梯度,增加目标(不受欢迎)项目在联邦推荐系统中的曝光率。

对推荐系统的投毒攻击的原因是曝光产生的经济效益。

原先的投毒攻击主要是数据投毒,但联邦推荐系统数据保存是分布式的。

普通推荐系统→去中心化→联邦推荐系统

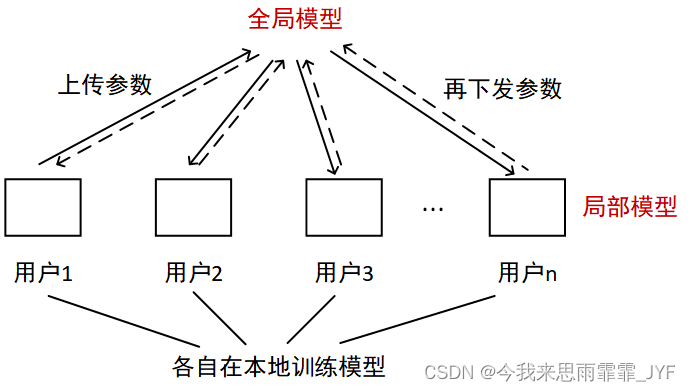

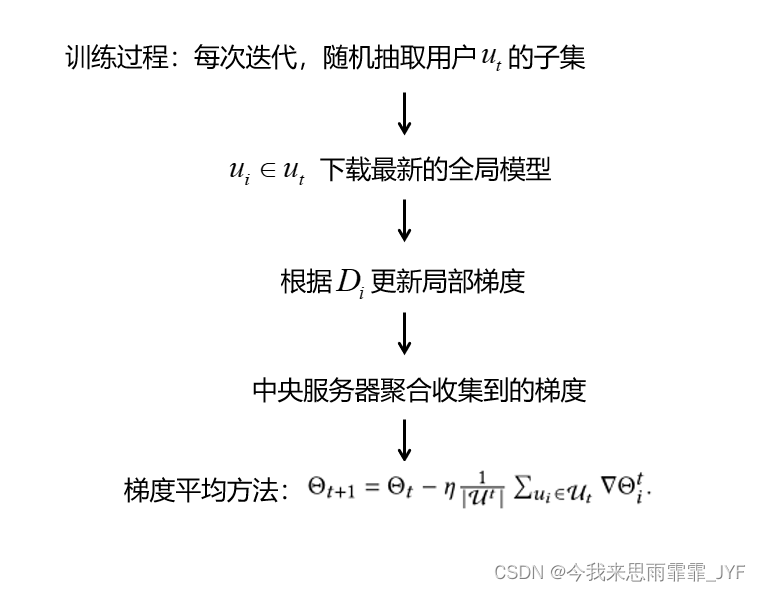

联邦学习:

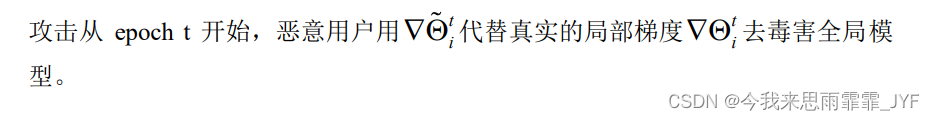

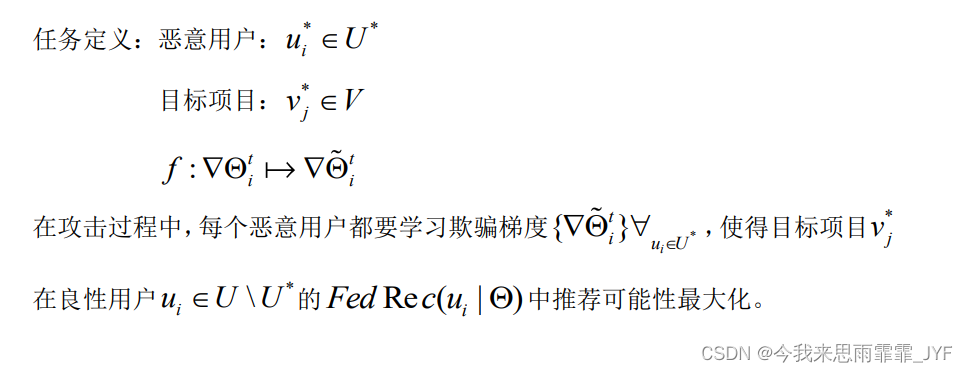

攻击方法: 对模型投毒,操纵恶意用户提交的局部模型梯度。

贡献:

- 发现去中心化的联邦推荐系统存在安全隐患;

- 根据热门偏差利用恶意用户上传中毒的本地梯度攻击联邦推荐系统;

- 成本效益更高,需要更少的模型更新和恶意用户。

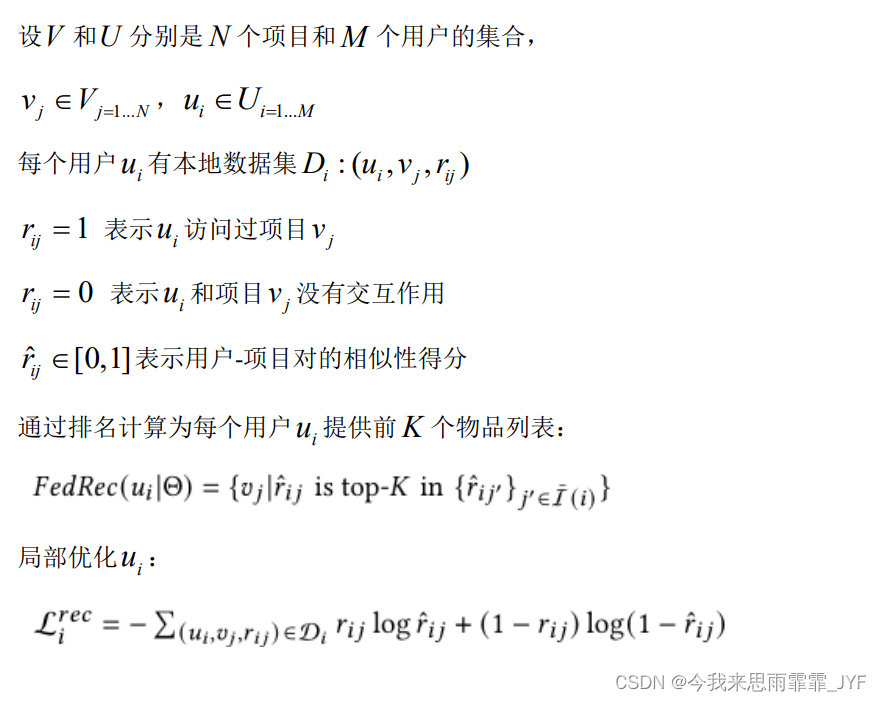

联邦推荐系统:

中毒攻击:

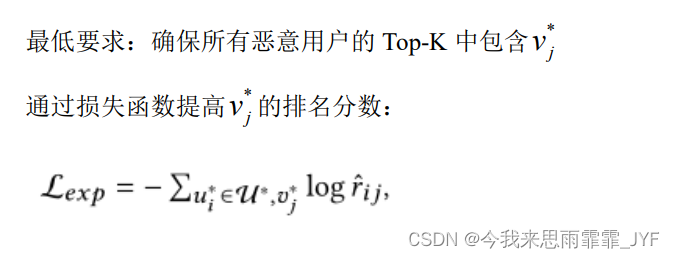

模型损失函数:

-

提高目标项目的排名分数;

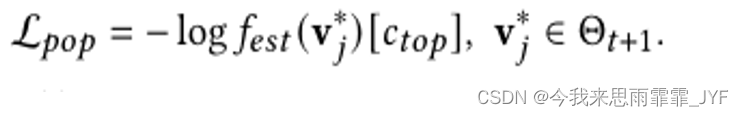

-

热门混淆:将目标项目与嵌入空间中的热门项目对齐来混淆联邦推荐;

-

距离约束:避免损害联邦推荐器的可用性和被检测到攻击,距离约束可以防止恶意用户上传的操纵梯度偏离原始梯度太远。

1971

1971

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?