Frequency constraint-based adversarial attack on deep neural networks for medical image classification ----《基于频域约束的深度神经网络医学图像分类的对抗攻击》

目标: 设计一种统一的攻击方法,生成内容相似度高的难以感知的攻击样本,并应用于不同的医学图像分类系统中。

背景: 近年来,人工智能系统的安全性受到了极大的关注,尤其是在医疗诊断领域。现有的攻击方法大多是针对自然图像分类模型而设计的,这种攻击不可避免地会对像素的语义造成干扰。

方法: 提出了一种新的基于频域约束的对抗攻击方法,在保留低频信息的同时对高频信息注入扰动,以保证内容的相似度,能够对不同的成像模式和维度的医学图像分类任务进行攻击。

主要优势: 攻击的不可察觉性,可转移到不同模型和数据集上。

引言

在许多自然图像分析任务中,深度神经网络(DNN)已经达到,并在许多情况下超过了人类水平,例如:图像分类[1-3],目标检测[4,5],分割[6]和三维图像分析[7,8]。随着自然图像领域的成功,DNN被证明是高效和有用的自动医学图像分类[9,10]。然而,最近的研究表明,DNN容易受到各种攻击[11,12],即经过良好训练的模型通过在原始图像上添加难以察觉的扰动而做出错误的预测。这对具有高安全性要求的医疗诊断系统[13]是一个严重的威胁。攻击者可以通过利用医疗对抗性实例来操纵诊断结果,以欺诈方式获得更高的医疗报销[14]。对抗性实例引起的错误结果有可能危及患者安全并导致不必要的医疗资源支出[15]。此外,这些攻击可能被不道德的医生利用,使他们能够通过操纵测试报告和进行不必要的手术来获利[16]。为了开发安全的医疗诊断系统,设计有效的对抗性攻击来识别和暴露系统中的漏洞至关重要,从而使研究人员能够提高其对潜在攻击的鲁棒性。

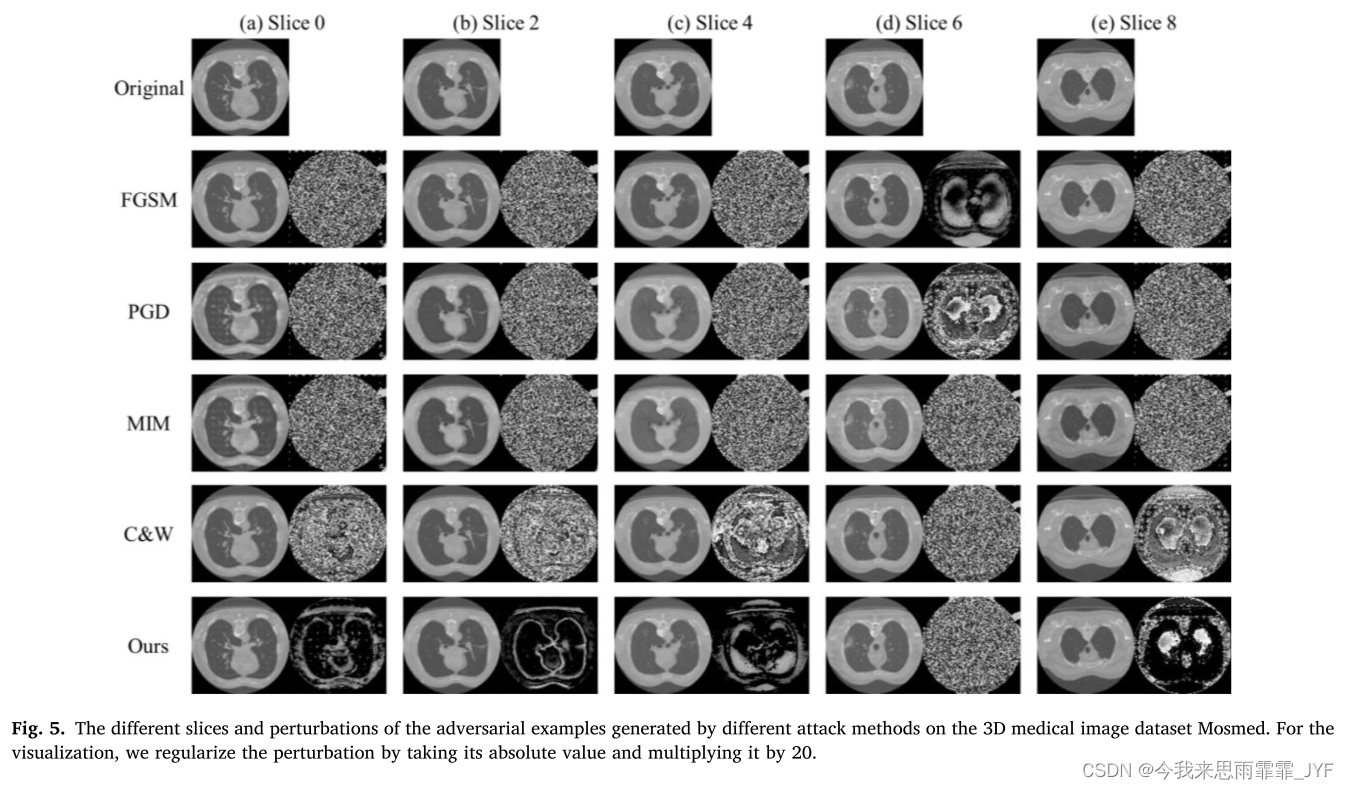

当涉及在自然图像领域攻击深度神经网络生成对抗性示例时,现有的许多攻击方法[11,17]都涉及到以全局干扰的方式向图像中添加噪声。这可能会导致生成的纹理与正常生理结构不匹配的医学对抗样本,从而使它们很容易被检测到。如图 1(a)所示,由现有的投影梯度下降(PGD)[17]方法生成的对抗示例包含大量扰动,即使在背景均匀的区域也是如此。

为了提高医学对抗样本的有效性和隐蔽性,本文提出了一种利用图像语义特征信息生成对抗样本的新方法。由于图像的底层信息存在于低频,而纹理、边缘细节和噪声存在于高频,该方法将对抗性样本限制在低频,并将噪声限制在高频,从而使生成的对抗性样本更加难以检测。通过这样做,生成的对抗样本中的扰动主要位于难以察觉的区域,例如对象边缘,如图 1(b)所示。与不考虑语义信息的现有方法相比,所提出的方法将将使更真实且不可检测的医学对抗样本成为可能。在这项研究中,我们提出了一种新颖的算法,它不仅可以攻击特征表示上的语义相似性,从而提高对抗性示例的可迁移性,而且还引入了低频约束来限制对高频分量的扰动,从而提高对抗性示例的不可察觉性。良好的可转移性和不可感知性确保我们的方法可以攻击具有不同成像模式和维度的医学图像分类任务。具体来说,我们的方法的主要贡献如下:

- 良好的转移性。 传统的白盒攻击方法通常通过最大化损失或改变 logits 来生成对抗性样本,这在很大程度上依赖于最终分类层的学习权重向量。相反,我们的方法侧重于攻击特征表示中的语义相似性,完全绕过分类层。在医学领域,扰动特征表示有利于实现对抗性样本的良好可转移性。我们的方法性能优越,可移植性强,优于其他攻击方法。

- 对人类视觉有良好的隐蔽性。 现有的研究表明,人类的视觉系统几乎察觉不到高频信号,但它们可以极大地影响DNN的预测结果。基于这种理解,我们的方法引入低频约束来限制高频分量的扰动,促进对抗样本的不可感知性。我们的方法产生的扰动较少,并且更多地集中于高频分量,例如边缘和纹理。我们的方法产生的扰动较少,并且更多地集中于高频分量,例如边缘和纹理。此外,与现有方法相比,我们的方法在生成对抗样本时具有更少的视觉差异和更大的不可感知性。

- 适用于不同的医学图像分类任务。 我们的实验包括四个公共医学图像数据集,包括一个3D CT数据集,一个2D胸部x射线图像数据集,一个2D乳房超声数据集,以及一个2D甲状腺超声数据集。这些公共医学图像数据集包含不同的成像模式和维度。在这些公共医疗诊断数据集上的大量实验表明,本方法可以为这些不同的医学图像分类任务生成对抗实例。

相关工作

对抗性攻击和防御

对抗实例的生成方法有很多[11,17 - 19],这些方法可以分为三类:基于梯度的[11,17]、基于查询的[20,21]和基于迁移的方法[22,23]。基于梯度的攻击利用相对于输入的损失梯度来生成对抗性示例。快速梯度符号法(FGSM)[11]通过一步更新梯度方向来生成扰动,而迭代攻击方法如动量迭代法 (MIM) [18] 和 PGD,通过多步更新扰动,以较小的扰动量实现较高的攻击成功率。基于查询的攻击依赖于模型的输出。Chen等人[20]提出了一种基于零阶优化的攻击方法,该方法依赖于模型输出结果的类概率。边界攻击[21]仅依赖于对抗性示例和原始对抗性示例之间的决策边界来生成对抗性示例。基于迁移的攻击旨在增强对抗实例的可泛化性。通过攻击代理模型生成的对抗样本可以成功攻击其他未知模型。Zhu等人[22]从数据分布的角度提出了分布式相关攻击(distributed - relevant attack, DRA)方法,通过操纵图像的分布以提高对抗性的可转移性。Zhang等人[24]通过使用神经元归因方法进行更精确的神经元重要性评估来进行特征级攻击。然而,这些方法通常存在可转移性差、耗时长或细节丢失等问题,从而损害了原始图像的语义信息。

为了减轻对抗性攻击的威胁,人们提出了各种对抗性防御方法。对抗训练[17,25]通过在训练数据中加入对抗样本,可以有效地提高模型的鲁棒性。然而,对抗训练既耗时计算成本又高,并且会降低模型的原始精度。对抗检测[26,27]试图通过利用对抗实例和原始实例之间的特征分布等差异来检测对抗实例。其他防御方法的目的是预处理输入图像,以消除敌对的攻击,如随机调整大小和填充[28],或者重建[29],使模型保持其原始性能。

基于频率的分析

最近,大量的研究从频域的角度为对抗性案例分析提供了新的见解。一个被广泛接受的共识是,低频区域与它的内容相关联,占了大部分的能量,而高频区域与图像的边缘和纹理信息相关联。Wang等人[30]提出高频分量对DNN的精度起着至关重要的作用,并提出了一种平滑卷积核方法来增强对低频特征的利用,提高模型的鲁棒性。Zhou等人[31]证明了对抗性例子的高频分量与目标类别图像的高频分量非常相似。Guo等人[32]提出了一种攻击方法,该方法仅通过操纵低频分量,有效地减少了模型查询的数量。然而,这种方法可能导致生成的对抗样本显得不太现实,很容易被发现。

最近,大量的研究从频域的角度为对抗性案例的分析提供了有价值的见解。一个被广泛接受的共识是,低频区域与图像的内容相连,包含了大部分能量,而高频区域则与图像的边缘和纹理信息有关 (我知道和上一段一样,但论文就是这么写的…) 。因此,当前的频域对抗攻击主要集中在限制或强调特定频域内容的干扰。Deng等人[33]提出了在每个频带中产生单个扰动分量的方法。Maiya等人[34]提出了一种基于频域的鲁棒性分析方法来解释和控制对抗训练中准确性与鲁棒性的权衡。Jia等人[35]利用lp−范数限制原始频域分布的偏差,用于人脸伪造检测。与现有的研究不同的是,我们提出了一种新的算法,该算法不仅攻击特征表示的语义相似度,从而提高对抗样本的可转移性,而且引入了低频约束,将扰动限制在高频分量上,促进对抗性例子的隐蔽性。

医学图像分类

DNN在医学领域被广泛应用于各种目的,包括分类、分割和检测任务。其中 DNNs[13]的使用对医学图像分类有很大的帮助。基于DNN的医学图像分类模型在某些疾病分类方面的表现甚至超过了人类水平,如糖尿病视网膜病变[36]、肺病[37]和皮肤癌[38]。然而,基于DNN的模型容易受到攻击,可能导致误诊或漏诊,造成严重后果[39]。因此,设计有效的多模态医学图像攻击算法来识别DNN在安全敏感应用中的不足是至关重要的。我们提出的攻击方法针对特征表示上的语义相似性,具有良好的跨数据集泛化能力。此外,我们使用傅里叶变换将图像变换到频域并限制低频,这将对抗性扰动限制在高频成分,导致对抗性样本更类似于原始图像。该攻击方法可以作为一种针对各类医学图像的统一攻击方法。

对抗性攻击符号表示:

特征空间攻击

指通过操纵图像表示,使其与来自不同类别的目标图像显著相似的攻击方式。

总结:

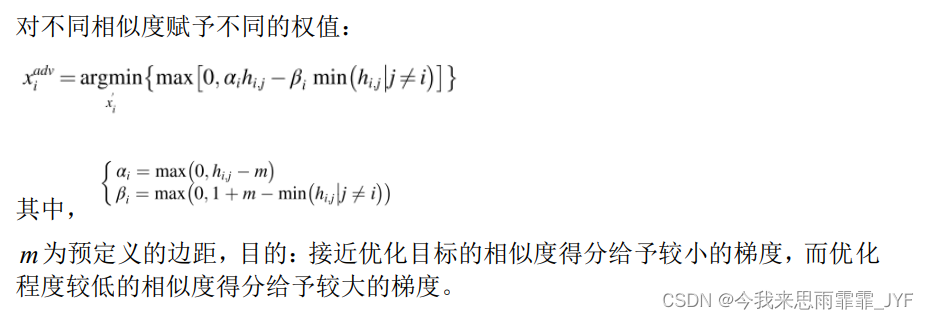

特征空间中语义相似度攻击通过降低对抗样本与其对应的原始样本之间的相似度来生成对抗示例,同时增加了批处理数据集中对抗样本与最不相似样本之间的相似度。

频域约束

原因:特征空间攻击生成的扰动仍然有可能被添加到医学图像的全局范围中,因此,需要将扰动限制在高频信息中。

实验

数据集: 1、胸部X光图像数据集;2、乳腺超声数据集;3、甲状腺超声数据集;4、胸部CT数据集。

步骤:首先用干净数据集训练模型,再用各种攻击方法攻击该模型。

评价指标:1、ASR:攻击成功率;2、FID:原始样本和对抗样本之间的相似度;3、LF:对抗样本在低频分量上的扰动大小。

总结:

- 目前的医学图像辅助诊断系统在面对攻击时非常脆弱,这些攻击使分类模型几乎失效,在实际应用中造成严重的安全风险。

- 所提出的攻击方法可以作为评估医疗诊断系统鲁棒性的一种方法。

- 引出一种频域角度的防御机制:压缩对抗性图像的高频成分。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?