机器翻译和数据集

机器翻译(MT):将一段文本从一种语言自动翻译为另一种语言,用神经网络解决这个问题通常称为神经机器翻译(NMT)。 主要特征:输出是单词序列而不是单个单词。 输出序列的长度可能与源序列的长度不同。

数据预处理

将数据集清洗、转化为神经网络的输入minbatch

字符在计算机里是以编码的形式存在,我们通常所用的空格是 \x20 ,是在标准ASCII可见字符 0x20~0x7e 范围内。 而 \xa0 属于 latin1 (ISO/IEC_8859-1)中的扩展字符集字符,代表不间断空白符nbsp(non-breaking space),超出gbk编码范围,是需要去除的特殊字符。再数据预处理的过程中,我们首先需要对数据进行清洗。

分词

字符串—单词组成的列表

建立词典

单词组成的列表—单词id组成的列表

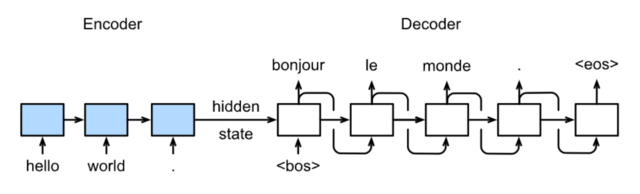

Encoder-Decoder

encoder:输入到隐藏状态

decoder:隐藏状态到输出

注意力机制与seq2seq模型

模型:

训练

预测:

具体结构:

损失函数

定义:衡量模型模型预测的好坏(用来表现预测与实际数据的差距程度)

比如你做一个线性回归,实际值和你的 预测值肯定会有误差,那么我们找到一个函数表达这个误差就是损失函数

和实际一样比如你是一个厨师大赛评委 几名厨师最后成绩由你确定 在你认为色香味都应该是100分才算冠军(这个100分就相当于实际值)

每个人都有自己的做菜方案和技巧,并且达到的效果也是不用的(这个就相当于预测值) 最后你是评委用你的一套规则判断他们多少分(你就是损失函数)

损失函数(loss function)是用来估量你模型的预测值f(x)与真实值Y的不一致程度,它是一个非负实值函数,通常使用L(Y, f(x))来表示,损失函数越小,模型的鲁棒性就越好。

Beam Search¶

简单greedy search:

维特比算法:选择整体分数最高的句子(搜索空间太大) 集束搜索:

课后习题:

Transfomer

注意力机制

在“编码器—解码器(seq2seq)”⼀节⾥,解码器在各个时间步依赖相同的背景变量(context vector)来获取输⼊序列信息。当编码器为循环神经⽹络时,背景变量来⾃它最终时间步的隐藏状态。将源序列输入信息以循环单位状态编码,然后将其传递给解码器以生成目标序列。然而这种结构存在着问题,尤其是RNN机制实际中存在长程梯度消失的问题,对于较长的句子,我们很难寄希望于将输入的序列转化为定长的向量而保存所有的有效信息,所以随着所需翻译句子的长度的增加,这种结构的效果会显著下降。

与此同时,解码的目标词语可能只与原输入的部分词语有关,而并不是与所有的输入有关。例如,当把“Hello world”翻译成“Bonjour le monde”时,“Hello”映射成“Bonjour”,“world”映射成“monde”。在seq2seq模型中,解码器只能隐式地从编码器的最终状态中选择相应的信息。然而,注意力机制可以将这种选择过程显式地建模。

注意力机制框架

不同的attetion layer的区别在于score函数的选择,在本节的其余部分,我们将讨论两个常用的注意层 Dot-product Attention 和 Multilayer Perceptron Attention;随后我们将实现一个引入attention的seq2seq模型并在英法翻译语料上进行训练与测试。

Softmax屏蔽

在深入研究实现之前,我们首先介绍softmax操作符的一个屏蔽操作。

点积注意力

The dot product 假设query和keys有相同的维度, 即 ∀i,𝐪,𝐤𝑖∈ℝ𝑑 . 通过计算query和key转置的乘积来计算attention score,通常还会除去 d 减少计算出来的score对维度𝑑的依赖性,如下

𝛼(𝐪,𝐤)=⟨𝐪,𝐤⟩/d

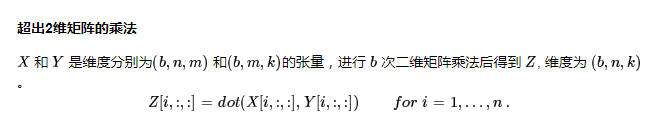

假设 𝐐∈ℝ𝑚×𝑑 有 m 个query, 𝐊∈ℝ𝑛×𝑑 有 n 个keys. 我们可以通过矩阵运算的方式计算所有 mn 个score:

𝛼(𝐐,𝐊)=𝐐𝐊𝑇/d

现在让我们实现这个层,它支持一批查询和键值对。此外,它支持作为正则化随机删除一些注意力权重.

测试

现在我们创建了两个批,每个批有一个query和10个key-values对。我们通过valid_length指定,对于第一批,我们只关注前2个键-值对,而对于第二批,我们将检查前6个键-值对。因此,尽管这两个批处理具有相同的查询和键值对,但我们获得的输出是不同的。

多层感知机注意力

在多层感知器中,我们首先将 query and keys 投影到 ℝℎ .为了更具体,我们将可以学习的参数做如下映射 𝐖𝑘∈ℝℎ×𝑑𝑘 , 𝐖𝑞∈ℝℎ×𝑑𝑞 , and 𝐯∈ℝh . 将score函数定义

𝛼(𝐤,𝐪)=𝐯𝑇tanh(𝐖𝑘𝐤+𝐖𝑞𝐪)

. 然后将key 和 value 在特征的维度上合并(concatenate),然后送至 a single hidden layer perceptron 这层中 hidden layer 为 ℎ and 输出的size为 1 .隐层激活函数为tanh,无偏置.

**

总结

**

注意力层显式地选择相关的信息。

注意层的内存由键-值对组成,因此它的输出接近于键类似于查询的值。

引入注意力机制的Seq2seq模型

本节中将注意机制添加到sequence to sequence 模型中,以显式地使用权重聚合states。下图展示encoding 和decoding的模型结构,在时间步为t的时候。此刻attention layer保存着encodering看到的所有信息——即encoding的每一步输出。在decoding阶段,解码器的 t 时刻的隐藏状态被当作query,encoder的每个时间步的hidden states作为key和value进行attention聚合. Attetion model的输出当作成上下文信息context vector,并与解码器输入 Dt 拼接起来一起送到解码器:

下图展示了seq2seq机制的所以层的关系,下面展示了encoder和decoder的layer结构

课后习题:

484

484

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?