前言

本篇博客主要是对《BERT Post-Training for Review Reading Comprehension and Aspect-based Sentiment Analysis》进行了泛读,并对其进行了简单地记录,以帮助大家快速了解此篇论文的要点。

一、论文信息

- 论文名:《BERT Post-Training for Review Reading Comprehension and Aspect-based Sentiment Analysis》

- 作者:Hu Xu, Bing Liu, Lei Shu, Philip S. Yu

- 领域:ABSA

- 关键词:BERT、Post-Training、Aspect-based Sentiment Analysis

- 发表年份:2019

- 会议/期刊名:NAACL

二、笔记要点

2.1 目前存在的问题

目前的在线问答系统不能很好的回答用户问题

2.2 目前解决方法

1、采用众包用户答案的方式,但是存在延迟不适合作为交互系统,并且仍然有很多没有答案;

2、已有的采用完整评论给用户的方法不可取,因为用户阅读它非常的耗时;

2.3 本文方法和创新点

创新点:

受机器阅读理解 (MRC) 最近在正式文档上取得成功的启发,本文探讨了将客户评论转化为可用于回答用户问题的大量知识来源的潜力。我们称这个问题为复习阅读理解 (RRC)。

方法:

post-training

2.4 模型结构

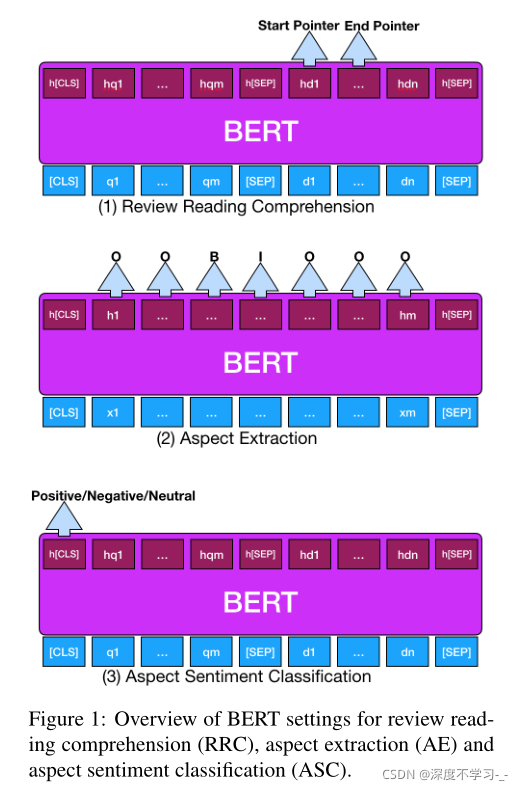

采用BERT进行的微调;

2.5 实验结果

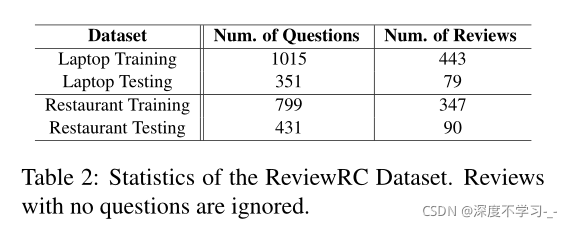

本文基于基于方面的情感分析的流行基准构建了一个名为 ReviewRC 的 RRC 数据集,如下图所示:

2.5.2 算法对比

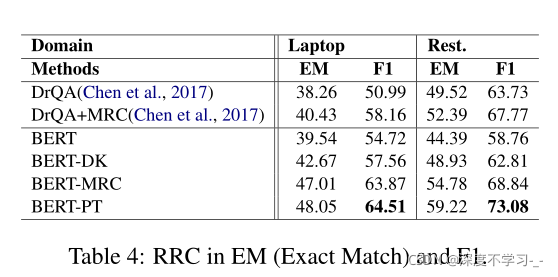

对比模型如下:

DrQA

DrQA+MRC

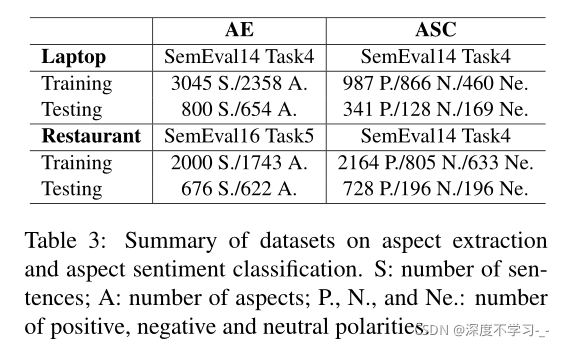

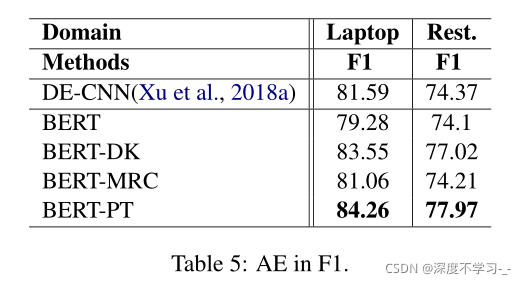

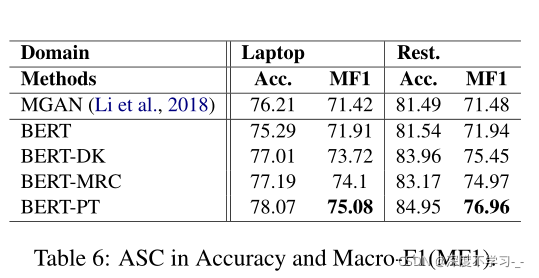

For AE and ASC:

DE-CNN

MGAN

BERT

BERT-DK

BERT-MRC

BERT-PT

对比结果如下:

2.6 总结和展望

- 提出了复习阅读理解(RRC)的新问题。

- 为了解决这个新问题,为 RRC 创建了一个带注释的数据集ReviewRC。

- 提出了一种通用的训练后方法来改善 RRC、AE 和 ASC

- 微调前的后训练方法是有效的。

总结

以上就是本篇博客的全部内容了,希望对你有所帮助。

2988

2988

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?