系列文章目录

- 【Domain Generalization(1)】增量学习/在线学习/持续学习/迁移学习/多任务学习/元学习/领域适应/领域泛化概念理解

- 第一篇了解了 DG 的概念,那么接下来将介绍 DG 近年在文生图中的相关应用/代表性工作。

- 【Domain Generalization(2)】领域泛化在文生图领域的工作之——PromptStyler(ICCV23)

- 【Domain Generalization(3)】领域泛化与文生图之 – QUOTA 任意领域生成物体的数量可控

- 本文则介绍 arXiv 上 23年 12 月,华为诺亚方舟实验室发布的工作 Cross Domain Generative Augmentation: Domain Generalization with Latent Diffusion Models

快速讲清楚

- 任务: 依然是 Image Classification,重点是用 LDM 来做数据增强。

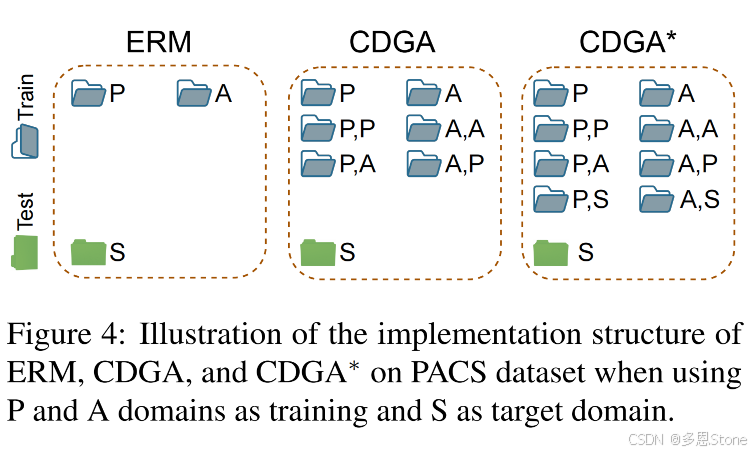

- 关键是补充了 Cross Domain (两种 Domain 之间)的数据,下图右侧的 -> 部分。

- 主要做法是

-

- 提示引导CDGA(CDGA-PG):给定来自一个域和类的图像,获取其他域的文本描述作为提示,将当前图像增强到相同的其他域的图像类;

-

- 图像引导CDGA(CDGA-IG):在域文本描述不可用的情况下,使用图像混合器(类似风格迁移)将每个图像与来自其他域的同类图像进行混合。

-

背景

- 领域泛化问题:在现实场景中,深度学习模型面临分布外(OOD)泛化挑战,即训练集和目标集分布不一致。域泛化(DG)研究在多个源域上学习模型并推广到未知目标域,而经验风险最小化(ERM)在域转移时难以保持性能。

- 相关工作不足:为提高 ERM 的 OOD 泛化能力,有学习域不变机制和数据增强两类方法。尽管开发新正则化器的研究众多,但简单数据增强在一些情况下表现更优。同时,新数据增强技术的探索较少,且现有正则化器难以捕捉所有不变性,还可能带来优化困难。

动机

- 理论局限:邻近风险最小化(VRM)通过在域内增加合成样本改进 ERM,但在 DG 中,ERM 的估计误差主要源于域间分布转移,域内简单数据增强无法完全解决。

- 方法启发:借助预训练的生成模型(如 LDM),有可能在域级别实现 VRM 原则,减少域间差异,从而提高模型泛化能力。

CDGA 方法

- 理论基础:改写 ERM 损失函数,对比 VRM 可知其在处理域间分布转移上的不足。CDGA 提出新的损失函数,通过从域对附近生成样本填充域间差距,降低非独立同分布性。由于无法直接获取相关分布,利用 LDM 进行采样实现,将域内数据点转换到所有域,增加样本数量。

- 实现方式

- CDGA with Prompt Guidance (CDGA - PG):利用域描述文本提示作为引导,用 LDM 生成合成图像,实现不同域同类数据的插值。若有目标域描述,还可直接在训练域和目标域之间插值。

- CDGA with Image Guidance (CDGA - IG):在无文本提示时,采用图像混合技术,用域内图像作为引导生成合成图像。

- 单域生成增强(SDGA):与 CDGA 不同,SDGA 仅从同一域获取引导进行图像增强,包括 SDGA - PG(用包含标签和/或域信息的提示)和 SDGA - IG(用图像和标签信息构建引导)。

实验

- 实验设置

- 数据集:在 VLCS、PACS、OfficeHome、DomainNet 等数据集评估方法。

- 模型与参数:使用预训练的 stable diffusion 1.4 作为 LDM,CDGA - IG 中图像混合器经微调,图像生成参数采用默认值。设置合适的生成批次大小,使用特定硬件进行实验。

- 主要实验结果

- DomainBed 基准测试:在不同数据集和模型选择技术下,CDGA 均达到 SOTA 性能,优于现有方法,如在 PACS、OfficeHome、DomainNet 等数据集上表现突出。

- CDGA 与 SDGA 对比:由于 CDGA 的域插值能力,在 PACS 数据集上始终优于 SDGA 及其变体,其中 SDGA - IG 相对其他 SDGA 方法表现较好。

- 数据规模缩放规律:在 PACS 数据集上,增加生成批次大小(即数据规模)可提高模型的 OOD 泛化能力,不过预训练模型性能会趋于饱和。

- 缓解类别不平衡:在 OfficeHome 数据集上,通过为不同类设置不同的批次大小使生成数据平衡,有效提升了 OOD 泛化性能。

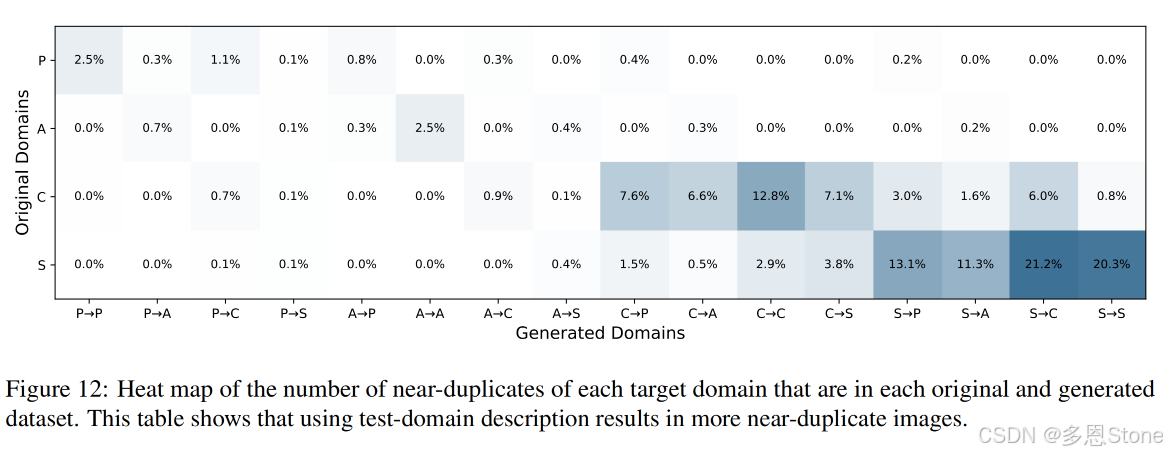

- 域转移量化:通过多种量化技术(t - SNE 可视化、近重复分析、可迁移性、多样性转移度量)表明 CDGA 能有效缓解域转移、减少非独立同分布性。例如,t - SNE 可视化显示合成图像可填充域间差距,近重复分析表明能生成与目标域相似的图像等。

- 对抗鲁棒性:在 PACS 数据集上,面对 FGSM 和 PGD 对抗攻击,CDGA 和 CDGA*训练的模型比经典数据增强和 Mixup 方法更具鲁棒性。

- 损失地形分析:CDGA 和 CDGA*导致的局部最小值更平坦,解释了其更好的泛化能力。

研究贡献与局限

- 提出 CDGA 方法利用 LDM 生成样本减少域间差距,在 DomainBed 基准上表现优异。通过大量消融实验分析了其有效性原因,但未来需进一步研究 CDGA 与模型损失地形结构的理论联系,以深入理解其工作机制。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?