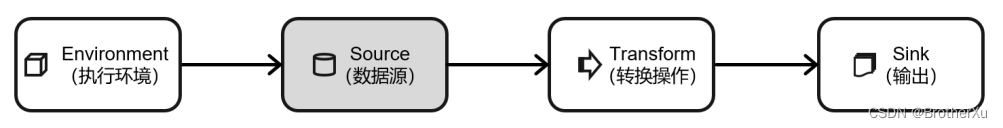

Flink的DataStream API的使用

一、Flink的DataStream API的使用------执行环境(Execution Environment)

执行环境这一节请点击超链接阅读https://blog.csdn.net/weixin_44328192/article/details/126952164

二、Flink的DataStream API的使用------源算子(Source)

创建环境之后,就可以构建数据处理的业务逻辑了,想要处理数据,先得有数据,所以首要任务就是把数据读进来。

Flink 可以从各种来源获取数据,然后构建 DataStream 进行转换处理。一般将数据的输入来源称为数据源(data source),而读取数据的算子就是源算子(source operator)。所以,source就是我们整个处理程序的输入端。

Flink 代码中通用的添加 source 的方式,是调用执行环境的 addSource()方法:

DataStream<String> stream = env.addSource(...);

方法传入一个对象参数,需要实现 SourceFunction 接口;返回 DataStreamSource。这里的DataStreamSource 类继承自 SingleOutputStreamOperator 类,又进一步继承自 DataStream。所以很明显,读取数据的 source 操作是一个算子,得到的是一个数据流(DataStream)。

这里可能会有些麻烦:传入的参数是一个“源函数”(source function),需要实现SourceFunction 接口。这是何方神圣,又该怎么实现呢?自己去实现它显然不会是一件容易的事。好在 Flink 直接提供了很多预实现的接口,此外还有很多外部连接工具也帮我们实现了对应的 source function,通常情况下足以应对我们的实际需求。

1、准备工作

为了更好地理解,我们先构建一个实际应用场景。比如网站的访问操作,可以抽象成一个三元组(用户名,用户访问的 urrl,用户访问 url 的时间戳),所以在这里,我们可以创建一个类 Event,将用户行为包装成它的一个对象。

代码如下:

public class Event {

public String user;

public String url;

public Long timestamp;

public Event() {

}

public Event(String user, String url, Long timestamp) {

this.user = user;

this.url = url;

this.timestamp = timestamp;

}

@Override

public String toString() {

return "Event{" +

"user='" + user + '\'' +

", url='" + url + '\'' +

", timestamp=" + new Timestamp(timestamp) +

'}';

}

}

这里需要注意,我们定义的 Event,有这样几个特点:

⚫ 类是公有(public)的

⚫ 有一个无参的构造方法

⚫ 所有属性都是公有(public)的

⚫ 所有属性的类型都是可以序列化的

我们这里自定义的 Event POJO 类会在后面的代码中频繁使用,所以在后面的代码中碰到Event,把这里的 POJO 类导入就好了。

2、读取有界流数据

2.1、从文件读取数据

真正的实际应用中,自然不会直接将数据写在代码中。

通常情况下,我们会从存储介质中获取数据,一个比较常见的方式就是读取日志文件。这也是批处理中最常见的读取方式。

DataStreamSource<String> stream1 = env.readTextFile("input/clicks.txt");

说明:

⚫ 参数可以是目录,也可以是文件;

⚫ 路径可以是相对路径,也可以是绝对路径;

⚫ 相对路径是从系统属性 user.dir 获取路径: idea 下是 project 的根目录, standalone 模式下是集群节点根目录;

⚫ 也可以从 hdfs 目录下读取, 使用路径 hdfs://…, 由于 Flink 没有提供 hadoop 相关依赖,

需要 pom 中添加相关依赖:

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-client</artifactId>

<version>2.7.5</version>

<scope>provided</scope>

</dependency>

2.2、从集合中读取数据

最简单的读取数据的方式,就是在代码中直接创建一个 Java 集合,然后调用执行环境的fromCollection 方法进行读取。这相当于将数据临时存储到内存中,形成特殊的数据结构后,作为数据源使用,一般用于测试。

public static void main(String[] args) throws Exception {

//创建执行环境

StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

env.setParallelism(1);

//从集合中读取数据

ArrayList<Integer> nums = new ArrayList<>();

nums.add(2);

nums.add(5);

DataStreamSource<Integer> numStream = env.fromCollection(nums);

ArrayList<Event> events = new ArrayList<>();

events.add(new Event("Mary","./home",1000L));

events.add(new Event("Bob","./cart",2000L));

events.add(new Event("Alice","./home",3000L));

DataStreamSource<Event> stream2 = env.fromCollection(events);

stream1.print("1");

numStream.print("nums");

stream2.print("2");

env.execute();

}

我们也可以不构建集合,直接将元素列举出来,调用 fromElements 方法进行读取数据:

//从元素中读取数据

DataStreamSource<Event> stream3 = env.fromElements(

new Event("Mary", "./home", 1000L),

new Event("Bob", "./cart", 2000L),

new Event("Alice", "./home", 3000L)

);

stream3.print("3");

2.3、从 Socket 读取数据

不论从集合还是文件,我们读取的其实都是有界数据。在流处理的场景中,数据往往是无

界的。

一个简单的方式,就是读取 socket 文本流。这种方式由于吞吐量小、稳定性较差,一般也是用于测试。

DataStreamSource<String> stream4 = env.socketTextStream("localflink", 7777);

2.4、☆从 Kafka 读取数据☆(重要)

Kafka 作为分布式消息传输队列,是一个高吞吐、易于扩展的消息系统。而消息队列的传输方式,恰恰和流处理是完全一致的。所以可以说 Kafka 和 Flink 天生一对,是当前处理流式数据的双子星。在如今的实时流处理应用中,由 Kafka 进行数据的收集和传输,Flink 进行分析计算,这样的架构已经成为众多企业的首选。

//5.从kafka中读取数据

Properties properties = new Properties();

properties.setProperty("bootstrap.server","localflink:9092");

properties.setProperty("group.id", "consumer-group");

properties.setProperty("key.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");

properties.setProperty("value.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");

properties.setProperty("auto.offset.reset", "latest");

DataStreamSource<String> kafkaStream = env.addSource(new FlinkKafkaConsumer<String>("clicks", new SimpleStringSchema(), properties));

kafkaStream.print();

env.execute();

创建 FlinkKafkaConsumer 时需要传入三个参数:

⚫ 第一个参数 topic,定义了从哪些主题中读取数据。可以是一个 topic,也可以是topic列表,还可以是匹配所有想要读取的 topic 的正则表达式。当从多个 topic 中读取数据 时,Kafka 连接器将会处理所有 topic 的分区,将这些分区的数据放到一条流中去。

⚫ 第二个参数是一个DeserializationSchema 或者KeyedDeserializationSchema。Kafka 消息被存储为原始的字节数据,所以需要反序列化成 Java 或者 Scala 对象。上面代码中使用的 SimpleStringSchema,是一个内置的 DeserializationSchema,它只是将字节数组简单地反序列化成字符串。DeserializationSchema 和 KeyedDeserializationSchema 是公共接口,所以我们也可以自定义反序列化逻辑。

⚫ 第三个参数是一个 Properties 对象,设置了 Kafka 客户端的一些属性。

2.5、自定义 Source

大多数情况下,前面的数据源已经能够满足需要。但是凡事总有例外,如果遇到特殊情况,我们想要读取的数据源来自某个外部系统,而 flink 既没有预实现的方法、也没有提供连接器,又该怎么办呢?

那就只好自定义实现 SourceFunction 了。

接下来我们创建一个自定义的数据源,实现 SourceFunction 接口。主要重写两个关键方法:run()和 cancel()。

⚫ run()方法:使用运行时上下文对象(SourceContext)向下游发送数据;

⚫ cancel()方法:通过标识位控制退出循环,来达到中断数据源的效果。

代码如下:

先自定义一下数据源:

public class ClickSource implements SourceFunction<Event> {

//声明一个标志位

private Boolean running=true;

@Override

public void run(SourceContext<Event> ctx) throws Exception {

//随机生成数据

Random random = new Random();

//定义字段选取的数据集

String[] users = {"Mary","Alice","Bob","Cary"};

String[] urls = {"./home","./cart","./fav","./prod?id=100","./prod?id=200"};

//循环生成数据

while (running){

String user = users[random.nextInt(users.length)];

String url = urls[random.nextInt(urls.length)];

Long timeStamp = Calendar.getInstance().getTimeInMillis();

ctx.collect(new Event(user,url,timeStamp));

Thread.sleep(1000L);

}

}

@Override

public void cancel() {

running=false;

}

}

这个数据源,我们后面会频繁使用,所以在后面的代码中涉及到 ClickSource()数据源,使用上面的代码就可以了。

下面的代码我们来读取一下自定义的数据源。有了自定义的 source function,接下来只要

调用 addSource()就可以了:

public class SourceCustomTest {

public static void main(String[] args) throws Exception {

StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

env.setParallelism(1);

DataStreamSource<Event> customStream = env.addSource(new ClickSource());

customStream.print();

env.execute();

}

}

这里要注意的是 SourceFunction 接口定义的数据源,并行度只能设置为 1,如果数据源设置为大于 1 的并行度,则会抛出异常。

如果我们想要自定义并行的数据源的话,需要使用 ParallelSourceFunction,示例程序

如下:

public class SourceCustomTest {

public static void main(String[] args) throws Exception {

StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

env.setParallelism(4);

// DataStreamSource<Event> customStream = env.addSource(new ClickSource());

DataStreamSource<Integer> customStream = env.addSource(new ParallelCustomSource()).setParallelism(2);

customStream.print();

env.execute();

}

public static class ParallelCustomSource implements ParallelSourceFunction<Integer>{

private Boolean running = true;

private Random random = new Random();

@Override

public void run(SourceContext<Integer> ctx) throws Exception {

while(running){

ctx.collect(random.nextInt());

}

}

@Override

public void cancel() {

}

}

}

三、Flink的DataStream API的使用------转换算子(Transformation)

转换算子这一节请点击超链接阅读

https://blog.csdn.net/weixin_44328192/article/details/127049140

四、Flink的DataStream API的使用------输出算子(Sink)

输出算子这一节请点击超链接阅读

https://blog.csdn.net/weixin_44328192/article/details/127076297

269

269

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?