学习目标:

代码

实验

论文

学习时间:

2023.11.4-2023.11.10

学习产出:

代码

1、修改CelebA64数据集的代码,实验暂时没跑完

2、添加CB模块,实验暂时没跑完

3、修改ViTGAN的CIPS Generator位置编码为傅里叶编码

实验

1、消融实验调整顺序还在进行中

2、相对位置编码出了一个新结果但还是没傅里叶编码好

3、cifar100数据集暂时跑出了一个比原效果好的结果,但是还没跑完

论文

SCRATCHING VISUAL TRANSFORMER’S BACK

WITH UNIFORM ATTENTION

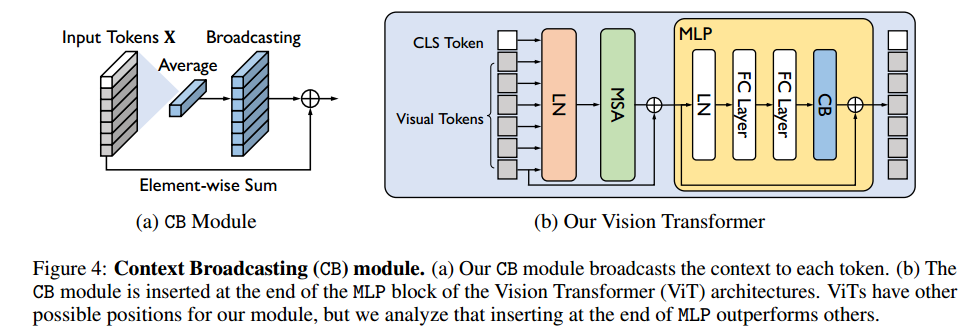

1、模型图

2、思想

该论文主要研究Vision Transformer,ViT的效果好主要是多头自注意力的原因,本文发现ViT中的注意力大部分具有高熵值,即MSA偏向于学习密集的相互作用(极端情况就是均匀注意力),尽管密集自注意力的梯度更陡峭,更难学习(均匀注意力可以被单个梯度打破)。文章引入显式广播上下文(CB)和维度缩放CB(CBS),将每一层的token进行平均池化后再提供给token,即由CB模块提供均匀注意力:

效果最好的是在MLP的末端。

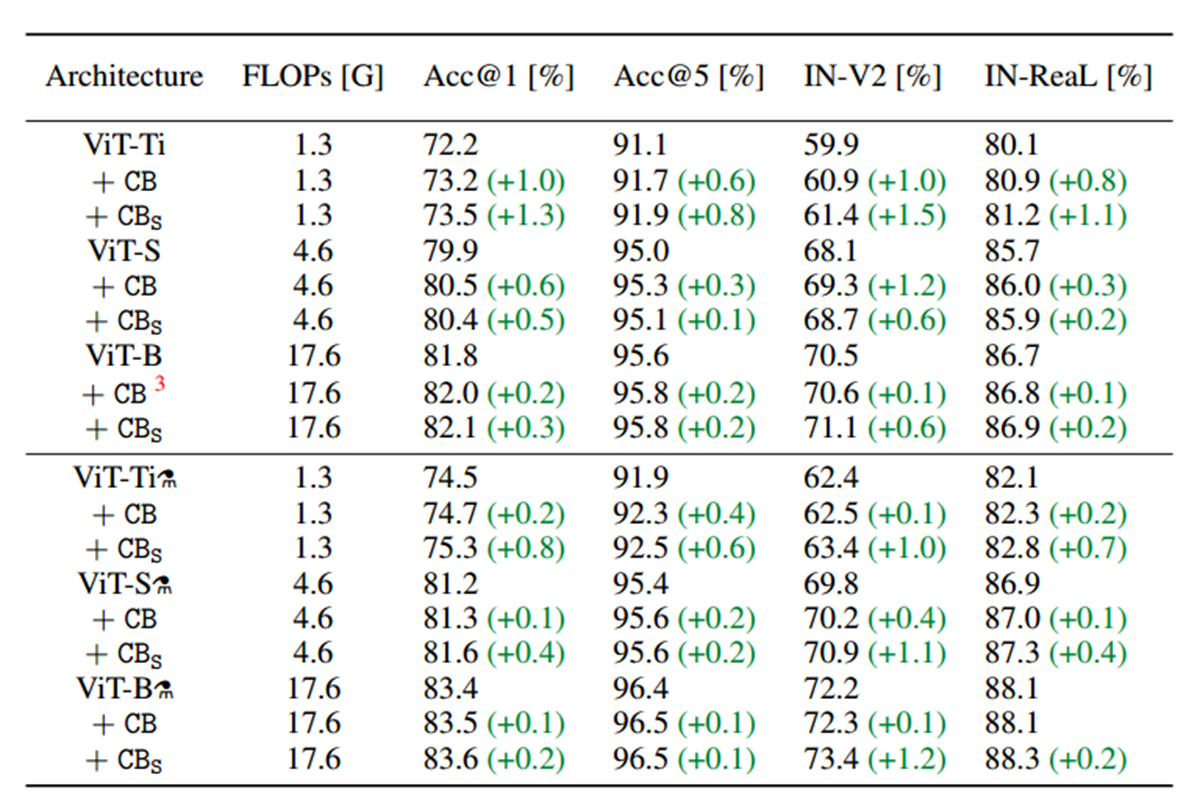

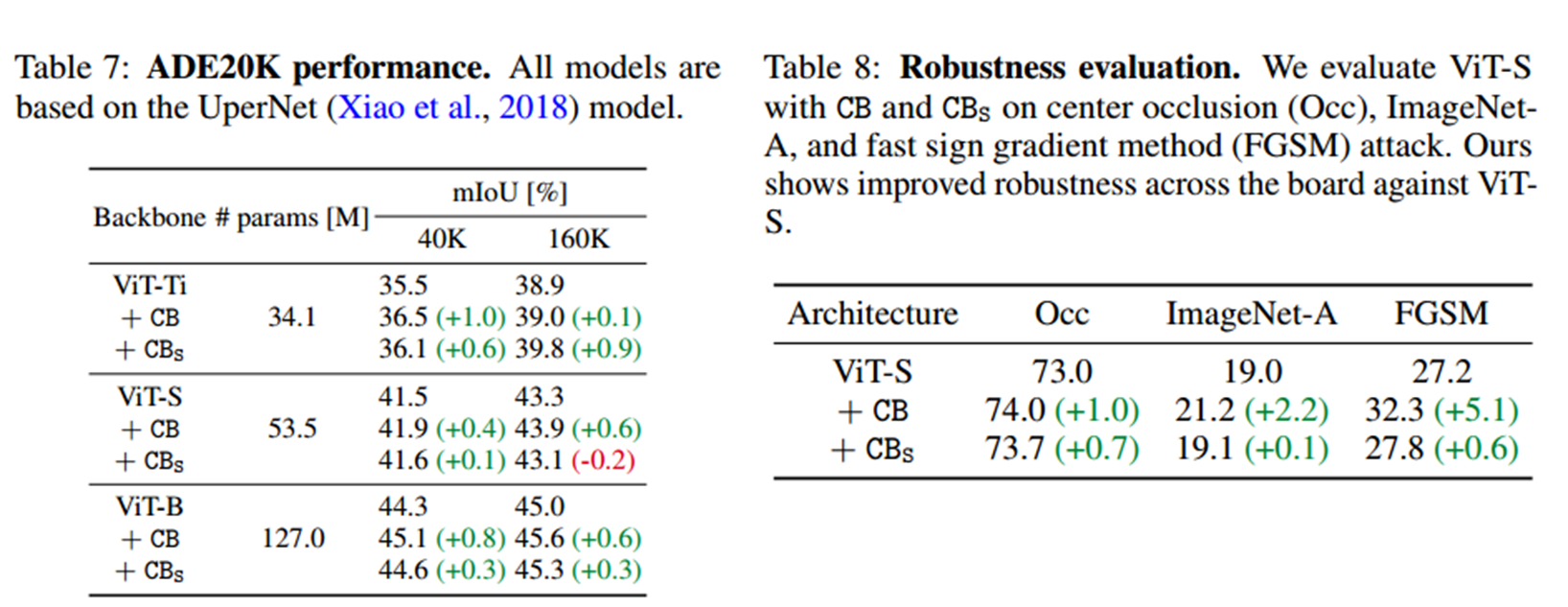

3、效果

图像分类的效果

语义分割的效果

667

667

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?