前言:博主最近在复现代码的时候遇到一个问题,有的代码使用softmax有的使用sigmod,两者使用到底有什么区别呢?

一、softmax函数

1.1公式

(一般只用于最后一层进行分类)深度学习中使用Softmax进行分类。

1.2举例

如果我们的结果有3类,那么最后的神经元输出就是3,也就是输出有3个数,但是直接输出这3个数有时候并不是特别好。通过softmax这个函数,上面的3个数就转换为了概率,输出还是3个数,它们加起来就等于1。如下图所示

1.3总结

softmax要综合考虑n个类,属于每个类的概率,这n类相互影响,加起来是等于1的.

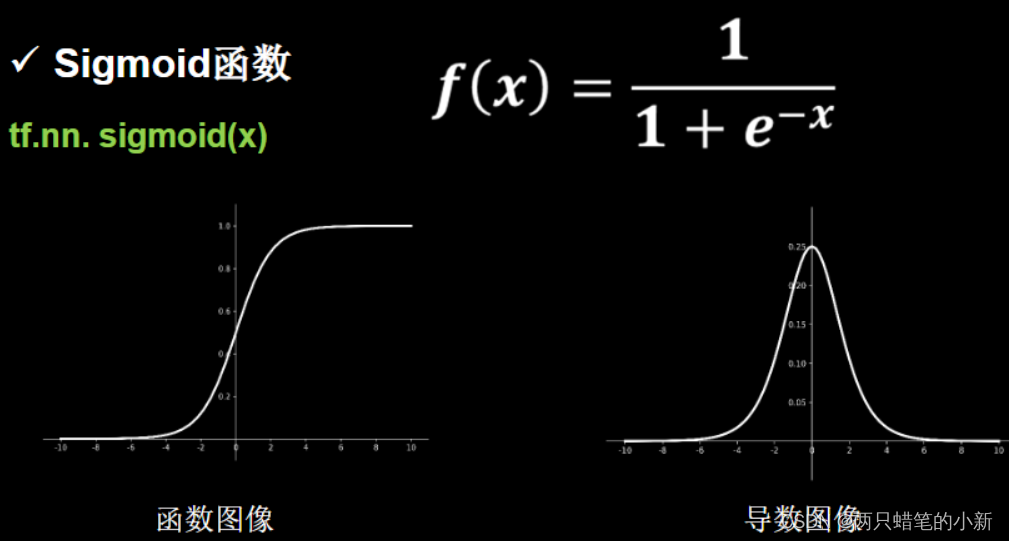

二、sigmod函数

2.1sigmod公式

2.2解释

可以看到Sigmoid 函数的范围是在0~1之间,所以任何一个值经过了Sigmoid 函数的作用,都会变成0~1之间的一个值,这个值可以形像

这篇博客探讨了softmax和sigmoid在深度学习中的应用及其区别。softmax常用于多分类任务,考虑所有类别的概率并确保概率总和为1,而sigmoid适用于二分类,输出值在0-1之间表示属于某类的概率,且与其它类无关。在多分类任务中,softmax由于其全局考虑的特性,通常表现更优。

这篇博客探讨了softmax和sigmoid在深度学习中的应用及其区别。softmax常用于多分类任务,考虑所有类别的概率并确保概率总和为1,而sigmoid适用于二分类,输出值在0-1之间表示属于某类的概率,且与其它类无关。在多分类任务中,softmax由于其全局考虑的特性,通常表现更优。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

344

344

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?